[spark程序]统计人口平均年龄(HDFS文件)(详细过程)

一、题目描述

(1)请编写Spark应用程序,该程序可以在分布式文件系统HDFS中生成一个数据文件peopleage.txt,数据文件包含若干行(比如1000行,或者100万行等等)记录,每行记录只包含两列数据,第1列是序号,第2列是年龄。效果如下:

1 89

2 67

3 69

4 78

(2)请编写Spark应用程序,对分布式文件系统HDFS中的数据文件peopleage.txt的数据进行处理,计算出所有人口的平均年龄。

二、实现

1、在分布式文件系统HDFS中生成一个数据文件peopleage.txt

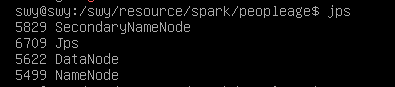

1)启动hadoop

start-dfs.sh

2)在HDFS中创建程序存放目录

hdfs dfs -mkdir -p /swy/resource/peopleage

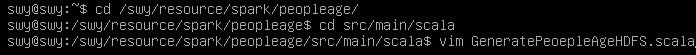

3)编辑生成peopleage.txt的程序GeneratePeopleAgeHDFS.scala

代码:

import org.apache.spark.SparkConf

import org.apache.spark.SparkContext

import org.apache.spark.SparkContext._

import scala.util.Random object GeneratePeopleAgeHDFS {

def main(args: Array[String]) {

val outFile = "hdfs://localhost:9000/swy/resource/peopleage/peopleage.txt"

val conf = new SparkConf().setAppName("GeneratePeopleAgeHDFS").setMaster("local[2]")

val sc = new SparkContext(conf)

val rand = new Random()

val array = new Array[String](1000)

for(i <- 1 to 1000) {

array(i-1) = i +" "+ rand.nextInt(100)

}

val rdd = sc.parallelize(array)

rdd.foreach(println)

rdd.saveAsTextFile(outFile)

}

}

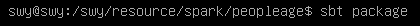

4)打包运行

5)可以看到HDFS中已经有了peopleage.txt文件

查看:

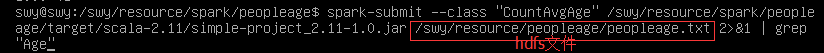

2、计算平均年龄

使用前面 创建的CountAvgage.scala文件

运行:

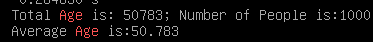

结果:

原文:http://dblab.xmu.edu.cn/blog/1756-2/

[spark程序]统计人口平均年龄(HDFS文件)(详细过程)的更多相关文章

- [spark程序]统计人口平均年龄(本地文件)(详细过程)

一.题目描述 (1)编写Spark应用程序,该程序可以在本地文件系统中生成一个数据文件peopleage.txt,数据文件包含若干行(比如1000行,或者100万行等等)记录,每行记录只包含两列数据, ...

- HDFS 文件读写过程

HDFS 文件读写过程 HDFS 文件读取剖析 客户端通过调用FileSystem对象的open()来读取希望打开的文件.对于HDFS来说,这个对象是分布式文件系统的一个实例. Distributed ...

- 记录一次用宝塔部署微信小程序Node.js后端接口代码的详细过程

一直忙着写毕设,上一次写博客还是元旦,大半年过去了.... 后面会不断分享各种新项目的源码与技术.欢迎关注一起学习哈! 记录一次部署微信小程序Node.js后端接口代码的详细过程,使用宝塔来部署. 我 ...

- Spark设置自定义的InputFormat读取HDFS文件

本文通过MetaWeblog自动发布,原文及更新链接:https://extendswind.top/posts/technical/problem_spark_reading_hdfs_serial ...

- Hadoop之HDFS文件读写过程

一.HDFS读过程 1.1 HDFS API 读文件 Configuration conf = new Configuration(); FileSystem fs = FileSystem.get( ...

- HDFS文件读写过程

参考自<Hadoop权威指南> [http://www.cnblogs.com/swanspouse/p/5137308.html] HDFS读文件过程: 客户端通过调用FileSyste ...

- JNI初级:android studio生成so文件详细过程

本文主要参考blog:http://blog.csdn.net/jkan2001/article/details/54316375 下面是本人结合blog生成so包过程中遇到一些问题和解决方法 (1) ...

- 大数据技术之_19_Spark学习_01_Spark 基础解析 + Spark 概述 + Spark 集群安装 + 执行 Spark 程序

第1章 Spark 概述1.1 什么是 Spark1.2 Spark 特点1.3 Spark 的用户和用途第2章 Spark 集群安装2.1 集群角色2.2 机器准备2.3 下载 Spark 安装包2 ...

- hdfs读写删除过程解析

一.hdfs文件读取过程 hdfs有一个FileSystem实例,客户端通过调用这个实例的open()方法就可以打开系统中希望读取的文件,hdfs通过rpc协议调用Nadmenode获取block的位 ...

随机推荐

- 网站是HTTP?10分钟变成HTTPS!域名免费添加配置SSL证书,变成https//环境

对于小程序request请求需要https域名.navigator.geolocation定位也需要在https环境下才可以生效等问题: 前端开发越来越需要https环境来来测试一下API接口和各类问 ...

- comparator接口实现时,只需要实现 int compare(T o1, T o2)方法?

从Comparator接口的源码,可以看到Comparator接口中的方法有三类: 1 普通接口方法 2 default方法 3 static方法 其中default方法和static方法 是java ...

- spring cloud 优雅停机

spring cloud 优雅停机 大部分部署项目如果要停掉项目一般都是用kill -9 来杀进程 但是由于Eureka采用心跳的机制来上下线服务,会导致服务消费者调用已经kill的服务提供者然后出错 ...

- 如何通过 Docker 部署 Logstash 同步 Mysql 数据库数据到 ElasticSearch

在开发过程中,我们经常会遇到对业务数据进行模糊搜索的需求,例如电商网站对于商品的搜索,以及内容网站对于内容的关键字检索等等.对于这些高级的搜索功能,显然数据库的 Like 是不合适的,通常我们采用 E ...

- java学习4-面向对象(上)

1.类和对象 修饰符可以是public.final.abstract或者完全省略这三个修饰符 类名命名规则:每个单词首字母大写,其他字母全部小写,单词与单词之间不使用分隔符 修饰符:可以省略,也可以是 ...

- pycharm中debug的使用

1.未打断点运程序,输出全部结果 2.打断点后,点击debug,代码执行到断点前停止(断点所在行不执行) 3.step over,是在单步执行时,在函数内遇到子函数时不会进入子函数内单步执行,而是将子 ...

- [Tarjan系列] Tarjan算法与有向图的SCC

前面的文章介绍了如何用Tarjan算法计算无向图中的e-DCC和v-DCC以及如何缩点. 本篇文章资料参考:李煜东<算法竞赛进阶指南> 这一篇我们讲如何用Tarjan算法求有向图的SCC( ...

- iOS开发高级分享 - Unread的下拉式选单

解构革命的演变 背景 2013年中期,RSS世界遭受了沉重打击.谷歌宣布,他们(*的*)RSS订阅服务,[谷歌阅读器],是被关闭了.有了它,数以百万计的声音突然惊恐地大叫,并突然保持沉默. 使用量下降 ...

- Redis(十三)Python客户端redis-py

一.安装redis-py的方法 使用pip install安装redis-py C:\Users\BigJun>pip3 install redis Collecting redis Downl ...

- (七)javac编译

文章目录 1.基本格式 2.目标路径 2.1 缺省项 2.2 指定路径 2.2.1 全路径 2.2.2 相对路径 3.源文件 3.1 无第三方库 3.1.1 基本方法 3.1.2 添加目录 3.1.3 ...