02-kubeadm初始化Kubernetes集群

部署

使用 kubeadm 安装kubernetes集群。

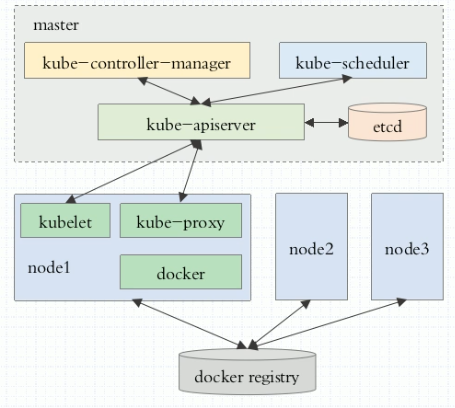

组件分布

部署环境

kubeadm 步骤

- master, node: 安装 kubelet, kubeadm, docker

- master: kubeadm init 初始化

- nodes: kubeadm join 加入集群 参考文章

基础环境

| 主机名 | 角色 | IP | 系统版本 | 内核版本 |

|---|---|---|---|---|

| master.kubernetes | master | 10.0.20.20 | CentOS 7.5 | 5.1.4-1.el7.elrepo.x86_64 |

| node01.kubernetes | node01 | 10.0.20.21 | CentOS 7.5 | 5.1.4-1.el7.elrepo.x86_64 |

| node02.kubernetes | node02 | 10.0.20.22 | CentOS 7.5 | 5.1.4-1.el7.elrepo.x86_64 |

| node03.kubernetes | node03 | 10.0.20.23 | CentOS 7.5 | 5.1.4-1.el7.elrepo.x86_64 |

基础配置

针对

所有机器操作

配置添加hosts

cat /etc/hosts10.0.20.20 master master.kubernetes10.0.20.21 node01 node01.kubernetes10.0.20.22 node02 node02.kubernetes10.0.20.23 node03 node03.kubernetes

关闭防火墙

systemctl disable firewalldsystemctl stop firewalld

禁用SELINUX

setenforce 0vi /etc/selinux/configSELINUX=disabled

创建/etc/sysctl.d/k8s.conf文件,添加如下内容

net.bridge.bridge-nf-call-ip6tables = 1net.bridge.bridge-nf-call-iptables = 1net.ipv4.ip_forward = 1# 执行命令使修改生效modprobe br_netfiltersysctl -p /etc/sysctl.d/k8s.conf

kube-proxy开启ipvs的前置条件

在

node01,node02和node03上执行以下脚本

由于ipvs已经加入到了内核的主干,所以为kube-proxy开启ipvs的前提需要加载以下的内核模块

ip_vsip_vs_rrip_vs_wrrip_vs_shnf_conntrack_ipv4

cat > /etc/sysconfig/modules/ipvs.modules <<EOF#!/bin/bashmodprobe -- ip_vsmodprobe -- ip_vs_rrmodprobe -- ip_vs_wrrmodprobe -- ip_vs_shmodprobe -- nf_conntrackEOFchmod 755 /etc/sysconfig/modules/ipvs.modules && bash /etc/sysconfig/modules/ipvs.modules && lsmod | grep -e ip_vs -e nf_conntrack

上面脚本创建了的/etc/sysconfig/modules/ipvs.modules文件,保证在节点重启后能自动加载所需模块。 使用lsmod | grep -e ip_vs -e nf_conntrack命令查看是否已经正确加载所需的内核模块。

接下来还需要确保各个节点上已经安装了ipset软件包yum install ipset。 为了便于查看ipvs的代理规则,最好安装一下管理工具ipvsadm yum install ipvsadm。

如果以上前提条件如果不满足,则即使kube-proxy的配置开启了ipvs模式,也会退回到iptables模式。

安装基础组件

配置yum源

在所有节点上执行

# cat /etc/yum.repos.d/kubernetes.repo[kubernetes]name=Kubernetes Repobaseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64/gpgcheck=0

# cat /etc/yum.repos.d/docker-ce.repo[docker-ce-stable]name=Docker CE Stable - $basearchbaseurl=https://mirrors.aliyun.com/docker-ce/linux/centos/7/$basearch/stableenabled=1gpgcheck=1gpgkey=https://mirrors.aliyun.com/docker-ce/linux/centos/gpg[docker-ce-stable-debuginfo]name=Docker CE Stable - Debuginfo $basearchbaseurl=https://mirrors.aliyun.com/docker-ce/linux/centos/7/debug-$basearch/stableenabled=0gpgcheck=1gpgkey=https://mirrors.aliyun.com/docker-ce/linux/centos/gpg[docker-ce-stable-source]name=Docker CE Stable - Sourcesbaseurl=https://mirrors.aliyun.com/docker-ce/linux/centos/7/source/stableenabled=0gpgcheck=1gpgkey=https://mirrors.aliyun.com/docker-ce/linux/centos/gpg[docker-ce-edge]name=Docker CE Edge - $basearchbaseurl=https://mirrors.aliyun.com/docker-ce/linux/centos/7/$basearch/edgeenabled=0gpgcheck=1gpgkey=https://mirrors.aliyun.com/docker-ce/linux/centos/gpg[docker-ce-edge-debuginfo]name=Docker CE Edge - Debuginfo $basearchbaseurl=https://mirrors.aliyun.com/docker-ce/linux/centos/7/debug-$basearch/edgeenabled=0gpgcheck=1gpgkey=https://mirrors.aliyun.com/docker-ce/linux/centos/gpg[docker-ce-edge-source]name=Docker CE Edge - Sourcesbaseurl=https://mirrors.aliyun.com/docker-ce/linux/centos/7/source/edgeenabled=0gpgcheck=1gpgkey=https://mirrors.aliyun.com/docker-ce/linux/centos/gpg[docker-ce-test]name=Docker CE Test - $basearchbaseurl=https://mirrors.aliyun.com/docker-ce/linux/centos/7/$basearch/testenabled=0gpgcheck=1gpgkey=https://mirrors.aliyun.com/docker-ce/linux/centos/gpg[docker-ce-test-debuginfo]name=Docker CE Test - Debuginfo $basearchbaseurl=https://mirrors.aliyun.com/docker-ce/linux/centos/7/debug-$basearch/testenabled=0gpgcheck=1gpgkey=https://mirrors.aliyun.com/docker-ce/linux/centos/gpg[docker-ce-test-source]name=Docker CE Test - Sourcesbaseurl=https://mirrors.aliyun.com/docker-ce/linux/centos/7/source/testenabled=0gpgcheck=1gpgkey=https://mirrors.aliyun.com/docker-ce/linux/centos/gpg[docker-ce-nightly]name=Docker CE Nightly - $basearchbaseurl=https://mirrors.aliyun.com/docker-ce/linux/centos/7/$basearch/nightlyenabled=0gpgcheck=1gpgkey=https://mirrors.aliyun.com/docker-ce/linux/centos/gpg[docker-ce-nightly-debuginfo]name=Docker CE Nightly - Debuginfo $basearchbaseurl=https://mirrors.aliyun.com/docker-ce/linux/centos/7/debug-$basearch/nightlyenabled=0gpgcheck=1gpgkey=https://mirrors.aliyun.com/docker-ce/linux/centos/gpg[docker-ce-nightly-source]name=Docker CE Nightly - Sourcesbaseurl=https://mirrors.aliyun.com/docker-ce/linux/centos/7/source/nightlyenabled=0gpgcheck=1gpgkey=https://mirrors.aliyun.com/docker-ce/linux/centos/gpg

安装组件

在master上执行

yum install docker-ce kubelet kubeadm kubectl -y# 安装完成后,配置忽略Swapcat /etc/sysconfig/kubeletKUBELET_EXTRA_ARGS="--fail-swap-on=false"

在node01 node02 node03 上执行

yum install docker-ce kubelet kubeadm -y

初始化 master

这里都在

master上操作

说明: 很重要,由于kubeadm 初始化的时候,默认拉取的镜像访问不了,我把master所需要的镜像已经准备好。

可以在 百度云盘地址 提取码:a4z9

导入镜像

先把下载好的镜像上传到

master服务器上,然后导入到docker中。

[root@master kubernetes.1.15]# lltotal 869812-rw------- 1 root root 40542720 Jul 9 13:54 coredns-1.3.tar-rw------- 1 root root 258365952 Jul 9 13:54 etcd-3.3.tar-rw------- 1 root root 55390720 Jul 9 15:58 flannel-0.11.tar-rw------- 1 root root 208382464 Jul 9 14:27 kube-apiserver-1.15.tar-rw------- 1 root root 160282112 Jul 9 13:53 kube-controller-manager-1.15.tar-rw------- 1 root root 84278272 Jul 9 13:52 kube-proxy-1.15.tar-rw------- 1 root root 82671104 Jul 9 13:53 kube-scheduler-1.15.tar-rw------- 1 root root 754176 Jul 9 13:54 pause-3.1.tar

# 导入镜像docker load --input coredns-1.3.tardocker load --input etcd-3.3.tardocker load --input flannel-0.11.tardocker load --input kube-apiserver-1.15.tardocker load --input kube-controller-manager-1.15.tardocker load --input kube-proxy-1.15.tardocker load --input kube-scheduler-1.15.tardocker load --input pause-3.1.tar

执行命令:

[root@master ~]# kubeadm init --kubernetes-version=1.15.0 --pod-network-cidr=10.244.0.0/16 --service-cidr=10.96.0.0/12 --ignore-preflight-errors=Swap.....Your Kubernetes control-plane has initialized successfully!To start using your cluster, you need to run the following as a regular user:mkdir -p $HOME/.kubesudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/configsudo chown $(id -u):$(id -g) $HOME/.kube/configYou should now deploy a pod network to the cluster.Run "kubectl apply -f [podnetwork].yaml" with one of the options listed at:https://kubernetes.io/docs/concepts/cluster-administration/addons/Then you can join any number of worker nodes by running the following on each as root:kubeadm join 10.0.20.20:6443 --token cgw8vp.c2gw34c6lc2jvw18 \--discovery-token-ca-cert-hash sha256:ada6c11ac45aadf7581baab773e7ab172bed8fc0df85ff38299a0c5dcb6538ad

注意 最后会输出上面显示的,这里要保留好,之后添加node的时候,用到的,否则添加不了node

按照初始化最后的提示执行

[root@master ~]# mkdir -p $HOME/.kube[root@master ~]# cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

查看组件状态

[root@master ~]# kubectl get csNAME STATUS MESSAGE ERRORscheduler Healthy okcontroller-manager Healthy oketcd-0 Healthy {"health":"true"}

查看node状态

[root@master ~]# kubectl get nodesNAME STATUS ROLES AGE VERSIONmaster.kubernetes NoReady master 66m v1.15.0

这里看到master的状态是NoReady,是因为没有安装flannel导致的,下面安装

安装flannel网络

执行:

[root@master ~]# kubectl apply -f https://raw.githubusercontent.com/coreos/flannel/master/Documentation/kube-flannel.ymlpodsecuritypolicy.extensions/psp.flannel.unprivileged createdclusterrole.rbac.authorization.k8s.io/flannel createdclusterrolebinding.rbac.authorization.k8s.io/flannel createdserviceaccount/flannel createdconfigmap/kube-flannel-cfg created

稍等后再次查看master状态

[root@master ~]# kubectl get nodesNAME STATUS ROLES AGE VERSIONmaster.kubernetes Ready master 66m v1.15.0

查看系统命名空间的pods状态

[root@master ~]# kubectl get pods -n kube-systemNAME READY STATUS RESTARTS AGEcoredns-5c98db65d4-8mzfz 1/1 Running 0 4mcoredns-5c98db65d4-spjx8 1/1 Running 0 4m6setcd-master.kubernetes 1/1 Running 0 7m24skube-apiserver-master.kubernetes 1/1 Running 0 7m23skube-controller-manager-master.kubernetes 1/1 Running 0 7m32skube-flannel-ds-amd64-wjczq 1/1 Running 0 48skube-proxy-rmckk 1/1 Running 0 8m14skube-scheduler-master.kubernetes 1/1 Running 0 7m33s

此时master已经初始化完成。

初始化 node

同样,先导入node所需的镜像到docker中,然后在执行个初始化命令

本次在node01 node02 node03 上执行

三个node节点操作相同

[root@node01 kubernetes.1.15]# lltotal 612216-rw------- 1 root root 55390720 Jul 9 15:58 flannel-0.11.tar-rw------- 1 root root 82671104 Jul 9 13:53 kube-scheduler-1.15.tar-rw------- 1 root root 754176 Jul 9 13:54 pause-3.1.tar[root@node01 kubernetes.1.15]# docker image lsREPOSITORY TAG IMAGE ID CREATED SIZEk8s.gcr.io/kube-proxy v1.15.0 d235b23c3570 2 weeks ago 82.4MBquay.io/coreos/flannel v0.11.0-amd64 ff281650a721 5 months ago 52.6MBk8s.gcr.io/pause 3.1 da86e6ba6ca1 18 months ago 742kB

初始化

执行下列命令:

[root@node01 ~]# kubeadm join 10.0.20.20:6443 --token cgw8vp.c2gw34c6lc2jvw18 --discovery-token-ca-cert-hash sha256:ada6c11ac45aadf7581baab773e7ab172bed8fc0df85ff38299a0c5dcb6538ad[preflight] Running pre-flight checks[WARNING IsDockerSystemdCheck]: detected "cgroupfs" as the Docker cgroup driver. The recommended driver is "systemd". Please follow the guide at https://kubernetes.io/docs/setup/cri/[preflight] Reading configuration from the cluster...[preflight] FYI: You can look at this config file with 'kubectl -n kube-system get cm kubeadm-config -oyaml'[kubelet-start] Downloading configuration for the kubelet from the "kubelet-config-1.15" ConfigMap in the kube-system namespace[kubelet-start] Writing kubelet configuration to file "/var/lib/kubelet/config.yaml"[kubelet-start] Writing kubelet environment file with flags to file "/var/lib/kubelet/kubeadm-flags.env"[kubelet-start] Activating the kubelet service[kubelet-start] Waiting for the kubelet to perform the TLS Bootstrap...This node has joined the cluster:* Certificate signing request was sent to apiserver and a response was received.* The Kubelet was informed of the new secure connection details.Run 'kubectl get nodes' on the control-plane to see this node join the cluster.

看到上面的最后提示,则表示完成,然后等一会儿后,在master查看效果如下:

master 验证

[root@master ~]# kubectl get nodesNAME STATUS ROLES AGE VERSIONmaster.kubernetes Ready master 84m v1.15.0node01.kubernetes Ready <none> 38m v1.15.0node02.kubernetes Ready <none> 38m v1.15.0node03.kubernetes Ready <none> 40m v1.15.0

[root@master ~]# kubectl get pods -n kube-systemNAME READY STATUS RESTARTS AGEcoredns-5c98db65d4-8mzfz 1/1 Running 0 80mcoredns-5c98db65d4-spjx8 1/1 Running 0 80metcd-master.kubernetes 1/1 Running 0 83mkube-apiserver-master.kubernetes 1/1 Running 0 83mkube-controller-manager-master.kubernetes 1/1 Running 0 83mkube-flannel-ds-amd64-4szk7 1/1 Running 0 40mkube-flannel-ds-amd64-b4ssp 1/1 Running 0 38mkube-flannel-ds-amd64-nmklz 1/1 Running 0 39mkube-flannel-ds-amd64-wjczq 1/1 Running 0 77mkube-proxy-8fqsz 1/1 Running 0 39mkube-proxy-bkrw4 1/1 Running 0 40mkube-proxy-n75g8 1/1 Running 0 38mkube-proxy-rmckk 1/1 Running 0 84mkube-scheduler-master.kubernetes 1/1 Running 0 83m

[root@master ~]# kubectl get nsNAME STATUS AGEdefault Active 85mkube-node-lease Active 85mkube-public Active 85mkube-system Active 85m

02-kubeadm初始化Kubernetes集群的更多相关文章

- 3、kubeadm初始化Kubernetes集群

同步时间 # ntpdate time.nist.gov k8s集群组成 k8s部署环境 https://kubernetes.io/docs/setup/independent/create-cl ...

- kubeadm初始化kubernetes集群

有两种方式安装集群: 1.手动安装各个节点的各个组件,安装极其复杂困难. 2.使用工具:kubeadm kubeadm 是官方提供的专门部署集群的管理工具. 1. 在kubeadm下每个节点都需要安装 ...

- kubeadm搭建kubernetes集群之三:加入node节点

在上一章<kubeadm搭建kubernetes集群之二:创建master节点>的实战中,我们把kubernetes的master节点搭建好了,本章我们将加入node节点,使得整个环境可以 ...

- kubeadm搭建kubernetes集群之二:创建master节点

在上一章kubeadm搭建kubernetes集群之一:构建标准化镜像中我们用VMware安装了一个CentOS7虚拟机,并且打算用这个虚拟机的镜像文件作为后续整个kubernetes的标准化镜像,现 ...

- Kubernetes(K8s) 安装(使用kubeadm安装Kubernetes集群)

背景: 由于工作发生了一些变动,很长时间没有写博客了. 概述: 这篇文章是为了介绍使用kubeadm安装Kubernetes集群(可以用于生产级别).使用了Centos 7系统. 一.Centos7 ...

- kubeadm 搭建kubernetes集群环境

需求 kubeadm 搭建kubernetes集群环境 准备条件 三台VPS(本文使用阿里云香港 - centos7.7) 一台能SSH连接到VPS的本地电脑 (推荐连接工具xshell) 安装步骤 ...

- Kubernetes 学习3 kubeadm初始化k8s集群

一.k8s集群 1.k8s整体架构图 2.k8s网络架构图 二.基于kubeadm安装k8s步骤 1.master,nodes:安装kubelet,kubeadm,docker 2.master: k ...

- 使用kubeadm部署Kubernetes集群

一.环境架构与部署准备 1.集群节点架构与各节点所需安装的服务如下图: 2.安装环境与软件版本: Master: 所需软件:docker-ce 17.03.kubelet1.11.1.kubeadm1 ...

- kubeadm部署Kubernetes集群

Preface 通过kubeadm管理工具部署Kubernetes集群,相对离线包的二进制部署集群方式而言,更为简单与便捷.以下为个人学习总结: 两者区别在于前者部署方式使得大部分集群组件(Kube- ...

随机推荐

- c#通过libreOffice实现 office文件转pdf文件

一.安装libreOffice 点击官网下载libreOffice 二.创建一个新的项目LibreOffice 创建一个新的项目,方便后面调用 添加下面代码 public class OfficeCo ...

- WPF项目设计规则

关于WPF应用程序的设计: 项目构成,自上而下: 1. 前端的WPF应用程序项目. 2. 业务逻辑的类库项目. 3. 映射到数据库各个表的Model型类库,(数据库操作接口定义). 4. 其他工具型类 ...

- Linux上的文件管理类命令都有哪些,其常用的使用方法及其相关示例演示

目录管理命令ls:列出指定目录下的内容格式: ls [OPTION]... [FILE]... -a:显示所有文件包括隐藏文件 -A:显示除.和..之外的所有文件 -l,--long:显示 ...

- Asp.net Core 系列之--1.事件驱动初探:简单事件总线实现(SimpleEventBus)

ChuanGoing 2019-08-06 前言 开篇之前,简单说明下随笔原因.在园子里游荡了好久,期间也起过要写一些关于.NET的随笔,因各种原因未能付诸实现. 前段时间拜读daxnet的系列文章 ...

- 原生JS实现双向链表

1.前言 双向链表和单向链表的区别在于,在链表中,一个节点只有链向下一个节点的链接,而在双向链表中,链接是双向的:一个链向下一个元素,另一个链向前一个元素,如下图所示: 从图中可以看到,双向链表中,在 ...

- 1000m交叉网线最简单做法

1-3,2-6,3-1,4-7,5-8,6-2,7-4,8-5 1,2,3,4,5,6,7,8即为网线内部8跟线编号,两头颜色和数字要对应.

- PHP压缩文件夹的方法

PHP压缩文件夹的方法<pre> public function addFileToZip($path, $zip) { $handler = opendir($path); //打开当前 ...

- mysql字符集那些事

1..查看mysql当前使用的字符集. 登录mysql 在mysql 里输入 show variables like 'character_set%' mysql> show variables ...

- nyoj 64-鸡兔同笼 (解二元一次方程)

64-鸡兔同笼 内存限制:64MB 时间限制:3000ms Special Judge: No accepted:26 submit:58 题目描述: 已知鸡和兔的总数量为n,总腿数为m.输入n和m, ...

- python的文件操作及简单的用例

一.python的文件操作介绍 1.文件操作函数介绍 open() 打开一个文件 语法:open(file, mode='r', buffering=-1, encoding=None, errors ...