【转载】 准人工智能分享Deep Mind报告 ——AI“元强化学习”

原文地址:

https://www.sohu.com/a/231895305_200424

---------------------------------------------------------------------------------------------

前言

比起人类,深度学习算法已经在很多任务上的表现更优秀。但它们的学习效率很低。一个电子游戏,人类玩一个下午大概就会了,而算法得花上百个小时。Deep Mind认为,这可能是人类的元学习能力占了优势。

Deep Mind指出,人类之所以能非常快地掌握新事物,原因可能是能从以往的经历中提取出规律,这种能力称为元学习。

不过元学习的底层机制一直是个谜。

Deep Mind利用 元强化学习 来解释人类大脑的快速学习原理,探索多巴胺(dopamine)在人脑学习中的地位,并据此提出了强化学习模型未来的发展思路。

一、前额叶皮质——人脑中的“元强化学习系统”

Deep Mind在该研究中使用AI来探索大脑中的多巴胺所发挥的帮助学习的作用。通过这项研究,Deep Mind使用元强化学习(meta-RL)算法,指出多巴胺的作用不仅仅是奖励对过去行为的学习,它发挥的是整体作用,特别是在前额叶区域,它使我们能高效地学习新知识、执行新任务——而不需要像深度学习算法那样,依赖大量数据进行训练。

多巴胺是人们所熟悉的大脑快乐信号,通常被用来类比AI强化学习算法中使用的 奖励预测误差信号,AI和人脑通过反复试错来进行学习与决策,正是由这种奖励推动的。

1.什么是元学习

说到什么是元强化学习,必须先说到什么是元学习。

正如我们所见,目前,AI系统已经掌握多种视频游戏(例如Atari的经典游戏 Breakout和Pong)的玩法,或像阿尔法狗一样学会了下围棋。虽然其表现令人印象深刻,但AI仍然依赖于数千小时的游戏经验才能达到并超越人类玩家的表现,而人类仅需数分钟就可以掌握视频游戏的基本玩法。对大脑何以能在少量的经验下快速学习这一问题的探究推动了元学习(meta-learning)或 “ 学习如何学习 ” 理论的发展。

由于人脑往往轻而易举便能学会更加错综复杂的事物,人们提出了“元学习”理论(theory of meta-learning),换句话说,就是“学习如何学习”。一般认为,我们的学习可以分为两个时间尺度:

短期学习中,我们往往更专注于事实的学习;

而长期学习中,我们更偏重任务中抽象的技巧与规则。

正是这样长期、短期学习的结合帮助我们有效学习,并得以在新任务中快速而灵活地应用新知识。

2.什么是元强化学习

而在人工智能系统中,这种“元学习” 结构的再创造 被称为 “元强化学习”(meta-reinforcement learning),在进行快速、单次的学习任务中极富有成效。然而,要从神经科学角度解释人脑中相应的机制则困难得多。

元学习,即从例子中快速学习,以及随着时间的推移从这些例子中明白事物的规则。这被认为是人类比AI能更有效地获得新知识的原因之一。

在 AI 系统中基于强化学习算法创建这种元学习结构,即元强化学习(meta-RL)。

二、多巴胺在人脑学习中的作用

我们最新运用了人工智能研究中“元强化学习”的框架,以探索多巴胺(dopamine)在人脑学习中的地位。多巴胺因作为大脑中的“快乐信号”被大家熟知,目前被认为是一种“奖励预测误差”(reward prediction error,RPE)信号,类似于人工智能中的强化学习算法。Deep Mind提出,多巴胺的功能并不只是从过往事件中估测奖励值。事实上,多巴胺尤其在前额叶皮质区中扮演着且重要的整体性角色,使我们在新任务中高效、迅速、灵活地学习。

Deep Mind虚拟再现的其中一个实验是Harlow实验,这是一个 1940 年代提出的心理训练测试,用于探索 元学习的概念。在1940年的Harlow实验训练中,研究人员先向一组猴子展示了2个它们不熟悉的物体并让它们进行选择,其中1个物体能带来食物奖励。这两个物体被展示了 6 次,每次展示中两个物体的左右位置都是随机的,因此猴子必须学会选择哪个物体才能带来食物奖励。然后,研究人员又向它们展示了2个新物体并让它们进行选择,这时也是只有其中1个能带来食物奖励。通过该训练过程,猴子摸索出了一种策略来选择可以获得奖励的物体:猴子学会了在第一次选择时进行随机选择,然后基于奖励反馈选择有奖励的物体,而不是只选择左右位置。该实验证明了猴子可以从例子中快速学会完成任务,并学会抽象的任务规则,即元学习(meta-learning)。

虚拟Harlow实验中,元强化学习智能体需要将关注点移向它认为与奖励相关的目标

人类要有很强的学习能力,掌握到多变事物的规律,不可能仅依赖突触增强这种长期慢性的改变。这暗示着多巴胺很可能有能力抽象出模块化的信息。不过,这不是科学家首次用AI模拟人脑。

荷兰内梅亨大学就用循环神经网络预测出了人脑处理感知信息的过程,特别是视觉刺激。但Deep Mind官博认为,大体来讲这些发现对机器学习领域有更大的启发,对神经生物学倒没起到什么推进的作用。

去年,Deep Mind针对人脑的部分解剖结构建模,用神经网络模仿前额皮质的活动以及海马的记忆。结果得到了一个强于大多数网络的AI。最近,DeepMind把研究重心转移到了理性机制上,造了一个合成的神经网络,可进行逻辑推演以及解决问题。

通过这个多巴胺的研究,医学界终于可以从神经网络研究中有所收获和启发了。

从AI里获得对神经生物学界有启发的认知洞见,这两个学科之间的互哺非常可贵。希望随着AI研究的深入,对人脑的运作机制有更多的了解,进一步设计出学习能力更强大的智能体。

Deep Mind使用虚拟计算机屏幕和随机展示的图像模拟了一个类似的测试。他们发现元强化学习智能体(meta-RL agent)的学习方式与Harlow实验中的猴子非常相似,这种相似性即使在展示完全没见过的全新图像时也会存在,即元强化学习智能体(meta-RL agent)能快速学习解决不同规则的大量任务,而且因此它还学到了进行快速学习的通用法则。

事实上,这些元强化学习网络迅速地适应了一系列不同规则和结构的实验任务;也正是因为它们已经了解了如何适应各种任务,它们还学会了高效学习的一些普适性原则。

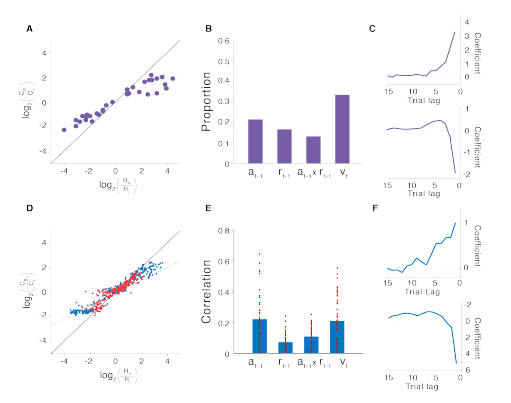

上图展示了元强化学习算法在多个任务基础上学习如何高效地解决新任务

更重要的是,传统神经科学观点认为,多巴胺可以加强前额叶系统中神经元间的突触联系,慢慢的改变神经元间突触的权重,从而强化大脑的特定的行为。而Deep Mind此次研究结果表明多巴胺不仅可以通过改变突触权重来强化大脑的特定行为,还可以快速编码和传输关于抽象任务规则的重要信息,使得大脑能够更快适应新任务。

模拟循环神经网络中编码动作和奖励历史的独立单元

而且,长期以来,神经科学家们发现前额叶皮质中有类似上一段提到的神经激活模式,这种模式适应速度快且灵活,但他们一直找不到一个合理的解释。前额叶皮质的神经网络不依赖缓慢的突触权重变化来学习抽象任务规则,而是使用多巴胺直接编码的基于模型或例子的信息来快速学习,这个思路为前额叶皮质快速而灵活神经激活模式提供了更合理的解释。

据此,Deep Mind不仅为神经科学做出了贡献,还运用了元强化学习(meta-RL)算法使AI像人脑一般可以快速解决并适应新的任务。

三、元强化学习(meta-RL)的意义

近年来,Deep Mind团队的阿尔法狗打遍围棋界,这让大家惊讶,Deep Mind似乎解决了通用AI中极其核心的一个问题,就是要让AI自己学会思考、学会推理。去年,Deep Mind团队又宣布要用AI挑战《星际争霸2》电脑游戏,然而却遭遇失败。

这是因为AI学会下围棋,是运用了深度强化学习的方法,而非AI真的学会了推理。在围棋棋盘上,给AI提供的选择数量仅有几百个,而《星际争霸2》给AI提供的选择数量达到上千万个,AI需要非常长的时间熟悉这些选择与选择带来的结果,才能做出正确的选择。

然而在面对巨量选择的情况下,人类依然没问题,而且人类通过战略战术大幅度降低了选择范围,因此如何使AI能够学会思考,而不只是从过往经验中慢慢强化正确选择,并快速构建战略以完成新目标非常关键。而模仿人类的元学习(meta-learning)便是使AI学会处理这种高难度问题的解决方法。

运用元强化学习(meta-RL)算法的AI能真正帮助人类解决各种类型的问题,而不只是执行某个特定任务,这将使得AI真正适用到人们的生活、工作中。以AI机器人将来或走进千家万户为例,每个人对AI机器人的要求是不同的,每个家庭的环境也并不相同,如果AI机器人运用元强化学习(meta-RL)算法,则不需要长时间的学习就能快速灵活的适应每个家庭的需求。

总结

一直以来,神经科学家们在前额叶皮质中观察到了不少类似的神经活动模式,然而关于这些适应及时且具有灵活性的模式,他们始终没能找到合理的解释。对于神经模式的多变性,有一种较为合理的观点:前额叶皮质并不依赖于突触权重随着规则结构学习的缓慢改变,而是基于直接编码于多巴胺的抽象模型信息。

我们的研究证明了,人工智能中元强化学习的关键因素同样存在于大脑中,而提出的理论不仅结合了对多巴胺和前额叶皮质的现有认知,还解释了神经科学与心理学的许多未知现象。

这进而引发一些对其他问题的思考:基于结构和模型的学习是如何发生在脑中的?为什么多巴胺本身就编码模型信息?前额叶皮质的神经元是如何调节学习信号的?此外,从人工智能得到的结果能应用到神经科学、心理学等其他学科的发现上,这就进一步强调了不同学科领域间的互惠价值。未来我们期待这一研究成果能够反向,从大脑神经环路的组织结构中获得启发,从而设计出更新、更好的强化学习模型。

---------------------------------------------------------------------------------------------

【转载】 准人工智能分享Deep Mind报告 ——AI“元强化学习”的更多相关文章

- (待续)【转载】 DeepMind发Nature子刊:通过元强化学习重新理解多巴胺

原文地址: http://www.dataguru.cn/article-13548-1.html -------------------------------------------------- ...

- 【转载】 DeepMind发表Nature子刊新论文:连接多巴胺与元强化学习的新方法

原文地址: baijiahao.baidu.com/s?id=1600509777750939986&wfr=spider&for=pc 机器之心 18-05-15 14:26 - ...

- AI之强化学习、无监督学习、半监督学习和对抗学习

1.强化学习 @ 目录 1.强化学习 1.1 强化学习原理 1.2 强化学习与监督学习 2.无监督学习 3.半监督学习 4.对抗学习 强化学习(英语:Reinforcement Learning,简称 ...

- (转) 深度强化学习综述:从AlphaGo背后的力量到学习资源分享(附论文)

本文转自:http://mp.weixin.qq.com/s/aAHbybdbs_GtY8OyU6h5WA 专题 | 深度强化学习综述:从AlphaGo背后的力量到学习资源分享(附论文) 原创 201 ...

- 《DRN: A Deep Reinforcement Learning Framework for News Recommendation》强化学习推荐系统

摘要 新闻推荐系统中,新闻具有很强的动态特征(dynamic nature of news features),目前一些模型已经考虑到了动态特征. 一:他们只处理了当前的奖励(ctr);. 二:有一些 ...

- 【转载】 “强化学习之父”萨顿:预测学习马上要火,AI将帮我们理解人类意识

原文地址: https://yq.aliyun.com/articles/400366 本文来自AI新媒体量子位(QbitAI) ------------------------------- ...

- 【转载】 强化学习(九)Deep Q-Learning进阶之Nature DQN

原文地址: https://www.cnblogs.com/pinard/p/9756075.html ------------------------------------------------ ...

- 【转载】 强化学习(八)价值函数的近似表示与Deep Q-Learning

原文地址: https://www.cnblogs.com/pinard/p/9714655.html ------------------------------------------------ ...

- 【腾讯Bugly干货分享】人人都可以做深度学习应用:入门篇

导语 2016年,继虚拟现实(VR)之后,人工智能(AI)的概念全面进入大众的视野.谷歌,微软,IBM等科技巨头纷纷重点布局,AI 貌似将成为互联网的下一个风口. 很多开发同学,对人工智能非常感兴趣, ...

随机推荐

- destoon模板语法规则笔记

1.包含模板 {template 'header'} 或 {template 'header', 'member'} {template 'header'} 被解析为 : <?php inclu ...

- 2019-2020-1 20199312《Linux内核原理与分析》第十二周作业

实验背景 2014年9月24日,Bash中发现了一个严重漏洞shellshock,该漏洞可用于许多系统,并且既可以远程也可以在本地触发.在本实验中,学生需要亲手重现攻击来理解该漏洞,并回答一些问题. ...

- quiver()函数

1.quiver函数 一般用于绘制二维矢量场图,函数调用方法如下: 1 quiver(x,y,u,v) 该函数展示了点(x,y)对应的的矢量(u,v).其中,x的长度要求等于u.v的列数,y的长度要求 ...

- tensorflow API _ 2 (tf.app.flags.FLAGS)

tf.app.flags.FLAGS 的使用,主要是在用命令行执行程序时,需要传些参数,代码如下:新建一个名为:app_flags.py 的文件. #coding:utf-8 import tens ...

- Linux rpm安装指定安装路径

可以使用prefix参数. rpm -i –prefix=/home/gpadmin greenplum-db-6.0.0-rhel6-x86_64.rpm 将greenplum-db-6.0. ...

- Filebeat在windows下安装使用

一.windows下安装Filebeat 官网下载安装包 解压到指定目录,打开解压后的目录,打开filebeat.yml进行配置. 1.配置为输出到ElasticSearch ①:配置 Filebea ...

- HTML5类操作

一.获取DOM的方式 ①通过类名获取元素,以伪数组形式存在 document.getElementsByClassName("class"); ②通过css选择器获取元素,符合匹配 ...

- unison 双向镜像同步

unison 双向镜像同步 需要 ocaml 依赖工具(3.0.7) 而且需要机器ssh双向互信 ssh 开启互信 # vi in.sh 直接执行 in.sh 就可以了 mkdir ~/.ssh ...

- codevs 2058 括号序列

2058 括号序列 时间限制: 2 s 空间限制: 128000 KB 题目等级 : 白银 Silver 题解 题目描述 Description 定义满足以下规则字符串为规则序列,否 ...

- 印象笔记作为todo(GTD相关)的一个尝试

印象笔记作为todo(GTD相关)的一个尝试 上来说结果: 失败 原则上的原因: 印象笔记作为一个比较重的笔记, 重点也不在于这一点, 虽然是可以新建清单之类的. 还是比较小巧的好一些. 最后使用的软 ...