机器学习-EM算法-pLSA模型笔记

pLSA模型--基于概率统计的pLSA模型(probabilistic Latent Semantic Analysis,概率隐语义分析),增加了主题模型,形成简单的贝叶斯网络,可以使用EM算法学习模型参数。概率潜在语义分析应用于信息检索,过滤,自然语言处理,文本的机器学习或者其他相关领域。

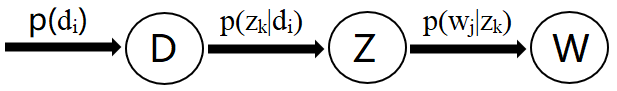

D代表文档,Z代表主题(隐含类别),W代表单词;

P(di)表示文档di的出现概率,

P(zk|di)表示文档di中主题zk的出现概率,

P(wj|zk)表示给定主题zk出现单词wj的概率。

每个主题在所有词项上服从多项分布,每个文档在所有主题上服从多项分布。

整个文档的生成过程是这样的:

以P(di)的概率选中文档di;

以P(zk|di)的概率选中主题zk;

以P(wj|zk)的概率产生一个单词wj。

观察数据为(di,wj)对,主题zk是隐含变量。

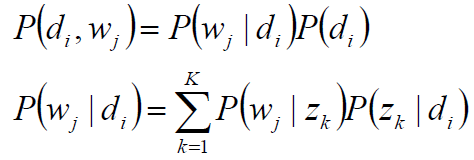

(di,wj)的联合分布为

而P(wj|zk),P(zk|di)对应了两组多项分布,而计算每个文档的主题分布,就是该模型的任务目标。

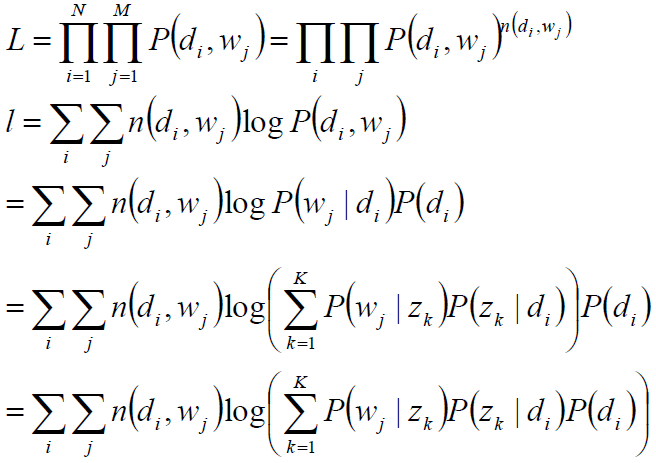

最大似然估计:wj在di中出现的次数n(di,wj)

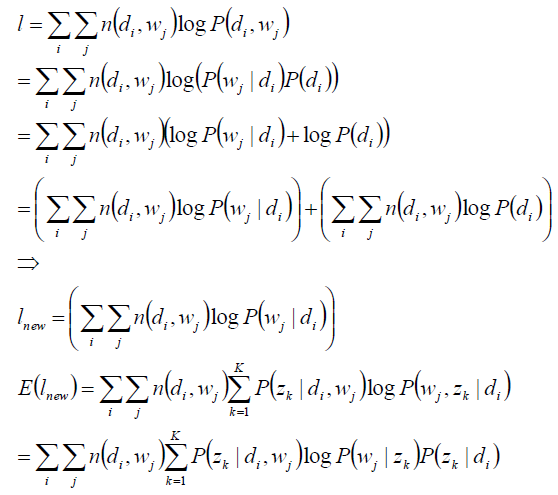

目标函数分析:

观察数据为(di,wj)对,主题zk是隐含变量。

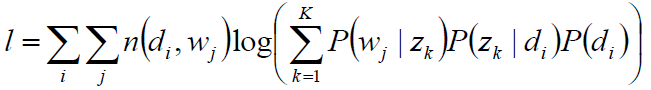

目标函数:

未知变量/自变量P(wj|zk),P(zk|di)

1) 使用逐次逼近的办法:假定P(zk|di)、P(wj|zk)已知,求隐含变量zk的后验概率;

2) 在(di,wj,zk)已知的前提下,求关于参数P(zk|di)、P(wj|zk) 的似然函数期望的最大值,得到最优解P(zk|di)、P(wj|zk) ,带入上一步,从而循环迭代,即:EM算法。

求隐含变量主题zk的后验概率:

假定P(zk|di)、P(wj|zk)已知,求隐含变量zk的后验概率;

在(di,wj,zk)已知的前提下,求关于参数P(zk|di)、P(wj|zk) 的似然函数期望的最大值,得到最优解P(zk|di)、P(wj|zk) ,带入上一步,从而循环迭代。

关于参数P(zk|di)、P(wj|zk) 的似然函数期望

完成目标函数的建立:

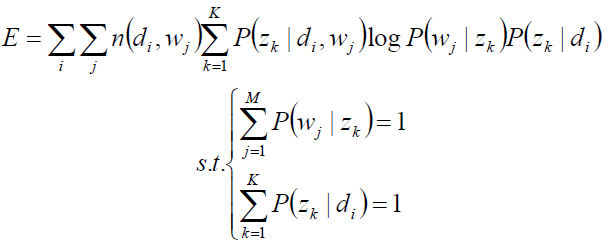

关于参数P(zk|di)、P(wj|zk) 的函数E,并且,带有概率加和为1的约束条件:

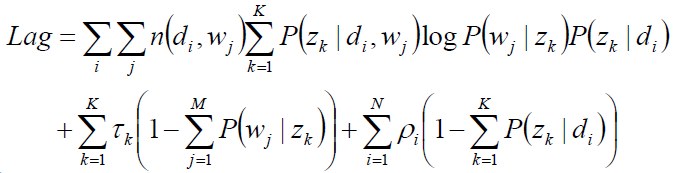

显然,这是只有等式约束的求极值问题,使用Lagrange乘子法解决。

目标函数的求解:

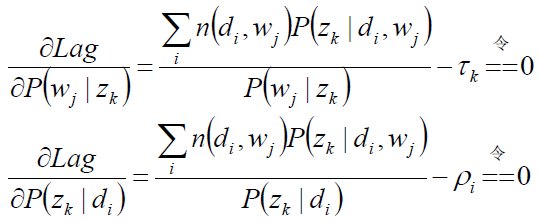

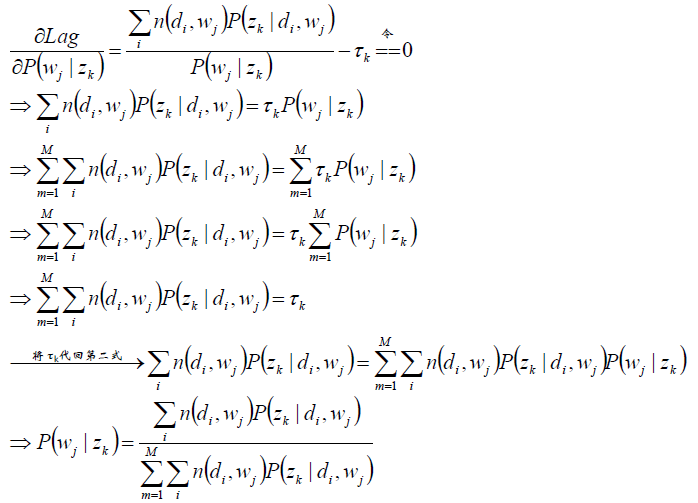

求驻点:

分析第一个等式:

同理分析第二个等式:

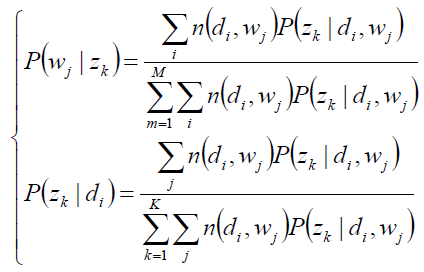

求极值时的解——M-Step:

E-step(zk的后验概率):

pLSA的总结:

1)pLSA应用于信息检索、过滤、自然语言处理等领域,pLSA考虑到词分布和主题分布,使用EM算法来学习参数。

2)虽然推导略显复杂,但最终公式简洁清晰,很符合直观理解,需用心琢磨;此外,推导过程使用了EM算法,也是学习EM算法的重要素材。

机器学习-EM算法-pLSA模型笔记的更多相关文章

- 机器学习-EM算法-GMM模型笔记

GMM即高斯混合模型,下面根据EM模型从理论公式推导GMM: 随机变量X是有K个高斯分布混合而成,取各个高斯分布的概率为φ1,φ2,... ,φK,第i个高斯分布的均值为μi,方差为Σi.若观测到随机 ...

- 机器学习-EM算法笔记

EM算法也称期望最大化(Expectation-Maximum,简称EM)算法,它是一个基础算法,是很多机器学习领域算法的基础,比如隐式马尔科夫算法(HMM), LDA主题模型的变分推断,混合高斯模型 ...

- 机器学习——EM算法

1 数学基础 在实际中,最小化的函数有几个极值,所以最优化算法得出的极值不确实是否为全局的极值,对于一些特殊的函数,凸函数与凹函数,任何局部极值也是全局极致,因此如果目标函数是凸的或凹的,那么优化算法 ...

- 机器学习-EM算法

最大期望算法 EM算法的正式提出来自美国数学家Arthur Dempster.Nan Laird和Donald Rubin,其在1977年发表的研究对先前出现的作为特例的EM算法进行了总结并给出了标准 ...

- 机器学习-EM算法的收敛证明

上一篇开头说过1983年,美国数学家吴建福(C.F. Jeff Wu)给出了EM算法在指数族分布以外的收敛性证明. EM算法的收敛性只要我们能够证明对数似然函数的值在迭代的过程中是增加的 即可: 证明 ...

- 机器学习——EM算法与GMM算法

目录 最大似然估计 K-means算法 EM算法 GMM算法(实际是高斯混合聚类) 中心思想:①极大似然估计 ②θ=f(θold) 此算法非常老,几乎不会问到,但思想很重要. EM的原理推导还是蛮复杂 ...

- PLSA及EM算法

前言:本文主要介绍PLSA及EM算法,首先给出LSA(隐性语义分析)的早期方法SVD,然后引入基于概率的PLSA模型,其参数学习采用EM算法.接着我们分析如何运用EM算法估计一个简单的mixture ...

- 详解十大经典机器学习算法——EM算法

本文始发于个人公众号:TechFlow,原创不易,求个关注 今天是机器学习专题的第14篇文章,我们来聊聊大名鼎鼎的EM算法. EM算法的英文全称是Expectation-maximization al ...

- 机器学习笔记(十)EM算法及实践(以混合高斯模型(GMM)为例来次完整的EM)

今天要来讨论的是EM算法.第一眼看到EM我就想到了我大枫哥,EM Master,千里马.RUA!!!不知道看这个博客的人有没有懂这个梗的. 好的,言归正传.今天要讲的EM算法,全称是Expectati ...

随机推荐

- 15.linux iptables防火墙规则vsftp服务

一.服务所开启的端口号. dhcp 67 samba 139 445 http 80 https 443 mysql 3306 ...

- [C++] typeid关键字使用方法

typeid 关键字的作用就是获取一个表达式是类型,返回表达式的类型 表达式可以是类型名称.变量名.数字.字符串.指针.结构体等 #include <iostream> using nam ...

- 范仁义html+css课程---2、html常用标签

范仁义html+css课程---2.html常用标签 一.总结 一句话总结: html常用的标签有 标题标签.div.span.p.hr.br标签 等 1.html中的标题标签有哪些? <h1& ...

- python window窗口

from Tkinter import * root=Tk() root.title('我是root窗口!') L=Label(root,text='我属于root') L.pack() f=Topl ...

- vue cli 静态资源导入 路径

1.public文件夹 使用绝对路径引入. 2.assets文件夹 使用相对路径引入. https://cli.vuejs.org/zh/guide/html-and-static-assets.ht ...

- Mysql中如何查看慢查询以及查看线程

一.MySQL数据库有几个配置选项可以帮助我们及时捕获低效SQL语句 1,slow_query_log这个参数设置为ON,可以捕获执行时间超过一定数值的SQL语句. 2,long_query_time ...

- 网关 apache APISIX

网关 apache - 国内版 Binghttps://cn.bing.com/search?q=%E7%BD%91%E5%85%B3+apache&qs=n&form=QBRE&am ...

- openresty开发系列16--lua中的控制结构if-else/repeat/for/while

openresty开发系列16--lua中的控制结构if-else/repeat/for/while 一)条件 - 控制结构 if-else if-else 是我们熟知的一种控制结构.Lua 跟其他语 ...

- sql 中 '' 与 null 的区别

SELECT * from t_company where content = '' SELECT * from t_company where content is null update t_co ...

- ROS学习笔记(二)

===================================================== QT工具箱sudo apt-get install ros-kinetic-rqtsudo ...