机器学习入门-文本特征-使用LDA主题模型构造标签 1.LatentDirichletAllocation(LDA用于构建主题模型) 2.LDA.components(输出各个词向量的权重值)

函数说明

1.LDA(n_topics, max_iters, random_state) 用于构建LDA主题模型,将文本分成不同的主题

参数说明:n_topics 表示分为多少个主题, max_iters表示最大的迭代次数, random_state 表示随机种子

2. LDA.components_ 打印输入特征的权重参数,

LDA主题模型:可以用于做分类,好比如果是两个主题的话,那就相当于是分成了两类,同时我们也可以找出根据主题词的权重值,来找出一些主题的关键词

使用sklearn导入库

from sklearn.decomposition import LatentDirichletAllocation, 使用方法还是fit_transform

LDA.components_ 打印出各个参数的权重值,这个权重值是根据数据特征的标签来进行排列的

代码:

第一步:Dataframe化数据

第二步:进行分词和停用词的去除,使用' '.join 为了词袋模型做准备

第三步:使用np.vectorizer对函数进行向量化处理,调用定义的函数进行分词和停用词的去除

第四步:使用Tf-idf 函数构建词袋模型

第五步:使用LatentDirichletAllocation构建LDA模型,并进行0,1标签的数字映射

第六步:使用LDA.components_打印输入特征标签的权重得分,去除得分小于0.6的得分,我们可以看出哪些词是主要的关键字

import pandas as pd

import numpy as np

import re

import nltk #pip install nltk corpus = ['The sky is blue and beautiful.',

'Love this blue and beautiful sky!',

'The quick brown fox jumps over the lazy dog.',

'The brown fox is quick and the blue dog is lazy!',

'The sky is very blue and the sky is very beautiful today',

'The dog is lazy but the brown fox is quick!'

] labels = ['weather', 'weather', 'animals', 'animals', 'weather', 'animals'] # 第一步:构建DataFrame格式数据

corpus = np.array(corpus)

corpus_df = pd.DataFrame({'Document': corpus, 'categoray': labels}) # 第二步:构建函数进行分词和停用词的去除

# 载入英文的停用词表

stopwords = nltk.corpus.stopwords.words('english')

# 建立词分割模型

cut_model = nltk.WordPunctTokenizer()

# 定义分词和停用词去除的函数

def Normalize_corpus(doc):

# 去除字符串中结尾的标点符号

doc = re.sub(r'[^a-zA-Z0-9\s]', '', string=doc)

# 是字符串变小写格式

doc = doc.lower()

# 去除字符串两边的空格

doc = doc.strip()

# 进行分词操作

tokens = cut_model.tokenize(doc)

# 使用停止用词表去除停用词

doc = [token for token in tokens if token not in stopwords]

# 将去除停用词后的字符串使用' '连接,为了接下来的词袋模型做准备

doc = ' '.join(doc) return doc # 第三步:向量化函数和调用函数

# 向量化函数,当输入一个列表时,列表里的数将被一个一个输入,最后返回也是一个个列表的输出

Normalize_corpus = np.vectorize(Normalize_corpus)

# 调用函数进行分词和去除停用词

corpus_norm = Normalize_corpus(corpus) # 第四步:使用TfidVectorizer进行TF-idf词袋模型的构建

from sklearn.feature_extraction.text import TfidfVectorizer Tf = TfidfVectorizer(use_idf=True)

Tf.fit(corpus_norm)

vocs = Tf.get_feature_names()

corpus_array = Tf.transform(corpus_norm).toarray()

corpus_norm_df = pd.DataFrame(corpus_array, columns=vocs)

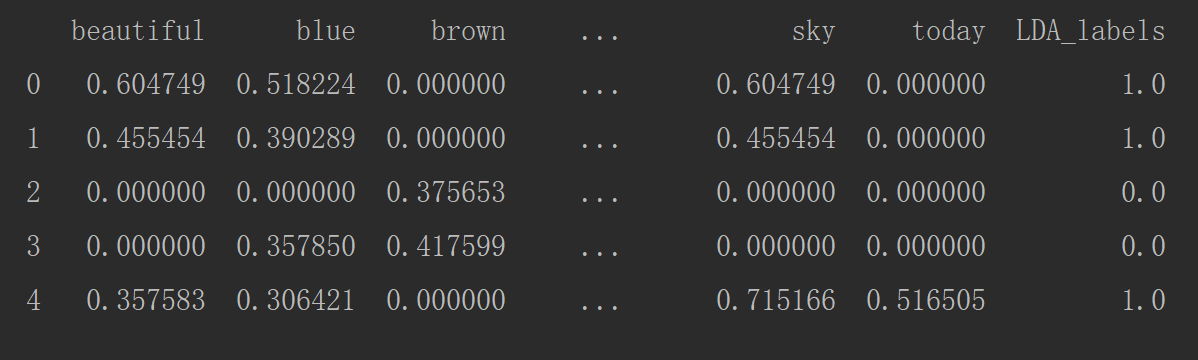

print(corpus_norm_df.head()) # 第五步:构建LDA主题模型

from sklearn.decomposition import LatentDirichletAllocation LDA = LatentDirichletAllocation(n_topics=2, max_iter=100, random_state=42)

LDA_corpus = np.array(LDA.fit_transform(corpus_array))

LDA_corpus_one = np.zeros([LDA_corpus.shape[0]])

LDA_corpus_one[LDA_corpus[:, 0] < LDA_corpus[:, 1]] = 1

corpus_norm_df['LDA_labels'] = LDA_corpus_one

print(corpus_norm_df.head())

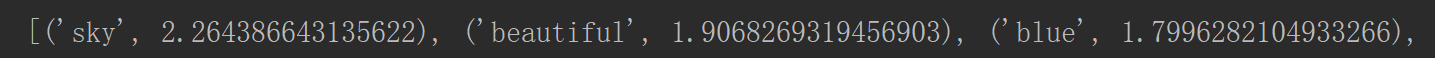

# 第六步:打印每个单词的主题的权重值

tt_matrix = LDA.components_

for tt_m in tt_matrix:

tt_dict = [(name, tt) for name, tt in zip(vocs, tt_m)]

tt_dict = sorted(tt_dict, key=lambda x: x[1], reverse=True)

# 打印权重值大于0.6的主题词

tt_dict = [tt_threshold for tt_threshold in tt_dict if tt_threshold[1] > 0.6]

print(tt_dict)

大于0.6权重得分的部分特征

机器学习入门-文本特征-使用LDA主题模型构造标签 1.LatentDirichletAllocation(LDA用于构建主题模型) 2.LDA.components(输出各个词向量的权重值)的更多相关文章

- 机器学习入门-文本特征-word2vec词向量模型 1.word2vec(进行word2vec映射编码)2.model.wv['sky']输出这个词的向量映射 3.model.wv.index2vec(输出经过映射的词名称)

函数说明: 1. from gensim.model import word2vec 构建模型 word2vec(corpus_token, size=feature_size, min_count ...

- 机器学习入门-文本数据-构造Ngram词袋模型 1.CountVectorizer(ngram_range) 构建Ngram词袋模型

函数说明: 1 CountVectorizer(ngram_range=(2, 2)) 进行字符串的前后组合,构造出新的词袋标签 参数说明:ngram_range=(2, 2) 表示选用2个词进行前后 ...

- 机器学习入门-数值特征-数字映射和one-hot编码 1.LabelEncoder(进行数据自编码) 2.map(进行字典的数字编码映射) 3.OnehotEncoder(进行one-hot编码) 4.pd.get_dummies(直接对特征进行one-hot编码)

1.LabelEncoder() # 用于构建数字编码 2 .map(dict_map) 根据dict_map字典进行数字编码的映射 3.OnehotEncoder() # 进行one-hot编码 ...

- 机器学习入门09 - 特征组合 (Feature Crosses)

原文链接:https://developers.google.com/machine-learning/crash-course/feature-crosses/ 特征组合是指两个或多个特征相乘形成的 ...

- 机器学习入门-文本数据-构造词频词袋模型 1.re.sub(进行字符串的替换) 2.nltk.corpus.stopwords.words(获得停用词表) 3.nltk.WordPunctTokenizer(对字符串进行分词操作) 4.np.vectorize(对函数进行向量化) 5. CountVectorizer(构建词频的词袋模型)

函数说明: 1. re.sub(r'[^a-zA-Z0-9\s]', repl='', sting=string) 用于进行字符串的替换,这里我们用来去除标点符号 参数说明:r'[^a-zA-Z0- ...

- 机器学习入门-文本数据-构造Tf-idf词袋模型(词频和逆文档频率) 1.TfidfVectorizer(构造tf-idf词袋模型)

TF-idf模型:TF表示的是词频:即这个词在一篇文档中出现的频率 idf表示的是逆文档频率, 即log(文档的个数/1+出现该词的文档个数) 可以看出出现该词的文档个数越小,表示这个词越稀有,在这 ...

- 机器学习入门-数值特征-对数据进行log变化

对于一些标签和特征来说,分布不一定符合正态分布,而在实际的运算过程中则需要数据能够符合正态分布 因此我们需要对特征进行log变化,使得数据在一定程度上可以符合正态分布 进行log变化,就是对数据使用n ...

- 机器学习入门-数值特征-数据四分位特征 1.quantile(用于求给定分数位的数值) 2.plt.axvline(用于画出竖线) 3.pd.pcut(对特征进行分位数切分,生成新的特征)

函数说明: 1. .quantile(cut_list) 对DataFrame类型直接使用,用于求出给定列表中分数的数值,这里用来求出4分位出的数值 2. plt.axvline() # 用于画 ...

- 机器学习入门-数值特征-连续数据离散化(进行分段标记处理) 1.hist(Dataframe格式直接画直方图)

函数说明: 1. .hist 对于Dataframe格式的数据,我们可以使用.hist直接画出直方图 对于一些像年龄和工资一样的连续数据,我们可以对其进行分段标记处理,使得这些连续的数据变成离散化 就 ...

随机推荐

- VS2012 创建的entityframework 4.1版本

起因:部署网站提示错误“Method not found: 'Void System.Data.Objects.ObjectContextOptions.set_UseConsistentNullRe ...

- uoj#119. 【UR #8】决战圆锥曲线

http://uoj.ac/problem/119 可以认为数据基本随机,于是可以直接用线段树维护,对每个询问在线段树上进行剪枝搜索. #include<bits/stdc++.h> ty ...

- 峰Redis学习(1)Redis简介和安装

是从博客:http://blog.java1234.com/blog/articles/310.html参考过来的: 第一节:Redis 简介 为什么需要NoSQL,主要应对以下问题,传统关系型数据库 ...

- Java-Runoob-高级教程-实例-方法:09. Java 实例 – continue 关键字用法-un

ylbtech-Java-Runoob-高级教程-实例-方法:09. Java 实例 – continue 关键字用法 1.返回顶部 1. Java 实例 - continue 关键字用法 Java ...

- 1120 Friend Numbers (20 分)

1120 Friend Numbers (20 分) Two integers are called "friend numbers" if they share the same ...

- Mongodb集群搭建之 Sharding+ Replica Sets集群架构

1.本例使用1台Linux主机,通过Docker 启动三个容器 IP地址如下: docker run -d -v `pwd`/data/master:/mongodb -p 27017:27017 d ...

- SAS 数值转日期

DATA _NULL_;FORMAT A YYMMDDN8.;B=PUT(20180101,$8.);A=INPUT(B,YYMMDD8.);PUT B= A=;RUN; 输出:47 DATA _ ...

- 更新SAS 9.4(64位) SID的简单方法(可以使用至2018.04.30)

打开SAS,在程序窗口输入: PROC SETINIT RELEASE='9.4'; SITEINFO NAME='NATIONAL PINGTUNG UNI OF SCIENCE&TECH' ...

- spark streaming的有状态例子

import org.apache.spark._ import org.apache.spark.streaming._ /** * Created by code-pc on 16/3/14. * ...

- 第11章 拾遗4:IPv6(2)_给计算机配置IPv6地址

4. 给计算机配置IPv6地址 4.1 无状态自动配置IPv6地址 (1)网络拓扑 ①无状态地址自动配置是指不需要DHCP服务器进行管理,由客户端向路由器发送前缀请求(RS)询问其所在网段.路由器收到 ...