将爬取的数据保存到mysql中

为了把数据保存到mysql费了很多周折,早上再来折腾,终于折腾好了

安装数据库

1、pip install pymysql(根据版本来装)

2、创建数据

打开终端 键入mysql -u root -p 回车输入密码

create database scrapy (我新建的数据库名称为scrapy)

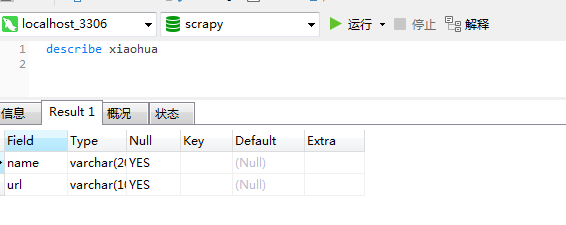

3、创建表

use scrapy;

create table xiaohua (name varchar(200) ,url varchar(100));

数据库部分就酱紫啦

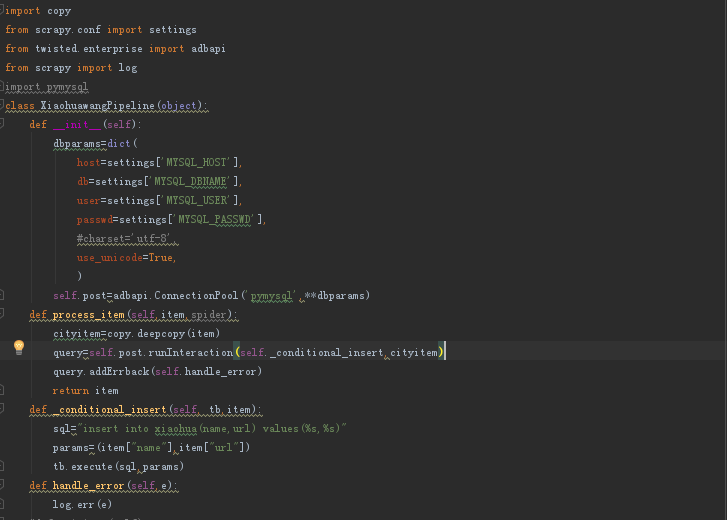

4、编写pipeline

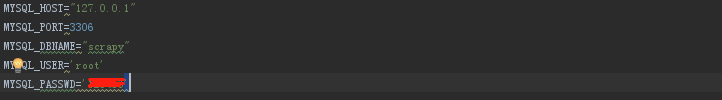

5、编写setting

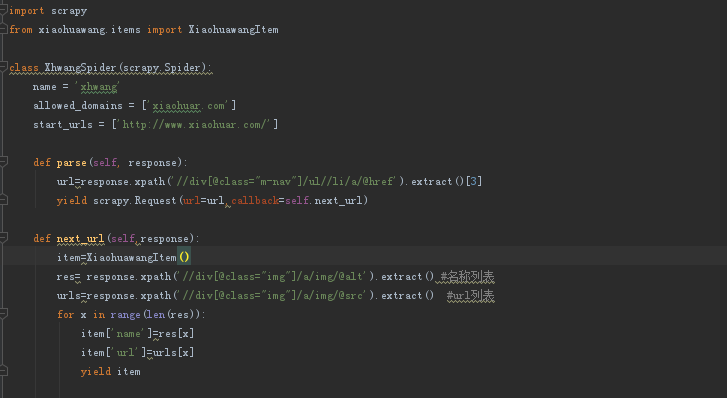

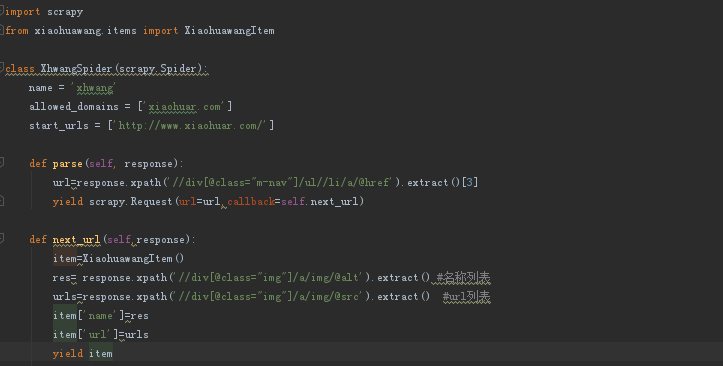

6、编写spider文件

7、爬取数据保存到mysql

scrapy crawl xhwang

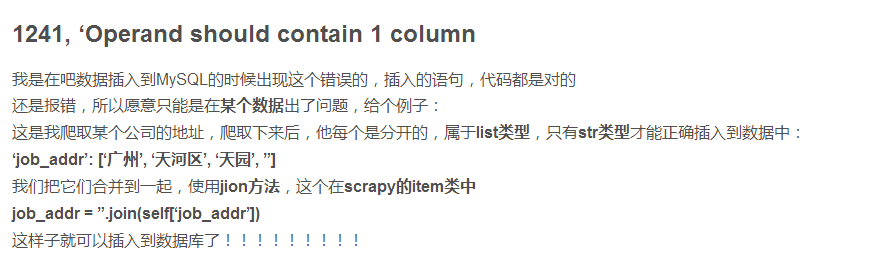

之前报错为2018-10-18 09:05:50 [scrapy.log] ERROR: (1241, 'Operand should contain 1 column(s)')

因为我的spider代码中是这样

附一张网上找到的答案

错误原因:item中的结果为{'name':[xxx,xxxx,xxxx,xxx,xxxxxxx,xxxxx],'url':[yyy,yyy,yy,y,yy,y,y,y,y,]},这种类型的数据

更正为6下面代码后出现如下会有重复

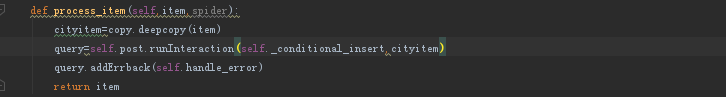

然后又查了下原因终于解决问题之所在

在图上可以看出,爬取的数据结果是没有错的,但是在保存数据的时候出错了,出现重复数据。那为什么会造成这种结果呢?

其原因是由于spider的速率比较快,scrapy操作数据库相对较慢,导致pipeline中的方法调用较慢,当一个变量正在处理的时候

一个新的变量过来,之前的变量值就会被覆盖了,解决方法是对变量进行保存,在保存的变量进行操作,通过互斥确保变量不被修改。

在pipeline中修改如下代码

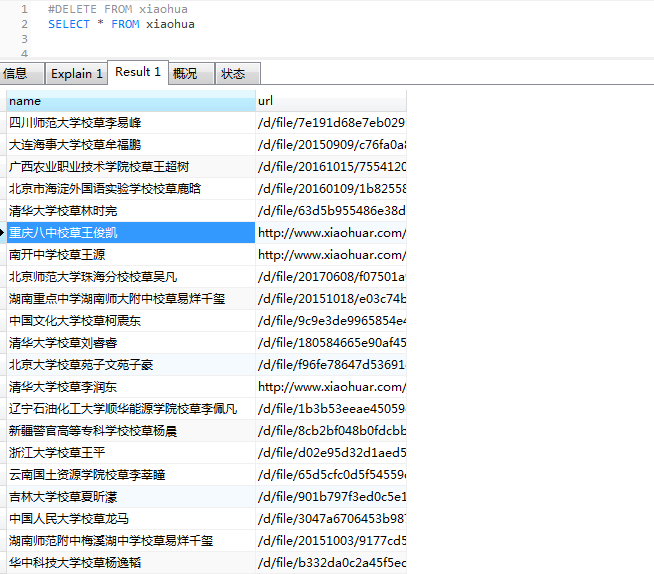

完成以上设定再来爬取,OK 大功告成(截取部分)

将爬取的数据保存到mysql中的更多相关文章

- 1.scrapy爬取的数据保存到es中

先建立es的mapping,也就是建立在es中建立一个空的Index,代码如下:执行后就会在es建lagou 这个index. from datetime import datetime fr ...

- 使用scrapy爬取的数据保存到CSV文件中,不使用命令

pipelines.py文件中 import codecs import csv # 保存到CSV文件中 class CsvPipeline(object): def __init__(self): ...

- 顺企网 爬取16W数据保存到Mongodb

import requests from bs4 import BeautifulSoup import pymongo from multiprocessing.dummy import Pool ...

- Asp.net Session 保存到MySql中

一 网站项目引入"mysql.web.dll" 二 web.config配置中添加mysql数据库连接字符串 <connectionStrings> <remov ...

- Python scrapy爬虫数据保存到MySQL数据库

除将爬取到的信息写入文件中之外,程序也可通过修改 Pipeline 文件将数据保存到数据库中.为了使用数据库来保存爬取到的信息,在 MySQL 的 python 数据库中执行如下 SQL 语句来创建 ...

- c# 抓取和解析网页,并将table数据保存到datatable中(其他格式也可以,自己去修改)

使用HtmlAgilityPack 基础请参考这篇博客:https://www.cnblogs.com/fishyues/p/10232822.html 下面是根据抓取的页面string 来解析并保存 ...

- Excel文件数据保存到SQL中

1.获取DataTable /// <summary> /// 查询Excel文件中的数据 /// </summary> /// <param name="st ...

- Redis使用场景一,查询出的数据保存到Redis中,下次查询的时候直接从Redis中拿到数据。不用和数据库进行交互。

maven使用: <!--redis jar包--> <dependency> <groupId>redis.clients</groupId> < ...

- python之scrapy爬取数据保存到mysql数据库

1.创建工程 scrapy startproject tencent 2.创建项目 scrapy genspider mahuateng 3.既然保存到数据库,自然要安装pymsql pip inst ...

随机推荐

- UFLDL 教程学习笔记(四)主成分分析

UFLDL(Unsupervised Feature Learning and Deep Learning)Tutorial 是由 Stanford 大学的 Andrew Ng 教授及其团队编写的一套 ...

- 使用 Notification API 开启浏览器桌面提醒

Notifications API 允许网页控制向最终用户显示系统通知 —这些都在顶级浏览上下文视口之外,因此即使用户已经切换标签页或移动到不同的应用程序,也可以显示.该API被设计成与不同平台上的现 ...

- Android_性能优化转载

胡凯 RSS Blog Archives Android Training in Chinese About Android性能优化典范 JAN 17TH, 2015 | COMMENTS 2015年 ...

- 网站性能压力测试工具--apache ab使用详解

ab是apache自带的压力测试工具.ab非常实用,它不仅可以对apache服务器进行网站访问压力测试,也可以对其它类型的服务器进行压力测试.比如nginx.tomcat.IIS等. 下面我们开始介绍 ...

- static和fianl修饰变量的区别

参考:http://hllvm.group.iteye.com/group/topic/37682 http://blog.csdn.net/javakuroro/article/details/68 ...

- python3爬虫——下载unsplash美图到本地

最近发现一个网站www.unsplash.com ( 没有广告费哈,纯粹觉得不错 ),网页做得很美观,上面也都是一些免费的摄影照片,觉得很好看,就决定利用蹩脚的技能写个爬虫下载图片. 先随意感受一下这 ...

- Linux系列教程(三)——Linux学习技巧

前面我们讲了Linux系统的详细安装教程,大家跟着教程一步一步的操作,应该能完美的完成安装.那么这篇博客跟大家聊聊如何来学习Linux. 1.工欲善其事必先利其器 ①.第一个问题:通过前面在虚拟软件中 ...

- JSP+Servlet+mysql简单示例【图文教程】

下载MYSQL:http://dev.mysql.com/downloads/ 下载安装版的 然后安装(安装步骤就不详细说了) 安装好之后,点击托盘图标,打开管理工具 创建一个数据库 数据库的名字 ...

- .Net Core中的日志组件(Logging)

1.介绍 Logging组件是微软实现的日志记录组件包括控制台(Console).调试(Debug).事件日志(EventLog)和TraceSource,但是没有实现最常用用的文件记录日志功能(可以 ...

- js 计算快速统计中用到的日期

前言 最近在做统计报表模块,其中查询条件用到了快速查询,主要为了方便客户统计查询常用的几个日期纬度,比如本周.上周.本月.上月.昨日. 使用js计算,主要用到了js Date. getDate().g ...