机器学习作业(一)线性回归——Matlab实现

题目太长啦!文档下载【传送门】

第1题

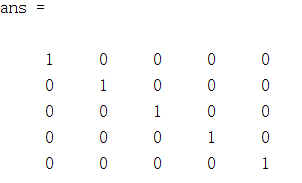

简述:设计一个5*5的单位矩阵。

function A = warmUpExercise()

A = [];

A = eye(5);

end

运行结果:

第2题

简述:实现单变量线性回归。

第1步:加载数据文件;

data = load('ex1data1.txt');

X = data(:, 1); y = data(:, 2);

m = length(y); % number of training examples

% Plot Data

% Note: You have to complete the code in plotData.m

plotData(X, y);

第2步:plotData函数实现训练样本的可视化;

function plotData(x, y)

figure;

plot(x,y,'rx','MarkerSize',10);

ylabel('Profit in $10,000s');

xlabel('Population of City in 10,000s');

end

第3步:使用梯度下降函数计算局部最优解,并显示线性回归;

X = [ones(m, 1), data(:,1)]; % Add a column of ones to x

theta = zeros(2, 1); % initialize fitting parameters

% Some gradient descent settings

iterations = 1500;

alpha = 0.01;

% run gradient descent

theta = gradientDescent(X, y, theta, alpha, iterations);

% print theta to screen

fprintf('Theta found by gradient descent:\n');

fprintf('%f\n', theta);

% Plot the linear fit

hold on; % keep previous plot visible

plot(X(:,2), X*theta, '-')

legend('Training data', 'Linear regression')

hold off % don't overlay any more plots on this figure

第4步:实现梯度下降gradientDescent函数;

function [theta, J_history] = gradientDescent(X, y, theta, alpha, num_iters) % Initialize some useful values

m = length(y); % number of training examples

J_history = zeros(num_iters, 1); for iter = 1:num_iters

theta = theta - alpha/length(y)*(X'*(X*theta-y));

% Save the cost J in every iteration

J_history(iter) = computeCost(X, y, theta);

end end

第5步:实现代价计算computeCost函数;

function J = computeCost(X, y, theta)

m = length(y); % number of training examples

J = 1/(2*m)*sum((X*theta-y).^2);

end

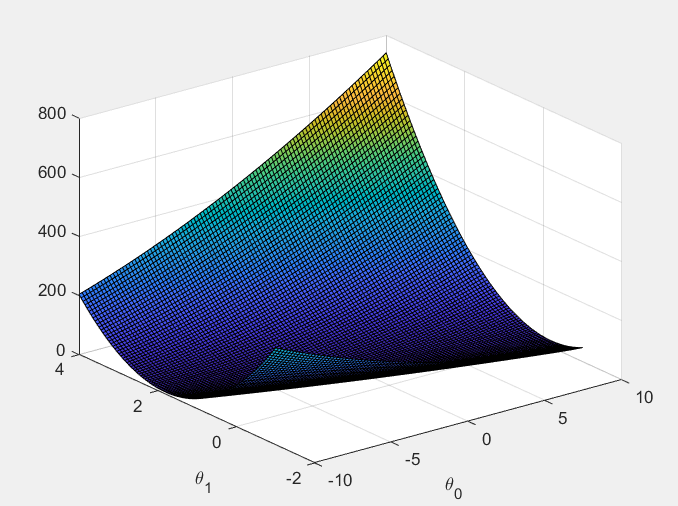

第6步:实现三维图、轮廓图的显示。

% Grid over which we will calculate J

theta0_vals = linspace(-10, 10, 100);

theta1_vals = linspace(-1, 4, 100); % initialize J_vals to a matrix of 0's

J_vals = zeros(length(theta0_vals), length(theta1_vals)); % Fill out J_vals

for i = 1:length(theta0_vals)

for j = 1:length(theta1_vals)

t = [theta0_vals(i); theta1_vals(j)];

J_vals(i,j) = computeCost(X, y, t);

end

end % Because of the way meshgrids work in the surf command, we need to

% transpose J_vals before calling surf, or else the axes will be flipped

J_vals = J_vals';

% Surface plot

figure;

surf(theta0_vals, theta1_vals, J_vals);

xlabel('\theta_0'); ylabel('\theta_1'); % Contour plot

figure;

% Plot J_vals as 15 contours spaced logarithmically between 0.01 and 100

contour(theta0_vals, theta1_vals, J_vals, logspace(-2, 3, 20))

xlabel('\theta_0'); ylabel('\theta_1');

hold on;

plot(theta(1), theta(2), 'rx', 'MarkerSize', 10, 'LineWidth', 2);

运行结果:

第3题

简述:实现多元线性回归。

第1步:加载数据文件;

data = load('ex1data2.txt');

X = data(:, 1:2);

y = data(:, 3);

m = length(y);

[X mu sigma] = featureNormalize(X);

% Add intercept term to X

X = [ones(m, 1) X];

第2步:均值归一化featureNormalize函数实现;

function [X_norm, mu, sigma] = featureNormalize(X) X_norm = X;

mu = zeros(1, size(X, 2));

sigma = zeros(1, size(X, 2));

mu = mean(X,1);

sigma = std(X,0,1);

X_norm = (X_norm-mu)./sigma; end

第3步:使用梯度下降函数计算局部最优解,并显示线性回归;

% Choose some alpha value

alpha = 0.05;

num_iters = 100; % Init Theta and Run Gradient Descent

theta = zeros(3, 1);

[theta, J_history] = gradientDescentMulti(X, y, theta, alpha, num_iters); % Plot the convergence graph

figure;

plot(1:numel(J_history), J_history, '-b', 'LineWidth', 2);

xlabel('Number of iterations');

ylabel('Cost J');

第4步:实现梯度下降gradientDescentMulti函数;

function [theta, J_history] = gradientDescentMulti(X, y, theta, alpha, num_iters) m = length(y); % number of training examples

J_history = zeros(num_iters, 1); for iter = 1:num_iters

theta = theta - alpha/m*(X'*(X*theta-y));

% Save the cost J in every iteration

J_history(iter) = computeCostMulti(X, y, theta);

end end

第5步:实现代价计算computeCostMulti函数;

function J = computeCostMulti(X, y, theta)

m = length(y); % number of training examples

J = 1/(2*m)*sum((X*theta-y).^2);%J=(X*theta-y)'*(X*theta-y)/(2*m);

end

运行结果:

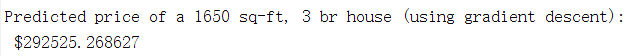

第6步:使用上述结果对“the price of a 1650 sq-ft, 3 br house”进行预测;

X1 = [1,1650,3];

X1(2:3) = (X1(2:3)-mu)./sigma;

price = X1*theta;

预测结果:

第7步:使用正规方程法求解;

%%Load Data

data = csvread('ex1data2.txt');

X = data(:, 1:2);

y = data(:, 3);

m = length(y); % Add intercept term to X

X = [ones(m, 1) X]; % Calculate the parameters from the normal equation

theta = normalEqn(X, y);

第8步:实现normalEqn函数;

function [theta] = normalEqn(X, y)

theta = zeros(size(X, 2), 1);

theta = (X'*X)^(-1)*X'*y;

end

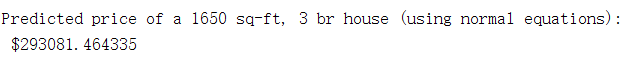

第9步:使用上述结果对“the price of a 1650 sq-ft, 3 br house”再次进行预测;

price = [1,1650,3]*theta;

预测结果:(与梯度下降法结果很接近)

机器学习作业(一)线性回归——Matlab实现的更多相关文章

- Andrew Ng机器学习课程笔记--week1(机器学习介绍及线性回归)

title: Andrew Ng机器学习课程笔记--week1(机器学习介绍及线性回归) tags: 机器学习, 学习笔记 grammar_cjkRuby: true --- 之前看过一遍,但是总是模 ...

- 机器学习:单元线性回归(python简单实现)

文章简介 使用python简单实现机器学习中单元线性回归算法. 算法目的 该算法核心目的是为了求出假设函数h中多个theta的值,使得代入数据集合中的每个x,求得的h(x)与每个数据集合中的y的差值的 ...

- 機器學習基石(Machine Learning Foundations) 机器学习基石 作业四 Q13-20 MATLAB实现

大家好,我是Mac Jiang,今天和大家分享Coursera-NTU-機器學習基石(Machine Learning Foundations)-作业四 Q13-20的MATLAB实现. 曾经的代码都 ...

- Coursera-AndrewNg(吴恩达)机器学习笔记——第二周编程作业(线性回归)

一.准备工作 从网站上将编程作业要求下载解压后,在Octave中使用cd命令将搜索目录移动到编程作业所在目录,然后使用ls命令检查是否移动正确.如: 提交作业:提交时候需要使用自己的登录邮箱和提交令牌 ...

- 机器学习作业(五)机器学习算法的选择与优化——Matlab实现

题目下载[传送门] 第1步:读取数据文件,并可视化: % Load from ex5data1: % You will have X, y, Xval, yval, Xtest, ytest in y ...

- 机器学习作业(一)线性回归——Python(numpy)实现

题目太长啦!文档下载[传送门] 第1题 简述:设计一个5*5的单位矩阵. import numpy as np A = np.eye(5) print(A) 运行结果: 第2题 简述:实现单变量线性回 ...

- 机器学习作业(八)异常检测与推荐系统——Matlab实现

题目下载[传送门] 第1题 简述:对于一组网络数据进行异常检测. 第1步:读取数据文件,使用高斯分布计算 μ 和 σ²: % The following command loads the datas ...

- 机器学习作业(七)非监督学习——Matlab实现

题目下载[传送门] 第1题 简述:实现K-means聚类,并应用到图像压缩上. 第1步:实现kMeansInitCentroids函数,初始化聚类中心: function centroids = kM ...

- 机器学习作业(六)支持向量机——Matlab实现

题目下载[传送门] 第1题 简述:支持向量机的实现 (1)线性的情况: 第1步:读取数据文件,可视化数据: % Load from ex6data1: % You will have X, y in ...

随机推荐

- ASP.NET Core MVC的基础学习笔记

最近由于“武汉肺炎”疫情在家办公,也没闲着,最近学习了一下asp.net core mvc的一些网页开发的的基础知识,话不多说直接上教程! 一.创建Web应用程序 1)创建新项目--->找到 “ ...

- Mysql:MySQL数据管理

Mysql:MySQL数据管理 外键管理 外键概念 如果公共关键字在一个关系中是主关键字,那么这个公共关键字被称为另一个关系的外键.由此可见,外键表示了两个关系之间的相关联系.以另一个关系的外键作主关 ...

- SDRAM的引脚封装标准

SDRAM从发展到现在已经经历了五代,分别是:第一代SDR SDRAM,第二代DDR SDRAM,第三代DDR2 SDRAM,第四代DDR3 SDRAM,第五代DDR4 SDRAM.第一代SDRAM采 ...

- sklearn使用小贴士

1 sklearn简介 Scikit-learn(sklearn)是机器学习中的第三方模块,封装了常用的机器学习算法,涉及回归.降维.分类以及聚类等,提供python接口. 虽然sklearn容纳的算 ...

- 陶陶摘苹果(升级版)P1478_巧妙模拟

如此水的题居然让我绞尽脑汁,我在想我是不是快退役了. 这道题我看见很多解法:贪心,背包,桶排乱七八糟一大堆. 题目 题目描述 又是一年秋季时,陶陶家的苹果树结了 n 个果子.陶陶又跑去摘苹果,这次他有 ...

- 在Idea中jdk11和jdk8环境变量的切换

先配置好jdk11和jdk8环境变量 idea(2019.3)中jdk版本切换(jdk8和jdk11) 快捷键ctrl + shift + alt +s ,将jdk11修改为jdk1.8 完成后,显示 ...

- Programming on C 学习笔记

目录 include不同的声明方式有什么不同? if defined 与 #ifdef 有什么区别? undef 是怎么工作的? 如何利用 typedef 来定义数组? 枚举中,如果有个元素被赋予值, ...

- GitHook 工具 —— husky介绍及使用

名称 githooks-Git使用的挂钩.(githook在官网的介绍) 描述 如同其他许多的版本控制系统一样,Git 也具有在特定事件发生之前或之后执行特定脚本代码功能(从概念上类比,就与监听事件. ...

- IDEA 在debug模式下启动慢或者无法启动解决

参考:https://www.cnblogs.com/han-1034683568/p/8603588.html 背景 这两天在开发项目的时候发现用debug模式启动项目的时候,项目启动速度非常慢甚至 ...

- linux中安装nginx时查看修改80端口时没有iptables文件的内容?? 求解