【HBase】带你了解一哈HBase的各种预分区

简单了解

概述

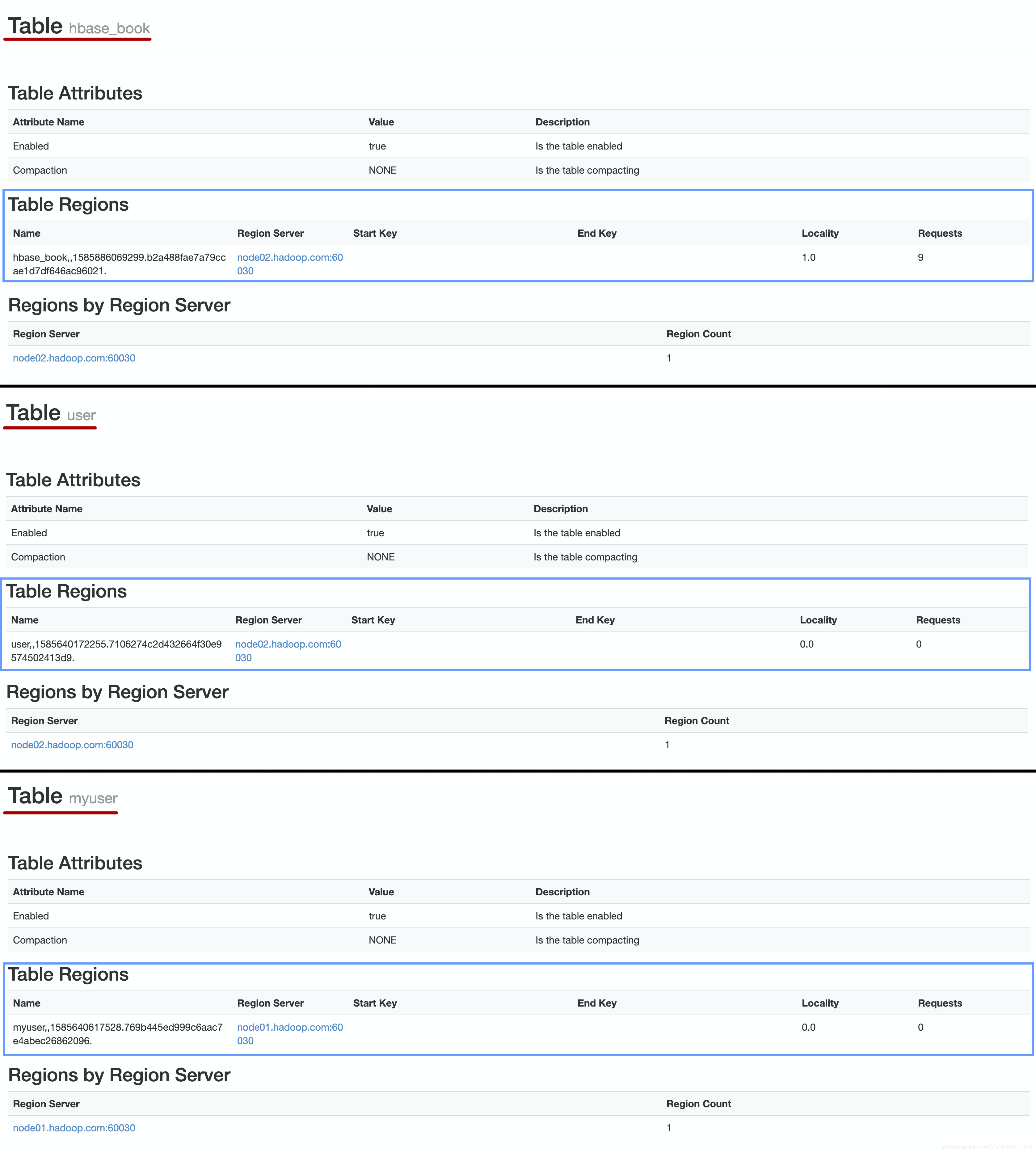

由上图可以看出,每一个表都有属于自己的一个Region,但Region内的数据达到10GB时,会进行分割,但仍会在同一个RegionServer上,而预分区的作用主要是增加数据读写效率、负载均衡、防止数据倾斜、方便集群容灾调度Region和优化Map数量

设置预分区

在设置预分区前要先明白一个概念,每一个Region都维护着从StartKey到EndKey的数据,如果加入的数据符合某个Region的rowKey范围,就把数据交给这个Region维护

比如说,现在有三个分区,它们的StartKey和EndKey分别是1-1000,1001-2000,2001-3000,现在如果有一条rowKey为1888的数据,那么他就会被分配到第二个Region中

预分区的设置方法一共有四种:

一、手动指定预分区

进入hbase shell输入一下命令

create 'staff','info','partition1',SPLITS => ['1000','2000','3000','4000']

二、使用16进制算法生成预分区

进入hbase shell输入一下命令

create 'staff2','info','partition2',{NUMREGIONS => 15, SPLITALGO => 'HexStringSplit'}

三、将分区规则写在文本文件中

首先在/export/servers目录下创建splits.txt文本文件,并输入一下内容

aaaabbbbccccdddd

然后在hbase shell中执行以下命令

create 'staff3','partition2',SPLITS_FILE => '/export/servers/splits.txt'

四、使用JavaAPI进行预分区

import org.apache.hadoop.conf.Configuration;import org.apache.hadoop.hbase.HBaseConfiguration;import org.apache.hadoop.hbase.HColumnDescriptor;import org.apache.hadoop.hbase.HTableDescriptor;import org.apache.hadoop.hbase.TableName;import org.apache.hadoop.hbase.client.Admin;import org.apache.hadoop.hbase.client.Connection;import org.apache.hadoop.hbase.client.ConnectionFactory;import org.testng.annotations.Test;import java.io.IOException;public class HbasePartition {/*** 通过javaAPI进行HBase的表的创建以及预分区操作*/@Testpublic void hbaseSplit() throws IOException {//获取连接Configuration configuration = HBaseConfiguration.create();configuration.set("hbase.zookeeper.quorum", "node01:2181,node02:2181,node03:2181");Connection connection = ConnectionFactory.createConnection(configuration);Admin admin = connection.getAdmin();//自定义算法,产生一系列Hash散列值存储在二维数组中byte[][] splitKeys = {{1,2,3,4,5},{'a','b','c','d','e'}};//通过HTableDescriptor来实现我们表的参数设置,包括表名,列族等等HTableDescriptor hTableDescriptor = new HTableDescriptor(TableName.valueOf("stuff4"));//添加列族hTableDescriptor.addFamily(new HColumnDescriptor("f1"));//添加列族hTableDescriptor.addFamily(new HColumnDescriptor("f2"));admin.createTable(hTableDescriptor,splitKeys);admin.close();}}

注意

在实际工作当中,创建表时一般都需要提前做预分区处理,一般来说每台服务器上面设置两个到五个的预分区,这么做可以更好地减少Split的过程,在设置预分区时,rowKey的设计尤为重要

关于rowKey的设计可以查看文章:【HBase】快速了解上手rowKey的设计技巧

【HBase】带你了解一哈HBase的各种预分区的更多相关文章

- 一文带你读懂 Hbase 的架构组成

hi,大家好,我是大D.今天咱们继续深挖一下 HBase 的架构组成. Hbase 作为 NoSQL 数据库的代表,属于三驾马车之一 BigTable 的对应实现,HBase 的出现很好地弥补了大数据 ...

- Hbase总结(一)-hbase命令,hbase安装,与Hive的区别,与传统数据库的区别,Hbase数据模型

Hbase总结(一)-hbase命令 下面我们看看HBase Shell的一些基本操作命令,我列出了几个常用的HBase Shell命令,如下: 名称 命令表达式 创建表 create '表名称', ...

- Hbase理论&&hbase shell&&python操作hbase&&python通过mapreduce操作hbase

一.Hbase搭建: 二.理论知识介绍: 1Hbase介绍: Hbase是分布式.面向列的开源数据库(其实准确的说是面向列族).HDFS为Hbase提供可靠的底层数据存储服务,MapReduce为Hb ...

- 一脸懵逼学习HBase的搭建(注意HBase的版本)

1:Hdfs分布式文件系统存的文件,文件存储. 2:Hbase是存储的数据,海量数据存储,作用是缓存的数据,将缓存的数据满后写入到Hdfs中. 3:hbase集群中的角色: ().一个或者多个主节点, ...

- Hbase总结(五)-hbase常识及habse适合什么场景

当我们对于数据结构字段不够确定或杂乱无章非常难按一个概念去进行抽取的数据适合用使用什么数据库?答案是什么,假设我们使用的传统数据库,肯定留有多余的字段.10个不行,20个,可是这个严重影响了质量. 而 ...

- linux 下通过过 hbase 的Java api 操作hbase

hbase版本:0.98.5 hadoop版本:1.2.1 使用自带的zk 本文的内容是在集群中创建java项目调用api来操作hbase,主要涉及对hbase的创建表格,删除表格,插入数据,删除数据 ...

- hbase学习(二)hbase单机和高可用完全分布式安装部署

hbase版本 2.0.4 与hadoop兼容表http://hbase.apache.org/book.html#hadoop 我的 hadoop版本是3.1 1.单机版hbase 1.1解 ...

- 一条数据的HBase之旅,简明HBase入门教程-开篇

常见的HBase新手问题: 什么样的数据适合用HBase来存储? 既然HBase也是一个数据库,能否用它将现有系统中昂贵的Oracle替换掉? 存放于HBase中的数据记录,为何不直接存放于HDFS之 ...

- 一条数据的HBase之旅,简明HBase入门教程1:开篇

[摘要] 这是HBase入门系列的第1篇文章,主要介绍HBase当前的项目活跃度以及搜索引擎热度信息,以及一些概况信息,内容基于HBase 2.0 beta2版本.本系列文章既适用于HBase新手,也 ...

随机推荐

- Nginx+uWSGI+Python+Django构建必应高清壁纸站

写在前面 做这个网站的初衷是因为,每次打开必应搜索搜东西的时候都会被上面的背景图片吸引,我想必应的壁纸应该是经过专业人员精选出来的,我甚至会翻看以前的历史图片,唯一美中不足的是必应的首页只能查看最多7 ...

- Prometheus监控 Redis & Redis Cluster 说明

说明 在前面的Prometheus + Grafana 部署说明之「安装」文章里,大致介绍说明了Prometheus和Grafana的一些安装使用,现在开始如何始部署Prometheus+Grafan ...

- 算法笔记刷题3(codeup 5901)

今天刷题的速度依旧很慢(小乌龟挥爪.jpg) 我觉得codeup5901中回文串的处理很妙,如果是我自己写的话可能会把数组直接倒过来和原来对比.按照对称规律进行比对的话,工作量可以减少一半. #inc ...

- Excel导入异常Cannot get a text value from a numeric cell解决及poi导入时注意事项

POI操作Excel时偶尔会出现Cannot get a text value from a numeric cell的异常错误. 异常原因:Excel数据Cell有不同的类型,当我们试图从一个数字类 ...

- 事件总线功能库,Reface.EventBus 详细使用教程

Reface.AppStarter 中的事件总线功能是通过 Reface.EventBus 提供的. 参考文章 : Reface.AppStarter 框架初探 使用 Reface.EventBus ...

- 虚拟机 VMware Workstation Pro 15.5.0 及永久激活密钥

虚拟机 VMware Workstation Pro 15.5.0 及永久激活密钥 虚拟机下载地址:https://download3.vmware.com/software/wkst/file/VM ...

- 听说你在从事前端开发?那这10个JavaScript的优化问题你不得不知道!

JavaScript的高效优化一直都是我们前端开发中非常重要的工作,也是很多开发人员无法做好的一部分内容,今天我总结了10个优化问题,大家可以参考来做优化,这其中很多问题都是大家经常遇到的哦. ==和 ...

- Spring Boot 静态文件,请求不到,util文件夹

静态文件貌似对util文件夹有特殊处理static/js/test.js 可以请求到static/js/laydate/test.js 可以请求到static/js/util/test.js 请求不到

- 自动驾驶汽车数据不再封闭,Uber 开源新的数据可视化系统

日前,Uber 开源了基于 web 的自动驾驶可视化系统(AVS),称该系统为自动驾驶行业带来理解和共享数据的新方式.AVS 由Uber旗下负责自动驾驶汽车研发的技术事业群(ATG)开发,目前该系统已 ...

- Kudu,支持快速分析的新型Hadoop存储系统

Kudu是Cloudera开源的新型列式存储系统,是Apache Hadoop生态圈的新成员之一(incubating),专门为了对快速变化的数据进行快速的分析,填补了以往Hadoop存储层的空缺.本 ...