Spark文档阅读之二:Programming Guides - Quick Start

Quick Start: https://spark.apache.org/docs/latest/quick-start.html

一、最简单的Spark Shell交互分析

scala> val textFile = spark.read.textFile("README.md") # 构建一个Dataset

textFile: org.apache.spark.sql.Dataset[String] = [value: string]

scala> textFile.count() # Dataset的简单计算

res0: Long =

scala> val linesWithSpark = textFile.filter(line => line.contain("Spark")) # 由现有Dataset生成新Dataset

res1: org.apache.spark.sql.Dataset[String] = [value: string]

# 等价于:

# res1 = new Dataset()

# for line in textFile:

# if line.contain("Spark"):

# res1.append(line)

# linesWithSpark = res1

scala> linesWithSpark.count()

res2: Long =

# 可以将多个操作串行起来

scala> textFile.filter(line => line.contain("Spark")).count()

res3: Long =

进一步的Dataset分析:

scala> textFile.map(line => line.split(" ").size).reduce((a,b) => if (a > b) a else b)

res12: Int =

# 其实map和reduce就是两个普通的算子,不要被MapReduce中一个map配一个reduce、先map后reduce的思想所束缚

# map算子就是对Dataset的元素X计算fun(X),并且将所有f(X)作为新的Dataset返回

# reduce算子其实就是通过两两计算fun(X,Y)=Z,将Dataset中的所有元素归约为1个值

# 也可以引入库进行计算

scala> import java.lang.Math

import java.lang.Math

scala> textFile.map(line => line.split(" ").size).reduce((a, b) => Math.max(a, b))

res14: Int =

# 还可以使用其他算子

scala> val wordCounts = textFile.flatMap(line => line.split(" ")).groupByKey(identity).count()

# flatMap算子也是对Dataset的每个元素X执行fun(X)=Y,只不过map的res是

# res.append(Y),如[[Y11, Y12], [Y21, Y22]],结果按元素区分

# 而flatMap是

# res += Y,如[Y11, Y12, Y21, Y22],各元素结果合在一起

# groupByKey算子将Dataset的元素X作为参数传入进行计算f(X),并以f(X)作为key进行分组,返回值为KeyValueGroupedDataset类型

# 形式类似于(key: k; value: X1, X2, ...),不过KeyValueGroupedDataset不是一个Dataset,value列表也不是一个array

# 注意:这里的textFile和textFile.flatMap都是Dataset,不是RDD,groupByKey()中可以传func;如果以sc.textFile()方法读文件,得到的是RDD,groupByKey()中间不能传func

# identity就是函数 x => x,即返回自身的函数

# KeyValueGroupedDataset的count()方法返回(key, len(value))列表,结果是Dataset类型

scala> wordCounts.collect()

res37: Array[(String, Long)] = Array((online,), (graphs,), ...

# collect操作:将分布式存储在集群上的RDD/Dataset中的所有数据都获取到driver端

数据的cache:

scala> linesWithSpark.cache() # in-memory cache,让数据在分布式内存中缓存

res38: linesWithSpark.type = [value: string] scala> linesWithSpark.count()

res41: Long =

二、最简单的独立Spark任务(spark-submit提交)

import org.apache.spark.sql.SparkSession

object SimpleApp {

def main(args: Array[String]) {

val logFile = "/Users/dxm/work-space/spark-2.4.5-bin-hadoop2.7/README.md"

val spark = SparkSession.builder.appName("Simple Application").getOrCreate()

val logData = spark.read.textFile(logFile).cache()

val numAs = logData.filter(line => line.contains("a")).count() # 包含字母a的行数

val numBs = logData.filter(line => line.contains("b")).count() # 包含字母b的行数

println(s"Lines with a: $numAs, Lines with b: $numBs")

spark.stop()

}

}

2)编写sbt依赖文件build.sbt

name := "Simple Application" version := "1.0" scalaVersion := "2.12.10" libraryDependencies += "org.apache.spark" %% "spark-sql" % "2.4.5"

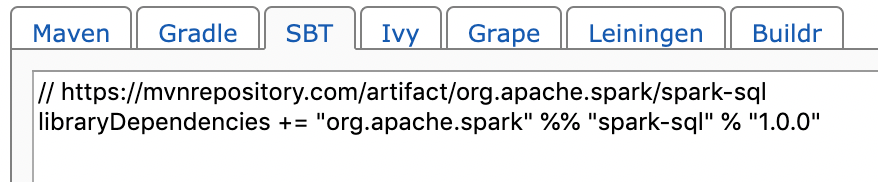

其中,"org.apache.spark" %% "spark-sql" % "2.4.5"这类库名可以在网上查到,例如https://mvnrepository.com/artifact/org.apache.spark/spark-sql_2.10/1.0.0

$ find .

.

./build.sbt

./src

./src/main

./src/main/scala

./src/main/scala/SimpleApp.scala

sbt目录格式要求见官方文档 https://www.scala-sbt.org/1.x/docs/Directories.html

src/

main/

resources/

<files to include in main jar here>

scala/

<main Scala sources>

scala-2.12/

<main Scala 2.12 specific sources>

java/

<main Java sources>

test/

resources

<files to include in test jar here>

scala/

<test Scala sources>

scala-2.12/

<test Scala 2.12 specific sources>

java/

<test Java sources>

使用sbt打包

# 打包

$ sbt package

...

[success] Total time: s (:), completed -- ::

# jar包位于 target/scala-2.12/simple-application_2.-1.0.jar

4)提交并执行Spark任务

$ bin/spark-submit --class "SimpleApp" --master spark://xxx:7077 ../scala-tests/SimpleApp/target/scala-2.12/simple-application_2.12-1.0.jar

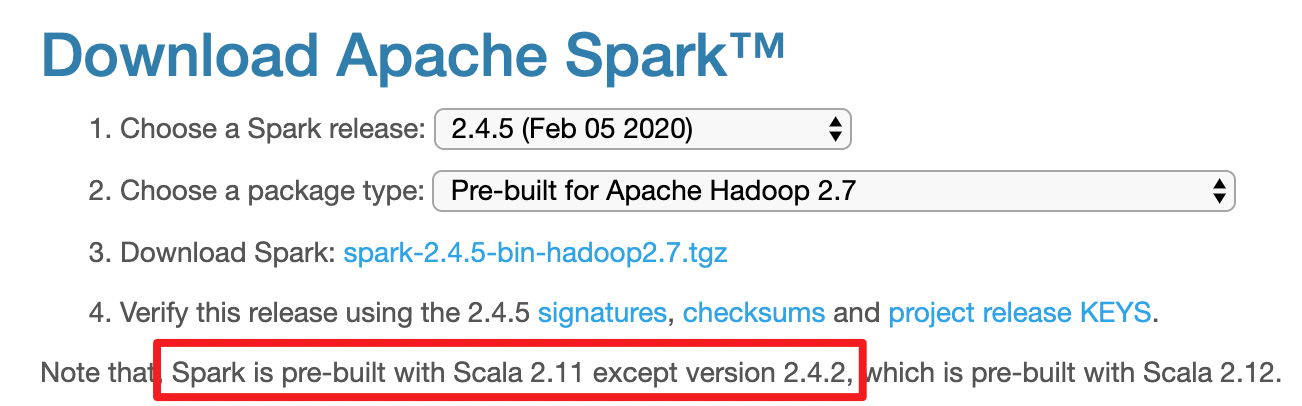

# 报错:Caused by: java.lang.ClassNotFoundException: scala.runtime.LambdaDeserialize

# 参考:https://stackoverflow.com/questions/47172122/classnotfoundexception-scala-runtime-lambdadeserialize-when-spark-submit

# 这是spark版本和scala版本不匹配导致的

查询spark所使用的scala的版本

$ bin/spark-shell --master spark://xxx:7077 scala> util.Properties.versionString

res0: String = version 2.11.

$ bin/spark-submit --class "SimpleApp" --master spark://xxx:7077 ../scala-tests/SimpleApp/target/scala-2.11/simple-application_2.11-1.0.jar

Lines with a: , Lines with b:

Spark文档阅读之二:Programming Guides - Quick Start的更多相关文章

- Spring 4.3.11.RELEASE文档阅读(二):Core Technologies_IOC

在看这部分内容的时候,想了一些问题: 容器: 1,什么是容器 用来包装或装载物品的贮存器 2,容器能做什么 包装或装载物品 3,为什么需要容器 为什么要使用集装箱?如果没有容器会是什么样? 4,常见的 ...

- Spark文档阅读之一:Spark Overview

Document: https://spark.apache.org/docs/latest/index.html 版本:2.4.5 1. spark的几种执行方式 1)交互式shell:bin/ ...

- Spring 4.3.11.RELEASE文档阅读(二):Core Technologies_AOP

虽然并不是每个问题都有答案,但我想了很多问题.so, just write it down , maybe one day...... AOP: 1,AOP是啥 2,AOP思想是怎么产生的 3,AOP ...

- 转:苹果Xcode帮助文档阅读指南

一直想写这么一个东西,长期以来我发现很多初学者的问题在于不掌握学习的方法,所以,Xcode那么好的SDK文档摆在那里,对他们也起不到什么太大的作用.从论坛.微博等等地方看到的初学者提出的问题,也暴露出 ...

- Node.js的下载、安装、配置、Hello World、文档阅读

Node.js的下载.安装.配置.Hello World.文档阅读

- 我的Cocos Creator成长之路1环境搭建以及基本的文档阅读

本人原来一直是做cocos-js和cocos-lua的,应公司发展需要,现转型为creator.会在自己的博客上记录自己的成长之路. 1.文档阅读:(cocos的官方文档) http://docs.c ...

- Keras 文档阅读笔记(不定期更新)

目录 Keras 文档阅读笔记(不定期更新) 模型 Sequential 模型方法 Model 类(函数式 API) 方法 层 关于 Keras 网络层 核心层 卷积层 池化层 循环层 融合层 高级激 ...

- Django文档阅读-Day1

Django文档阅读-Day1 Django at a glance Design your model from djano.db import models #数据库操作API位置 class R ...

- Django文档阅读-Day2

Django文档阅读 - Day2 Writing your first Django app, part 1 You can tell Django is installed and which v ...

随机推荐

- Gym100548F Color

题目链接:https://vjudge.net/problem/Gym-100548F 题目大意: n 朵花,按顺序排成一排.从 m 种颜色中选出 k 种颜色,给这 n 朵花染色,要求相邻的花颜色不同 ...

- upload-labs通关手册

最近在练习文件上传,所以记录一下自己练习的过程,既能帮助自己以后复习,同时也能帮到初学者. 主要用到的工具是Burpsuite.首先我们应该明白上传文件的目的是什么,通过上传文件将web后门上传并被成 ...

- docker出现相同的image条目的删除办法

一.问题:在测试docker安装的prometheus系统时,由于异常操作,使用docker image ls出现了两条一模一样的条目,如下: [root@ELK prometheus]# docke ...

- POJ 2671 Jimmy's Bad Day题解(很详细很友好,类似区间dp)

有问题的话欢迎在评论区提出 题意: 题目链接 你是一个送快递的,现在给你一个环,环的边有权值,代表走这条边所花的时间,每个点代表一个地点,点有点权,代表这个点上有多少货物需要你送.初始时间\(t=0\ ...

- Rocket - diplomacy - AddressAdjuster

https://mp.weixin.qq.com/s/X0s5CWN84GEiwpNR7tiRgA 基于AddressAdjuster介绍LazyModule的实现. 参考链接:https://g ...

- 【Spring】JdbcTemplate的使用,查询,增、删、改

数据库名:taobaodb 配置文件: JdbcTemplate主要提供以下五类方法: execute方法:可以用于执行任何SQL语句,一般用于执行DDL语句: update方法及batchUpdat ...

- 面试题:我们重写一个对象的时候为什么要同时重写hashcode()和equals()方法

个人博客网:https://wushaopei.github.io/ (你想要这里多有) 在创建的类不重写hashCode()和equals() 方法时,默认使用 java 提供的 java.l ...

- python3 的setter方法及property修饰

#!/usr/bin/env pthon#coding:utf-8 class person(object): def __init__(self,name,sex,age,surface,heigh ...

- Java实现考察团组成

考察团组成 某饭店招待国外考察团.按照标准,对领导是400元/人,随团职员200元/人,对司机50元/人. 考察团共36人,招待费结算为3600元,请问领导.职员.司机各几人. 答案是三个整数,用逗号 ...

- 09 . Nginx配置LNMP和LNMT架构

安装LNMP架构 环境清单 list CentOS7.3 proxysql-2.0.12-1-centos7.x86_64.rpm mysql-5.7.23-1.el7.x86_64.rpm-bund ...