大数据-HBase HA集群搭建

1、下载对应版本的Hbase,在我们搭建的集群环境中选用的是hbase-1.4.6

将下载完成的hbase压缩包放到对应的目录下,此处我们的目录为/opt/workspace/

2、对已经有的压缩包进行解压缩

[root@master1 workspace]#tar -zxvf hbase-1.4.-bin.tar.gz

3、为了方便可以将文件重命名,此处我们不需要重命名

4、修改配置文件、/etc/profile,添加下面代码

# HBase Config

export HBASE_HOME=/opt/workspace/hbase-1.4.

export PATH=.:${JAVA_HOME}/bin:${SCALA_HOME}/bin:$HADOOP_HOME/sbin:$HADOOP_HOME/bin:${HIVE_HOME}/bin:${SPARK_HOME}/bin:${HBASE_HOME}/bin:${ZK_HOME}/bin:$PATH

[root@master1 workspace]# source /etc/profile

5、修改配置文件hbase-env.sh,在文件中添加如下,其中HBASE_MANAGES_ZK=false 是不启用HBase自带的Zookeeper集群。

export JAVA_HOME=/opt/workspace/jdk1.

export HADOOP_HOME=/opt/workspace/hadoop-2.9.

export HBASE_HOME=/opt/workspace/hbase-1.4.

export HBASE_CLASSPATH=$HADOOP_HOME/etc/hadoop

export HBASE_PID_DIR=/root/hbase/pids

export HBASE_MANAGES_ZK=false

export HBASE_LOG_DIR=${HBASE_HOME}/logs

6、修改配置文件hbase-site.xml,配置如下:

<?xml version="1.0"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<!--

/**

*

* Licensed to the Apache Software Foundation (ASF) under one

* or more contributor license agreements. See the NOTICE file

* distributed with this work for additional information

* regarding copyright ownership. The ASF licenses this file

* to you under the Apache License, Version 2.0 (the

* "License"); you may not use this file except in compliance

* with the License. You may obtain a copy of the License at

*

* http://www.apache.org/licenses/LICENSE-2.0

*

* Unless required by applicable law or agreed to in writing, software

* distributed under the License is distributed on an "AS IS" BASIS,

* WITHOUT WARRANTIES OR CONDITIONS OF ANY KIND, either express or implied.

* See the License for the specific language governing permissions and

* limitations under the License.

*/

-->

<configuration>

<property>

<name>hbase.rootdir</name>

<value>hdfs://hadoop-test/hbase</value>

<description>The directory shared byregion servers.</description>

</property>

<!--port of hbase-->

<property>

<name>hbase.zookeeper.property.clientPort</name>

<value></value>

</property>

<!--timeout time-->

<property>

<name>zookeeper.session.timeout</name>

<value></value>

</property>

<!--pretend errors caused by time don't synchronize in servers-->

<property>

<name>hbase.master.maxclockskew</name>

<value></value>

</property>

<!--cluser host-->

<property>

<name>hbase.zookeeper.quorum</name>

<value>master1,master2,slave1,slave2,slave3</value>

</property>

<!--path of tmp-->

<property>

<name>hbase.tmp.dir</name>

<value>/opt/hbase_tmp/tmp</value>

</property>

<!-- true means of distributed-->

<property>

<name>hbase.cluster.distributed</name>

<value>true</value>

</property>

<!--master-->

<property>

<name>hbase.master</name>

<value></value>

</property>

<property>

<name>hbase.zookeeper.property.dataDir</name>

<value>/opt/workspace/zookeeper/data</value>

</property>

<property>

<name>hbase.regionserver.restart.on.zk.expire</name>

<value>true</value>

</property>

<property>

<name>hbase.master.info.port</name>

<value></value>

</property>

<property>

<name>dfs.support.append</name>

<value>true</value>

</property>

</configuration>

其中hbase.rootdir配置的是hdfs地,用来持久化Hbase,ip:port要和hadoop/core-site.xml中的fs.defaultFS保持一致。hbase.cluster.distributed :Hbase的运行模式。false是单机模式,true是分布式模式

7、修改regionservers,指定hbase的主从

slave1

slave2

slave3

8、将该环境配置发送到其余4台服务器

9、启动hbase集群

[root@master1 hbase-1.4.]# cd bin

[root@master1 bin]# start-hbase.sh

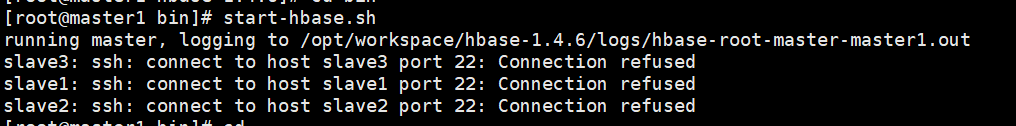

报错如下:

解决:

在hbase-env.sh文件中添加

export HBASE_SSH_OPTS="-p 61333"

重新启动,成功。

[root@master1 hbase-1.4.]# cd bin

[root@master1 bin]# start-hbase.sh

master1节点进程如下:

slave1、slave2、slave3节点进程如下:

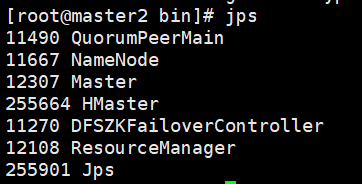

10、启动备用节点的HMaster

[root@master2 hbase-1.4.]# cd bin

[root@master2 bin]# hbase-daemon.sh start master

启动成功,进程如下:

大数据-HBase HA集群搭建的更多相关文章

- 大数据-hadoop HA集群搭建

一.安装hadoop.HA及配置journalnode 实现namenode HA 实现resourcemanager HA namenode节点之间通过journalnode同步元数据 首先下载需要 ...

- 大数据-spark HA集群搭建

一.安装scala 我们安装的是scala-2.11.8 5台机器全部安装 下载需要的安装包,放到特定的目录下/opt/workspace/并进行解压 1.解压缩 [root@master1 ~]# ...

- 大数据学习——HADOOP集群搭建

4.1 HADOOP集群搭建 4.1.1集群简介 HADOOP集群具体来说包含两个集群:HDFS集群和YARN集群,两者逻辑上分离,但物理上常在一起 HDFS集群: 负责海量数据的存储,集群中的角色主 ...

- 大数据中Hadoop集群搭建与配置

前提环境是之前搭建的4台Linux虚拟机,详情参见 Linux集群搭建 该环境对应4台服务器,192.168.1.60.61.62.63,其中60为主机,其余为从机 软件版本选择: Java:JDK1 ...

- 大数据平台Hadoop集群搭建

一.概念 Hadoop是由java语言编写的,在分布式服务器集群上存储海量数据并运行分布式分析应用的开源框架,其核心部件是HDFS与MapReduce.HDFS是一个分布式文件系统,类似mogilef ...

- 大数据:spark集群搭建

创建spark用户组,组ID1000 groupadd -g 1000 spark 在spark用户组下创建用户ID 2000的spark用户 获取视频中文档资料及完整视频的伙伴请加QQ群:9479 ...

- 大数据学习——Storm集群搭建

安装storm之前要安装zookeeper 一.安装storm步骤 1.下载安装包 2.解压安装包 .tar.gz storm 3.修改配置文件 mv /root/apps/storm/conf/st ...

- 大数据中Linux集群搭建与配置

因测试需要,一共安装4台linux系统,在windows上用vm搭建. 对应4个IP为192.168.1.60.61.62.63,这里记录其中一台的搭建过程,其余的可以直接复制虚拟机,并修改相关配置即 ...

- 大数据学习——hadoop集群搭建2.X

1.准备Linux环境 1.0先将虚拟机的网络模式选为NAT 1.1修改主机名 vi /etc/sysconfig/network NETWORKING=yes HOSTNAME=itcast ### ...

随机推荐

- 浅析JavaScript访问对象属性和方法及区别

属性是一个变量,用来表示一个对象的特征,如颜色.大小.重量等:方法是一个函数,用来表示对象的操作,如奔跑.呼吸.跳跃等. 在JavaScript中通常使用”."运算符来存取对象的属性的值.或 ...

- IntelliJ IDEA 2017版开发SpringBoot之fastJsonHttpMessageConvert使用

继承WebMvcConfigurerAdapter,改写成自己的json转换工具的写法 1.建立实体类 package com.fastjson; import com.alibaba.fastjso ...

- metasploitable实践

使用Fimap和metasploitable2文件包含漏洞测试 fimap 首先查看msf已经存在的漏洞: root@kali:~# fimap -u 'http://192.168.136.130/ ...

- Linux 基础教程 28-nc命令

nc nc命名netcat,直译为网络猫.在CentOS 7查看帮助的解释如下所示: ncat - Concatenate and redirect sockets 翻译过来就是可以连接和重定 ...

- ZOJ3770Ranking System 2017-04-14 12:42 52人阅读 评论(0) 收藏

Ranking System Time Limit: 2 Seconds Memory Limit: 65536 KB Few weeks ago, a famous software co ...

- java并发编程实战:第二章----线程安全性

一个对象是否需要是线程安全的取决于它是否被多个线程访问. 当多个线程访问同一个可变状态量时如果没有使用正确的同步规则,就有可能出错.解决办法: 不在线程之间共享该变量 将状态变量修改为不可变的 在访问 ...

- Java动态代理(三)——模拟AOP实现

以下案例模拟AOP实现 目录结构 接口PersonService package com.ljq.service; public interface PersonService { public vo ...

- ------------------java collection 集合学习 ----小白学习笔记,,有错,请指出谢谢

<!doctype html>java对象集合学习记录 figure:first-child { margin-top: -20px; } #write ol, #write ul { p ...

- Selenium WebDriver之JavaScript

WebDriver提供了方法来同步/异步执行JavaScript代码,这是因为JavaScript可以完成一些WebDriver本身所不能完成的功能,从而让WebDriver更加灵活和强大. 本文中所 ...

- Axure8.0入门级基础操作到高手产品经理

宅男下载了一个Axure8.0.从来没有用过,那就从最基础的了解一下呗. 1.添加元件,选择元件设置样式(右侧对话框中)略!!!!! 2.按住ctrl键,用鼠标点选元件,可以任意旋转3.点元件上的黑圆 ...