Python爬虫常用库安装

建议更换pip源到国内镜像,下载会快很多:https://www.cnblogs.com/believepd/p/10499844.html

requests

pip3 install requests

selenium

pip3 install selenium

安装好后,测试一下:

from selenium import webdriver

driver = webdriver.Chrome()

执行后报错了:

需要安装chromedriver才能完成chrome浏览器的驱动。

可以从这里下载适合自己的chromedriver(需要对应自己的chrome版本!!!):https://npm.taobao.org/mirrors/chromedriver

比如我的是windows,解压后将chromedriver.exe放到某个配置好环境变量的目录下。

运行:

from selenium import webdriver

driver = webdriver.Chrome()

driver.get("https://www.baidu.com")

print(driver.page_source)

可以看到,自动打开百度并获取到了源代码。

但是,在做爬虫的时候,一直打开浏览器是不方便的,这时就需要一个没有界面的"浏览器"----phantomjs。

下载phantomjs:http://phantomjs.org/download.html

解压后,将bin目录配置到环境变量中。

from selenium import webdriver

driver = webdriver.PhantomJS(executable_path=r"D:\phantomjs-2.1.1-windows\bin\phantomjs.exe")

driver.get("https://www.baidu.com")

print(driver.page_source)

lxml

pip3 install lxml

beautifulsoup

pip3 install beautifulsoup4

from bs4 import BeautifulSoup

soup = BeautifulSoup("<html></html>", "lxml")

pyquery

pip3 install pyquery

from pyquery import PyQuery as pq

doc = pq("<html>hello!</html>")

result = doc("html").text()

print(result) # hello!

pymongo

pip3 install pymongo

import pymongo

client = pymongo.MongoClient("localhost")

db = client["test_db"]

db["table"].insert({"name": "pd"})

result = db["table"].find_one({"name": "pd"})

print(result)

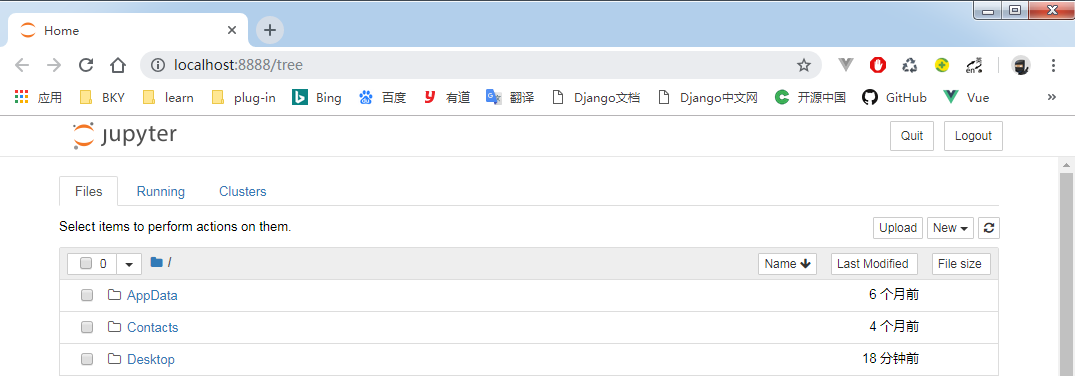

jupyter

pip3 install jupyter

相当于一个记事本,它是运行在网页端的。

在cmd中输入:jupyter notebook,就会自动打开浏览器。点击new python3,即可在网页上运行代码。

Python爬虫常用库安装的更多相关文章

- 爬虫-Python爬虫常用库

一.常用库 1.requests 做请求的时候用到. requests.get("url") 2.selenium 自动化会用到. 3.lxml 4.beautifulsoup 5 ...

- python爬虫常用库和安装 -- windows7环境

1:urllib python自带 2:re python自带 3:requests pip install requests 4:selenium 需要依赖chrome ...

- Python爬虫常用模块安装

安装:pip3 install requestspip3 install seleniumpip3 install bs4pip3 install pyquerypip3 install pymysq ...

- Python 爬虫常用库(九)

- python常用库安装网址

python常用库安装网址如下: http://pypi.python.org/pypi

- Python爬虫—requests库get和post方法使用

目录 Python爬虫-requests库get和post方法使用 1. 安装requests库 2.requests.get()方法使用 3.requests.post()方法使用-构造formda ...

- python爬虫---selenium库的用法

python爬虫---selenium库的用法 selenium是一个自动化测试工具,支持Firefox,Chrome等众多浏览器 在爬虫中的应用主要是用来解决JS渲染的问题. 1.使用前需要安装这个 ...

- Python爬虫Urllib库的高级用法

Python爬虫Urllib库的高级用法 设置Headers 有些网站不会同意程序直接用上面的方式进行访问,如果识别有问题,那么站点根本不会响应,所以为了完全模拟浏览器的工作,我们需要设置一些Head ...

- Python爬虫Urllib库的基本使用

Python爬虫Urllib库的基本使用 深入理解urllib.urllib2及requests 请访问: http://www.mamicode.com/info-detail-1224080.h ...

随机推荐

- 【转载】limits.h

limits.h专门用于检测整型数据数据类型的表达值范围. <limits.h>主要提供对整型和字符型范围的限制的宏,同样没有指定类型和函数的定义. 1.整型宏如下表: 2.字符型宏如下表 ...

- 【HAOI 2007】 理想的正方形

[题目链接] 点击打开链接 [算法] 单调队列 [代码] #include<bits/stdc++.h> using namespace std; #define MAXN 1010 co ...

- python 使用.bat文件自动执行

@echo off title demo cmd "/c activate py36 && cd demo&& python demo_test.py&quo ...

- MyBatis基本应用

框架的概念: 框架(Framework)是一个提供了可重用的公共结构的半成品. 数据持久化: 数据持久化是将内存中的数据模型转换为存储模型,以及将存储模型转换为内存中的数据模型的统称. ORM(Obj ...

- E20170603-ts

sanitize vt. 净化; 进行消毒; 使清洁; 审查; omission n. 遗漏; 疏忽; 省略,删节; [法] 不履行法律责任; separator n. 分离器,分离装置; 防胀 ...

- view 的继承关系

view 的继承关系 如果一个view 有多个子view. 甚至是多成次的 子view. 只需要把第一级别的view(父view) 授权给用户,就可以访问view了,子view 不需要授权.

- MySql数据查询中 left join 条件位置区别

/*A 和 B 两张表都只有一个 ID 字段 比如A表的数据为 ID 1,2,3,4,5,6 B表的数据为 ID 1,2,3 判断 JOIN 查询时候条件在 ON 和 WHERE 时的区别 ON 和 ...

- SQL数据库--数据访问

数据访问: 对应命名空间:System.Data.SqlClient; SqlConnection:连接对象 SqlCommand:命令对象 SqlDataReader:读取器对象 //造连接字符串 ...

- c# 线程浅析(代理 、Invoke、Lock)

前言:本来想根据自己的经验总结一下c#线程相关的知识点, 写之前看了一些其他人的博客,发现自己也就掌握了不到三分之一....希望通过这次的博客将自己的知识点补充一下,写出更直白的博客和初学者分享. 这 ...

- 不讲CRUSH的Ceph教程是不完整的

前面我们提到了Ceph是一个支持统一存储架构的分布式存储服务.简单介绍了Ceph的基本概念和基础架构包含的组件,其中最重要的就是底层的RADOS和它的两类守护进程OSD and Monitor.上篇文 ...