模型压缩-Learning Efficient Convolutional Networks through Network Slimming

Zhuang Liu主页:https://liuzhuang13.github.io/

Learning Efficient Convolutional Networks through Network Slimming: https://arxiv.org/pdf/1708.06519.pdf

后续出了:Rethinking the Value of Network Pruning (Pytorch) (ICLR 2019),https://github.com/Eric-mingjie/rethinking-network-pruning/

转载:https://zhuanlan.zhihu.com/p/39761855 https://blog.csdn.net/u011995719/article/details/78788336

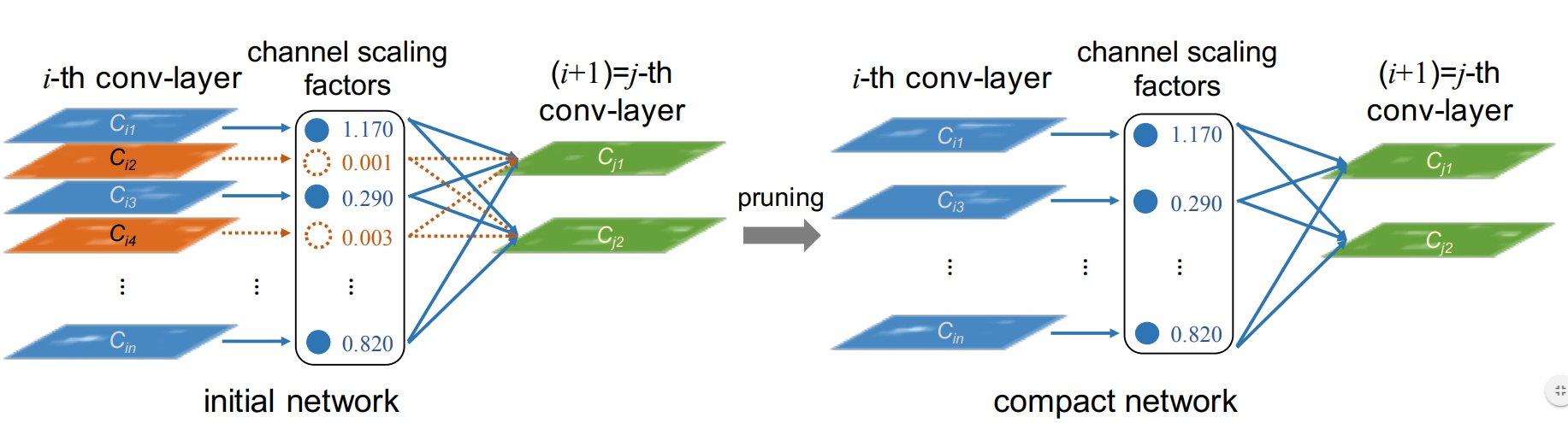

核心思想(利用BN放缩因子来修剪Channel)

将预训练好的网络删减掉一些Channel(再fine-tuning),让模型参数减少的同时,还能让准确率维持不变(或精度损失很少)。

那问题来了:

- 1)那它是以什么准则来删减Channel?

- 2)总体训练步骤是什么?

- 3)效果如何?优缺点是?

- 4)类似相关工作有哪些?

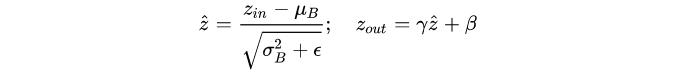

论文方法从BN中得到启发。我们回顾下BN:其中 表示mini-batch B中某feature map的均值,scale

和 shift

都是通过反向传播训练更新。

这么看来,可以直接用 来评估channel的重要程度。

的数越小,说明该channel的信息越不重要,也就可以删减掉该Channel。虽然可以通过删减

值接近零的channel,但是一般情况下,

值靠近0的channel还是属于少数。于是作者采用smooth-L1 惩罚

,来让

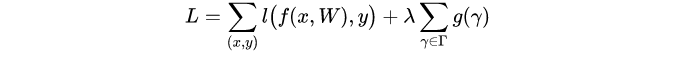

值倾向于0。那么网络的损失函数就可设计为:

其中 是训练的输入和目标,

是可训练的权重,

是引导稀疏的惩罚函数,

作为这两项的调整。 文中选择

,当然也可以采用Smooth_L1方法在零点为光滑曲线。

Tips:

a) 论文中提到Smooth-L1时,引用的是:2007_Fast optimization methods for l1 regularization: A comparative study and two new approaches.

b) 而2015_Fast R-CNN 提出了 Smooth-L1 公式为:

c) 作者源码采用的不是Fast R-CNN提出的SmoothL1. 可以看下 论文提供的源码. https://github.com/Eric-mingjie/rethinking-network-pruning/

接下来我们看看训练过程(非常简明的步骤):

- 第一步:初始化网络;

- 第二步:加入Channel稀疏惩罚项,训练网络;

- 第三步:通过固定阈值来删减channel,如删减70%的channel;

- 第四步:Fine-tune。由于删减channel后精度会下降,故再训练去微调网络;

- 第五步:可以再跳到第二步,实现多次精简网络;

- 第六步:得到精简后的网络。

具体操作细节:

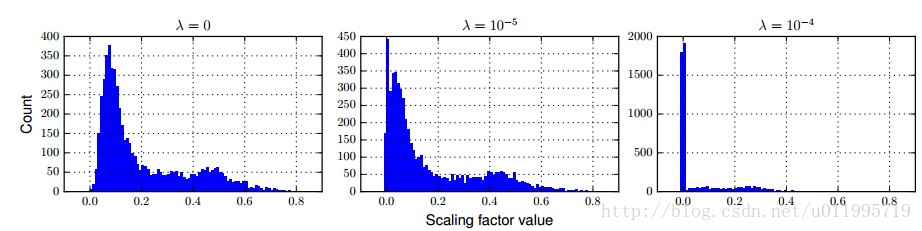

γ通常取 1e-4或者1e-5,具体情况具体分析,

γ得出后,应该怎么剪,γ多小才算小? 这里采用与类似PCA里的能量占比差不多,将当前层的γ全都加起来,然后按从大到小的顺序排列,选取较大的那一部分,通常选取70%左右(具体情况具体分析)。

λ的选取对γ的影响如图所示:

λ为0的时候,目标函数不会对γ进行惩罚,λ等于1e-5时,可以发现,γ=0.0+的有450多个,整体都向0靠近。当λ=1e-4时,对γ有了更大的稀疏约束了,可以看到有接近2000个γ是在0.0x附近。

剪枝百分比: 剪得越多,模型越小;剪得太多,精度损失。这是矛盾的,所以作者做了实验对比,看看剪多少合适。实验发现,当剪枝超过80%,精度会下降。

具体实验请阅读原文,其中涉及了vgg,resnet-164(pre-actionvation),densenet-40。效果都很好,不仅压缩模型大小,提升运算速度,还能提升分类准确率。

对剪枝的程度没有先验知识的指导。论文是把所有通道的γ 值做了排序,选择砍掉一定比例的γ,但是这个比例会因为具体的模型、具体的任务而变化很大。在我的项目中,剪枝3轮,每轮剪枝20%,对精度无影响;如果每轮剪枝30%,对精度有很大影响。也就是说不能自动的将模型压缩到最紧凑,二是靠“试”。

本人已经基于此方法在MobileNetV2-ssdlite上验证成功,精度不减的情况下,模型压缩50%左右,速度能够提升近1倍,代码即将开源。

模型压缩-Learning Efficient Convolutional Networks through Network Slimming的更多相关文章

- [论文理解] Learning Efficient Convolutional Networks through Network Slimming

Learning Efficient Convolutional Networks through Network Slimming 简介 这是我看的第一篇模型压缩方面的论文,应该也算比较出名的一篇吧 ...

- 论文翻译:2020_WaveCRN: An efficient convolutional recurrent neural network for end-to-end speech enhancement

论文地址:用于端到端语音增强的卷积递归神经网络 论文代码:https://github.com/aleXiehta/WaveCRN 引用格式:Hsieh T A, Wang H M, Lu X, et ...

- 【论文翻译】MobileNets: Efficient Convolutional Neural Networks for Mobile Vision Applications

MobileNets: Efficient Convolutional Neural Networks for Mobile Vision Applications 论文链接:https://arxi ...

- [论文理解] MobileNets: Efficient Convolutional Neural Networks for Mobile Vision Applications

MobileNets: Efficient Convolutional Neural Networks for Mobile Vision Applications Intro MobileNet 我 ...

- 深度学习论文翻译解析(十七):MobileNets: Efficient Convolutional Neural Networks for Mobile Vision Applications

论文标题:MobileNets: Efficient Convolutional Neural Networks for Mobile Vision Applications 论文作者:Andrew ...

- 论文笔记之:Learning Multi-Domain Convolutional Neural Networks for Visual Tracking

Learning Multi-Domain Convolutional Neural Networks for Visual Tracking CVPR 2016 本文提出了一种新的CNN 框架来处理 ...

- [论文阅读] MobileNets: Efficient Convolutional Neural Networks for Mobile Vision Applications (MobileNet)

论文地址:MobileNets: Efficient Convolutional Neural Networks for Mobile Vision Applications 本文提出的模型叫Mobi ...

- 论文笔记——MobileNets(Efficient Convolutional Neural Networks for Mobile Vision Applications)

论文地址:MobileNets: Efficient Convolutional Neural Networks for Mobile Vision Applications MobileNet由Go ...

- 深度学习论文翻译解析(六):MobileNets:Efficient Convolutional Neural Networks for Mobile Vision Appliications

论文标题:MobileNets:Efficient Convolutional Neural Networks for Mobile Vision Appliications 论文作者:Andrew ...

随机推荐

- 11_Redis_事务

一:Redis 事务:目的为了进行Redis语句的批量化操作,不保证数据安全 Redis作为NoSQL数据库也同样提供了事务机制:在Redis中,MULTI/EXEC/DISCARD/这三个命令是我们 ...

- Comparator分组测试

import java.util.ArrayList; import java.util.Collection; import java.util.Collections; import java.u ...

- set调用add报错:

Map<String, String> goodsStandMap = new HashMap<>();goodsStandMap.put("key1", ...

- C语言Ⅰ|博客作业07

这个作业属于哪个课程 C语言程序设计Ⅰ 这个作业要求在哪里 https://www.cnblogs.com/tongyingjun/p/11809219.html 我在这个课程的目标是 熟练掌握swi ...

- asyncio模块实现线程的嵌套和穿插

import asyncio import time now = lambda :time.time() async def cpc_1(x): print('正在烙比萨饼,预计{}分钟'.forma ...

- codeforces#1148E. Earth Wind and Fire(贪心)

题目链接: http://codeforces.com/contest/1148/problem/E 题意: 给出两个长度为$n$的序列,将第一个序列变成第二个序列,顺序不重要,只需要元素完全相同即可 ...

- Hadoop配置多个HDFS入口

为了验证存在不同的hdfs之间的hive的互操作(归根结底还是为了解决BUG) 需要在两个不同的hadoop集群的HDFS 能够在Hiveserver2上进行路由转发绕过一些坑. 就需要将某hdfs ...

- Linux设备驱动程序 之 顺序锁

当要保护的资源很小,很简单,会频繁的被访问而且写入访问很少的且必须快速时(即读不允许让写饥饿),就可以使用顺序锁(seqlock):从本质上讲,顺序锁会允许读取者对资源的自由访问,但需要读取者检查是否 ...

- Linux设备驱动程序 之 并发及其管理

竞态产生 Linux系统找那个存在大量的并发联系,因此会导致可能的竞态: 1. 正在运行的用户空间进程可以以多种组合方式访问我们的代码: 2. SMP系统甚至可以再不同的处理器上同时执行我们的代码: ...

- 什么叫Closed-form闭式解

转自百度知道 与数值解对应的是解析解 闭式解closed form solution)也叫解析解(analytical solution),就是一些严格的公式,给出任意的自变量就可以求出其因变量,也就 ...