Scrapy 中的模拟登陆

目前,大部分网站都具有用户登陆功能,其中某些网站只有在用户登陆后才能获得有价值的信息,在爬取这类网站时,Scrapy 爬虫程序先模拟登陆,再爬取内容

1、登陆实质

其核心是想服务器发送含有登陆表单数据的 HTTP 请求(通常是POST)

2、使用 FormRequest

Scrapy 提供了一个FormRequest(Request 的子类),专门用于含有表单数据的请求,FormRequest 的构造方法有一个 formdata 参数,接收字典形式的表单数据。

有两方法可以构造 FormRequest 对象

(1)直接构造

<1> 先提取 3 个隐藏在<inout>中包含的信息

<2> 构造表单数据

<3> 填写账号和密码信息

(2)简单方式

即调用 FormRequest 的 form_response 方法,调用时传入一个 Response 对象作为第一个参数,该方法会解析 Response 对象所包含页面中的<from>元素,帮助用户创建FormRequest 对象,并将隐藏<input> 中的信息自动填入表单数据,使用这种方法,我们只需要通过 formdata 参数填写账号和密码即可:

>>> fd = {'email': 'junchuanzhang@webscraping.com', 'password': }

>>> request = FromRequest.from_response(response, fromdata = fd)

3、实现登陆的 Spide

import scrap

from http.http import Request , FormRequest

class LoginSpider(scrapy.Spider):

name = 'login'

allowed_domains = ['example.webscraping.com']

start_urls = ['http:?/example.websrcaping.com/user/login'] def parse(self, response):

# 解析登陆后下载的页面,此例中是用户个人信息

keys = response.css('table lable::text').re('*').extractor()

values = response.css(''table td.w2p_fw::text).extractor()

yield dict(zip(keys, values)) # --------------------登陆-------------------

#登陆页面的url

login_url = 'http://example.websracping.com/user/login' def start_requests(self):

yield Request(self.login_url, callback=self.login) def login(self, response):

# 登陆页面的解析函数,构造FormRequest 对象提交表单

fd = {'email': 'junchuanzhang@webscraping.com', 'password': 123456}

request = FromRequest.from_response(response, fromdata = fd, callback=self.parse_login)

def parse_login(self, response):

# 登陆成功后, 继续爬取 start_url 中的页面

if 'Welcome Liu' in response.text:

yield from super().start_requests()

解析上述代码如下:

(1)覆盖基类的 start_requests 方法,最先请求登录页面

(2)login 方法为登录页面的解析函数,在该方法中进行模拟登录,构造表单请求并提交。

(3)parse_login 方法为表单请求的响应处理函数,在该方法中通过在页面查找特殊字符串“Welcome Liu” 判断是否登录成功

如果成功,调用基类的 start_requests 方法,继续爬取 start_urls 中的页面。

这样设计 LoginSpider 就是想把模拟登录和爬取内容的代码分离开,使得逻辑上更加清晰。

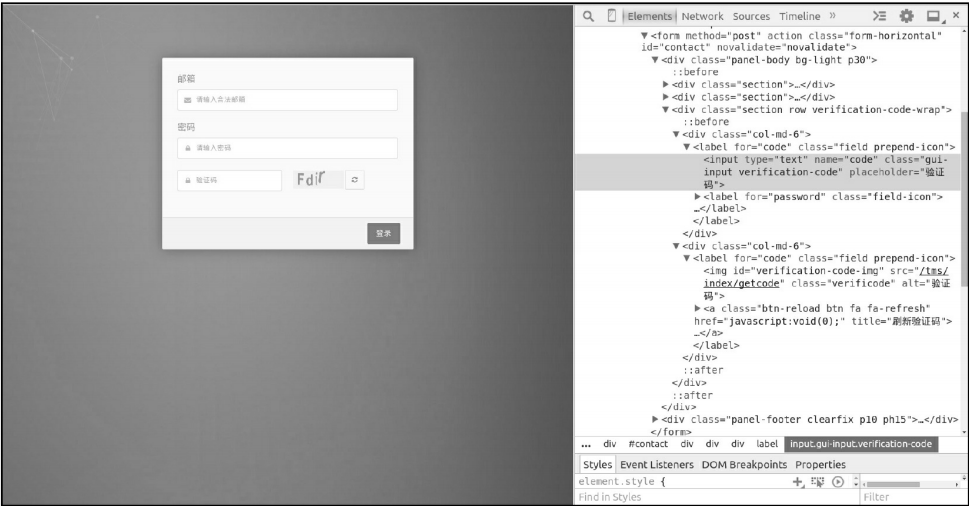

4、识别验证码

目前,很多网站为了防止爬虫爬取,登录是需要用户输入验证码

下面我们学习如何在爬虫程序中识别验证码(在举例过程中不知名具体网站)

页面中的图片对应一个 <img> 元素,即一张图片,浏览器加载完登录页面后,会携带之前访问获取的Cookie信息,继续发送一个HTTP请求加载验证码图片,

和账号密码输入框一样,验证码输入框也对应一个<input>元素,因此用户输入的验证码会成为表单数据的一部分,表单提交后有网站服务器程序验证,

识别验证码有多种方式,下面解说常用的几种。

(1) OCR识别

(2)网络识别平台

(3)人工识别

5、Cookie 登录

目前网站的验证码越来越复杂,某些验证码已经复杂到人类那一识别的程度,有些时候提交表单的路子那一走通,此时,我们可以换一种登录爬取的思路,在使用浏览器登录网站后,包含用户身份的信息的Cookie会被浏览器保存在本地,如果 Scrapy 爬虫能直接使用浏览器中的 Cookie 发送 HTTP 请求,就可以绕过提交表单登录的步骤。

1、获取浏览器 Cookie

我们无需费心钻研,各种浏览器将 Cookie 以哪种形式存储在哪里,使用第三方 Python 库 browercookie 便可以获取 Chrome 和 Firefox浏览器中的 Cookie

使用 pip 安装 browercookie :

pip install browsercookie

browsercookie 的使用非常简单,实例代码如下:

>>> import browsercookie

>>>chrome_cookiejar = browsercookie.chrome()

>>>fire_cookiejar = browsercookie.firefox()

>>>type(chrome_cookiejar)

<class 'http.cookiejar.CookieJar'>

browsercookie的Chrome和Firefox方法分别返回 Chrome 和 Firefox 浏览器中的 Cookie,返回值是一个http.cookiejar.Cookiejar对象,对 cookiejar 对象进行迭代,可以访问其中的Cookie对象。

总结一下

1、如何使用 FormRequest 提交登陆表单的模拟登录

2、讲解识别验证码的 3 中方式

3、如何使用浏览器 Cookie 直接登录

Scrapy 中的模拟登陆的更多相关文章

- python之scrapy携带Cookies模拟登陆

知识点 """ scrapy两种模拟登陆: 1.直接携带cookie 2.找到发送post请求的url地址,带上信息,发送请求 应用场景: 1.cookie过期时间很长, ...

- Scrapy 模拟登陆知乎--抓取热点话题

工具准备 在开始之前,请确保 scrpay 正确安装,手头有一款简洁而强大的浏览器, 若是你有使用 postman 那就更好了. Python 1 scrapy genspid ...

- scrapy爬取某网站,模拟登陆过程中遇到的那些坑

本节内容 在访问网站的时候,我们经常遇到有些页面必须用户登录才能访问.这个时候我们之前写的傻傻的爬虫就被ban在门外了.所以本节,我们给爬虫配置cookie,使得爬虫能保持用户已登录的状态,达到获得那 ...

- Scrapy中使用cookie免于验证登录和模拟登录

Scrapy中使用cookie免于验证登录和模拟登录 引言 python爬虫我认为最困难的问题一个是ip代理,另外一个就是模拟登录了,更操蛋的就是模拟登录了之后还有验证码,真的是不让人省心,不过既然有 ...

- Scrapy基础(十四)————Scrapy实现知乎模拟登陆

模拟登陆大体思路见此博文,本篇文章只是将登陆在scrapy中实现而已 之前介绍过通过requests的session 会话模拟登陆:必须是session,涉及到验证码和xsrf的写入cookie验证的 ...

- scrapy的一些容易忽视的点(模拟登陆,传递item等)

scrapy爬虫注意事项 一.item数据只有最后一条 这种情况一般存在于对标签进行遍历时,将item对象放置在了for循环的外部.解决方式:将item放置在for循环里面. 二.item字段传递 ...

- 第三百四十三节,Python分布式爬虫打造搜索引擎Scrapy精讲—scrapy模拟登陆和知乎倒立文字验证码识别

第三百四十三节,Python分布式爬虫打造搜索引擎Scrapy精讲—scrapy模拟登陆和知乎倒立文字验证码识别 第一步.首先下载,大神者也的倒立文字验证码识别程序 下载地址:https://gith ...

- 爬虫入门之scrapy模拟登陆(十四)

注意:模拟登陆时,必须保证settings.py里的COOKIES_ENABLED(Cookies中间件) 处于开启状态 COOKIES_ENABLED = True或# COOKIES_ENABLE ...

- Scrapy模拟登陆豆瓣抓取数据

scrapy startproject douban 其中douban是我们的项目名称 2创建爬虫文件 进入到douban 然后创建爬虫文件 scrapy genspider dou douban. ...

随机推荐

- placeholder样式

.mdwh_txtmod_tp_inpshad input::-webkit-input-placeholder { /* WebKit browsers */ color: #cccccc; } . ...

- C语言:将字符串中的前导*号全部移到字符串的尾部。

//规定输入的字符串中只包含字母和*号,fun函数:将字符串中的前导*号全部移到字符串的尾部. #include <stdio.h> void fun( char *a ) { ]; ch ...

- 应用 AddressSanitizer 发现程序内存错误

作为 C/ C++ 工程师,在开发过程中会遇到各类问题,最常见便是内存使用问题,比如,越界,泄漏.过去常用的工具是 Valgrind,但使用 Valgrind 最大问题是它会极大地降低程序运行的速度, ...

- 最长公共子序列-Hdu1159

Common Subsequence Time Limit: 2000/1000 MS (Java/Others) Memory Limit: 65536/32768 K (Java/Other ...

- java.lang.ClassNotFoundException: javax.xml.bind.DatatypeConverter 可能是我们运行的java版本过高导致

最近给自己写了个 SpringBoot 应用程序 顺便练练手,准备把程序过到 树莓派 上,结果登陆报错

- VBA 学习笔记 - 消息框

学习资料:https://www.yiibai.com/vba/vba_macro_comments.html 注释 单引号或 REM 开头 丸子:多行注释咋办? 消息框(MsgBox) 函数功能:显 ...

- laravel npm安装yarn

npm install -g yarn yarn install --no-bin-links yarn add cross-env npm run dev Laravel 默认集成了一些 NPM 扩 ...

- day46_Webservice学习笔记_02

一.回顾昨天所学 什么是webservice? 什么是远程调用技术?答:系统和系统之间的调用,从远程系统当中获取业务数据. Webservice是web服务,他是用http传输SOAP协议 ...

- SpringBoot与Mybatis整合(包含generate自动生成代码工具,数据库表一对一,一对多,关联关系中间表的查询)

链接:https://blog.csdn.net/YonJarLuo/article/details/81187239 自动生成工具只是生成很单纯的表,复杂的一对多,多对多的情况则是在建表的时候就建立 ...

- mqtt开源服务器 EMQX ,客户端MQTTX5.0,使用指南

服务器 EMQX 官网: https://docs.emqx.io/broker/v3/cn/getstarted.html#mqtt-clients 一.安装启动 # 各平台下载https://ww ...