Spark- 使用第三方依赖解析IP地址

使用 github上已有的开源项目

1)git clone https://github.com/wzhe06/ipdatabase.git

2)编译下载的项目: mvn clean package- DskipTests

3)安装jar包到自己的 maven仓库

mvn install: install-file -Dfile=${编译的jar包路径}/target/ipdatabase-1.0-SNAPSHOT jar -DgroupId=com.ggstar -DartifactId=ipdatabase -Dversion=1.0 -Dpackaging=jar

4)添加依赖到pom

<dependency>

<groupId>com.ggstar<groupId>

<artifactId>ipdatabase</artifactId>

<version>1.0</version>

</dependency>

<dependency>

<groupId>org.apache.poi</groupId>

<cartifactId>poi-ooxml</artifactId>

<version>3.14</version>

</dependency>

<dependency>

<groupId>org.apache.poi</groupId>

<cartifactId>poi</artifactId>

<version>3.14</version>

</dependency>

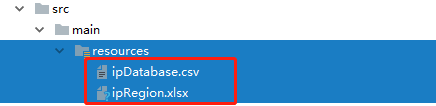

5)将源码main/resource下的ipDatabase.csv和ipRegion.xlxs拷贝到当前项目的resource目录下

6)ip解析工具类

/**

* IP解析工具类

*/

object IpUtils { def getCity(ip:String): Unit ={

IpHepler.findRegionByIp(ip)

}

}

7)打包到yarn运行

在pom文件排除spark打包,因为环境上有。

<!--scala 依赖-->

<dependency>

<groupId>org.scala-lang</groupId>

<artifactId>scala-library</artifactId>

<version>${scala.version}</version>

<scope>provided</scope>

</dependency>

<!--SparkSQL-->

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-sql_2.11</artifactId>

<version>${spark.version}</version>

<scope>provided</scope>

</dependency> <dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-hive_2.11</artifactId>

<version>${spark.version}</version>

<scope>provided</scope>

</dependency>

打包时注意,pom.xml中需要添加如下plugin

<plugin>

<artifactId>maven-assembly-plugin</artifactId>

<configuration>

<archive>

<mainfest>

<mainClass></mainClass>

</mainfest>

</archive>

<descriptRefs>

<descriptRef>

jar-with-dependencies

</descriptRef>

</descriptRefs>

</configuration>

</plugin>

<plugin>

提交运行

/bin/spark-submit

class com.rz.log.SparkstatcleanJobYARN

--name SparkstatcleanJobYARN

--master yarn

--executor-memory 1G

--num-executors 1\

--files /home/hadoop/Lib/ipDatabase. CSV, /home/hadoop/lib/ipRegion XlSx \

/home/hadoop/lib/sql-1.0-jar-with-dependencies.jar \

hdfs://hadoop001:8020/imooc/input/* hdfs://hadoop001: 8020/imooc/clean

Spark- 使用第三方依赖解析IP地址的更多相关文章

- 关于域名系统DNS解析IP地址的一些总结

关于域名系统DNS(Domain Name System) 从域名中解析出IP地址. DNS主要由3部分组成: ① 名称解析器(resolver) ② 域名空间(domain name space) ...

- JavaMail SMTP服务器发送邮件程序示例 java通过dns服务器解析ip地址

/** * JavaMail SMTP服务器发送邮件程序示例 * 扮演SMTP服务器角色与邮件客户端软件最大的区别就是: * SMTP服务器需要解析不同接收人邮件地址主机名对应的SMTP服务器主机名 ...

- 通过阿里云域名动态解析 IP 地址

这两天在家里用树莓派折腾了一个家用服务器,主要用来做 mac 的 Time Machine ,还有就是当做下载机和 nas ,想着平时上班时间家里没人用网络,空着也是空着,就可以利用空闲带宽下个美剧啥 ...

- 使用python解析ip地址

前言 想要批量将ip地址转换为省份城市.国家或是经纬度?百度上的批量查找每次的容量太小满足不了要求?第三方库神器 - geoip2帮你解决所有烦恼. 准备工作 首先安装一下geoip2库, pip i ...

- 嵌入式开发之函数解析---ip地址2进制转字符inet_ntoa 调用中只生效一次

inet_addr() 简述:将一个点间隔地址转换成一个in_addr. #include <winsock.h> unsigned long PASCAL FAR inet_addr ...

- DataLakeAnalytics: 解析IP地址对应的国家城市地址的能力

Data Lake Analytics 作为云上数据处理的枢纽,最近加入了通过IP地址查找对应的国家.省份.城市.ISP的函数, 今天带大家体验一下. 函数详细介绍 本次一共添加了下面这些函数: ip ...

- spark streaming 使用geoIP解析IP

1.首先将GEOIP放到服务器上,如,/opt/db/geo/GeoLite2-City.mmdb 2.新建scala sbt工程,测试是否可以顺利解析 import java.io.Fileimpo ...

- 最新IP地址数据库

2016年12月1日 最新发行版 265051条数据 基于:国内基于省市区以及运营商 国外基于国家 版本:全球旗舰版 国内精华版 国外拓展版 英文版 掩码版 字段:大洲 国家 省份 城市 县区 运营 ...

- PHP 使用 GeoLiteCity 库解析 IP 为地理位置

关于把 IP 地址转换为地理位置可以使用网络上很多的 API,好处就是不用在本地存储一个 IP 数据库,而且一般网络上的 IP 库会自动更新,不利的地方就是太依赖于网络,性能表现也可能会弱些.比如像下 ...

随机推荐

- Hessian接口测试

- 如何看懂ORACLE执行计划

如何看懂Oracle执行计划 一.什么是执行计划 An explain plan is a representation of the access path that is taken when a ...

- Gson 解析多层嵌套JSON数据

http://stackoverflow.com/questions/14139437/java-type-generic-as-argument-for-gson

- 接口测试工具 — jmeter(header与cookie的添加)

1.header的添加 添加HTTP信息头管理器 填写header 2.添加cookie 添加HTTP Cookie管理器 添加cookie值

- Redis资料汇总(转)

原文:Redis资料汇总专题 很多朋友反映,说NoSQLFan上的资料不少,但是要找到自己实用的太难,于是萌生做这样一个专题的想法.通过将不同NoSQL产品从入门到精通的各种资料进行汇总,希望能够让大 ...

- django之单表操作

1.查询方法: <1> all(): 查询所有结果 <2> filter(**kwargs): 它包含了与所给筛选条件相匹配的对象 <3> get(**kwargs ...

- 初级学IP地址

IP地址是我们上网的凭证!通过IP地址的学习.能够对网络拓扑结构有一个简单的认识,以及对网络的传递过程进行初步了解. 传输数据简单认识 网络中传播的数据是以数据包的形式存在的! 当中包括着目的IP地址 ...

- tornado下的跨站请求伪造(防护)

跨站请求伪造(防护) 任何Web应用所面临的一个主要安全漏洞是跨站请求伪造,通常被简写为CSRF或XSRF,发音为"sea surf".这个漏洞利用了浏览器的一个允许恶意攻击者在受 ...

- python2函数

1.函数的定义 函数的定义形式如下: def <name>(arg1,arg2...argN): <statements> 函数的名字必须以字母开头,可以包括下划线.函数的目的 ...

- web前端编码规范

简要介绍 本文通过参考百度腾讯等前端编码规范(链接建文末),得出个人习惯的编码规范.个人编码规范采用在不影响可读性的情况下能省就省,尽量简洁,不需要就直接去掉. 最佳原则不管是个人编码规范还是团队编码 ...