Hadoop学习之路(4)Intelij+Maven搭建Hadoop项目

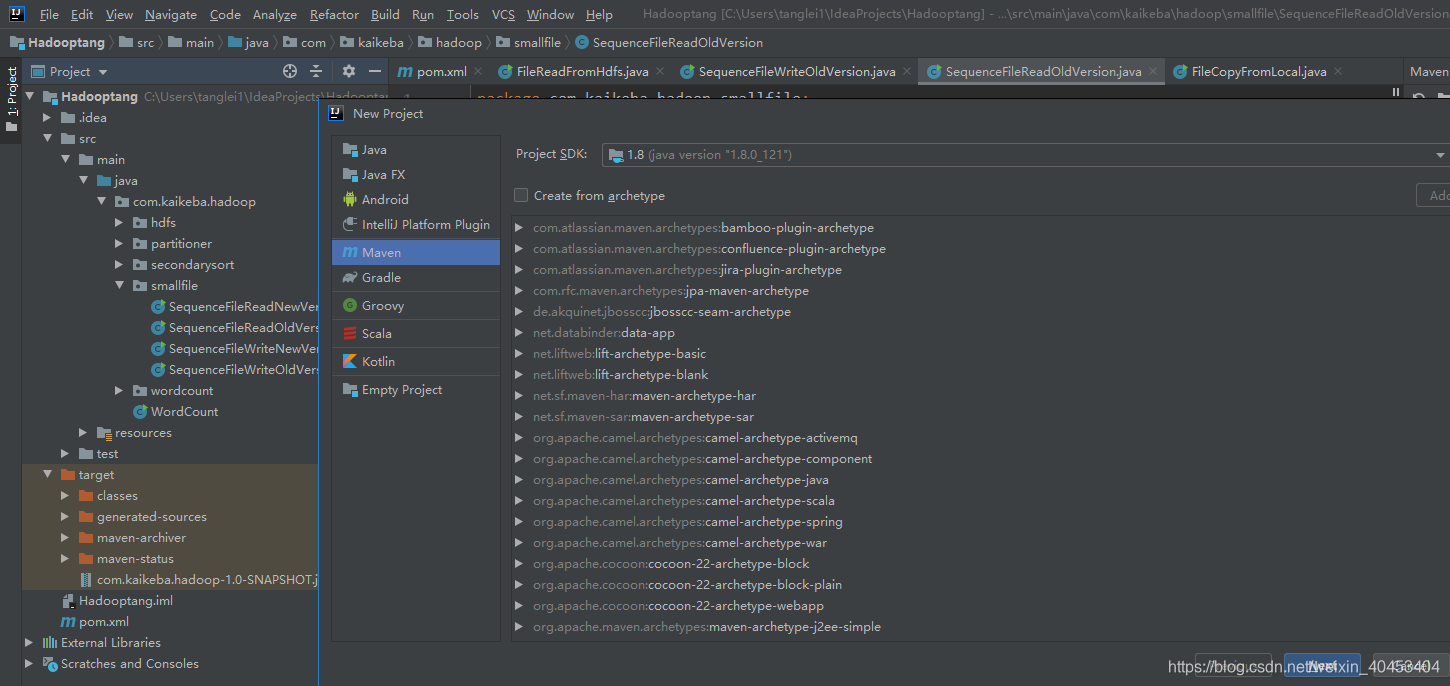

1创建工程

点击project——Maven——next

2通过maven导入项目依赖jar包

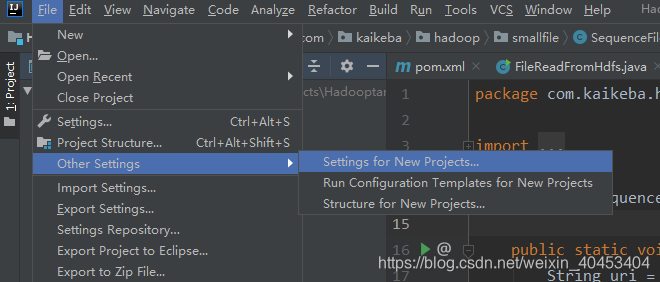

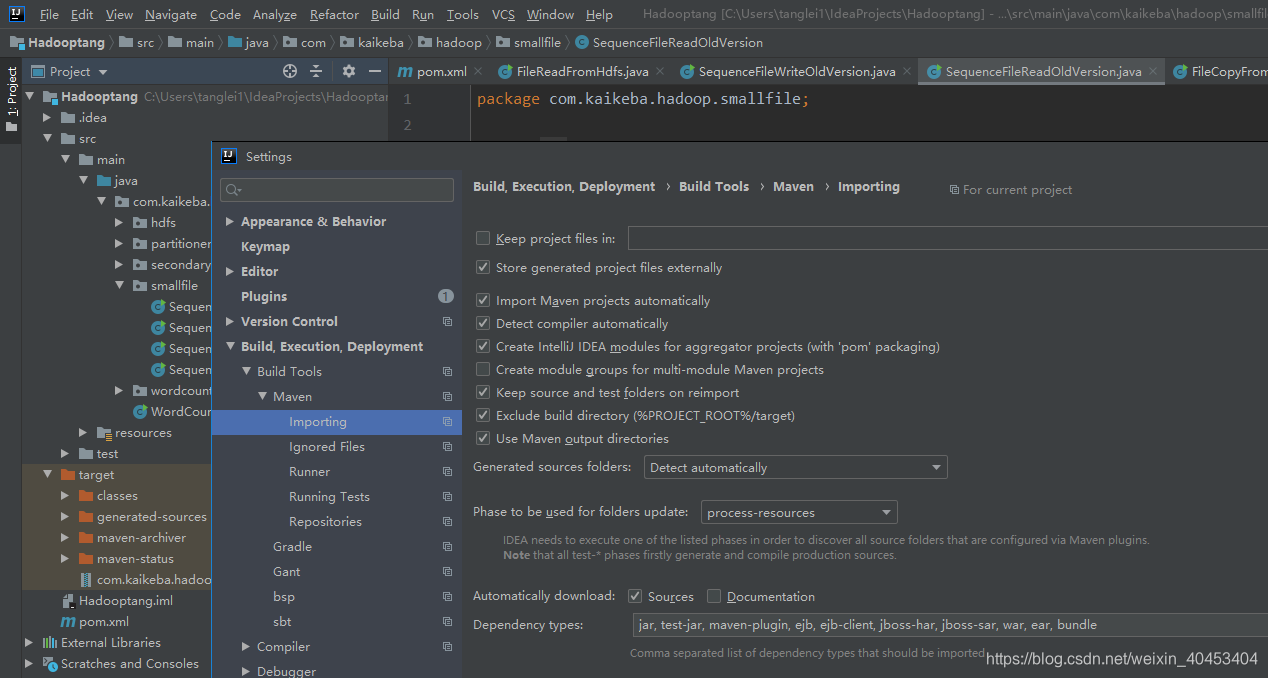

(1)设置maven自动导入依赖jar包

勾选 Import Maven projects automatically,点击apply

(2)配置pom.xml文件

pom.xml配置文件如下:

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<modelVersion>4.0.0</modelVersion>

<groupId>com.kaikeba.hadoop</groupId>

<artifactId>com.kaikeba.hadoop</artifactId>

<version>1.0-SNAPSHOT</version>

<packaging>jar</packaging>

<properties>

<hadoop.version>2.7.3</hadoop.version>

</properties>

<dependencies>

<dependency>

<groupId>commons-cli</groupId>

<artifactId>commons-cli</artifactId>

<version>1.2</version>

</dependency>

<dependency>

<groupId>commons-logging</groupId>

<artifactId>commons-logging</artifactId>

<version>1.1.3</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-mapreduce-client-jobclient</artifactId>

<version>${hadoop.version}</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-common</artifactId>

<version>${hadoop.version}</version>

</dependency>

<!-- 3.1.2 -->

<!-- <dependency>-->

<!-- <groupId>org.apache.hadoop</groupId>-->

<!-- <artifactId>hadoop-hdfs-client</artifactId>-->

<!-- <version>2.8.0</version>-->

<!-- </dependency>-->

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-hdfs</artifactId>

<version>2.7.3</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-hdfs</artifactId>

<version>${hadoop.version}</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-mapreduce-client-app</artifactId>

<version>${hadoop.version}</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-mapreduce-client-hs</artifactId>

<version>${hadoop.version}</version>

</dependency>

<!-- <dependency>-->

<!-- <groupId>org.slf4j</groupId>-->

<!-- <artifactId>slf4j-api</artifactId>-->

<!-- <version>1.7.25</version>-->

<!-- </dependency>-->

<!-- <dependency>-->

<!-- <groupId>log4j</groupId>-->

<!-- <artifactId>log4j</artifactId>-->

<!-- <version>1.2.17</version>-->

<!-- </dependency>-->

</dependencies>

</project>

3编写HDFS读写程序

****把本地文件传输到HDFS****

package com.kaikeba.hadoop.hdfs;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.IOUtils;

import java.io.*;

import java.net.URI;

/**

* 将本地文件系统的文件通过java-API写入到HDFS文件

*/

public class FileCopyFromLocal {

public static void main(String[] args) {

String source = "E:\\aa.mp4";

//获取/data的m目录存在(根据自己的环境更改)

String destination = "hdfs://122.51.241.109:9000/data/hdfs01.mp4";

InputStream in = null;

try {

in = new BufferedInputStream(new FileInputStream(source));

//HDFS读写的配置文件

Configuration conf = new Configuration();

//生成一个文件系统对象

FileSystem fs = FileSystem.get(URI.create(destination),conf);

//生成一个输出流

OutputStream out = fs.create(new Path(destination));

IOUtils.copyBytes(in, out, 4096, true);

} catch (FileNotFoundException e) {

e.printStackTrace();

} catch (IOException e) {

e.printStackTrace();

}

}

}

**把HDFS中的文件传输到本地**

package com.kaikeba.hadoop.hdfs;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FSDataInputStream;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.IOUtils;

import java.io.BufferedOutputStream;

import java.io.FileOutputStream;

import java.io.IOException;

import java.net.URI;

/**

* 从HDFS读取文件

* 打包运行jar包 [bruce@node-01 Desktop]$ hadoop jar com.kaikeba.hadoop-1.0-SNAPSHOT.jar com.kaikeba.hadoop.hdfs.FileReadFromHdfs

*/

public class FileReadFromHdfs {

public static void main(String[] args) {

try {

//

String srcFile = "hdfs://122.51.241.109:9000/data/hdfs01.mp4";

Configuration conf = new Configuration();

FileSystem fs = FileSystem.get(URI.create(srcFile),conf);

FSDataInputStream hdfsInStream = fs.open(new Path(srcFile));

BufferedOutputStream outputStream = new BufferedOutputStream(new FileOutputStream("/opt/hdfs01.mp4"));

IOUtils.copyBytes(hdfsInStream, outputStream, 4096, true);

} catch (IOException e) {

e.printStackTrace();

}

}

}

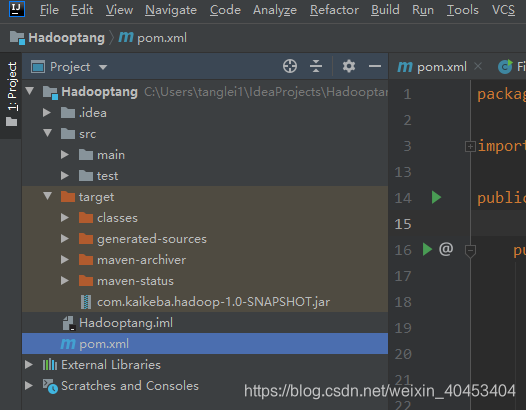

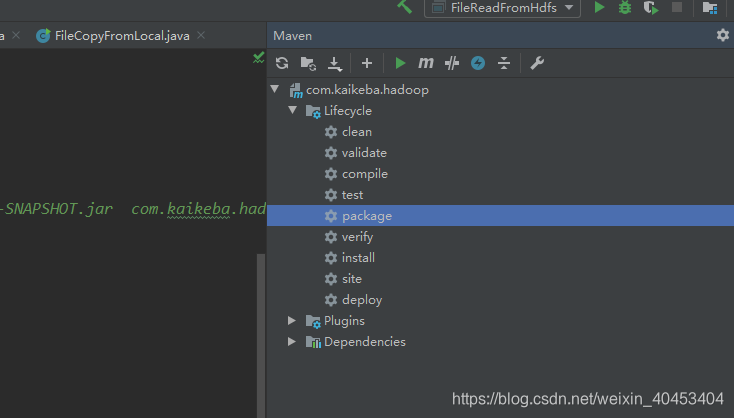

4通过运行jar包的方式验证

双击package

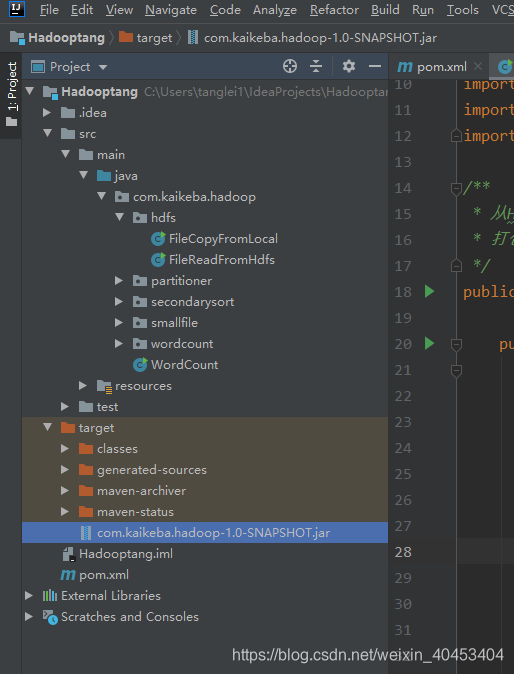

生成com.kaikeba.hadoop-1.0-SNAPSHOT.jar,考入到服务器中执行

执行命令:hadoop jar com.kaikeba.hadoop-1.0-SNAPSHOT.jar com.kaikeba.hadoop.hdfs.FileReadFromHdfs

注意: com.kaikeba.hadoop.hdfs.FileReadFromHdfs是全类名,根据自己的项目更改。

Hadoop学习之路(4)Intelij+Maven搭建Hadoop项目的更多相关文章

- Hadoop学习之路(十六)Hadoop命令hadoop fs -ls详解

http://blog.csdn.net/strongyoung88/article/details/68952248

- 《Hadoop学习之路》学习实践

(实践机器:blog-bench) 本文用作博文<Hadoop学习之路>实践过程中遇到的问题记录. 本文所学习的博文为博主“扎心了,老铁” 博文记录.参考链接https://www.cnb ...

- 阿里封神谈hadoop学习之路

阿里封神谈hadoop学习之路 封神 2016-04-14 16:03:51 浏览3283 评论3 发表于: 阿里云E-MapReduce >> 开源大数据周刊 hadoop 学生 s ...

- 【maven】 在 MyEcplise上使用maven搭建Web项目

二.在My Ecplise上使用Maven搭建Web项目 1.新建一个maven项目 2.create一个简单的骨架 3.就像在ecplise中一样设置项目的以下配置 4.新创建的项目结构如下 ...

- Maven 搭建 SSM 项目 (oracle)

简单谈一下maven搭建 ssm 项目 (使用数据库oracle,比 mysql 难,所以这里谈一下) 在创建maven 的web项目时,常常会缺了main/java , main/test 两个文件 ...

- 如何使用maven搭建web项目

博客园注册了有二十多天了,还没有写过博客,今天就发一篇,也便于后面查找笔记. 我个人已经做了几年的java web开发了,由于所在的公司是业务型公司,用的都是一些老旧的稳定技术,很少接触到稍微新点的内 ...

- IDEA使用maven搭建spring项目

spring框架 Spring框架是由于软件开发的复杂性而创建的.Spring使用的是基本的JavaBean来完成以前只可能由EJB完成的事情.然而,Spring的用途不仅仅限于服务器端的开发.从简单 ...

- Hadoop学习之路(八)在eclispe上搭建Hadoop开发环境

一.添加插件 将hadoop-eclipse-plugin-2.7.5.jar放入eclipse的plugins文件夹中 二.在Windows上安装Hadoop2.7.5 版本最好与Linux集群中的 ...

- Hadoop学习之路(四)Hadoop集群搭建和简单应用

概念了解 主从结构:在一个集群中,会有部分节点充当主服务器的角色,其他服务器都是从服务器的角色,当前这种架构模式叫做主从结构. 主从结构分类: 1.一主多从 2.多主多从 Hadoop中的HDFS和Y ...

随机推荐

- 2.【Spring Cloud Alibaba】实现负载均衡-Ribbon

负载均衡的两种方式 如何实现负载均衡 目前已经实现让A总能找到B,如何实现负载均衡 负载均衡的两种方式 服务器端负载均衡 客户端负载均衡 使用Ribbo实现负载均衡 Ribbon是什么 ==Netfl ...

- 《自拍教程19》ffmpeg_音视频图像转码工具

ffmpeg命令介绍 ffmpeg.exe(linux/imac一般不带后缀,ffmpeg), 是一款音视频编解码的命令行工具软件, 常用于多媒体测试的文件制作与转码. 我们常用的:格式工厂,Medi ...

- Java 添加、读取、删除Excel图片

本文介绍在Java程序中如何添加图片到excel表格,添加图片时可设置图片大小.位置.旋转.超链接.可选文本等,以及如何读取.删除excel表格中已有的图片. 工具:Free Spire.XLS fo ...

- 珠峰-babel

#### babel 翻译的require为了给node使用么.浏览器可以使用么.#### amd, cmd的规范.和实现原理.#### babel的三个核心包,什么使用使用.#### babel的几 ...

- Spring Boot自动配置如何工作

通过使用Mongo和MySQL DB实现的示例,深入了解Spring Boot的@Conditional注释世界. 在我以前的文章“为什么选择Spring Boot?”中,我们讨论了如何创建Sprin ...

- 11.Android-Xml读写

android中写XML时,需要用到XmlSerializer类 解析XML时,则需要用到XmlPullParser类 1.XmlSerializer类介绍 通过Xml.newSerializer() ...

- Android中通过数组资源文件xml与适配器两种方式给ListView列表视图设置数据源

场景 实现效果如下 注: 博客: https://blog.csdn.net/badao_liumang_qizhi 关注公众号 霸道的程序猿 获取编程相关电子书.教程推送与免费下载. 实现 将布局改 ...

- 关于Redis缓存预热的思考

系统上线时,提前将相关的缓存数据直接加载到缓存系统.避免在用户请求的时候,先查询数据库,然后再将数据缓存的问题. 这里我考虑2个问题: A.哪些数据需要预热? B.如何预热? 关于问题A,根据不同的业 ...

- 五分钟后,你将真正理解MySQL事务隔离级别!

什么是事务? 事务是一组原子性的SQL操作,所有操作必须全部成功完成,如果其中有任何一个操作因为崩溃或其他原因无法执行,那么所有的操作都不会被执行.也就是说,事务内的操作,要么全部执行成功,要么全部执 ...

- 【转】Makefile步步为营

Makefile步步为营 本目录主要包含Makefile一步步递进学习的示例代码 makefile代码实例:https://www.lanzous.com/i9m9npi step0:Makefile ...