Linux云计算运维-MySQL

0、建初心

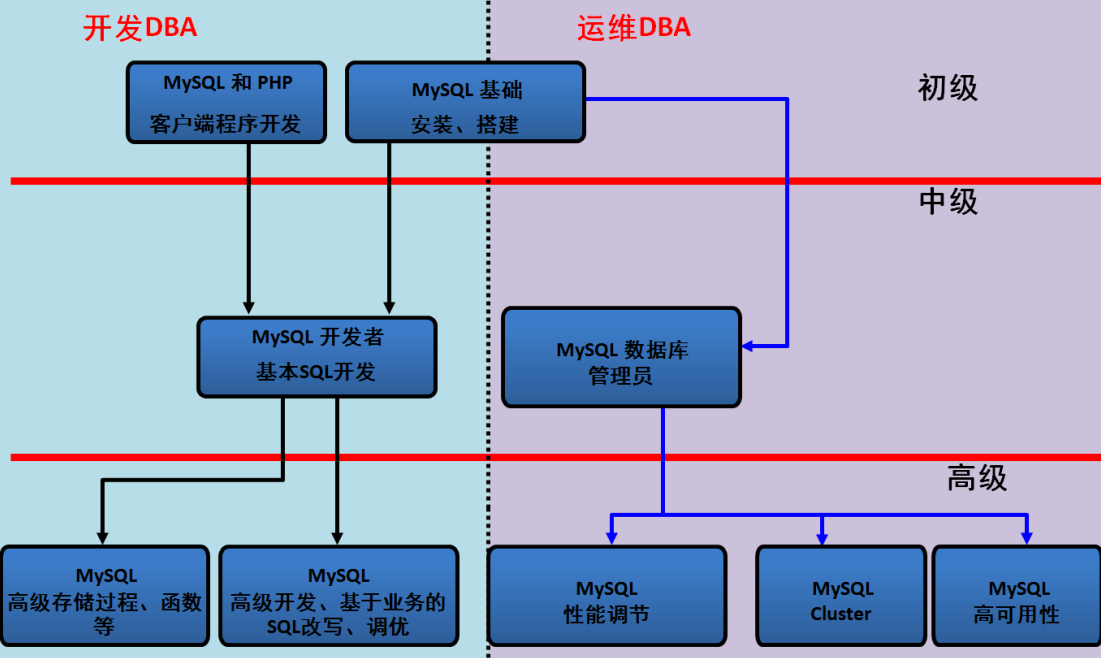

优秀DBA的素质

1、人品,不做某些事情

2、严谨,运行命令前深思熟虑,三思而后行,即使是依据select

3、细心,严格按照步骤一步一步执行,减少出错

4、心态,遇到灾难,首先要稳住,不慌张,不要受到旁人的影响

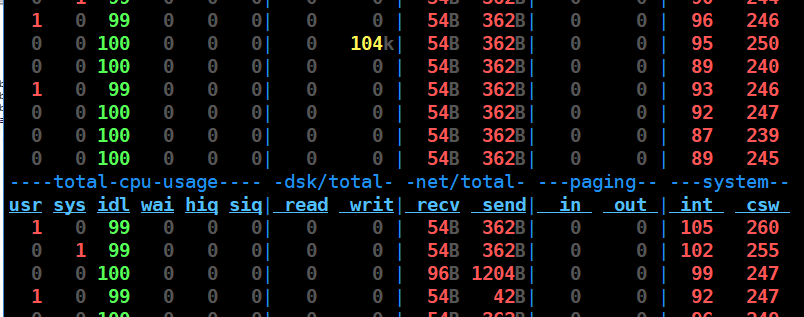

5、熟悉操作系统,Linux系统的工具和命令

6、熟悉业务(开发),编程语言

7、熟悉行业

8、喜欢数据库

• 什么是数据?

数据是指对客观事件进行记录并可以鉴别的符号,是对客观事物的性质、状态以及相互关系等进行记载的物理符号或这些物理符号的组合。它是可识别的、抽象的符号。

• 什么是数据库管理系统?

将大量的数据规范的管理在一起的软件

• 数据库管理系统种类

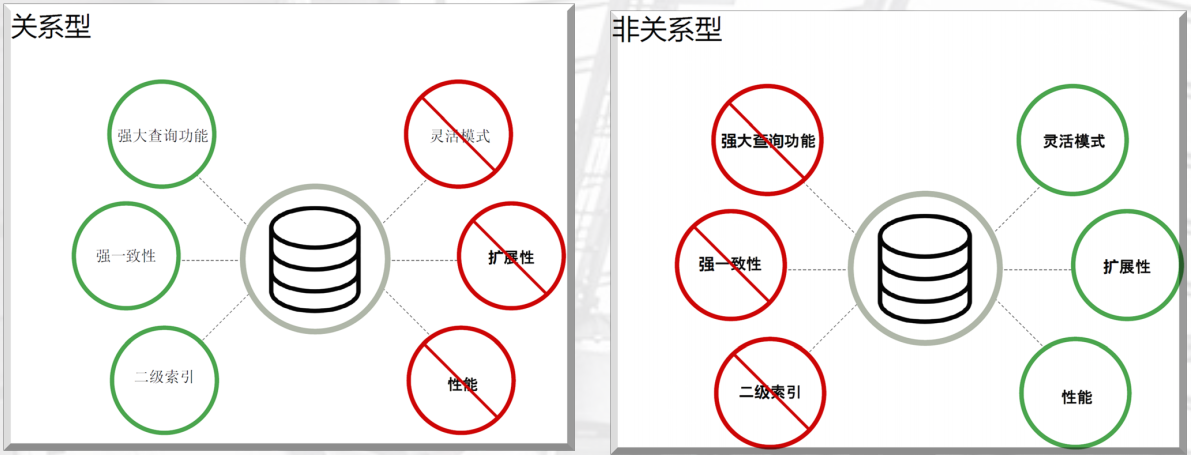

关系型和非关系型

• 关系型数据库的特点

– 二维表

– 典型产品 Oracle传统企业, MySQL是互联网企业

– 数据存取是通过SQL

– 最大特点,数据安全性方面强(ACID)

• NoSQL:非关系型数据库(Not only SQL)

– 不是否定关系型数据库,做关系型数据库的的补充。

– 想做老大,先学会做老二。 RDBMS与NoSQL对比

• web1.0时代

企业提供内容,用户浏览,所以关系型数据库够用,并发并不高,所以不需要NoSQL。

• web2.0时代

核心是企业提供平台,用户参与提供内容。这时关系型数据库无法满足需求了。

• NoSQL出现

memcached诞生,关注的点是性能,而安全性关注比较低。随着安全性需求不断提升,所以有了redis。

• redis特点

– 依然高性能该并发,

– 数据持久化的功能

– 支持多数据类型,主从复制和集群

– 管理不再使用SQL了

• NoSQL特性总览

– 不是否定关系型数据库,而是作为补充,现在也有部分替代的趋势。

– 关注高性能,高并发,灵活性,忽略和上述无关的功能。

– 现在也在提升安全性和使用功能。

– 典型产品: Redis(持久化缓存,两个半天)、 MongoDB(最接近关系型数据的NoSQL)、 Memcached。

– 管理不适用SQL管理,而是用一些特殊的 API 或 数据接口。

• NoSQL的分类、特点、典型产品

– 键值(KV)存储: Memcached、 Redis

– 列存储(column-oriented): HBASE(新浪, )、 Cassandra(200台服务器集群)

– 文档数据库(document-oriented): MongoDB(最接近关系型数据库的NoSQL)

– 图形存储(Graph): Neo4j

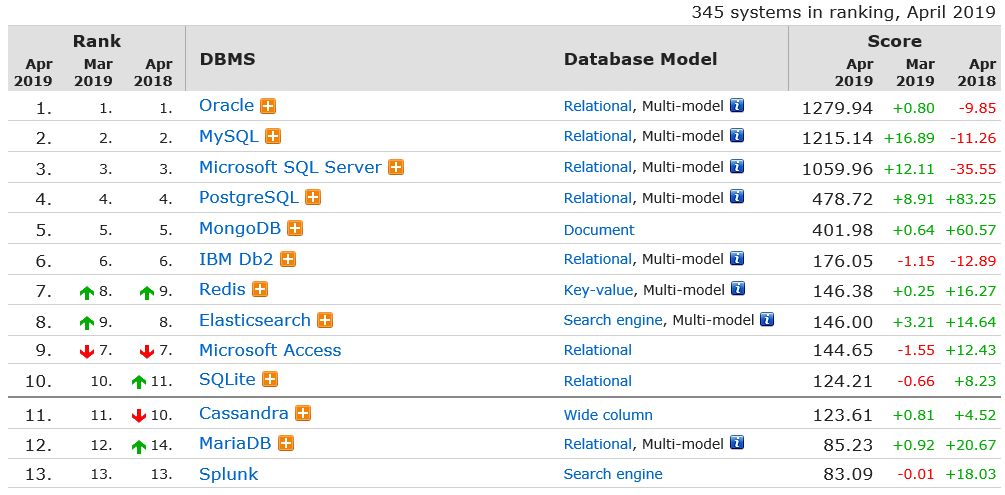

常见数据库企业及其产品

• Oracle数据库版本介绍

– 7--8i--9i--10g—11g--12c--18c(?)

• Oracle的市场应用

– 市场份额第一,趋势递减

– 市场空间,传统企业

– 传统企业也在互联网化

• MySQL数据库版本介绍

– 5.0--5.1--5.5--5.6--5.7--8.0

5.0和5.1已经不能用了,5.6和5.7是现在的主流,8.0暂时还没有稳定的版本

• MySQL的市场应用

– 中、大型互联网公司

– 市场空间:互联网领域第一

– 趋势明显

– 同源产品: MariaDB、 perconaDB 其他公司产品介绍

• 微软: SQL Server

– 微软和sysbase合作开发的产品,后来自己开发,windows平台

– 3,4线小公司,传统行业在用

• IBM : DB2

– 市场占有量小

– 目前只有:国有银行(人行、中国银行、工商银行等)、中国移动应用。

• PostgreSQL

• MongoDB

• Redis

后三者广泛应用在大型互联网公司。

MySQL发展史

• 1979年,报表工具Unireg出现。

• 1985 年,以瑞典David Axmark 为首,成立了一家公司(AB前身), IASM引擎出现。

• 1990年,提供SQL支持。

• 1999-2000年, MySQL AB公司成立,并公布源码,开源化。

• 2000年4月BDB引擎出现,支持事务。

• 2008年1月16号 MySQL被Sun公司收购。

• 2009年04月20日Oracle收购Sun公司, MySQL 转入Oracle 门下。

https://db-engines.com/en/ranking 点击查看各种数据度广度排名

1、MySQL的安装和配置

一、MySQL5..36安装前准备 ()克隆一个模板机器(使用centos6),克隆完做快照

()IP 10.0.0.52 主机名db02

()iptables selinux 关闭

()下载好5.6.36

官网下载 ftp://ftp.jaist.ac.jp/pub/mysql/Downloads/MySQL-5.6/ 下载完成最好比对一下md5

()安装依赖包

yum install -y ncurses-devel libaio-devel

()安装cmake

yum install cmake –y

()创建用户

useradd -s /sbin/nologin -M mysql

id mysql 二、MySQL下载安装 ()创建软件下载目录:

mkdir -p /server/tools

cd /server/tools/

()下载并上传到/server/tools

将下载的MySQL上传到服务器文件

社区版MySQL Community Server

5.6 5.6.3x 5.6. 5.6. 5.6.

发布超过6-12余额的版本

5.7 5.7.17以后

()解压:

cd /server/tools

tar xf mysql-5.6..tar.gz

()安装:注意修改自己下载的版本号,我这里是5.6.36,版本号输入错误会导致安装失败

cd mysql-5.6. cmake . -DCMAKE_INSTALL_PREFIX=/application/mysql-5.6. \

-DMYSQL_DATADIR=/application/mysql-5.6./data \

-DMYSQL_UNIX_ADDR=/application/mysql-5.6./tmp/mysql.sock \

-DDEFAULT_CHARSET=utf8 \

-DDEFAULT_COLLATION=utf8_general_ci \

-DWITH_EXTRA_CHARSETS=all \

-DWITH_INNOBASE_STORAGE_ENGINE= \

-DWITH_FEDERATED_STORAGE_ENGINE= \

-DWITH_BLACKHOLE_STORAGE_ENGINE= \

-DWITHOUT_EXAMPLE_STORAGE_ENGINE= \

-DWITH_ZLIB=bundled \

-DWITH_SSL=bundled \

-DENABLED_LOCAL_INFILE= \

-DWITH_EMBEDDED_SERVER= \

-DENABLE_DOWNLOADS= \

-DWITH_DEBUG=

执行到这里也许会抱一个错误,导致安装失败

CMake Error: your CXX compiler: "CMAKE_CXX_COMPILER-NOTFOUND" was not found. Pleaet CMAKE_CXX_COMPILER to a valid compiler path or name.

这是因为系统缺少C++编译器

yum install gcc-c++ -y

make && make install 太慢了... 三、配置并启动 ()制作软连接:

ln -s /application/mysql-5.6./ /application/mysql ()拷贝配置文件到/etc:覆盖原文件

cp support-files/my*.cnf /etc/my.cnf ()初始化数据库:创建元数据,系统数据库

/application/mysql/scripts/mysql_install_db --basedir=/application/mysql/ --datadir=/application/mysql/data --user=mysql ()创建关键目录并设置权限:

mkdir -p /application/mysql/tmp

chown -R mysql.mysql /application/mysql/ ()复制启动脚本到/etc/init.d/mysqld

cp support-files/mysql.server /etc/init.d/mysqld ()启动数据库

chkconfig mysqld on

/etc/init.d/mysqld start

netstat -lntup|grep ()配置环境变量

echo 'PATH=/application/mysql/bin/:$PATH' >>/etc/profile

tail - /etc/profile

source /etc/profile

echo $PATH

mysql select user,host,password from mysql.user; 排错:

1、输出

2、错误日志

tail -100 /application/mysql/data/db02.err

设置密码:

mysqladmin -u root password 'pizza123'

mysql -uroot -pizza123

清理用户及无用数据库(基本优化)

select user,host from mysql.user;

drop user ''@'db02';

drop user ''@'localhost';

drop user 'root'@'db02';

drop user 'root'@'::1';

select user,host from mysql.user;

drop database test;

show databases;

作业

、请列举你了解到的数据库典型产品 、请说明企业中选择数据库版本的规则 、请简述MySQL数据库支持的安装方式 、编译安装自己的一套MySQL数据库 、简述mysql_install_db命令的常用参数 、简述5.7版本安装过程中与5.6的区别(自己扩展学习)

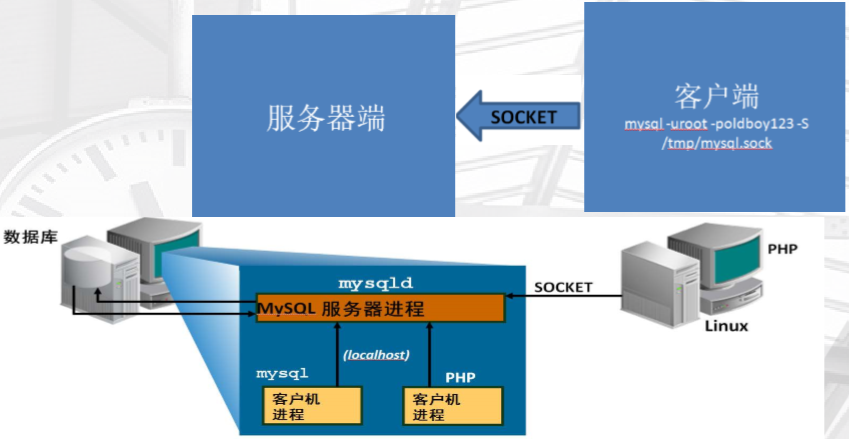

2、MySQL 体系结构

客户端与服务器端模型

1、cs之间通过TCP/IP链接

2、cs之间通过socket链接

所以,对应两种链接到数据库的方法

• 通过网络连接串

mysql -uroot -poldboy123 -h 10.0.0.200

• 通过套接字文件

mysql -uroot -poldboy123 -S /tmp/mysql.sock

• 思考: mysql - uroot - poldboy123 使用的是什么方式登录的?

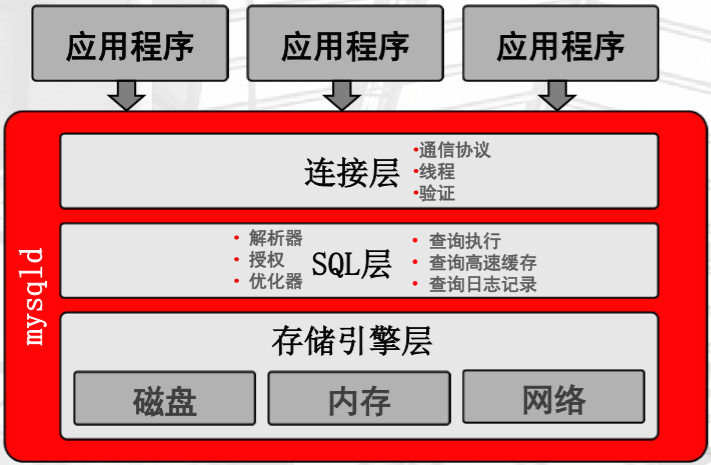

MySQL体系结构-实例、连接层、SQL层详解

• MySQL在启动过程

– 启动后台守护进程,并生成工作线程

– 预分配内存结构供MySQL处理数据使用

• 实例是什么?

MySQL的后台进程+线程+预分配的内存结构。

mysqld服务器程序的构成

show processlist;可以查看链接到MySQL的信息

SQL处理流程

在SQL层中,语句交给解析器,转换成执行计划,交给查询执行

当有多种执行计划时,交给优化器,确认执行计划,交给查询执行

得到的结果(获取数据的方式,即位置)交给存储引擎层,

、接收到连接层送过过来的“SQL”

、由专门的模块,会判断SQL语法、语义(SQL语句的类型:DDL、DCL、DML)

、将不同类型的语句,送到专门的处理接口(解析器)

、解析器,将SQL解析成执行计划

、优化器,会选择“它”最优的执行计划交给执行器

、执行器,执行 执行计划,得出如何去“磁盘”获取数据的方法

、专门线程将获取数据的方法,送给下层(存储引擎层)继续处理。

、验证授权,当前用户对 库或表对象有没有操作的权限。

、查询高速缓存query_cache。

、记录修改操作日志binlog。

存储引擎层

真正接触数据,和数据打交道的,接受SQL层执行计划的结果,去指定的位置取指定的数据,或者将数据存储在哪个位置

存储引擎是充当不同表类型的处理程序的服务器组件。

• 存储引擎用于:

– 存储数据

– 检索数据

– 通过索引查找数据

• 双层处理

– 上层包括SQL解析器和优化器

– 下层包含一组存储引擎

• SQL 层不依赖于存储引擎:

– 引擎不影响SQL处理

– 有一些例外,

依赖于存储引擎的功能

• 存储介质

• 事务功能

• 锁定

• 备份和恢复

• 优化

• 特殊功能:

– 全文搜索

– 引用完整性

– 空间数据处理

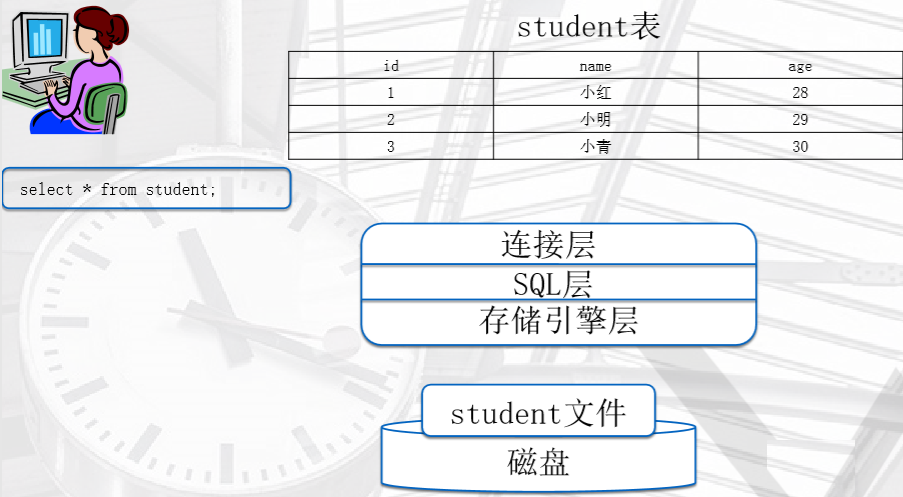

简述MySQL的整个处理过程

首先,在磁盘中存储的数据肯定不是这个表的形式,在命令运行之后,经过一系列的操作,表格才展现在我们眼前

1、连接层

通信协议---验证---授权---提供链接线程---接收SQL语句,并交给SQL层

2、SQL层

见上面的流程,验证语法、语义(查询or插入)---query_cache---解析---优化---

3、存储引擎层

去指定位置取指定的数据---返回给SQL层---处理---连接层交给用户展现

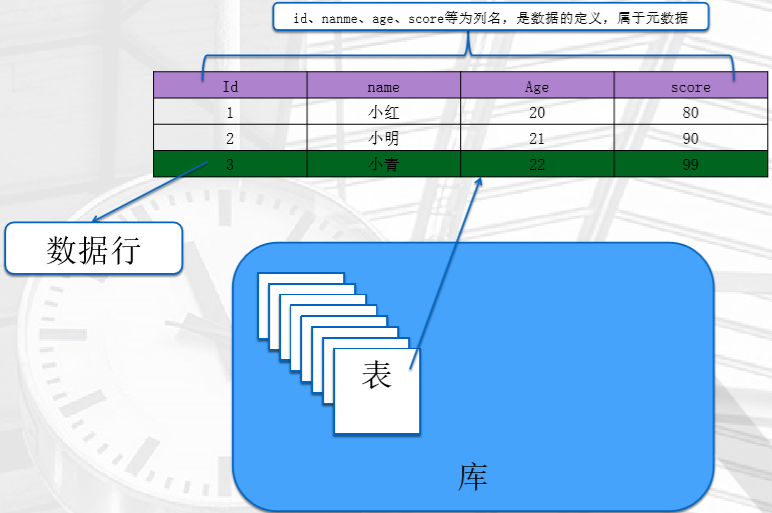

数据库的逻辑结构

列、数据行、表、库 就是这些抽象出来的结构

在物理层,是怎么存储到磁盘的呢?见下图,MySQL对磁盘的使用

注:我们只研究到文件系统层

程序文件随数据目录一起存储在服务器安装目录下。执行各种客户机程序、管理程序 和实用程序时将创建程序可执行文件和日志文件。

首要使用磁盘空间的是数据目录。

• 服务器日志文件和状态文件: 包含有关服务器处理的语句的信息。日志可用于进行故障排除、监视、复制和恢复。

• InnoDB 日志文件: (适用于所有数据库)驻留在数据目录级别。

• InnoDB 系统表空间:

包含数据字典、撤消日志和缓冲区。

每个数据库在数据目录下均具有单一目录(无论在数据库中创建何种类型的表)。

数据库目录存储以下内容:

- 数据文件: 特定于存储引擎的数据文件。这些文件也可能包含元数据或索引信息,具体取决于所使用的存储引擎。

- 格式文件 (.frm): 包含每个表和/或视图结构的说明,位于相应的数据库目录中。

- 触发器: 与某个表关联并在该表发生特定事件时激活的命名数据库对象。

数据目录的位置取决于配置、操作系统、安装包和分发。

典型位置是 /var/lib/mysql。 MySQL在磁盘上存储系统数据库 (mysql)。

mysql 包含诸如用户、特权、插件、 帮助列表、事件、时区实现和存储例程之类的信息。

页(默认是16k):是mysql数据库存储的最小单元

区:连续的多个页组成,是一系列练习的数据行

段:一个表(分区表)就是一个段,包含了多个区

3、MySQL的基本管理

• MySQL的连接管理

mysql命令 -u 用户名

-p 密码 例子:

mysql -uroot -pizza123 -h ip

例子:

mysql -uroot -pizza123 -h 10.0.0.52 -P

例子:

mysql -uroot -pizza123 -h 10.0.0.52 -P -S /tmp/mysql.sock 套接字目录

例子:

mysql -uroot -pizza123 -S /application/mysql/tmp/mysql.sock -e "show variables like 'server_id';" 免交互式执行SQL命令,直接获得结果

例子:

mysql -uroot -pizza123 -e "show variables like 'server_id';" mysqladmin

mysqladmin -uroot -p password pizza123

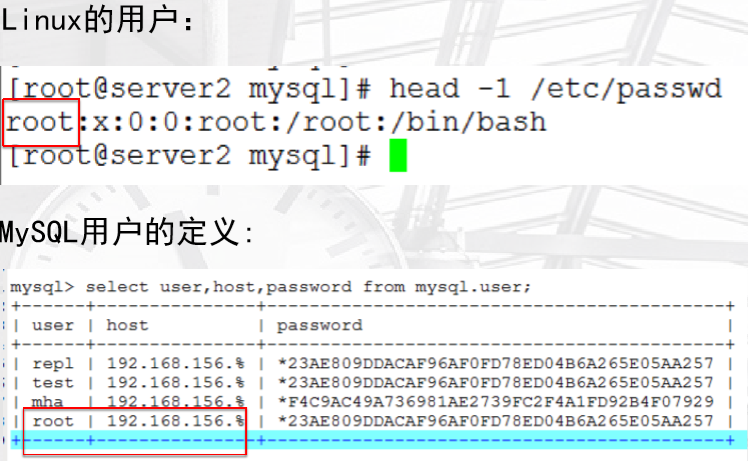

• MySQL用户管理及权限基本管理

用户权限由用户名+主机范围构成

对比一下Linux用户和MySQL用户

user:表示使用哪个用户登陆

host:表示从哪些地址访问这个数据库

• 用户的作用:

– 、用户登录

– 、用于管理数据库及数据

• 权限: 针对不同用户设置不同对象管理能力

– 对数据库的读、写等操作

– (insert update、select等)

• 角色:

– 数据库定义好的一组权限的定义

– (all privileges、replication slave等)

• 权限范围:

– 全库级别: *.*

– 单库级别:oldboy.*

– 单表级别:oldboy.t1

超级管理(管理)用户:root ,当前如果要进行授权操作只能用root进行

也不用再去创建了,当然也可以根据不同的地址,主机域去设置不同的密码和操作

mysqladmin -uroot -p password pizza123 这条命令,执行的是root@localhost,即只在本地生效的权限范围

普通用户(开发)的权限包括:select update delete insert drop ...用的比较多的

用户操作命令

• 查看当前用户:

select user,host from mysql.user;

• 创建用户

CREATE USER '用户'@'主机' IDENTIFIED BY '密码';

create user 'pizza'@'localhost' identified by 'pizza123';

#只有连接权限 企业里创建用户一般是授权一个内网网段登录,最常见的网段写法有两种。

方法1:172.16.1.%(%为通配符,匹配所有内容)。

方法2:172.16.1.0/255.255.255.0,但是不能使用172.16.1.0/24,是个小遗憾。

# 远程登录,带参数-h

mysql> create user web01@'10.0.0.%' identified by '123';

[root@web01 mysql-5.6.43]# mysql -uweb01 -p123 -h10.0.0.7

登陆后的普通用户,权限很低 标准的建用户方法:

create user 'web'@'172.16.1.%' identified by 'web123';

• 查看用户对应的权限

show grants for oldboy@localhost\G

• 删除用户

drop user 'user'@'主机域' 或者 drop user root@'127.0.0.1';

用户优化:只保留 有密码和有用户名的

| root | 127.0.0.1 |

| root | localhost |

特殊的删除方法:

mysql> delete from mysql.user where user='pizza' and host='localhost';

Query OK, row affected (0.00 sec) mysql> flush privileges; • 给用户授权

create user 'pizza'@'localhost' identified by 'pizza123';

select user,host from mysql.user;

GRANT ALL ON *.* TO 'pizza'@'localhost';

SHOW GRANTS FOR 'pizza'@'localhost'\G

• 创建用户的同时授权

grant all on *.* to pizza@'172.16.1.%' identified by 'pizzal123';

flush privileges; #<==可以不用。

create user 'pizza'@'localhost' identified by 'pizza123';

GRANT ALL ON *.* TO 'pizza'@'localhost';

• 授权和root一样的权限

grant all on *.* to system@'localhost' identified by 'pizzal123' with grant option;

• 收回权限

REVOKE INSERT ON *.* FROM pizza@localhost;

• 可以授权的用户权限

INSERT,SELECT, UPDATE, DELETE, CREATE, DROP, RELOAD, SHUTDOWN, PROCESS, FILE,

REFERENCES, INDEX, ALTER, SHOW DATABASES, SUPER, CREATE TEMPORARY TABLES,

LOCK TABLES, EXECUTE, REPLICATION SLAVE, REPLICATION CLIENT, CREATE VIEW,

SHOW VIEW, CREATE ROUTINE, ALTER ROUTINE, CREATE USER, EVENT, TRIGGER,

CREATE TABLESPACE

• 开发用户 拥有的基本权限

INSERT,SELECT, UPDATE, DELETE, CREATE, DROP

grant INSERT,SELECT, UPDATE, DELETE, CREATE, DROP on testdb.* to web01@‘10.0.0.%’;

• 工作博客授权:

grant select,insert,update,delete,create,drop on blog.* to 'blog'@'172.16.1.%' identified by 'blog123';

revoke create,drop on blog.* from 'blog'@'172.16.1.%';

最多:select,insert,update,delete

• 注意: 思考一下如果在oldboy.*,设置了select,insert,update,delete 在oldboy.t1设置了select,

那么用户在t1表的最终权限应该是什么。 回收权限的时候又该怎么做?

实验后的结论:

如果对于某个用户在不同数据库级别都设置了权限,最终权限相叠加,以加起来的最大权限为准。

建议:不要多范围授权

• MySQL的启动和关闭(启动脚本介绍)

数据库的启动流程介绍

mysql最终启动的是mysqld进程,通过他提供的启动脚本,不能直接启动mysqld

数据库的关闭

• mysqladmin shutdown

• servive mysqld stop

• kill - ? 慎用

• 第三种为利用系统进程管理命令关闭MySQL。

– kill pid #<==这里的pid为数据库服务对应的进程号。

– killall mysqld #<==这里的mysqld是数据库服务对应的进程名字。

– pkill mysqld #<==这里的mysqld是数据库服务对应的进程名字。

可通过如下地址查看生产高并发环境野蛮粗鲁杀死数据库导致故障企业案例:

http://oldboy.blog.51cto.com/2561410/1431161

http://oldboy.blog.51cto.com/2561410/1431172

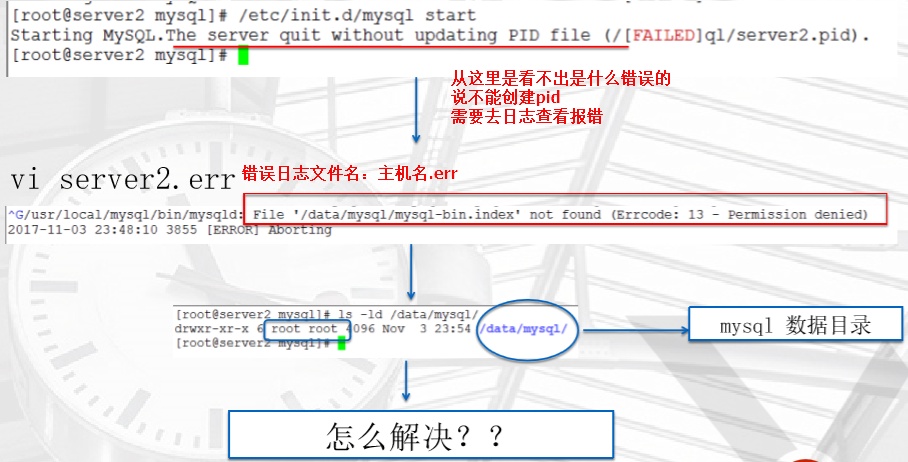

MySQL启动报错

停数据库----去mysql/data目录下--随便改一个文件(目录下的一个文件权限改成root)---启动数据库

报错

常规的报错代码整理 http://oldboy.blog.51cto.com/2561410/1728380

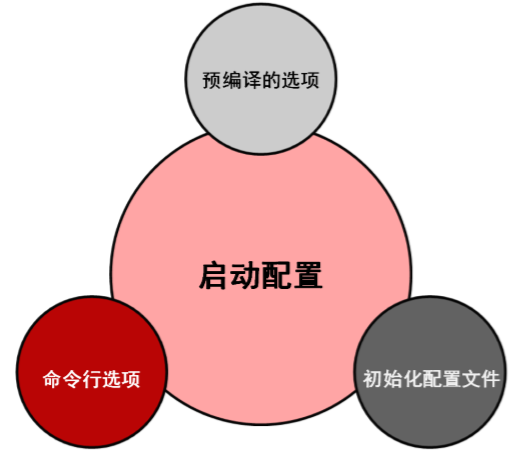

• MySQL数据库配置文件详解

启动之前都做了什么?

1、程序在哪

2、启动后去哪里找数据

3、启动之后分配多大内存

...

n、还有许许多多的问题

MySQL的初始化配置文件

预编译配置项,即在使用cmake时,硬编码设置的参数,指定了如安装目录、数据目录、sock目录

命令行设置,在命令行上配置参数

/application/mysql/bin/mysqld_safe 用来启动mysql,因为设置过环境变量,可以直接运行

mysqld_safe --socket=/tmp/mysql.sock --port=3307 &

链接,不能用老的方式了

mysql -uroot -ppizza -S /tmp/mysql.sock

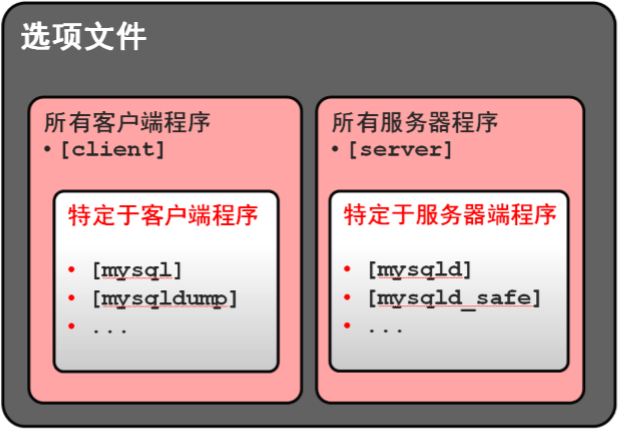

初始化配置文件,/etc/my.cof

标签的种类和影响的程序

选项文件示例

[mysqld]

basedir=/application/mysql

datadir=/application/mysql/data

socket=/application/mysql/tmp/mysql.sock

port=3306

server_id=10

log-error=/var/log/mysql.log

log-bin=/application/mysql/data/mysql-bin

binlog_format=row

skip_name_resolve [mysql]

socket=/application/mysql/tmp/mysql.sock

- 数据库的启动(客户端)

- 启动文件的启动选项包括

- 共享内存

- 日志记录

- 系统变量

- 默认存储引擎

- 命名管道链接

- 启动文件的启动选项包括

- 数据库的链接(服务器)

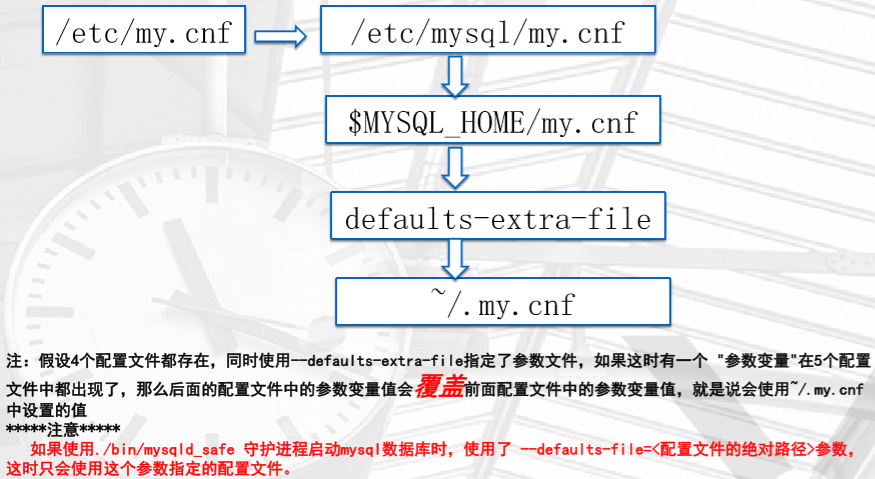

优先级

mysql 启动参数设置

、预编译时候设置参数,参数会硬编码到程序中

、命令行方式设定启动参数

、初始化的配置文件

>>

MySQL为我们配置了很多配置文件,配置文件读取顺序如下

自定义配置文件位置,系统自己是找不到的

vim /tmp/aa.txt

[mysqld]

basedir=/application/mysql

datadir=/application/mysql/data

port=

socket=/tmp/mysql.sock

使用自定义的配置文件

/etc/init.d/mysqld stop

mysqld_safe --defaults-file=/tmp/aa.txt &

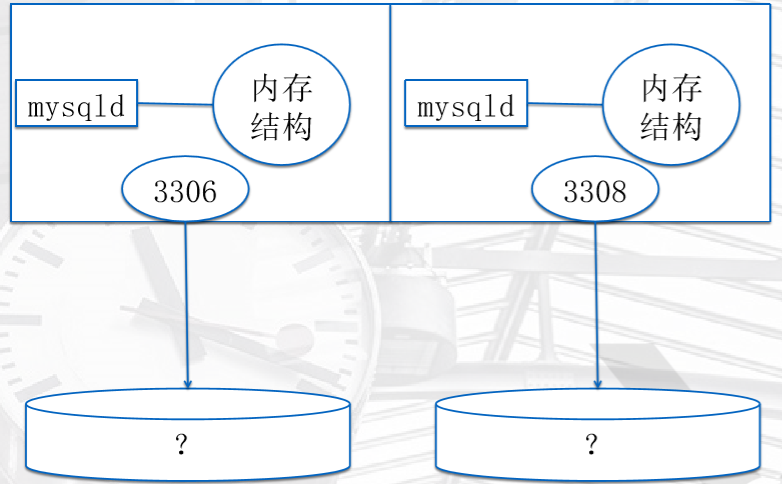

• 多实例简介及配置

一个MySQL实例就是一个进程,多个线程,一定量预分配的内存空间

多实例就是,多个这样的实例管理不同的数据,和一些日志

思路

、启动多个mysqld进程

、规划多套数据

、规划多个端口

、规划多套日志路径

多实例配置

、创建多套目录

mkdir -p /data/{,,}

、准备多套配置文件

vim /data//my.cnf

[mysqld]

basedir=/application/mysql

datadir=/data/

server-id=

port=

log-bin=/data//mysql-bin

socket=/data//mysql.sock

log-error=/data//mysql.log

vim /data//my.cnf

[mysqld]

basedir=/application/mysql

datadir=/data/

server-id=

port=

log-bin=/data//mysql-bin

socket=/data//mysql.sock

log-error=/data//mysql.log

vim /data//my.cnf

[mysqld]

basedir=/application/mysql

datadir=/data/

server-id=

port=

log-bin=/data//mysql-bin

socket=/data//mysql.sock

log-error=/data//mysql.log

、初始化多套数据

/application/mysql/scripts/mysql_install_db --basedir=/application/mysql/ --datadir=/data/ --user=mysql

/application/mysql/scripts/mysql_install_db --basedir=/application/mysql/ --datadir=/data/ --user=mysql

/application/mysql/scripts/mysql_install_db --basedir=/application/mysql/ --datadir=/data/ --user=mysql

、启动多个实例

mysqld_safe --defaults-file=/data//my.cnf &

mysqld_safe --defaults-file=/data//my.cnf &

mysqld_safe --defaults-file=/data//my.cnf &

、查看启动端口

netstat -lnp |grep

、分别连接测试

mysql -S /data//mysql.sock -e "show variables like 'server_id';"

mysql -S /data//mysql.sock -e "show variables like 'server_id';"

mysql -S /data//mysql.sock -e "show variables like 'server_id';"

作业

、列出MySQL在Linux下的两种连接方式 、简述mysql修改密码方法 、简述实例的构成 、结合MySQL体系结构,说明一条SQL语句的执行过程 、mysql的默认日志文件在什么位置 、简述MySQL的启动方式 、简述MySQL配置文件读取顺序 、配置MySQL多实例,端口分别为3307 、请介绍mysql连接命令的常用参数,并说明功能 、请简述MySQL的逻辑构成

• 数据库对象管理——SQL(库、表、行记录)

4、MySQL客户端工具及SQL入门

• MySQL 客户端命令

mysql命令

• mysql:

– 用于数据库连接管理

– 前面章节已经使用过(略。)

– 命令接口自带命令

• 1、\h 或 help 或 ?

• 2、\G 键值对的方式排列

• 3、\T 或 tee 记录到日志

• 4、\c 或 CTRL+c 结束上一条命令

• 5、\s 或 status 查看数据库基本状态信息

• 6、\. 或 source 调用外部SQL脚本

• 7、\u 或use

– 将 用户SQL 语句发送到服务器,管理数据库

结构化查询语言,MySQL接口程序只负责接受SQL,传送给SQL层

– DDL:数据库(对象)定义语言

– DCL:数据控制语言(grant、revoke)

– DML:数据(行)操作语言(update、delete、insert)

- DQL:数据查询语言(show、select)

• mysqladmin:

– 命令行管理工具

• mysqldump:

– 备份数据库和表的内容

source命令使用

• 在 mysql 中处理输入文件:

• 如果这些文件包含 SQL 语句,则称为:

– “脚本文件”

– “批处理文件”

• 使用 SOURCE 命令:

mysql> SOURCE /data/mysql/world.sql

或者使用非交互式:

mysql</data/mysql/world.sql

mysqladmin命令

• DBA的命令行客户端工具

• 多项功能:

– “强制回应 (Ping)”服务器。

– 关闭服务器。

– 创建和删除数据库。

– 显示服务器和版本信息。

– 显示或重置服务器状态变量。

– 设置口令

– 重新刷新授权表。

– 刷新日志文件和高速缓存

– 启动和停止复制

– 显示客户机信息

• 命令帮助及基本语法:

mysqladmin --help

mysqladmin -u<name> -p<password> commands

• 例子:

mysqladmin version

mysqladmin status

mysqladmin ping

mysqladmin processlist

mysqladmin shutdown

mysqladmin variables

…

mysqldump命令简介

• 数据库备份工具。

• 命令帮助及基本语法:

mysqldump –help

Usage: mysqldump [OPTIONS] database [tables]

OR mysqldump [OPTIONS] --databases [OPTIONS] DB1 [DB2 DB3...]

OR mysqldump [OPTIONS] --all-databases [OPTIONS]

数据库对象:库、表

库的名字,库的基本属性 create database blog;

• MySQL 获取帮助的方法

help命令的使用

• 查看完整的 SQL 类别列表:

mysql> HELP CONTENTS

...

Account Management

Administration

Compound Statements

Data Definition

Data Manipulation Data Types

...

• 有关特定 SQL 类别或语句的帮助:

mysql> HELP Data Manipulation

mysql> HELP JOIN

• 有关与状态相关的 SQL 语句的帮助:

mysql> HELP STATUS

• DDL操作简介

DDL操作:

对象:

库:

定义什么?

、库名字

、库的基本属性

如何定义?

create database lufei;

create schema lf;

show databases;

create database llf CHARACTER SET utf8 ;

show create database llf;

drop database llf;

help create database;

字符集: CHARACTER SET [=] charset_name

排序规则:COLLATE [=] collation_name 改库的字符集:

ALTER DATABASE [db_name] CHARACTER SET charset_name COLLATE collation_name

mysql> alter database lf charset utf8mb4;

mysql> show create database lf; 表:

表数据:数据行

表属性(元数据):表名、列名字、列定义(数据类型、约束、特殊列属性)、表的索引信息

定义什么?

定义表的属性。

use lufei;

创建:

create table t1 (id int ,name varchar());

查询:

show tables;

show create table t1;

desc

删除

drop table t1;

修改:

()在表中添加一列

alter table t1 add age int;

()添加多列

alter table t1 add bridate datetime, add gender enum('M','F');

()在指定列后添加一列,没有before(,这是一个可有可无的选项,降低开发需求)

alter table t1 add stu_id int after id;

()在表中最前添加一列

alter table t1 add sid int first;

()删除列

alter table t1 drop sid;

()修改列名

alter table t1 change name stu_name varchar();

()修改列属性

alter table t1 modify stu_id varchar();

()修改表名

rename table t1 to student;

alter table student rename to stu;

• DDL 语句之管理数据库

• 查看数据库

show databases;

show databases like '%old%';

• 获取命令帮助

? contents

?Administration

? show database

• 创建数据库

CREATE DATABASE oldboy; #字符集和编译指定相同.

• 获取命令帮助

? contents

?Data Definition

? create database

• 查看建库的语句

show create database oldboy\G

• 指定字符集建库

CREATE DATABASE db_name CHARACTER SET

charset_name COLLATE collation_name

CREATE DATABASE oldgirl CHARACTER SET gbk COLLATE

gbk_chinese_ci;

show character set;#找字符集和校对规则.

• 改库的字符集:

ALTER DATABASE [db_name] CHARACTER SET charset_name COLLATE collation_name

ALTER DATABASE oldgirl CHARACTER SET utf8mb4 COLLATE utf8mb4_general_ci;

• 删库 drop database oldboy;

• 切库 use oldboy;

• 查看当前所在的库 select database(); select user();

• 查看库里的表 show tables;

• DDL语句之管理用户(上面已说过)

• 用户:

‘user’@‘主机域’

• 帮助:

? Account Management

• 常用命令:

.查看当前用户

.创建用户

.查看用户对应的权限

.删除用户

.给用户授权

.收回权限

.工作博客授权

• DDL 语句之管理表 与 案例介绍

建表、查看变结构、查看建表语句、改表名

• 表的属性:

– 字段、数据类型、索引

– 默认:字符集、引擎

• 建立表

create table <表名> (<字段名1> <类型1> , …<字段名n> <类型n>);

• 获取帮助

help create table;

• 查看表结构:

desc student;

• 查看建表语句:

show create table student\G

• 更改表名

rename table student to test;

alter table test rename to student;

修改表结构

• 原表:

CREATE TABLE `test` (

`id` int() NOT NULL AUTO_INCREMENT,

`name` char() NOT NULL,

PRIMARY KEY (`id`)

) ENGINE=InnoDB DEFAULT CHARSET=UTF8;

• 先添加性别列,长度为4,内容非空

alter table test add sex char() NOT NULL;

• 指定添加年龄列到name列后面的位置,示例如下:

alter table test add age int() after name;

• 通过下面的命令在第一列添加qq字段。

alter table test add qq varchar() first;

• 若要删除字段,可采用如下命令。

alter table test drop qq;

• 若要同时添加两个字段,可采用如下命令。

alter table test add age tinyint() first,add qq varchar();

• 修改字段类型的命令如下:

alter table test modify age char() after name;

Query OK, rows affected (0.00 sec)

Records: Duplicates: Warnings:

• 修改字段名称的命令如下:

alter table test change age oldboyage char() after name; 添加表字段

alter table table1 add transactor varchar(10) not Null;

alter table table1 add id int unsigned not Null auto_increment primary key 修改某个表的字段类型及指定为空或非空

alter table 表名称 change 字段名称 字段名称 字段类型 [是否允许非空]; alter table 表名称 modify 字段名称 字段类型 [是否允许非空]; alter table 表名称 modify 字段名称 字段类型 [是否允许非空]; 修改某个表的字段名称及指定为空或非空

alter table 表名称 change 字段原名称 字段新名称 字段类型 [是否允许非空] 删除某一字段

ALTER TABLE mytable DROP 字段 名; 添加唯一键

ALTER TABLE `test2` ADD UNIQUE ( `userid`) 修改主键 ALTER TABLE `test2` DROP PRIMARY KEY ,ADD PRIMARY KEY ( `id` ) 增加索引 ALTER TABLE `test2` ADD INDEX ( `id` ) ALTER TABLE `category ` MODIFY COLUMN `id` int(11) NOT NULL AUTO_INCREMENT FIRST ,ADD PRIMARY KEY (`id`); 第一步:给 id 增加auto_increment 属性

alter table test modify id int(11) auto_increment;

第二步:给自增值设置初始值

alter table test auto_increment=0;

思考:change和modify该如何选择? 修改主键的sql语句块如下:

mailbox 表新增字段 DROP PROCEDURE IF EXISTS mailbox_column_update;

CREATE PROCEDURE mailbox_column_update() BEGIN

-- 新增删除标志列

IF NOT EXISTS(SELECT 1 FROM information_schema.COLUMNS WHERE TABLE_SCHEMA='cbs' AND table_name='mailbox' AND COLUMN_NAME='delete_flag') THEN

ALTER TABLE mailbox ADD delete_flag int DEFAULT 2 NOT NULL;

END IF;

-- 新增删除日期列

IF NOT EXISTS(SELECT 1 FROM information_schema.COLUMNS WHERE TABLE_SCHEMA='cbs' AND table_name='mailbox' AND COLUMN_NAME='delete_date') THEN

ALTER TABLE mailbox ADD delete_date int DEFAULT 0 NOT NULL;

END IF;

-- 如果存在字段account_mail,则修改字段长度

IF EXISTS(SELECT 1 FROM information_schema.COLUMNS WHERE TABLE_SCHEMA='cbs' AND table_name='mailbox' AND COLUMN_NAME='email_account')

THEN

alter table mailbox modify column email_account varchar(320);

END IF;

-- 如果不存在主键列,则设置双主键

IF ((SELECT count(*) FROM information_schema.KEY_COLUMN_USAGE WHERE TABLE_SCHEMA ='cbs' AND table_name='mailbox' AND CONSTRAINT_NAME ='PRIMARY' AND (COLUMN_NAME ='email_account' OR COLUMN_NAME = 'company_id'))=0)THEN

ALTER TABLE mailbox ADD primary key (company_id,email_account);

-- 如果只存在一个主键列

ELSEIF ((SELECT count(*) FROM information_schema.KEY_COLUMN_USAGE WHERE TABLE_SCHEMA ='cbs' AND table_name='mailbox' AND CONSTRAINT_NAME ='PRIMARY' AND (COLUMN_NAME ='email_account' OR COLUMN_NAME = 'company_id'))<2)THEN

ALTER TABLE mailbox DROP PRIMARY KEY,ADD primary key (company_id,email_account);

END IF;

• DML 语句之管理表中的数据

• 备份数据备用

mysqldump以SQL语句形式将数据导出来。

mysqldump -B --compact oldboy >/opt/bak.sql

• insert 插入数据

use lufei;

create table t1 (id int ,name varchar(20));

# 要根据 表结构 插入

insert into t1 values(1,'zhang3');

select * from t1;

insert into t1 values (2,'li4'),(3,'wang5'),(4,'ma6');

# 向指定列 插入

insert into t1(name) values ('xyz');

• 修改数据

update t1 set name='zhang33' ; --会更新表中所有行的name字段,比较危险。

update t1 set name='zhang55' where id=1;

--update在使用时一般都会有where条件去限制。

update test set id= where name='kaka';

练习:把ID为2的名字改为bingbing.

• 防止不加条件误删:

mysql -U

update test set name='lanlan';

ERROR (HY000): You are using safe update mode

and you tried to update a table without a WHERE that uses a KEY column

至于防止误操作导致上述数据库故障案例的方法之一,

请参见http://oldboy.blog.51cto.com/2561410/1321061

• 删除(delete)

delete from test; #逻辑删除,一行一行删。 删除所有

delete from t1 where id=2; 删除指定数据

truncate table test; #物理删除,pages(block),效率高。 DDL操作

• 案例:不删除,而是伪删除。添加字段state,改变字段的值实现伪删除

alter table test add state tinyint() not null default ;

update test set state=;

正常显示:

select * from test where id=;

update test set state= where name='oldboy';

• DQL

开发环境准备

- 导入world.sql

- 应用脚本

登陆mysql

mysql> source /server/tools/world.sql

show databases;

mysql> show databases;

+--------------------+

| Database |

+--------------------+

| information_schema |

| mysql |

| performance_schema |

| world |

+--------------------+

4 rows in set (0.00 sec)

- 创建用户(能远程链接的用户),使用sqlyog(有联想功能)登陆数据库

- create user root@'10.0.0.%' identified '123';

- grant all on *.* to 'root'@'10.0.0.%'

select 的基本格式

• 查询表中的数据

命令语法:select <字段1,字段2,...> from < 表名 > where < 表达式 > and < 表达式 >。

其中,select、from、where是不能随便改的,是关键字,支持大小写。

select <字段1,字段2,...> from < 表名 > where < 表达式 >

select user,host,password from mysql.user;

select * from oldboy.test;

select id,name from oldboy.test;

select id,name from test where id=;

select id,name from test where name='oldgirl';

select id,name from test where id>;

select id,name from test where id> and id<;

select id,name from test where id> or id<;

select id,name from test;

select id,name from test order by id asc;

select id,name from test order by id desc;

select id,name from test limit ,; help select;

查询select语法详解

• 基本语法

SELECT *|{[DISTINCT] column|select_expr [alias], ...]}

[FROM [database.]table]

[WHERE conditions];

• WHERE条件又叫做过滤条件,它从FROM子句的中间结果中去掉所有

条件conditions不为TRUE(而为FALSE或者NULL)的行

• WHERE子句跟在FROM子句后面

• 不能在WHERE子句中使用列别名

• 例1:where字句的基本使用

SELECT * FROM world.`city` WHERE CountryCode='CHN';

or

SELECT * FROM world.`city` WHERE CountryCode='chn';

注意: WHERE中出现的字符串和日期字面量必须使用引号括起来

这里,字符串字面量写成大写或小写结果都一样,即不区分大小写进行查询。

这和ORACLE不同,ORACLE中WHERE条件中的字面量是区分大小写的

• 例2:where字句中的逻辑操作符:

SELECT * FROM world.`city` WHERE CountryCode='chn' AND district = 'anhui';

• 逻辑操作符介绍:

– and 逻辑与。只有当所有的子条件都为true时,and才返回true。否则返回false或null

– or 逻辑或。只要有一个子条件为true,or就返回true。否则返回false或null

– not 逻辑非。如果子条件为true,则返回false;如果子条件为false,则返回true

– xor 逻辑异或。当一个子条件为true而另一个子条件为false时,其结果为true;

当两个条件都为true或都为false时,结果为false。否则,结果为null

• 例3 :where字句中的范围比较:

SELECT * FROM world.`city` WHERE population BETWEEN AND ;

• 例4:where字句中的IN

SELECT * FROM city WHERE countrycode IN ('CHN','JPN');

• 例5:where字句中的like

– 语法:

like ‘匹配模式字符串’

– 实现模式匹配查询或者模糊查询:

测试一个列值是否匹配给出的模式

– 在‘匹配模式字符串’中,可以有两个具有特殊含义的通配字符:

%:表示0个或者任意多个字符

_:只表示一个任意字符

SELECT * FROM city WHERE countrycode LIKE 'ch%';

• ORDER BY子句用来排序行

• 如果SELECT语句中没有ORDER BY子句,

那么结果集中行的顺序是 不可预料的

• 语法: SELECT expr

FROM table

[WHERE condition(s)]

[ORDER BY {column, expr, numeric_position} [Asc|DEsc]];

• 其中:

– Asc:执行升序排序。默认值

– DEsc:执行降序排序

– ORDER BY子句一般在SELECT语句的最后面

• 例1: 基本使用

SELECT * FROM city ORDER BY population;

• 例2:多个排序条件

SELECT * FROM city ORDER BY population,countrycode;

• 例3:以select字句列编号排序

SELECT * FROM city ORDER BY ;

• 例4:desc asc

SELECT * FROM city ORDER BY desc;

• 例5:NULL值的排序 在MySQL中,把NULL值当做一列值中的最小值对待。

因此,升序排序时,它出现在最前面

LIMIT

• MySQL特有的子句。

• 它是SELECT语句中的最后一个子句(在order by后面)。

• 它用来表示从结果集中选取最前面或最后面的几行。

• 偏移量offset的最小值为0。

• 语法: limit <获取的行数> [OFFSET <跳过的行数>]

或者 limit [<跳过的行数>,] <获取的行数>

SELECT * FROM city ORDER BY DEsc LIMIT ;

注:先按照人口数量进行降序排序,然后使用 limit 从中挑出最前面的 行。

如果没有 order by 子句,返回的 行就是不可预料的。

• 传统的连接写法(使用where)

SELECT NAME,ci.countrycode ,cl.language ,ci.population

FROM city ci , countrylanguage cl WHERE ci.`CountryCode`=cl.countrycode;

注意:一旦给表定义了别名,那么原始的表名就不能在出现在该语句 的其它子句中了

• NATURAL JOIN子句

• 自动到两张表中查找所有同名同类型的列拿来做连接列,进行相等

连接 SELECT NAME,countrycode ,LANGUAGE ,population

FROM city NATURAL JOIN countrylanguage WHERE population >

ORDER BY population;

注意:在 select 子句只能出现一个连接列

• 使用using子句

SELECT NAME,countrycode ,LANGUAGE ,population

FROM city JOIN countrylanguage USING(countrycode);

• UNION [DISTINCT]

• UNION ALL

• 语法:

SELECT ...

UNION [ALL | DISTINCT]

SELECT ...

[UNION [ALL | DISTINCT]

SELECT ...]

• UNION用于把两个或者多个select查询的结果集合并成一个

• 进行合并的两个查询,其SELECT列表必须在数量和对应列的数据类型上保持一致

• 默认会去掉两个查询结果集中的重复行

• 默认结果集不排序

• 最终结果集的列名来自于第一个查询的SELECT列表

• “Group By”从字面意义上理解就是根据“By”指定的规则对数据进行分组,

所谓的分组就是将一个“数据集”划分成若干个“小区域”,然后针对若干个 “小区域”进行数据处理。

• Having与Where的区别

– where 子句的作用是在对查询结果进行分组前,将不符合where条件的行去掉,

即在分组之前过滤数据,where条件中不能包含聚组函数,使用where条件过滤出特定的行。

– having 子句的作用是筛选满足条件的组,即在分组之后过滤数据,

条件中经常包含聚 组函数,使用having 条件过滤出特定的组,也可以使用多个分组标准进行分组。

• 子查询定义

– 在一个表表达中可以调用另一个表表达式,这个被调用的表表达式叫做子查询( subquery),

我么也称作子选择(subselect)或内嵌选择(inner select)。

子查询 的结果传递给调用它的表表达式继续处理。

– 子查询(inner query)先执行,然后执行主查询(outer query)

– 子查询按对返回结果集的调用方法,可分为:where型子查询,from型子查询及exists 型子查询。

• 使用子查询原则

– 一个子查询必须放在圆括号中。

– 将子查询放在比较条件的右边以增加可读性。

子查询不包含 ORDER BY 子句。对一个 SELECT 语句只能用一个 ORDER BY 子句,并且

如果指定了它就必须放在主 SELECT 语句的最后。

– 在子查询中可以使用两种比较条件:

单行运算符(>, =, >=, <, <>, <=) 和多行运算符 (IN, ANY, ALL)。

查询select案例详解

查询之前,先看一下表的结构

DESC world.city

SELECT id ,NAME FROM world.city;

SELECT * FROM world.`city`;

-- select 条件查询 where

注意: WHERE中出现的字符串和日期字面量必须使用引号括起来

这里,字符串字面量写成大写或小写结果都一样,即不区分大小写进行查询。

这和ORACLE不同,ORACLE中WHERE条件中的字面量是区分大小写的

---- 、查询中国(CHN)所有的城市信息

SELECT * FROM world.`city` WHERE countrycode='CHN';

---- 、查询中国(CHN)安徽省所有的城市信息。 AND

SELECT * FROM world.`city`

WHERE countrycode='CHN'

AND

district='anhui'; ---- 、查询世界上人口数量在10w-20w城市信息 BETWEEN AND

SELECT * FROM world.`city`

WHERE

population BETWEEN AND ; ---- 、中国或者日本的所有城市信息 IN

where字句中的IN

SELECT * FROM world.city

WHERE countrycode IN ('CHN','JPN'); ---- 、模糊查询 LIKE

SELECT * FROM world.city

WHERE countrycode LIKE 'ch%'; -- select 排序并限制 ORDER BY

---- 按照人口数量排序输出中国的城市信息(ASC\DESC)

ASC 升序 DESC 降序

order by 字句一般在select语句的后面

SELECT * FROM world.`city` WHERE countrycode='CHN' ORDER BY population ASC;

SELECT * FROM world.`city` WHERE countrycode='CHN' ORDER BY population DESC; ---- 按照多列排序人口+省排序

SELECT * FROM world.`city` WHERE countrycode='CHN'

ORDER BY Population,District DESC; 多个条件用,分割,

---出现的效果是,按照最后一个排序,但有时候也不是按照最后一个,会出现意想不到的效果

---一般排序时,最好还是使用单列

SELECT * FROM world.`city` WHERE countrycode='CHN'

ORDER BY id DESC ;

---安装列所在位置,排序

SELECT * FROM city

ORDER BY DESC ; ---就是按照第5列population

--- NULL值的排序,在MySQL中,把NULL值当做一列的最小值

-10 LIMIT

SELECT * FROM world.`city` WHERE countrycode='CHN'

ORDER BY DESC LIMIT ; -

SELECT * FROM world.`city` WHERE countrycode='CHN'

ORDER BY DESC LIMIT , ;

--相当于

SELECT * FROM world.`city` WHERE countrycode='CHN'

ORDER BY DESC LIMIT OFFSET ;

-- 表连接查询 DESC city

DESC countrylanguage 传统的连接写法(使用where)

---- 中国所有城市信息+使用语言(city+countrylanguage)

--1、从city中显示城市名

SELECT NAME ,countrycode ,population FROM city WHERE countrycode ='CHN'

--2、从countrycode中显示语言

SELECT countrycode ,LANGUAGE FROM countrylanguage;

--3、连表

SELECT ci.NAME ,ci.countrycode ,ci.population,cl.language

FROM

city AS ci , countrylanguage AS cl

WHERE ci.countrycode ='CHN'

AND

ci.CountryCode=cl.CountryCode;

-- name 可以直接使用,

SELECT NAME,ci.countrycode ,cl.language ,ci.population

FROM city ci , countrylanguage cl

WHERE

ci.countrycode='chn' AND

ci.`CountryCode`=cl.countrycode;

-- 使用NATURAL JOIN

SELECT NAME,countrycode ,LANGUAGE ,population

FROM city NATURAL JOIN countrylanguage

WHERE population >

ORDER BY population;

-- 使用JOIN USING

SELECT NAME,countrycode ,LANGUAGE ,population

FROM city JOIN countrylanguage

USING(countrycode);

NATURAL JOIN 和 JOIN USING 都不常用

---- 查询青岛这个城市,所在的国家具体叫什么名字 使用 JOIN ON

DESC city

DESC country

--1、查看青岛

SELECT NAME,countrycode FROM city WHERE NAME='qingdao';

--2、查看中国城市名

SELECT NAME FROM country WHERE CODE='CHN';

--3、连表

--------------------------------

SELECT ci.name ,ci.countrycode,ci.population ,co.name

FROM city AS ci

JOIN

country AS co

ON ci.countrycode=co.code

AND

ci.name='qingdao';

---------------------------------

group by +聚合函数(avg()、max()、min()、sum()) SELECT countrycode ,SUM(population) FROM city

WHERE countrycode = 'chn'

GROUP BY countrycode; union 用来替换 or 、in() 性能更好些 SELECT * FROM world.city

WHERE countrycode IN ('CHN','JPN');

改写为:

SELECT * FROM world.city

WHERE countrycode ='CHN'

union

SELECT * FROM world.city

WHERE countrycode ='JPN'; 两个SQL需要是相同的结

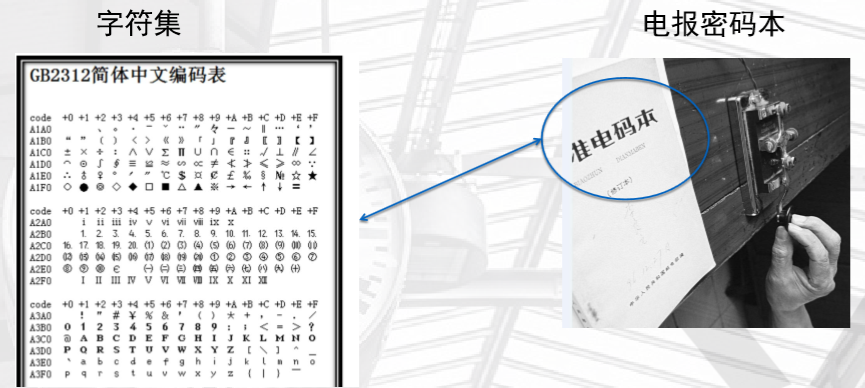

5、SQL字符集

尤其是在进行数据库迁移的时候,一定要注意字符集

• 字符集(Charset):

是一个系统支持的所有抽象字符的集合。

字符是各种文字和符号的总称, 包括各国家文字、标点符号、图形符号、数字等。

• MySQL数据库的字符集:

– 字符集(CHARACTER)

– 校对规则(COLLATION)

• MySQL中常见的字符集:

– UTF8 ,utf8mb4

– LATIN1 编译默认的,开发者的母语

– GBK

• 常见校对规则: 即排序规则

– ci:大小写不敏感 aA-zZ

– cs或bin:大小写敏感 a-z A-Z

• 我们可以使用以下命令查看:

– show charset;

– show collation;

字符集的级别

• 操作系统级别

控制的是系统相关的显示,和一些依赖于操作系统的应用

source /etc/sysconfig/i18n

[root@db02 logs]# echo $LANG

zh_CN.UTF-8

• 操作系统客户端级别(SSH)

控制的是用户的输入和展示

• 服务端字符集

控制的是,存到mysql中时,字符集控制

• MySQL实例级别

– 方法1:在编译安装时候就指定如下服务器端字符集。

cmake .

-DDEFAULT_CHARSET=utf8 \

-DDEFAULT_COLLATION=utf8_general_ci \

-DWITH_EXTRA_CHARSETS=all \

– 方法2:

[mysqld] character-set-server=utf8 • 数据库中的库级别

CREATE DATABASE `oldboy` /*!40100 DEFAULT CHARACTER SET utf8 */

create database oldboy DEFAULT CHARACTER SET UTF8 DEFAULT COLLATE

= utf8_general_ci;

• 获取帮助并查询

help create database;

show character set;

• 表级别(含字段级别)

CREATE TABLE `test` (

`id` int(4) NOT NULL AUTO_INCREMENT,

`name` char(20) NOT NULL,

PRIMARY KEY (`id`)

) ENGINE=InnoDB AUTO_INCREMENT=13 DEFAULT CHARSET=utf8

• MySQL客户端级别(连接及返回结果)

方法1:临时生效单条命令法。

mysql> set names utf8;

Query OK, 0 rows affected (0.00 sec)

方法2:通过修改my.cnf实现修改mysql客户端的字符集,配置方法如下。

[client]

default-character-set=utf8

• 程序代码级别

• 生产环境更改数据库(含数据)字符集的方法

alter database oldboy CHARACTER SET utf8 collate

utf8_general_ci;

alter table t1 CHARACTER SET latin1;

注意:更改字符集时,一定要保证由小往大改,后者必须是前者的严格超集。

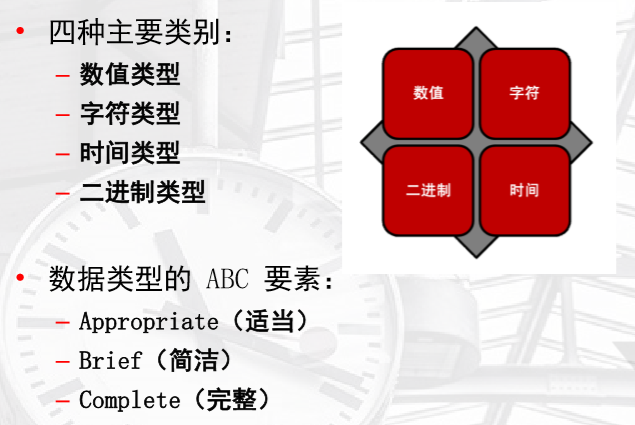

6、数据类型介绍

• 数据类型介绍

• 数据类型设置

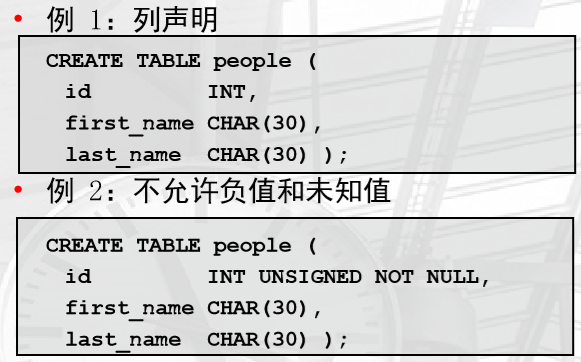

创建带有数据类型的表

数值数据类型

注意事项:

- 数据类型所表示的值的范围

- 列值所需的空间量

- 列精度和范围(浮点数和定点数)

种类:

- 整数:整数

- 浮点数:小数

- 定点数:精确值数值

- BIT:位字段值

字符串数据类型

- 表示给定字符集中的一个字母数字字符序列

- 用于存储文本或二进制数据

- 几乎在每种编程语言中都有实现

- 支持字符集和整理

- 属于以下其中一类

- 文本:真实的非结构化字符串数据类型

- 整数:结构化字符串类型

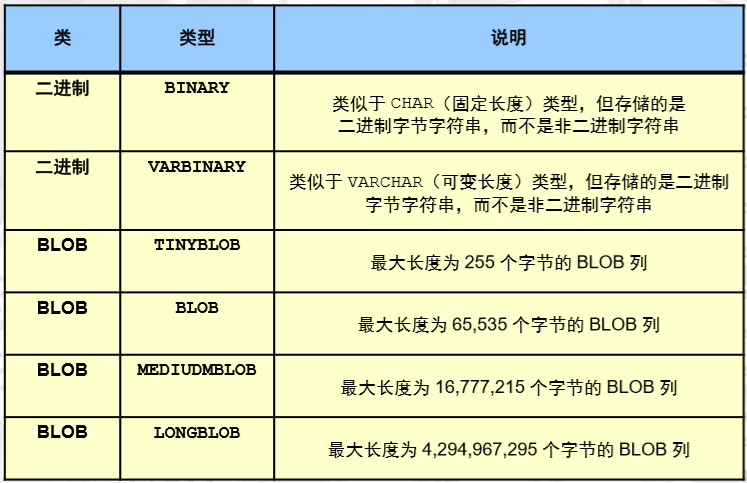

二进制字符串数据类型

- 字节序列

- 二进制位按八位分组

- 存储二进制值,例如:

- 编译的计算机程序和应用程序

- 图像和声音文件

- 字符二进制数据类型的类:

- 二进制:固定长度和可变长度的二进制字符串

- – BLOB:二进制数据的可变长度非结构化集合

时间数据类型

常用的是datetime和timestamp

• 列属性

列属性的类别:

- 数值:适用于数值数据类型(BIT 除外)

- 字符串:适用于非二进制字符串数据类型

- 常规:适用于所有数据类型

primary key:主键:非空、唯一

unique:唯一

• 数据类型的字符集用法

• 选择适当的数据类型

• 考虑哪些数据类型和字符集可以最大限度地减少存储和磁盘 I/O。

• 使用固定长度数据类型:

– 如果存储的所有字符串值的长度相同

• 使用可变长度数据类型:

– 如果存储的字符串值不同

– 对于多字节字符集

• 对于频繁使用的字符,使用占用空间较少的多字节字符集。

– 使用基本多文种平面 (Basic Multilingual Plane, BMP) 之外的其他 Unicode 字符集

7、元数据获取-INFORMATION_SCHEMA数据库介绍

INFORMATION_SCHEMA,通过这个库提供的一些视图,我们可以非常轻松的去获取

对于数据库的,统计信息。我们也把这些叫做元数据

对于数据库,两个信息

- 数据行:我们使用DDL、DCL、DQL操作的数据

- 元数据:定义数据的数据

- 库的名字、属性

- 表名、属性

- 库状态,表状态...

• 元数据访问方式介绍

• 查询 INFORMATION_SCHEMA 数据库表。

– 其中包含 MySQL 数据库服务器所管理的所有对象的相关数据

• 使用 SHOW 语句。

– 用于获取数据库和表信息的 MySQL 专用语句

• 使用 DESCRIBE(或 DESC)语句。

– 用于检查表结构和列属性的快捷方式

• 使用 mysqlshow 客户端程序。

– SHOW 语法的命令行程序

• INFORMATION_SCHEMA 数据库的结构

• 充当数据库元数据的中央系统信息库

– 模式和模式对象

– 服务器统计信息(状态变量、设置、连接)

• 采用表格式以实现灵活访问

– 使用任意 SELECT 语句

• 是“虚拟数据库”

– 表并非“真实”表(基表),而是“系统视图”

– 根据当前用户的特权动态填充表

INFORMATION_SCHEMA 表

列出 INFORMATION_SCHEMA 数据库中所有的表:

mysql> use information_schema

mysql> show tables;

| CHARACTER_SETS |

| COLLATIONS |

| COLLATION_CHARACTER_SET_APPLICABILITY |

| COLUMNS |

| COLUMN_PRIVILEGES |

...

| USER_PRIVILEGES |

| VIEWS

查看数据库一共有多少张表

查看元数据中的表的元数据

mysql> desc tables;

+-----------------+---------------------+------+-----+---------+-------+

| Field | Type | Null | Key | Default | Extra |

+-----------------+---------------------+------+-----+---------+-------+

| TABLE_CATALOG | varchar() | NO | | | |

| TABLE_SCHEMA | varchar() | NO | | | |

| TABLE_NAME | varchar() | NO | | | |

| TABLE_TYPE | varchar() | NO | | | |

| ENGINE | varchar() | YES | | NULL | |

| VERSION | bigint() unsigned | YES | | NULL | |

| ROW_FORMAT | varchar() | YES | | NULL | |

| TABLE_ROWS | bigint() unsigned | YES | | NULL | |

| AVG_ROW_LENGTH | bigint() unsigned | YES | | NULL | |

| DATA_LENGTH | bigint() unsigned | YES | | NULL | |

| MAX_DATA_LENGTH | bigint() unsigned | YES | | NULL | |

| INDEX_LENGTH | bigint() unsigned | YES | | NULL | |

| DATA_FREE | bigint() unsigned | YES | | NULL | |

| AUTO_INCREMENT | bigint() unsigned | YES | | NULL | |

| CREATE_TIME | datetime | YES | | NULL | |

| UPDATE_TIME | datetime | YES | | NULL | |

| CHECK_TIME | datetime | YES | | NULL | |

| TABLE_COLLATION | varchar() | YES | | NULL | |

| CHECKSUM | bigint() unsigned | YES | | NULL | |

| CREATE_OPTIONS | varchar() | YES | | NULL | |

| TABLE_COMMENT | varchar() | NO | | | |

+-----------------+---------------------+------+-----+---------+-------+

rows in set (0.00 sec)

查看数据库一共有多少张表

mysql> select count(TABLE_NAME) from tables;

+-------------------+

| count(TABLE_NAME) |

+-------------------+

| |

+-------------------+

row in set (0.01 sec)

• 使用可用命令查看元数据

对 INFORMATION_SCHEMA 使用 SELECT

• 指定要检索哪个表和哪些列。

• 通过使用 WHERE 子句,可仅检索特定条件。

• 对结果分组或排序。

• 使用 JOIN、UNION 和子查询。

• 将结果检索到其他表中。

• 基于 INFORMATION_SCHEMA 表创建视图

例子:

查看world库下的所有表的表名,引擎

mysql> SELECT TABLE_NAME, ENGINE

-> FROM INFORMATION_SCHEMA.TABLES

-> WHERE TABLE_SCHEMA = 'world';

mysql> SELECT TABLE_SCHEMA, TABLE_NAME, COLUMN_NAME

-> FROM INFORMATION_SCHEMA.COLUMNS

-> WHERE DATA_TYPE = 'set';

mysql> SELECT CHARACTER_SET_NAME, COLLATION_NAME

-> FROM INFORMATION_SCHEMA.COLLATIONS

-> WHERE IS_DEFAULT = 'Yes';

每个库下面的表数量的统计

mysql> SELECT TABLE_SCHEMA, COUNT(*)

-> FROM INFORMATION_SCHEMA.TABLES

-> GROUP BY TABLE_SCHEMA;

只能查询

mysql> DELETE FROM INFORMATION_SCHEMA.VIEWS;

ERROR (): Access denied for user

'root'@'localhost' to database 'information_schema'

• SHOW 语句和 INFORMATION_SCHEMA 表之间的区别

show是基于information_schema表提前做好的视图函数

show语句

• SOHW databases:列出所有数据库

• SHOW TABLES:列出默认数据库中的表

• SHOW TABLES FROM <database_name>:列出指定数据库中的表

• SHOW COLUMNS FROM <table_name>:显示表的列结构

• SHOW INDEX FROM <table_name>:显示表中有关索引和索引列的信息

• SHOW CHARACTER SET:显示可用的字符集及其默认整理

• SHOW COLLATION:显示每个字符集的整理

• SHOW STATUS:列出当前数据库状态

• SHOW VARIABLES:列出数据库中的参数定义值

上面的命令重点掌握

配合模糊查询得到我们需要的信息

mysql> show status like '%lock%';

+------------------------------------------+-------+

| Variable_name | Value |

+------------------------------------------+-------+

| Com_lock_tables | |

| Com_unlock_tables | |

| Handler_external_lock | |

| Innodb_row_lock_current_waits | |

| Innodb_row_lock_time | |

| Innodb_row_lock_time_avg | |

| Innodb_row_lock_time_max | |

| Innodb_row_lock_waits | |

| Key_blocks_not_flushed | |

| Key_blocks_unused | |

| Key_blocks_used | |

| Performance_schema_locker_lost | |

| Performance_schema_rwlock_classes_lost | |

| Performance_schema_rwlock_instances_lost | |

| Qcache_free_blocks | |

| Qcache_total_blocks | |

| Table_locks_immediate | |

| Table_locks_waited | |

+------------------------------------------+-------+

rows in set (0.00 sec)

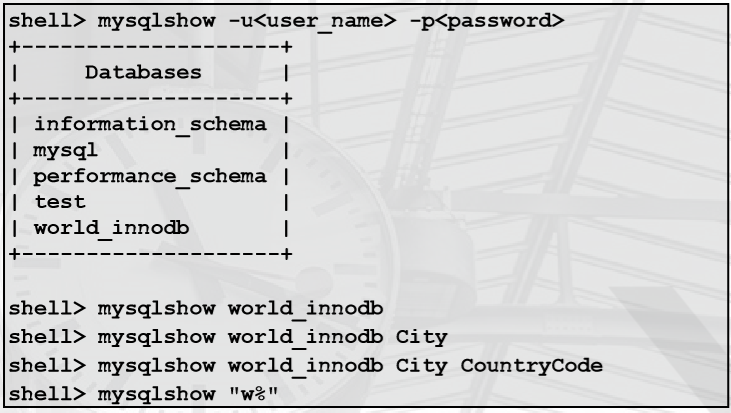

• mysqlshow 客户端工具使用

显示有关数据库和表的结构的信息

– 与 SHOW 语句相似

一般语法:

shell> mysqlshow [options] [db_name [table_name [column_name]]]

选项可以是标准连接参数。

显示所有数据库或特定数据库、表和/或列的相关信息:

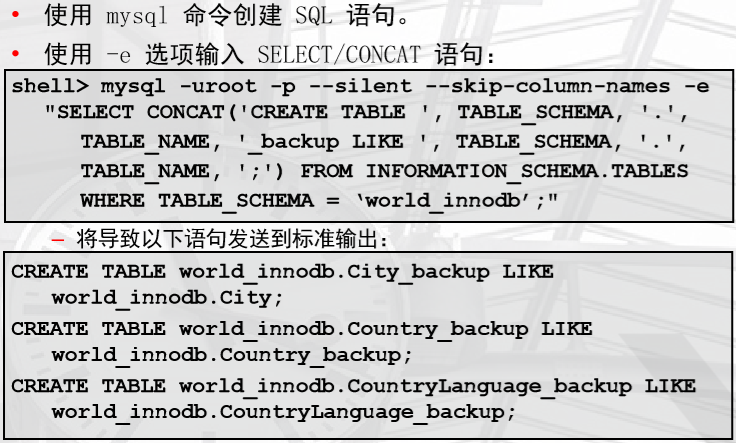

• 使用 INFORMATION_SCHEMA 表创建 shell 命令和 SQL 语句

使用 INFORMATION_SCHEMA 表创建 SQL 语句

使用 INFORMATION_SCHEMA 表创建 Shell 命令

备份的普通写法:mysqldump -uroot -ppizza123 world country >> /backup/world.bak.sql

如果有100条,要写100次

可以在NFORMATION_SCHEMA中查到world下的所有表

select table_schema,country from tables where table schema='world';

请按照下面的例子,按照需求拼接上面的命令并输出到文件

注意:空格也是要标识出来的

8、索引管理及执行计划

索引类型介绍

- BTREE:B+树索引 ------>重点和常用

- HASH:HASH索引

- FULLTEXT:全文索引

- RTREE:R树索引

索引管理

- 索引建立在表的列上(字段)的。

- 在where后面的列建立索引才会加快查询速度。

- pages<---索引(属性)<----查数据。

- 索引分类:

- 主键索引 开发前就决定了

- 普通索引*****

- 唯一索引 开发前就决定了

- 添加索引:

- alter table test add index index_name(name);

- create index index_name on test(name);

查询索引信息

mysql> desc test;

+-------+------------+------+-----+---------+----------------+

| Field | Type | Null | Key | Default | Extra |

+-------+------------+------+-----+---------+----------------+

| id | int(11) | NO | PRI | NULL | auto_increment |

| name | char(20) | NO | MUL | NULL | |

| state | tinyint(2) | NO | | 1 | |

+-------+------------+------+-----+---------+----------------+

3 rows in set (0.00 sec)

删除索引

mysql> alter table test drop index index_name;

Query OK, rows affected (0.20 sec)

Records: Duplicates: Warnings: mysql> desc test;

+-------+------------+------+-----+---------+----------------+

| Field | Type | Null | Key | Default | Extra |

+-------+------------+------+-----+---------+----------------+

| id | int() | NO | PRI | NULL | auto_increment |

| name | char() | NO | | NULL | |

| state | tinyint() | NO | | | |

+-------+------------+------+-----+---------+----------------+

rows in set (0.00 sec)

或者drop index index_name on test;

查询

desc test;

或

show index from test\G

MySQL中的约束索引

、主键索引:只能有一个主键。

主键索引:列的内容是唯一值,高中学号.

表创建的时候至少要有一个主键索引,最好和业务无关。

走主键索引的查询效率是最高的

、普通索引

加快查询速度,工作中优化数据库的关键。

在合适的列上建立索引,让数据查询更高效。

create index index_name on test(name);

alter table test add index index_name(name);

用了索引,查一堆内容。

在where条件关键字后面的列建立索引才会加快查询速度.

select id,name from test where state= order by id group by name;

、唯一索引

内容唯一,但不是主键。

create unique index index_name on test(name);

创建主键索引

.建立表时

CREATE TABLE `test` (

`id` int() NOT NULL AUTO_INCREMENT,

`name` char() NOT NULL,

PRIMARY KEY (`id`)

) ENGINE=InnoDB DEFAULT CHARSET=UTF8; .建立表后增加

CREATE TABLE `test` (

`id` int() NOT NULL,

`name` char() NOT NULL

) ENGINE=InnoDB DEFAULT CHARSET=UTF8;

增加自增主键

alter table test change id id int() primary key not null auto_increment;

使用字段前缀创建索引及联合索引

.前缀索引:根据字段的前N个字符建立索引

create index index_name on test(name());

.联合索引:多个字段建立一个索引。

where a女生 and b身高165 and c身材好

index(a,b,c)

特点:前缀生效特性。

a,ab,abc 可以走索引。

b ac bc c 不走索引。

原则:把最常用来作为条件查询的列放在前面。 实例:

alter table test add sex char(4) not null;

create index ind_name_sex on test(name,sex);

explain select id,name from test where name='oldboy'\G

explain select id,name from test where sex='nv'\G

explain select id,name from test where name='oldgirl' and sex='nv'\G 联合主键是联合索引的特殊形式:

PRIMARY KEY (`Host`,`User`)

alter table test add sex char(4) not null;

create index ind_name_sex on test(name,sex);

前缀加联合索引

create index index_name on test(name(8),sex(2));

用expain查看SQL的执行计划

没有索引

mysql> explain select id,name from test where name='pizza'\G

*************************** 1. row ***************************

id: 1

select_type: SIMPLE

table: test

type: ALL 表示MySQL在表中找到所需行的方式,又称“访问类型”

possible_keys: NULL

key: NULL

key_len: NULL 越小越好

ref: NULL

rows: 1

Extra: Using where

1 row in set (0.08 sec)

常见的type

ALL、index、range、ref、eq_ref、const、system、null

从左到右,性能从最差到最好

mysql> alter table test add index index_name(name);

Query OK, 0 rows affected (0.14 sec)

Records: 0 Duplicates: 0 Warnings: 0

有索引

mysql> explain select id,name from test where name='pizza'\G

*************************** 1. row ***************************

id: 1

select_type: SIMPLE

table: test

type: ref

possible_keys: index_name

key: index_name

key_len: 60

ref: const

rows: 1

Extra: Using where; Using index

1 row in set (0.00 sec)

explain select SQL_NO_CACHE * from test where name='oldboy'\G

SQL_NO_CACHE的作用是禁止缓存查询结果。

explain中各type类型的详解

ALL:

Full Table Scan, MySQL将遍历全表以找到匹配的行 如果显示ALL,说明:

查询没有走索引:

1、语句本身的问题

2、索引的问题,没建立索引 index:

Full Index Scan,index与ALL区别为index类型只遍历索引树

例子:

explain select count(*) from stu ; range:

索引范围扫描,对索引的扫描开始于某一点,返回匹配值域的行。

显而易见的索引范围扫描是带有between或者where子句里带有<,>查询。

where 条件中有范围查询或模糊查询时

> < >= <= between and in () or

like 'xx%'

当mysql使用索引去查找一系列值时,例如IN()和OR列表,也会显示range(范围扫描)

当然性能上面是有差异的。 ref:

使用非唯一索引扫描或者唯一索引的前缀扫描,返回匹配某个单独值的记录行

where stu_name='xiaoming'

explain select * from stu where stu_name='aa'; eq_ref:

类似ref,区别就在使用的索引是唯一索引,对于每个索引键值,表中只有一条记录匹配,简单来说,

就是多表连接中使用primary key或者 unique key作为关联条件

join条件使用的是primary key或者 unique key const、system:

当MySQL对查询某部分进行优化,并转换为一个常量时,使用这些类型访问。

如将主键置于where列表中,MySQL就能将该查询转换为一个常量

explain select * from city where id=1; NULL:

MySQL在优化过程中分解语句,执行时甚至不用访问表或索引,

例如从一个索引列里选取最小值可以通过单独索引查找完成。

或者走的缓存中已经存在的

explain中的Extra

避免出现

Using temporary

Using filesort

Using join buffer

出现的原因是:

排序 order by ,group by ,distinct,排序条件上没有索引

explain select * from city where countrycode='CHN' order by population;

解决办法:

在join 的条件列上没有建立索引

将前一个结果保存为视图,再排序

数据库索引的设计原则

为了使索引的使用效率更高,在创建索引时

必须考虑在哪些字段上创建索引和创建什么类型的索引。

那么索引设计原则又是怎样的? .选择唯一性索引

唯一性索引的值是唯一的,可以更快速的通过该索引来确定某条记录。

例如,学生表中学号是具有唯一性的字段。为该字段建立唯一性索引可以很快的确定某个学生的信息。

如果使用姓名的话,可能存在同名现象,从而降低查询速度。 主键索引和唯一键索引,在查询中使用是效率最高的 .为经常需要排序、分组和联合操作的字段建立索引

经常需要ORDER BY、GROUP BY、DISTINCT和UNION等操作的字段,排序操作会浪费很多时间。

如果为其建立索引,可以有效地避免排序操作。 .为常作为查询条件的字段建立索引

如果某个字段经常用来做查询条件,那么该字段的查询速度会影响整个表的查询速度。因此,

为这样的字段建立索引,可以提高整个表的查询速度。

但是,是不是真的适合去做索引,还要去统计一下这个列,去重之后的数量

和总行数对比,占的数量太小,比如性别,就不合适作为索引列

select count(DISTINCT population ) from city;

select count(*) from city; .尽量使用前缀来索引

如果索引字段的值很长,最好使用值的前缀来索引。例如,TEXT和BLOG类型的字段,进行全文检索

会很浪费时间。如果只检索字段的前面的若干个字符,这样可以提高检索速度。 ------------------------以上的是重点关注的,以下是能保证则保证的--------------------

.限制索引的数目

索引的数目不是越多越好。每个索引都需要占用磁盘空间,索引越多,需要的磁盘空间就越大。

修改表时,对索引的重构和更新很麻烦。越多的索引,会使更新表变得很浪费时间。 .尽量使用数据量少的索引

如果索引的值很长,那么查询的速度会受到影响。例如,对一个CHAR()类型的字段进行全文

检索需要的时间肯定要比对CHAR()类型的字段需要的时间要多。 .删除不再使用或者很少使用的索引

表中的数据被大量更新,或者数据的使用方式被改变后,原有的一些索引可能不再需要。数据库管理

员应当定期找出这些索引,将它们删除,从而减少索引对更新操作的影响。 ------------------------------二、开发规范----------------------------------------- 不走索引的情况:

重点关注:

) 没有查询条件,或者查询条件没有建立索引 select * from tab; 全表扫描。

select * from tab where =; 在业务数据库中,特别是数据量比较大的表。

是没有全表扫描这种需求。 、对用户查看是非常痛苦的。

、对服务器来讲毁灭性的。 ()select * from tab;

SQL改写成以下语句:

selec * from tab order by price limit 需要在price列上建立索引

()

select * from tab where name='zhangsan' name列没有索引 改:

、换成有索引的列作为查询条件

、将name列建立索引 ) 查询结果集是原表中的大部分数据,应该是30%以上。 查询的结果集,超过了总数行数30%,优化器觉得就没有必要走索引了。

假如:tab表 id,name id:-100w ,id列有索引

select * from tab where id>; 如果业务允许,可以使用limit控制。

怎么改写 ?

结合业务判断,有没有更好的方式。如果没有更好的改写方案

尽量不要在mysql存放这个数据了。放到redis里面。 ) 索引本身失效,统计数据不真实

索引有自我维护的能力。

对于表内容变化比较频繁的情况下,有可能会出现索引失效。 ) 查询条件使用函数在索引列上,或者对索引列进行运算,运算包括(+,-,*,/,! 等)

例子:

错误的例子:select * from test where id-=;

正确的例子:select * from test where id=; )隐式转换导致索引失效.这一点应当引起重视.也是开发中经常会犯的错误.

由于表的字段tu_mdn定义为varchar2(),但在查询时把该字段作为number类型以where条件传给数据库,

这样会导致索引失效. 错误的例子:select * from test where tu_mdn=;

正确的例子:select * from test where tu_mdn='';

------------------------

mysql> alter table tab add index inx_tel(telnum);

Query OK, rows affected (0.03 sec)

Records: Duplicates: Warnings:

mysql>

mysql> desc tab;

+--------+-------------+------+-----+---------+-------+

| Field | Type | Null | Key | Default | Extra |

+--------+-------------+------+-----+---------+-------+

| id | int() | YES | | NULL | |

| name | varchar() | YES | | NULL | |

| telnum | varchar() | YES | MUL | NULL | |

+--------+-------------+------+-----+---------+-------+

rows in set (0.01 sec) mysql> select * from tab where telnum='';

+------+------+---------+

| id | name | telnum |

+------+------+---------+

| | a | |

+------+------+---------+

row in set (0.00 sec) mysql> select * from tab where telnum=;

+------+------+---------+

| id | name | telnum |

+------+------+---------+

| | a | |

+------+------+---------+

row in set (0.00 sec) mysql> explain select * from tab where telnum='';

+----+-------------+-------+------+---------------+---------+---------+-------+------+-----------------------+

| id | select_type | table | type | possible_keys | key | key_len | ref | rows | Extra |

+----+-------------+-------+------+---------------+---------+---------+-------+------+-----------------------+

| | SIMPLE | tab | ref | inx_tel | inx_tel | | const | | Using index condition |

+----+-------------+-------+------+---------------+---------+---------+-------+------+-----------------------+

row in set (0.00 sec) mysql> explain select * from tab where telnum=;

+----+-------------+-------+------+---------------+------+---------+------+------+-------------+

| id | select_type | table | type | possible_keys | key | key_len | ref | rows | Extra |

+----+-------------+-------+------+---------------+------+---------+------+------+-------------+

| | SIMPLE | tab | ALL | inx_tel | NULL | NULL | NULL | | Using where |

+----+-------------+-------+------+---------------+------+---------+------+------+-------------+

row in set (0.00 sec) mysql> explain select * from tab where telnum=;

+----+-------------+-------+------+---------------+------+---------+------+------+-------------+

| id | select_type | table | type | possible_keys | key | key_len | ref | rows | Extra |

+----+-------------+-------+------+---------------+------+---------+------+------+-------------+

| | SIMPLE | tab | ALL | inx_tel | NULL | NULL | NULL | | Using where |

+----+-------------+-------+------+---------------+------+---------+------+------+-------------+

row in set (0.00 sec) mysql> explain select * from tab where telnum='';

+----+-------------+-------+------+---------------+---------+---------+-------+------+-----------------------+

| id | select_type | table | type | possible_keys | key | key_len | ref | rows | Extra |

+----+-------------+-------+------+---------------+---------+---------+-------+------+-----------------------+

| | SIMPLE | tab | ref | inx_tel | inx_tel | | const | | Using index condition |

+----+-------------+-------+------+---------------+---------+---------+-------+------+-----------------------+

row in set (0.00 sec) mysql> ------------------------ )

<> ,not in 不走索引 EXPLAIN SELECT * FROM teltab WHERE telnum <> '';

EXPLAIN SELECT * FROM teltab WHERE telnum NOT IN ('','');

------------

mysql> select * from tab where telnum <> '';

+------+------+---------+

| id | name | telnum |

+------+------+---------+

| | a | |

+------+------+---------+

row in set (0.00 sec) mysql> explain select * from tab where telnum <> '';

-----

单独的>,<,in 有可能走,也有可能不走,和结果集有关,尽量结合业务添加limit

or或in 尽量改成union EXPLAIN SELECT * FROM teltab WHERE telnum IN ('','');

改写成: EXPLAIN SELECT * FROM teltab WHERE telnum=''

UNION ALL

SELECT * FROM teltab WHERE telnum='' -----------------------------------

) like "%_" 百分号在最前面不走 EXPLAIN SELECT * FROM teltab WHERE telnum LIKE '31%' 走range索引扫描

EXPLAIN SELECT * FROM teltab WHERE telnum LIKE '%110' 不走索引

%linux%类的搜索需求,可以使用elasticsearch

%linux培训% ) 单独引用复合索引里非第一位置的索引列.

列子:

复合索引: DROP TABLE t1

CREATE TABLE t1 (id INT,NAME VARCHAR(),age INT ,sex ENUM('m','f'),money INT); ALTER TABLE t1 ADD INDEX t1_idx(money,age,sex);

DESC t1

SHOW INDEX FROM t1

走索引的情况测试:

EXPLAIN SELECT NAME,age,sex,money FROM t1 WHERE money= AND age= AND sex='m';

EXPLAIN SELECT NAME,age,sex,money FROM t1 WHERE money= AND age= ;

EXPLAIN SELECT NAME,age,sex,money FROM t1 WHERE money= AND sex='m'; ----->部分走索引

不走索引的:

EXPLAIN SELECT NAME,age,sex,money FROM t1 WHERE age=

EXPLAIN SELECT NAME,age,sex,money FROM t1 WHERE age= AND sex='m';

EXPLAIN SELECT NAME,age,sex,money FROM t1 WHERE sex='m'; ------------------------------------------------

索引的企业应用场景

企业SQL优化思路:

、把一个大的不使用索引的SQL语句按照功能进行拆分

、长的SQL语句无法使用索引,能不能变成2条短的SQL语句让它分别使用上索引。

、对SQL语句功能的拆分和修改

、减少“烂”SQL

由运维(DBA)和开发交流(确认),共同确定如何改,最终由DBA执行

、制定开发流程 不适合走索引的场景:

、唯一值少的列上不适合建立索引或者建立索引效率低。例如:性别列

、小表可以不建立索引,100条记录。

、对于数据仓库,大量全表扫描的情况,建索引反而会慢 查看表的唯一值数量:

select count(distinct user) from mysql.user;

select count(distinct user,host) from mysql.user; 建索引流程:

、找到慢SQL。

show processlist;

记录慢查询日志。

、explain select句,条件列多。

、查看表的唯一值数量:

select count(distinct user) from mysql.user;

select count(distinct user,host) from mysql.user;

条件列多。可以考虑建立联合索引。

、建立索引(流量低谷)

force index

、拆开语句(和开发)。

、like '%%'不用mysql

9、MySQL的存储引擎

1、存储引擎的介绍

文件系统:

- 操作系统组织和存取数据的一种机制。

- 文件系统是一种软件。

类型:ext2 ,xfs 数据

- 不管使用什么文件系统,数据内容不会变化

- 不同的是,存储空间、大小、速度。

MySQL引擎:

- 可以理解为,MySQL的“文件系统”,只不过功能更加强大。

MySQL引擎功能:

- 除了可以提供基本的存取功能,还有更多功能事务功能、锁定、备份和恢复、优化以及特殊功能。

2、MySQL中的存储引擎分类

MySQL 提供以下存储引擎:

- InnoDB

- MyISAM

InnoDB 和 MyISAM最常用

- MEMORY

- ARCHIVE

- FEDERATED

- EXAMPLE

- BLACKHOLE

- MERGE

- NDBCLUSTER

- CSV

还可以使用第三方存储引擎(TokuDB)。用于zabbix和爬虫的存储,inno操作很有效,压缩性

Innodb功能总览

重点理解:事务、锁定粒度(行)、备份和恢复、自动故障恢复

3、MySQL存储引擎设置

查看

、使用 SELECT 确认会话存储引擎:

SELECT @@default_storage_engine;

查看所有的存储引擎

show engines;

、使用 SHOW 确认每个表的存储引擎:

SHOW CREATE TABLE City\G

SHOW TABLE STATUS LIKE 'CountryLanguage'\G

、使用 INFORMATION_SCHEMA 确认每个表的存储引擎:

SELECT TABLE_NAME, ENGINE

FROM INFORMATION_SCHEMA.TABLES

WHERE TABLE_SCHEMA = 'world'

AND TABLE_SCHEMA = 'world';

+-----------------+--------+

| TABLE_NAME | ENGINE |

+-----------------+--------+

| city | InnoDB |

| country | InnoDB |

| countrylanguage | InnoDB |

| test | InnoDB |

+-----------------+--------+

4、mysql> show variables like '%engine%';

+----------------------------+--------+

| Variable_name | Value |

+----------------------------+--------+

| default_storage_engine | InnoDB |

| default_tmp_storage_engine | InnoDB |

| storage_engine | InnoDB |

+----------------------------+--------+

3 rows in set (0.00 sec) 下列查询语句都对应查询了什么?

show engines;

show create table city;

show table status like 'city'\G

select table_schema,table_name,engine from information_schema.tables where table_schema='world';

select table_schema,table_name,engine from information_schema.tables where table_schema='mysql';

select table_schema,table_name,engine from information_schema.tables where engine='csv';

设置

0、在编译的时候也可以设置

1、在启动配置文件中设置服务器存储引擎:

vim /etc/my.cnf

[mysqld]

default-storage-engine=<Storage Engine>

、使用 SET 命令为当前客户机会话设置:

SET @@storage_engine=<Storage Engine>;

、在 CREATE TABLE 语句指定:

CREATE TABLE t (i INT) ENGINE = <Storage Engine>;

4、MySQL Innodb引擎存储结构

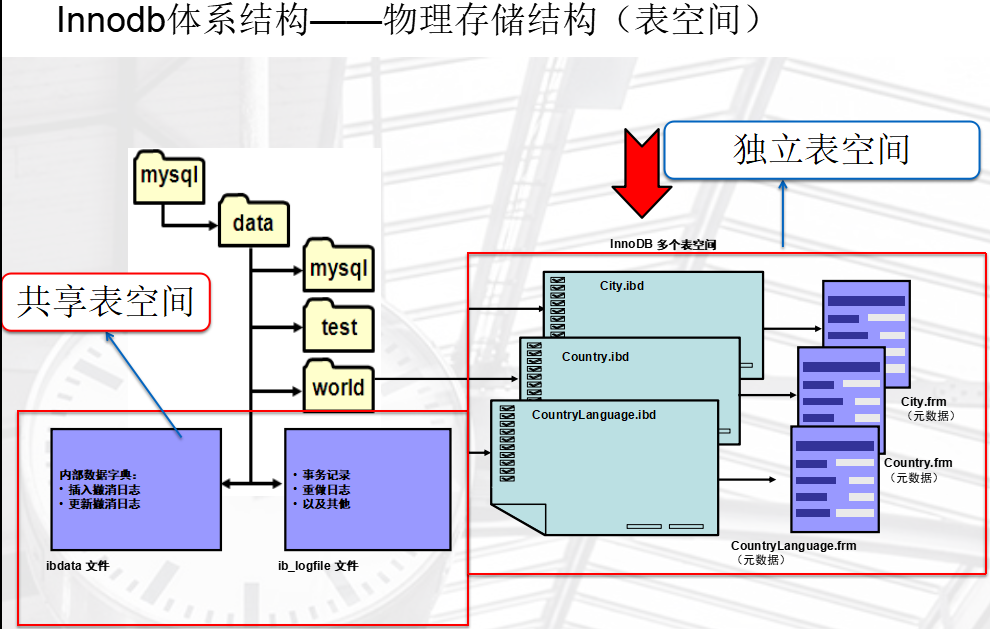

表空间的概念由orcle引入

系统共享表空间

InnoDB 系统表空间

- 默认情况下,InnoDB 元数据、撤消日志和缓冲区存储在系统“表空间”中。

- 这是单个逻辑存储区域,可以包含一个或多个文件。

- 每个文件可以是常规文件或原始分区。

- 最后的文件可以自动扩展。

现在已经不用于生产数据的存储了,只用于存系统文件。

共享表空间设置

通过添加数据文件增加表空间大小。

在 my.cnf 文件中使用 innodb_data_file_path 选项。

[mysqld]

innodb_data_file_path=datafile_spec1[;datafile_spec2]...

配置示例:创建一个表空间,

其中包含一个名为 ibdata1 且大小为 MB(固定)的数据文件和

一个名为 ibdata2 且大小为 MB(自动扩展)的数据文件:

[mysqld]

innodb_data_file_path=ibdata1:50M;ibdata2:50M:autoextend

默认情况下将文件放置在 data 目录中。

如果需要,显式指定文件位置。

innodb_data_file_path=ibdata1:12M;ibdata2:50M:autoextend ----错误的配置XXX

innodb_data_file_path=ibdata1:76M;ibdata2:50M:autoextend ----正确的配置,看实际而定

查看表空间设置

修改之前:

mysql> show variables like '%data%';

+-------------------------------+---------------------------------+

| Variable_name | Value |

+-------------------------------+---------------------------------+

| character_set_database | utf8 |

| collation_database | utf8_general_ci |

| datadir | /application/mysql-5.6.43/data/ |

| innodb_data_file_path | ibdata1:12M:autoextend |

修改之前先看一下,文件的大小,否则就是错误的修改,将导致数据库启动时报错,无法启动 [root@web01 data]# du -h ibdata1

12M ibdata1

这第一个的大小,不能大也不能小

innodb_data_file_path=ibdata1:12M;ibdata2:50M:autoextend

修改后,重启,再次查看

mysql> show variables like '%data%';

+-------------------------------+------------------------------------+

| Variable_name | Value |

+-------------------------------+------------------------------------+

| character_set_database | utf8 |

| collation_database | utf8_general_ci |

| datadir | /application/mysql-5.6.43/data/ |

| innodb_data_file_path | ibdata1:12M;ibdata2:50M:autoextend |

已经改变了! 最好在装完软件后就设置好

数据独立表空间

除了系统表空间之外,InnoDB 还在数据库目录中创建另外的表空间,用于每个 InnoDB 表的 .ibd 文件。

InnoDB 创建的每个新表在数据库目录中设置一个 .ibd 文件来搭配表的 .frm 文件。

当然,也会想系统空间存放元数据信息(存在哪个库,空间占用是多少,索引信息)

可以使用 innodb_file_per_table 选项控制此设置,

更改该设置仅会更改已创建的新表的默认值。 注:在mysql5.6开始,默认的配置为:

| innodb_file_per_table | ON | 在mysql内部有专门删除或者导入ibd的功能

alter table test discard tablespace;

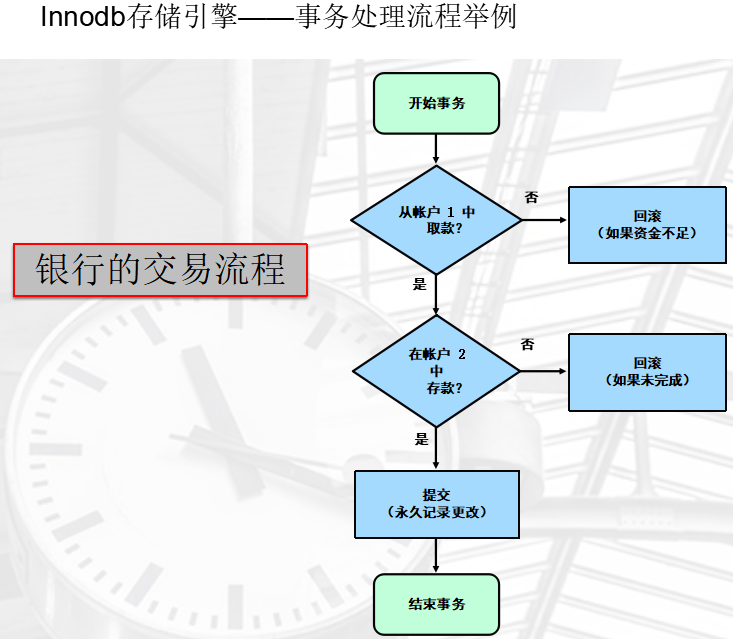

5、MySQL中的事务

简介

一组数据操作执行步骤,这些步骤被视为一个工作单元

- 用于对多个语句进行分组

- 可以在多个客户机并发访问同一个表中的数据时使用

所有步骤都成功或都失败

- 如果所有步骤正常,则执行

- 如果步骤出现错误或不完整,则取消

事务的特性-ACID

Atomic(原子性)

所有语句作为一个单元全部成功执行或全部取消。

Consistent(一致性)

如果数据库在事务开始时处于一致状态,则在执行该事务期间将保留一致状态。

Isolated(隔离性)

事务之间不相互影响。

Durable(持久性)

事务成功完成后,所做的所有更改都会准确地记录在数据库中。所做的更改不会丢失。

Innodb存储引擎--事务处理流程举例

标准的事务语句,就只是DML语句,insert、update、delete

只要看到有DML标准语句,系统不需要begin就开始事务了,这是5.6后的新特性

START TRANSACTION(或 BEGIN):显式开始一个新事务

SAVEPOINT:分配事务过程中的一个位置,以供将来引用

COMMIT:永久记录当前事务所做的更改,说明事务要提交,要完成了

ROLLBACK:取消当前事务所做的更改

ROLLBACK TO SAVEPOINT:取消在 savepoint 之后执行的更改

RELEASE SAVEPOINT:删除 savepoint 标识符

SET AUTOCOMMIT:为当前连接禁用或启用默认 autocommit 模式 查看autocommit的状态

mysql> show variables like '%autocommit%';

+---------------+-------+

| Variable_name | Value |

+---------------+-------+

| autocommit | ON |

+---------------+-------+

1 row in set (0.00 sec)

在事务性的应用场景下,要改成OFF,避免写一句就提交,写一句就提交

查看全局的

show global variables like '%autocommit%';

Autocommit 模式设置

在MySQL5.5开始,开启事务时不再需要begin或者start transaction语句。

并且,默认是开启了Autocommit模式,作为一个事务隐式提交每个语句。

在有些业务繁忙企业场景下,这种配置可能会对性能产生很大影响,但对于安全性上有很大提高。

将来,我们需要去权衡我们的业务需求去调整是否自动提交。

我们可以通过以下命令进行修改关闭(0是关闭,1是开启):

SET GLOBAL AUTOCOMMIT=; - 所有新建会话

SET SESSION AUTOCOMMIT=; - 当前会话

SELECT @@AUTOCOMMIT; - 查看设置结果

我们也可以修改配置文件让其永久生效:

vim /etc/my.cnf

[mysqld]

AUTOCOMMIT=

其他触发隐式commit的情况

用于隐式提交的 SQL 语句:

START TRANSACTION,也就是之前有一个Begin或者START TRANSACTION

SET AUTOCOMMIT =

导致提交的非事务语句:

DDL语句: (ALTER、CREATE 和 DROP)

DCL语句: (GRANT、REVOKE 和 SET PASSWORD)

锁定语句:(LOCK TABLES 和 UNLOCK TABLES)

导致隐式提交的语句示例:

TRUNCATE TABLE

LOAD DATA INFILE

SELECT FOR UPDATE

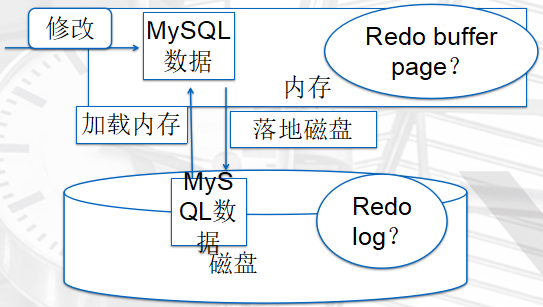

事务日志redo

Redo是什么?

redo,顾名思义“重做日志”,是事务日志的一种。

作用是什么?

在事务ACID过程中,实现的是“D”持久化的作用。

记录数据页的变化

每次都提交,过多的IO操作会影响性能,所以有了Redo

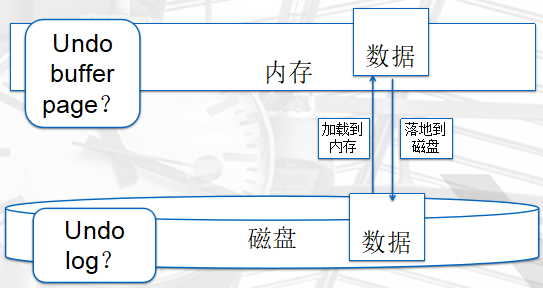

事务日志undo

undo是什么?

undo,顾名思义“回滚日志”,是事务日志的一种。

作用是什么?

在事务ACID过程中,实现的是“A、C”原子性和一致性的作用。

6、MySQL中的锁

什么是“锁”?

“锁”顾名思义就是锁定的意思。

“锁”的作用是什么?

在事务ACID过程中,“锁”和“隔离级别”一起来实现“I”隔离性的作用。

避免争抢资源

锁的粒度:

1、MyIasm:低并发锁——表级锁

2、Innodb:高并发锁——行级锁

四种隔离级别

READ UNCOMMITTED

允许事务查看其他事务所进行的未提交更改

READ COMMITTED

允许事务查看其他事务所进行的已提交更改

REPEATABLE READ******

确保每个事务的 SELECT 输出一致

InnoDB 的默认级别

SERIALIZABLE

将一个事务的结果与其他事务完全隔离 mysql> show variables like '%iso%';

+---------------+-----------------+

| Variable_name | Value |

+---------------+-----------------+

| tx_isolation | REPEATABLE-READ |

+---------------+-----------------+

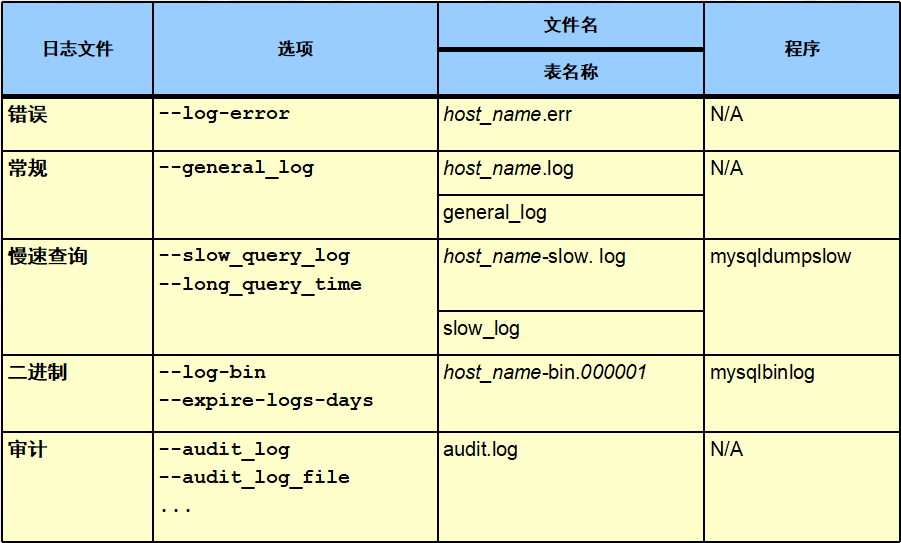

10、MySQL日志管理

1、MySQL日志类型简介

2、MySQL错误日志配置及查看

配置方法:

[mysqld]

log-error=/data/mysql/mysql.log

查看配置方式:

mysql> show variables like '%log%error%';

mysql> show variables like '%log_error%';

+---------------------+--------------+

| Variable_name | Value |

+---------------------+--------------+

| binlog_error_action | IGNORE_ERROR |

| log_error | ./web01.err |

+---------------------+--------------+

2 rows in set (0.00 sec)

不进行设置,默认在上面的目录

作用:

记录mysql数据库的一般状态信息及报错信息,是我们对于数据库常规报错处理的常用日志。

一般查询日志

配置方法:

[mysqld]

general_log=on

general_log_file=/data/mysql/server2.log

查看配置方式:

show variables like '%gen%';

作用:

记录mysql所有执行成功的SQL语句信息,可以做审计用,但是我们很少开启

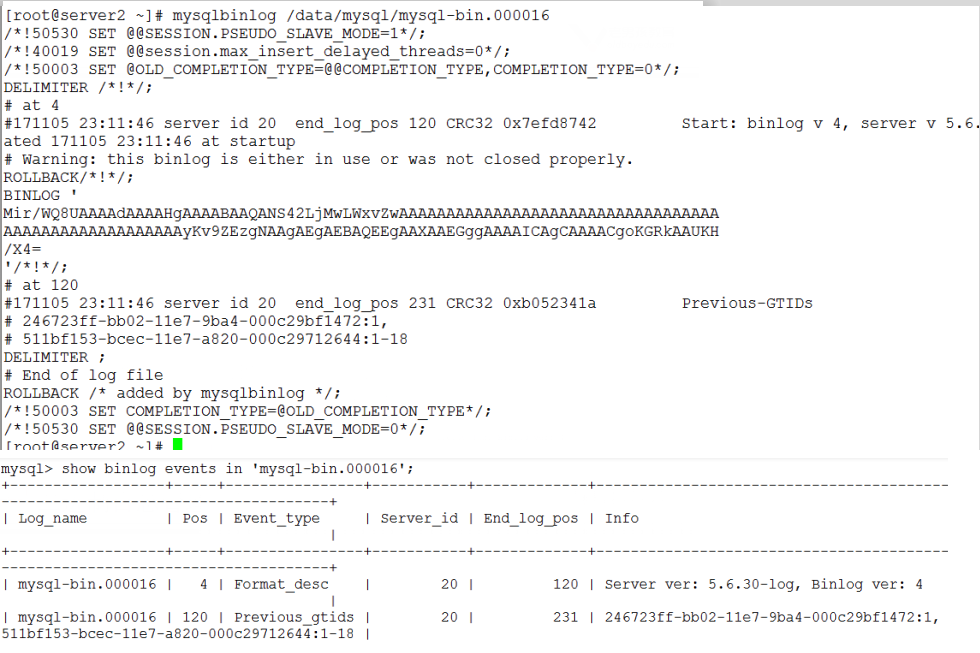

3、MySQL binlog介绍及管理实战

、二进制日志都记录了什么?

已提交的数据记录,以event的形式记录到二进制文件中

只记录增删改

、二进制记录格式有哪些?

row:行模式,即数据行的变化过程,上图中Age=19修改成Age=20的过程事件。

行模式相比语句模式,臃肿,它要记录每一行的变化

statement:语句模式,上图中将update语句进行记录。

记录函数类的操作,不是特别的准确,比如插入了一个时间函数now()

mixed:以上两者的混合模式。

、三种模式有什么优缺点?

、binlog的作用

备份恢复、复制

查看模式的设置

mysql> show variables like '%binlog_format%';

+---------------+-----------+

| Variable_name | Value |

+---------------+-----------+

| binlog_format | STATEMENT |

+---------------+-----------+

1 row in set (0.00 sec)

二进制日志是否开启的查看

mysql> show variables like 'log_bin';

+---------------+-------+

| Variable_name | Value |

+---------------+-------+

| log_bin | OFF | 关闭的

+---------------+-------+

1 row in set (0.00 sec

二进制日志管理

、开启二进制日志

set sql_log_bin= 在会话级别修改为临时关闭

vi /etc/my.cnf

log-bin=/data/mysql/mysql-bin 在全局打开binlog 、设置二进制日志记录格式(建议是ROW):

配置文件中修改:

binlog-format=ROW

命令行修改

mysql> SET GLOBAL binlog_format = 'STATEMENT';

mysql> SET GLOBAL binlog_format = 'ROW';

mysql> SET GLOBAL binlog_format = 'MIXED';

、查看binlog设置

show variables like '%binlog%';

+-----------------------------------------+----------------------+

| Variable_name | Value |

+-----------------------------------------+----------------------+

| binlog_cache_size | 32768 |

| binlog_checksum | CRC32 |

| binlog_direct_non_transactional_updates | OFF |

| binlog_error_action | IGNORE_ERROR |

| binlog_format | STATEMENT |

| binlog_gtid_simple_recovery | OFF |

| binlog_max_flush_queue_time | 0 |

| binlog_order_commits | ON |

| binlog_row_image | FULL |

| binlog_rows_query_log_events | OFF |

| binlog_stmt_cache_size | 32768 |

| binlogging_impossible_mode | IGNORE_ERROR |

| innodb_api_enable_binlog | OFF |

| innodb_locks_unsafe_for_binlog | OFF |

| max_binlog_cache_size | 18446744073709547520 |

| max_binlog_size | 1073741824 |

| max_binlog_stmt_cache_size | 18446744073709547520 |

| simplified_binlog_gtid_recovery | OFF |

| sync_binlog | 0 |什么时候写入到磁盘上

设置为1 ,每次事务提交commit就binlog cache刷新,0就是达到内存大小才写入

+-----------------------------------------+----------------------+

19 rows in set (0.00 sec)

设置文件中的内容

cat /etc/my.cnf

-------------------------------------------

[mysqld]

basedir=/appliacation/mysql

datadir=/application/mysql/data

soket=/appliacation/mysql/tmp/mysql.sock

port=3306

server_id=10

log-error=/var/log/mysql.log

log-bin=/application/mysql/data/mysql-bin

binlog_format=row

skip_name_resolve

innodb_data_file_path=ibdata1:76M;abdata2:50M:autoexend

default_storage_engine=innodb

character-set-server=utf8

antocommit=0

sync_binlog=1

[mysql]

socket=/application/mysql/tmp/mysql.sock

default-character-set=utf8

--------------------------------------------

查询二进制日志文件

ls -l /data/mysql/mysql-bin*

或者在mysql中使用命令

mysql> SHOW BINARY LOGS;

+---------------+-----------+

| Log_name | File_size |

+---------------+-----------+

| binlog.000015 | 724935 |

| binlog.000016 | 733481 |

查看当前在使用的binlog

mysql> SHOW MASTER STATUS;

+---------------+----------+--------------+------------------+

| File | Position | Binlog_Do_DB | Binlog_Ignore_DB |

+---------------+----------+--------------+------------------+

| binlog.000016 | 733481 | world_innodb | manual,mysql 刷新二进制日志

flush logs

截取二进制日志

mysqlbinlog --start-position= --stop-position= >a.sql

删除二进制:

默认情况下,不会删除旧的日志文件。

根据存在时间删除日志:

SET GLOBAL expire_logs_days = 7;

…或者…

PURGE BINARY LOGS BEFORE now() - INTERVAL 3 day; 删除3天之前的,手工

根据文件名删除日志:

PURGE BINARY LOGS TO 'mysql-bin.000010'; 删除到那个文件

help purge binary logs 查看帮助

reset master 重第一个开始重新开始记录,之前都删除了 问题:

1、什么是事件?

2、什么是position?

获取二进制日志的内容及事件,在一系列sql操作后,并commit后,可以看到日志内容

shell中使用mysqlbinlog /data/mysql/mysql-bin.000016

或者

sql中使用show binlog events in ‘mysql-bin.000016

但是看不到DML详细的命令,可以使用参数(mysqlbinlog --help|more)--base64-output=decode-rows 改变输出

mysqlbinlog --base64-output=decode-rows -v /data/mysql/mysql-bin.000016

命令小结

show binary logs; 查询二进制日志文件

show binlog events in 'my-bin.000002' 查看日志中的事件

show master status; 查看当前在使用的binlog mysqlbinlog --base64-output=decode-rows -v my-bin.000002 查看日志转码后的 详细结果,有DML语句的执行过程

mysqlbinlog --start-position= --stop-position= my-bin.000002 截取

mysqlbinlog --start-position= --stop-position= my-bin. >/tmp/binlog.sql

二进制日志管理实战

、通过截取binlog恢复损坏数据

set sql_log_bin=0 临时关闭二进制日志记录,不记录恢复语句

commit

source //tmp/binlog.sql

2、如果我们没有提前去备份binlog,将来在误操作之后,有如何恢复呢?

去截取到误操作之前的所有操作,没有开始标记了

mysqlbinlog --stop-position=721 my-bin.000002 >/tmp/binlog.sql

、二进制日志翻转实现闪回数据(扩展)

一年多的二进制文件,极大,极多,如何快速恢复

4、MySQL 慢查询日志设置及管理实战

慢查询日志

是将mysql服务器中影响数据库性能的相关SQL语句记录到日志文件

通过对这些特殊的SQL语句分析,改进以达到提高数据库性能的目的。

慢日志设置

long_query_time : 设定慢查询的阀值,超出次设定值的SQL即被记录到慢查询日志,缺省值为10s

slow_query_log : 指定是否开启慢查询日志

slow_query_log_file : 指定慢日志文件存放位置,可以为空,系统会给一个缺省的文件host_name-slow.log

min_examined_row_limit:查询检查返回少于该参数指定行的SQL不被记录到慢查询日志

log_queries_not_using_indexes: 不使用索引的慢查询日志是否记录到索引

配置例子

slow_query_log=1

slow_query_log_file=/data/slow/slow.log (必须要有这个文件,且有权限

long_query_time=0.5 (单位是s,)

log_queries_not_using_indexes

加入到/etc/my.cnf

# min_examined_row_limit=100 (少于100行,认为他没问题,尽量不用,如果查询半小时,返回少于100)

mysql中查看配置

mysql> show variables like '%slow%';

+---------------------------+---------------------+

| Variable_name | Value |

+---------------------------+---------------------+

| log_slow_admin_statements | OFF |

| log_slow_slave_statements | OFF |

| slow_launch_time | 2 |

| slow_query_log | ON |

| slow_query_log_file | /data/slow/slow.log |

+---------------------------+---------------------+

5 rows in set (0.00 sec)

查看慢查询超时时间

mysql> show variables like '%long_que%';

+-----------------+----------+

| Variable_name | Value |

+-----------------+----------+

| long_query_time | 0.500000 |

+-----------------+----------+

1 row in set (0.00 sec)

查看 不使用 索引 是否记录的设置

mysql> show variables like '%indexes%';

+----------------------------------------+-------+

| Variable_name | Value |

+----------------------------------------+-------+

| log_queries_not_using_indexes | ON |

| log_throttle_queries_not_using_indexes | 0 |

+----------------------------------------+-------+

2 rows in set (0.00 sec)

mysqldumpslow 如何处理慢日志

记录到慢日志中的日志是没有顺序的,它是追加的模式

mysqldumpslow命令

mysqldumpslow -s c -t /data/slow/slow.log 次数

mysqldumpslow -s at -t 10 /data/slow/slow.log 时间

这会输出记录次数最多的10条SQL语句,其中:

-s

是表示按照何种方式排序,

c、t、l、r分别是按照记录次数、时间、查询时间、返回的记录数来排序,

ac、at、al、ar,表示相应的倒叙;

-t

是top n的意思,即为返回前面多少条的数据;

----扩展工具---

pt-query-diagest 自动做判断,先优化哪一个 percona-toolkit 里面的

mysqlsla

重要的是先找到,哪条语句最慢,而且执行次数最多

11、MySQL备份与恢复

理论情况下,只要有二进制日志文件在,我就可以将数据库恢复到任意时刻

但是,有一个前提,必须是全量

而且,二进制文件只适合短期的恢复

1、备份的原因

运维工作的核心简单概括就两件事:

- 第一个是保护公司的数据.

- 第二个是让网站能7*24小时提供服务(用户体验)。

2、备份的方式

备份的类型

- 热备份:在线备份,不影响业务正常运行,避开业务高峰

- 冷备份:关闭数据,停止业务

- 温备份:加锁备份,避开业务高峰

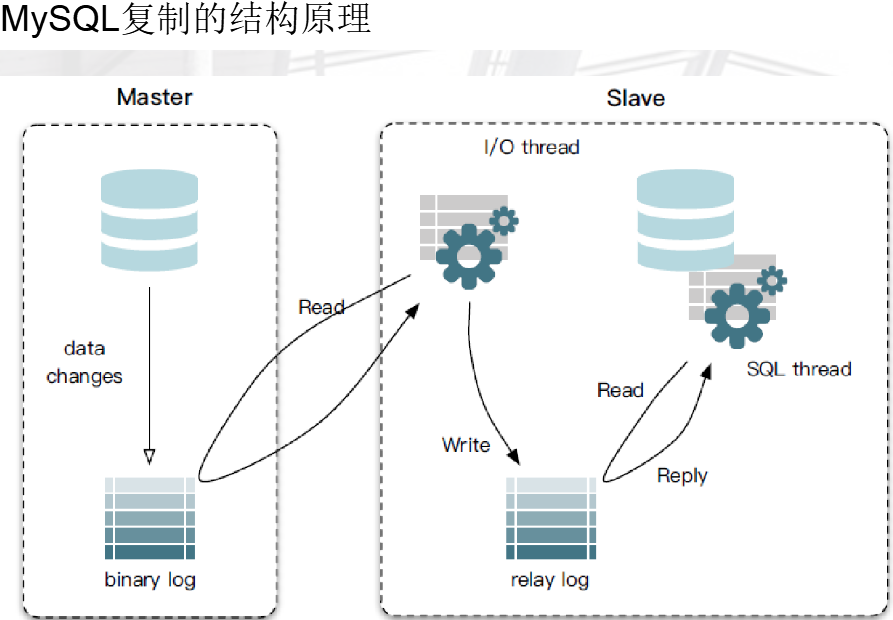

备份方式

逻辑备份(文本表示:SQL 语句)

()mysqldump---->建库、建表、数据插入

()基于二进制日志:数据库的所有变化类的操作

()基于复制的备份:将二进制日志实时传送到另一台机器并且恢复

物理备份(数据文件的二进制副本)

()xtrabackup进行物理备份

()拷贝数据文件(冷备)

增量备份(刷新二进制日志)

基于复制的备份

3、备份工具

1、mysqldump

mysql原生自带很好用的逻辑备份工具

2、mysqlbinlog

实现binlog备份的原生态命令

3、xtrabackup

precona公司开发的性能很高的物理备份工具

4、mysqldump备份工具详解

优点:逻辑备份工具,都是SQL语句,都是文本格式,便于查看和编辑,更便于压缩

缺点:备份效率慢

mysqldump常用参数 -u -p -h -S -P 首先是链接到数据库

-A, --all-databases 全库备份

例子:mysqldump -uroot -p123 -A >/backup/full.sql

-B,单库备份

- 例子:

mysqldump -uroot -p123 -B lufei >/backup/lufei.sql

mysqldump -uroot -p123 lufei >/backup/lufei1.sql

- 区别:

加-B,增加建库(create)及“use库”的语句,在将来恢复时,不需要手工进行建库和use

不加-B,需要恢复时,先创建库,use到库下再进行恢复

- 另外,-B选项还可以实现,同时备份多个库,备份到同一个文件中

mysqldump -uroot -p123 -B lufei oldboy>/backup/lufei_oldboy.sql

不加-B,去备份,他的功能是备份路飞数据库下的oldboy表

mysqldump -uroot -p123 lufei oldboy>/backup/lufei_oldboy.sql

mysqldump 库1 表1 表2 表3 >库1.sql

生产环境下,也要加的额外参数

-R, --routines 备份存储过程和函数数据

--triggers 备份触发器数据

mysqldump -uroot -p123 -A -R --triggers >/backup/full.sql 备份多个表:

mysqldump 库1 表1 表2 表3 >库1.sql

mysqldump 库2 表1 表2 表3 >库2.sql -F, --flush-logs 备份时刷新binlog日志(回顾binlog),为了方便将来二进制截取时的起点

每天晚上0点备份数据库

mysqldump -A -B -F >/opt/$(date +%F).sql

提示:每个库都会刷新一次.

即,-F会根据有多少个库,刷新出多少个二进制文件

[root@db02 ~]# ll /application/mysql/logs/

-rw-rw---- mysql mysql Jun : oldboy-bin.

-rw-rw---- mysql mysql Jun : oldboy-bin.

-rw-rw---- mysql mysql Jun : oldboy-bin.index

一个解决每个库都会刷新的参数

--master-data={|} 告诉你备份时刻的binlog位置,一般我们选择使用2,以注释的方式记录二进制日志位置

注释

非注释,要执行(主从复制)

mysqldump -uroot -p123 -A --master-data= >/backup/full.sql

看一下记录:

[root@db02 logs]# sed -n '22p' /opt/t.sql

-- CHANGE MASTER TO MASTER_LOG_FILE='oldboy-bin.000005', MASTER_LOG_POS=;

[root@db02 logs]# mysqldump -B --master-data= oldboy >/opt/t.sql 锁表:适合所有引擎(myisam,innodb) (温备份)

-x, --lock-all-tables

-l, --lock-tables

mysqldump -B -x oldboy >/opt/t.sql

有了--master-data 就不用锁表参数了

基于事务引擎:不用锁表就可以获得一致性的备份.

生产中99% 使用innodb事务引擎.

ACID四大特性中的隔离性

--single-transaction 对innodb引擎进行热备

mysqldump -uroot -p123 -A -R --triggers --master-data=2 --single-transaction >/backup/full.sql

这是比较合适的备份方式

热备,就是不需要锁表,它是以快照的方式实现热备

举例子:查人数,把教室的学员照个相,在相片上点数 压缩备份:压缩比很高

mysqldump -B --master-data= oldboy|gzip >/opt/t.sql.gz

解压:

zcat t.sql.gz >t1.sql

gzip -d t.sql.gz #删压缩包 适合多引擎混合(例如:myisam与innodb混合)的备份命令如下:

mysqldump -A -R --triggers --master-data= --single-transaction |gzip >/opt/all_$(date +%F).sql.gz 使用source命令进行恢复:

mysql>set sql_log_bin=0; 临时不向二进制文件记录

mysql> source /opt/xxx.sql;

5、mysqldump+mysqlbinlog实现增量备份

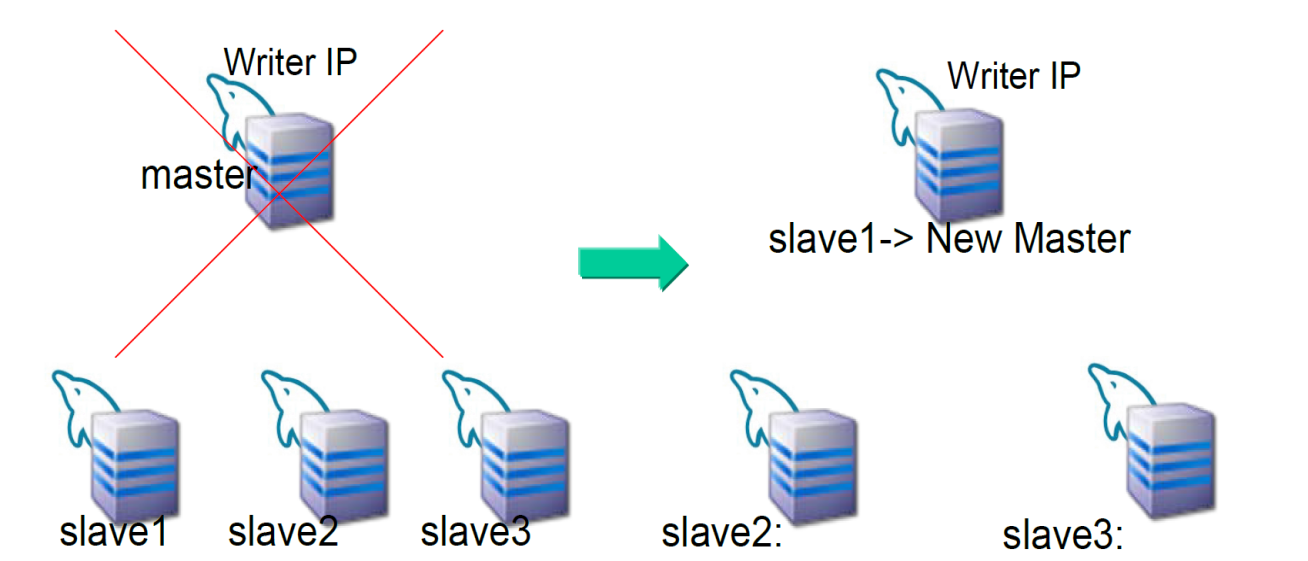

6、企业级备份策略及恢复案例

背景环境:

正在运行的网站系统,mysql数据库,数据量25G,日业务增量10-15M。

备份方式:

每天23:00点,计划任务调用mysqldump执行全备脚本

故障时间点:

上午10点,误删除了一个表 如何恢复?

思路:

、断开业务,防止对数据库二次伤害,挂出维护页面

、搭建备用库,恢复全备

、截取昨天晚上23:00之后到上午10点误删除操作之前的二进制日志

、恢复到备用库,验证数据可用性和完整性

、两种方案恢复前端应用

5.1 备用库导出误删除的表,导入到生产库,开启业务

5.2 直接将应用切割到备用库,替代生产库,开启业务

------------------

模拟故障并恢复:

0、为了模拟 二进制全清除,

mysql>reset master;

删除原库数据

cd /application/mysql/data

\rm -rf *

pkill mysqld

初始化

/application/mysql/script/mysql_install_db --basedir=/application/mysql --datadir=/application/data --user=mysql

启动

/etc/init.d/mysqld start

mysql

、插入原始数据:

mysql> create database oldboy;

mysql> use oldboy

mysql> create table t1 (id int,name varchar());

mysql> insert into t1 values (,'zhang3');

mysql> insert into t1 values (,'li4');

mysql> insert into t1 values (,'wang5');

mysql> commit;

、模拟前一天晚上23:00全备

mysqldump -A -R --triggers --master-data= --single-transaction |gzip >/backup/all_$(date +%F).sql.gz 、模拟白天(:-:)业务对数据的修改

mysql> insert into t1 values (,'zhang33');

mysql> insert into t1 values (,'li44');

mysql> insert into t1 values (,'wang54');

mysql> commit;

、模拟故障

drop table t1; 、恢复

()准备全备,并获取到备份文件中的binlog的截取起点 gunzip all_2018--.sql.gz

-- CHANGE MASTER TO MASTER_LOG_FILE='my-bin.000004', MASTER_LOG_POS=;

()截取二进制日志

查看删库前的日志

mysql>show binlog events in 'my-bin.000004',找到删除之前的位置

mysqlbinlog --start-position= --stop-position= /data/binlog/my-bin. >/backup/binlog.sql -----

show binlog events in 'my-bin.000004'; ----》drop之前的position为1126

-----

()恢复全备+binlog

set sql_log_Bin=;

source /backup/all_2018--.sql;

source /backup/binlog.sql

7、Xtrabackup备份恢复实战

Xtrabackup介绍

percona公司的备份工具,性能比较高。物理备份工具。

特点:

物理备份工具,在同级数据量基础上,都要比逻辑备份性能要好的多。

特别是在数据量比较大的时候,体现的更加明显。

备份方式:

、拷贝数据文件

、拷贝数据页

备份原理(innodb):

、对于innodb表,可以实现热备

()在数据还有修改操作的时刻,直接将数据文件中的数据页备份

此时,备份走的数据对于当前mysql来讲是不一致。

()将备份过程中的redo和undo一并备走。

()为了恢复的时候,只要保证备份出来的数据页LSN 能和redo LSN匹配,

将来恢复的就是一致的数据。redo应用和undo的应用。

、对与myisam表,实现自动锁表拷贝文件。

Xtrabackup安装

、安装

wget -O /etc/yum.repos.d/epel.repo http://mirrors.aliyun.com/repo/epel-6.repo

yum -y install perl perl-devel libaio libaio-devel perl-Time-HiRes perl-DBD-MySQL wget https://www.percona.com/downloads/XtraBackup/Percona-XtraBackup-2.4.4/binary/redhat/6/x86_64/percona-xtrabackup-24-2.4.4-1.el6.x86_64.rpm

yum -y install percona-xtrabackup--2.4.-.el6.x86_64.rpm 备份命令:

xtrabackup

innobackupex ******

依赖配置文件,需要配置好

Xtrabackup全备份及恢复实战

创建备份目录

mkdir /server/backup -p

全备完整命令

innobackupex --user=root --password=oldboy123

--socket=/application/mysql-5.6./tmp/mysql.sock

--no-timestamp /server/backup/full 因为是新库,且配置文件中指定可sock简单的命令

innobackupex /server/backup/

默认是备份到以时间戳作为目录名的目录中,加参数后,备份到指定目录

innobackupex --no-timestamp /server/backup/full 全备的回复例子:

1、恢复数据前的准备(合并xtabackup_log_file和备份的物理文件),因为备份时把redo和undo也备走了

-use-memory:恢复的时候,单独指定一个内存,属于优化的细节

--apply-log:做操作-->恢复数据前的准备(合并xtabackup_log_file和备份的物理文件)

innobackupex --apply-log --use-memory=32M /server/backup/full/

2、模拟故障

停库:

Kill - pid

lsof -i :

破坏数据:

cd /application/mysql/data

mv data /opt/ 或者 \rm -rf *

3、恢复

cp -a /server/backup/full/ /application/mysql/data

或者

innobackupex --copy-back /server/backup/full/

注意:恢复时,要确认数据路径是空的,并且数据库是停掉的

chown -R mysql.mysql /application/mysql/data

启动:

/etc/init.d/mysqld start

mysql -e "select * from oldboy.test"