Python3.5:爬取网站上电影数据

首先我们导入几个pyhton3的库:

from urllib import request

import urllib

from html.parser import HTMLParser

在Python2和Python3之间一个重要区别就是,在Python2有urllib,urllib2两个库,在Python3整合到一起,里面的函数方式也有一点变,先定义一个函数,将header,url,request,都打包成一个函数方便调用,且看下面代码:

def print_movies(url):

# 伪装成浏览器访问网站,但其实没啥用,很容易被中间件检测出来,但没有又不行,所以蛮写吧

header = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/51.0.2704.103 Safari/537.36'}

# Python3的urllib

req = urllib.request.Request(url, headers=header)

s = urllib.request.urlopen(req)

parser = MovieParser()

parser.feed((s.read()).decode('utf-8'))

s.close()

再重载HTMLParser库的handle_starttag(self, tag, attrs),系统就会默认调用用户重载的,具体调用方式在官方文档里面详细介绍:HTMLParser,

class MovieParser(HTMLParser):

def __init__(self):

HTMLParser.__init__(self)

self.movies = []

# 重载HTMLParser自带的函数

def handle_starttag(self, tag, attrs):

def _attr(attrlist, attrname):

for attr in attrlist:

if attr[0] == attrname:

return attr[1]

return None

# 可以在这class后面找到每个li标签的特征属性比如catrgory在下面判断

if tag == 'li' and _attr(attrs, 'data-title'):

movie= {}

movie['title'] = _attr(attrs, 'data-title')

movie['rate'] = _attr(attrs, 'data-rate')

movie['director'] = _attr(attrs, 'data-director')

movie['actors'] = _attr(attrs, 'data-actors')

self.movies.append(movie)

print('%(title)s|%(rate)s|%(director)s|%(actors)s' % movie)

当我们执行到parser.feed((s.read()).decode('utf-8'))时,知道为什么要这样写,首先parser时HTMLParser的子类所以包括feed(),在注入数据时,s.read()是返回bytes类型,但feed()只接受str类型,所以直接在后面加个decode('utf-8')即转码(三个bytes转换为一个中文),又可以转换为str,基本获取数据就这么简单,要是想获取别的网站的数据,可以换个url和条件判断就可以了,我把全部代码贴上来:

from urllib import request

import urllib

from html.parser import HTMLParser class MovieParser(HTMLParser):

def __init__(self):

HTMLParser.__init__(self)

self.movies = []

# 重载HTMLParser自带的函数

def handle_starttag(self, tag, attrs):

def _attr(attrlist, attrname):

for attr in attrlist:

if attr[0] == attrname:

return attr[1]

return None

# 可以在这class后面找到每个li标签的特征属性比如catrgory在下面判断

if tag == 'li' and _attr(attrs, 'data-title'):

movie= {}

movie['title'] = _attr(attrs, 'data-title')

movie['rate'] = _attr(attrs, 'data-rate')

movie['director'] = _attr(attrs, 'data-director')

movie['actors'] = _attr(attrs, 'data-actors')

self.movies.append(movie)

print('%(title)s|%(rate)s|%(director)s|%(actors)s' % movie) def print_movies(url):

# 伪装成浏览器访问网站,但其实没啥用,很容易被中间件检测出来,但没有又不行,所以蛮写吧

header = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/51.0.2704.103 Safari/537.36'}

# Python3的urllib

req = urllib.request.Request(url, headers=header)

s = urllib.request.urlopen(req)

parser = MovieParser()

parser.feed((s.read()).decode('utf-8'))

s.close() if __name__ == '__main__':

url = 'https://movie.douban.com/'

# 返回一个电影列表

print_movies(url)

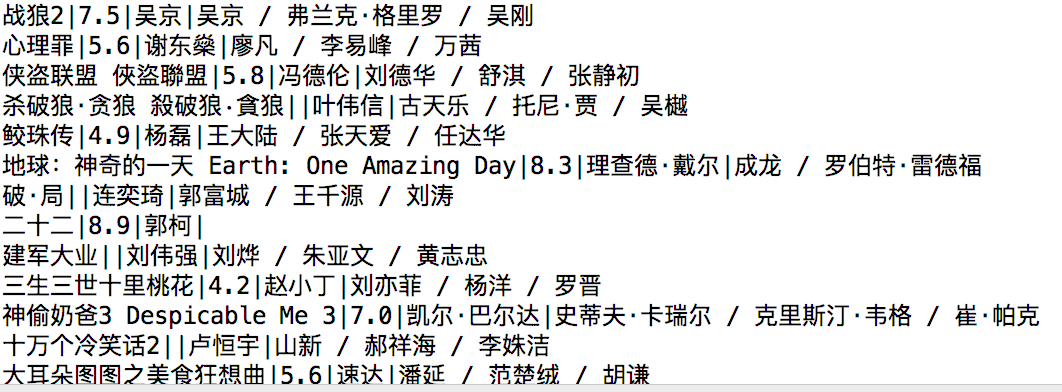

运行结果为:

Python3.5:爬取网站上电影数据的更多相关文章

- Python爬取网站上面的数据很简单,但是如何爬取APP上面的数据呢

- 使用scrapy爬取网站的商品数据

目标是爬取网站http://www.muyingzhijia.com/上全部的商品数据信息,包括商品的一级类别,二级类别,商品title,品牌,价格. 搜索了一下,python的scrapy是一个不错 ...

- 基础爬虫,谁学谁会,用requests、正则表达式爬取豆瓣Top250电影数据!

爬取豆瓣Top250电影的评分.海报.影评等数据! 本项目是爬虫中最基础的,最简单的一例: 后面会有利用爬虫框架来完成更高级.自动化的爬虫程序. 此项目过程是运用requests请求库来获取h ...

- 使用Selenium爬取网站表格类数据

本文转载自一下网站:Python爬虫(5):Selenium 爬取东方财富网股票财务报表 https://www.makcyun.top/web_scraping_withpython5.html 需 ...

- C# 爬取网页上的数据

最近工作中需求定时爬取不同城市每天的温度.其实就是通过编程的方法去抓取不同网站网页进行分析筛选的过程..NET提供了很多类去访问并获得远程网页的数据,比如WebClient类和HttpWebReque ...

- Python3爬虫爬取淘宝商品数据

这次的主要的目的是从淘宝的搜索页面获取商品的信息.其实分析页面找到信息很容易,页面信息的存放都是以静态的方式直接嵌套的页面上的,很容易找到.主要困难是将信息从HTML源码中剥离出来,数据和网页源码结合 ...

- python3 requests_html 爬取智联招聘数据(简易版)

PS重点:我回来了-----我回来了-----我回来了 1. 基础需要: python3 基础 html5 CS3 基础 2.库的选择: 原始库 urllib2 (这个库早些年的用过,后来淡忘了) ...

- python 实现爬取网站下所有URL

python3 实现爬取网站下所有URL 获取首页元素信息: 首页的URL链接获取: 遍历第一次返回的结果: 递归循环遍历: 全部代码如下: 小结: python3.6 requests && ...

- Python转页爬取某铝业网站上的数据

天行健,君子以自强不息:地势坤,君子以厚德载物! 好了废话不多说,正式进入主题,前段时间应朋友的请求,爬取了某铝业网站上的数据.刚开始呢,还是挺不愿意的(主要是自己没有完整的爬取过网上的数据哎,即是不 ...

随机推荐

- work 2013-07-19

今天,在现场进行了数据库的优化,将数据库的日志截断和压缩了 use 测试库backup log 测试库 with no_logdbcc shrinkfile (测试库_Data,1)dbcc shri ...

- Less的Extend_Less继承

Extend就相当于Java的继承,它允许一个选择器继承另一个选择器的样式.Extend有两种语法格式. 一种是: <selector>:extend(<parentSelector ...

- 软件测试管理QC

一.QC简介 1)是HP公司的产品,是B/S结构的产品 2)在QC服务器中,打开IE浏览器,在地址栏中输入QC服务器的网址或者IP地址. 查看虚拟机的IP地址: 本地连接-属性-TCP/IP协议(重点 ...

- ctrl+z 以后怎么恢复挂起的进程

(1) CTRL+Z挂起进程并放入后台 (2) jobs 显示当前暂停的进程 (3) bg %N 使第N个任务在后台运行(%前有空格) (4) fg %N 使第N个任务在前台运行 默认bg,fg不带% ...

- mysql单表多表查询

单表查询语法: select 字段1,字段2... from 表名where 条 件group by fieldhaving 筛选order by 字段limit 限制条数 关键字的优先级:from ...

- javascript文档节点

创建文本节点 document.createTextNode() 创建新文本节点,该方法接收一个参数,即要插入节点中的文本信息. <script> //创建一个div节点 var elem ...

- C++反汇编第三讲,反汇编中识别虚表指针,以及指向的虚函数地址

C++反汇编第三讲,反汇编中识别虚表指针,以及指向的虚函数地址 讲解之前,了解下什么是虚函数,什么是虚表指针,了解下语法,(也算复习了) 开发知识为了不码字了,找了一篇介绍比较好的,这里我扣过来了,当 ...

- unity中Ray、RaycastHit 、Raycast(小白之路)

1.Ray Ray(Vector3 origin, Vector3 direction) Ray:在程序中可以理解为射线,就是以某个位置(origin)朝某个方向(direction)的一条射线,是一 ...

- 获取或设置当前窗口contextmenu事件的事件处理函数

在浏览器中 鼠标右键点击会显示默认的 自带的菜单,那么如何禁止 和更改呢? 1) 禁止右键 window.oncontextmenu = funcRef; //funcRef是个函数引用 列子: w ...

- 下拉菜单被挡住了,DIV置于最底层的方法

网站常会用到一些 下拉菜单,,幻灯片,,,飘浮广告等. 但经常会发现.幻灯片会挡住下拉菜单或者飘浮广告等.解决办法有下 第一,可将幻灯片所在DIV 置于最底层.添加CSS如下 style=" ...