HtmlParser应用,使用Filter从爬取到的网页中获取需要的内容

htmlparser是一个纯的java写的html解析的库,它不依赖于其它的java库文件,主要用于改造或提取html。它能超高速解析html,而且不会出错。现在htmlparser最新版本为2.0。

下载地址: http://sourceforge.net/projects/htmlparser/

在线API: http://www.ostools.net/apidocs/apidoc?api=HTMLParser

Filter就是对于结果进行过滤,取得需要的内容。HTMLParser在org.htmlparser.filters包之内一共定义了15个不同的Filter

AndFilter、CssSelectorNodeFilter、HasAttributeFilter、HasChildFilter、HasSiblingFilter、IsEqualFilter、LinkRegexFilter、LinkStringFilter、NodeClassFilter、NotFilter、OrFilter、RegexFilter、StringFilter 、TagNameFilter.

常用的几个过滤器说明

TagNameFilter:

是最容易理解的一个Filter,根据Tag的名字进行过滤

HasChildFilter:

是返回有符合条件的子节点的节点,需要另外一个Filter作为过滤子节点的参数。

HasAttributeFilter:

可以匹配出包含制定名字的属性,或者制定属性为指定值的节点。HasParentFilter和HasSiblingFilter的功能与HasChildFilter类似。

StringFilter:

这个Filter用于过滤显示字符串中包含指定内容的标签节点。注意是可显示的字符串,不可显示的字符串中的内容(例如注释,链接等等)不会被显示

RegexFilter :

根据正则表达式匹配节点.与LinkRegexFilter不同的是,LinkRegexFilter只在LinkTag中寻找匹配

NodeClassFilter:

根据已定义的标签类获取节点

LinkStringFilter:

这个Filter用于判断链接中是否包含某个特定的字符串,可以用来过滤出指向某个特定网站的链接。

OrFilter:

是结合几种过滤条件的'或'过滤器

AndFilter:

是结合几种过滤条件的'与'过滤器

实例应用

NodeClassFilter过滤器实例

/**

*

* 过滤页面中的标签信息

*

* @param url 要解析的url页面

* @param encoding 使用的字符编码

* @param tagclass

* 要或取得页面标签,如要获取页面中的超链接 值为LinkTag.class,要获取页面中图片链接,值为ImageTag.class

* 要传入的标签类为org.htmlparser.tags下的

*/

public static void nodeFilterTagClass(String url,String encoding,Class tagclass){

try {

Parser parser = new Parser();

parser.setURL(url);

if(null==encoding){

parser.setEncoding(parser.getEncoding());

}else{

parser.setEncoding(encoding);

}

//过滤页面中的链接标签

NodeFilter filter = new NodeClassFilter(tagclass);

NodeList list = parser.extractAllNodesThatMatch(filter);

for(int i=0; i<list.size();i++){

Node node = (Node)list.elementAt(i);

System.out.println("link is :" + node.toHtml());

} } catch (Exception e) {

e.printStackTrace();

}

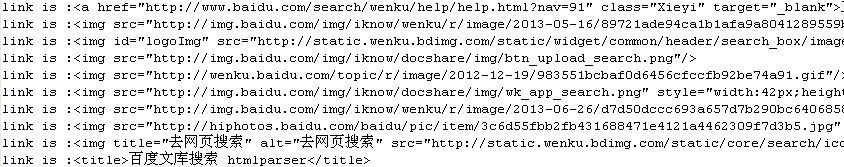

} public static void main(String[] args) { String url = "http://wenku.baidu.com/search?word=htmlparser&lm=0&od=0&fr=top_home"; //获取页面中的<a href='xxx' [属性]>格式的链接

nodeFilterTagClass(url, "UTF-8", LinkTag.class); //或取页面中的<img src='xxx' [属性='属性值']>格式的链接

nodeFilterTagClass(url, "UTF-8", ImageTag.class); //或取页面<title>xxxx</title>标题

nodeFilterTagClass(url, "UTF-8", TitleTag.class); //获取页面<div [属性='属性值']> xxx</div>

//nodeFilterTagClass(url, "UTF-8", Div.class); }

程序运行结果:

TagNameFilter实例应用

是最容易理解的一个Filter,根据Tag的名字进行过滤

/**

*

* 根据标签名过滤页面中的标签信息

*

* @param url 要解析的url页面

* @param encoding 使用的字符编码

* @param tagName 标签名

*/

public static void nodeFilterTagName(String url,String encoding,String tagName){

try {

Parser parser = new Parser();

parser.setURL(url);

if(null==encoding){

parser.setEncoding(parser.getEncoding());

}else{

parser.setEncoding(encoding);

}

//过滤页面中的链接标签

NodeFilter filter = new TagNameFilter(tagName);

NodeList list = parser.extractAllNodesThatMatch(filter);

for(int i=0; i<list.size();i++){

Node node = (Node)list.elementAt(i);

System.out.println("link is :" + node.toHtml());

} } catch (Exception e) {

e.printStackTrace();

}

} public static void main(String[] args) { String url = "http://wenku.baidu.com/search?word=htmlparser&lm=0&od=0&fr=top_home"; //获取页面中的<a href='xxx' [属性]>格式的链接

nodeFilterTagName(url, "UTF-8", "a"); //或取页面中的<img src='xxx' [属性='属性值']>格式的链接

nodeFilterTagName(url, "UTF-8", "img"); //获取页面中的<div>链接

//nodeFilterTagName(url, "UTF-8", "div"); }

程序运行结果同上

StringFilter实例应用

过滤显示字符串中包含指定内容的标签节点。注意是可显示的字符串,不可显示的字符串中的内容(例如注释,链接等等)不会被显示

/**

* 过滤显示字符串中包含指定内容的标签节点。注意是可显示的字符串,不可显示的字符串中的内容(例如注释,链接等等)不会被显示

*

* @param url 请求处理的url

* @param encoding 字符编码

* @param containStr包含的指定内容

*/

public static void stringFilter(String url,String encoding,String containStr){

try {

Parser parser = new Parser();

parser.setURL(url);

if(null==encoding){

parser.setEncoding(parser.getEncoding());

}else{

parser.setEncoding(encoding);

}

//OrFilter是结合几种过滤条件的‘或’过滤器

NodeFilter filter = new StringFilter(containStr);

NodeList list = parser.extractAllNodesThatMatch(filter);

for(int i=0; i<list.size();i++){

Node node = (Node)list.elementAt(i);

System.out.println("link is :" + node.toHtml());

} } catch (Exception e) {

e.printStackTrace();

}

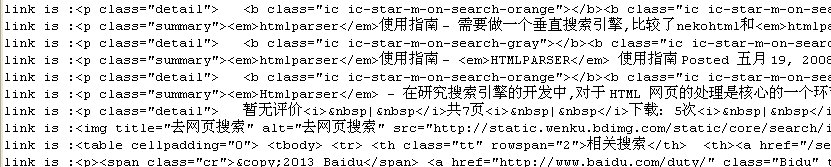

} public static void main(String[] args) { String url = "http://wenku.baidu.com/search?word=htmlparser&lm=0&od=0&fr=top_home";

stringFilter(url, "UTF-8", "img.baidu.com"); }

程序运行结果

OrFilter实例应用

OrFilter是结合几种过滤条件的‘或’过滤器,与此相反的是AndFilter,AndFilter是集合几个过滤条件的‘与’过滤器

/**

* OrFilter是结合几种过滤条件的‘或’过滤器

*

* 一般主题信息包含在下列标签中:<table>、<tr>、<td>、<p>、<div>等。如果要过滤出这些节点标签,可以使用OrFilter过滤器

*

* @param url 请求处理的url

* @param encoding 使用的字符编码

* @param filters 多个过滤器数组

*/

public static void orMultiFilter(String url,String encoding,NodeFilter[] filters){

try {

Parser parser = new Parser();

parser.setURL(url);

if(null==encoding){

parser.setEncoding(parser.getEncoding());

}else{

parser.setEncoding(encoding);

}

//OrFilter是结合几种过滤条件的‘或’过滤器

NodeFilter filter = new OrFilter(filters);

NodeList list = parser.extractAllNodesThatMatch(filter);

for(int i=0; i<list.size();i++){

Node node = (Node)list.elementAt(i);

System.out.println("link is :" + node.toHtml());

} } catch (Exception e) {

e.printStackTrace();

}

} public static void main(String[] args) { String url = "http://wenku.baidu.com/search?word=htmlparser&lm=0&od=0&fr=top_home";

//过滤多个标签 或关系

NodeFilter[] filters = new NodeFilter[3];

filters[0] = new NodeClassFilter(TableTag.class);

filters[1] = new NodeClassFilter(ParagraphTag.class);

filters[2] = new NodeClassFilter(ImageTag.class);

orMultiFilter(url, "UTF-8", filters); }

程序运行结果:

RegexFilter与LinkRegexFilter实例应用

RegexFilter根据正则表达式匹配节点.与LinkRegexFilter不同的是,LinkRegexFilter只在LinkTag中寻找匹配

/**

* 在文本中通过正则进行匹配

*

* @param url 请求处理的url

* @param encoding 字符编码

* @param regex 待匹配的正则表达式

*/

public static void regexStringFilter(String url,String encoding,String regex){

try {

Parser parser = new Parser();

parser.setURL(url);

if(null==encoding){

parser.setEncoding(parser.getEncoding());

}else{

parser.setEncoding(encoding);

}

//OrFilter是结合几种过滤条件的‘或’过滤器

NodeFilter filter = new RegexFilter(regex);

NodeList list = parser.extractAllNodesThatMatch(filter);

for(int i=0; i<list.size();i++){

Node node = (Node)list.elementAt(i);

System.out.println("link is :" + node.toHtml());

} } catch (Exception e) {

e.printStackTrace();

}

} /**

* 在链接地址中进行正则匹配,返回的是Link结点

*

* @param url 请求url

* @param encoding 字符编码

* @param regex 待匹配的正则表达式

*/

public static void linkTagRegexFilter(String url,String encoding,String regex){

try {

Parser parser = new Parser();

parser.setURL(url);

if(null==encoding){

parser.setEncoding(parser.getEncoding());

}else{

parser.setEncoding(encoding);

}

//OrFilter是结合几种过滤条件的‘或’过滤器

NodeFilter filter = new LinkRegexFilter(regex);

NodeList list = parser.extractAllNodesThatMatch(filter);

for(int i=0; i<list.size();i++){

Node node = (Node)list.elementAt(i);

System.out.println("link is :" + node.toHtml());

} } catch (Exception e) {

e.printStackTrace();

}

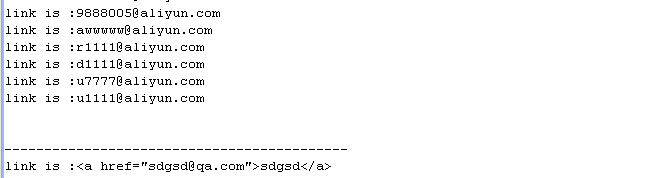

} public static void main(String[] args) { String url = "F:/dennisit/email.txt"; String emailRegex = "[a-zA-Z0-9_-]+@\\w+\\.[a-z]+(\\.[a-z]+)?";

regexStringFilter(url, "UTF-8", emailRegex);

System.out.println("-------------------------------------------");

linkTagRegexFilter(url, "UTF-8", emailRegex); }

程序运行结果

HtmlParser应用,使用Filter从爬取到的网页中获取需要的内容的更多相关文章

- 【AMAD】newspaper -- 爬取/提取新闻网页中的文本,元数据

动机 简介 用法 源码分析 个人评分 动机 新闻网页,结构大多是类似的. 所以,能不能用一种通用的爬取方法来提取其中的数据? 简介 Newspapaer1受到requests那种简单性API的启发,通 ...

- scrapy-redis + Bloom Filter分布式爬取tencent社招信息

scrapy-redis + Bloom Filter分布式爬取tencent社招信息 什么是scrapy-redis 什么是 Bloom Filter 为什么需要使用scrapy-redis + B ...

- python连续爬取多个网页的图片分别保存到不同的文件夹

python连续爬取多个网页的图片分别保存到不同的文件夹 作者:vpoet mail:vpoet_sir@163.com #coding:utf-8 import urllib import ur ...

- python网络爬虫之使用scrapy自动爬取多个网页

前面介绍的scrapy爬虫只能爬取单个网页.如果我们想爬取多个网页.比如网上的小说该如何如何操作呢.比如下面的这样的结构.是小说的第一篇.可以点击返回目录还是下一页 对应的网页代码: 我们再看进入后面 ...

- 爬取CVPR 2018过程中遇到的坑

爬取 CVPR 2018 过程中遇到的坑 使用语言及模块 语言: Python 3.6.6 模块: re requests lxml bs4 过程 一开始都挺顺利的,先获取到所有文章的链接再逐个爬取获 ...

- Python 网络爬虫 005 (编程) 如何编写一个可以 下载(或叫:爬取)一个网页 的网络爬虫

如何编写一个可以 下载(或叫:爬取)一个网页 的网络爬虫 使用的系统:Windows 10 64位 Python 语言版本:Python 2.7.10 V 使用的编程 Python 的集成开发环境:P ...

- Node JS爬虫:爬取瀑布流网页高清图

原文链接:Node JS爬虫:爬取瀑布流网页高清图 静态为主的网页往往用get方法就能获取页面所有内容.动态网页即异步请求数据的网页则需要用浏览器加载完成后再进行抓取.本文介绍了如何连续爬取瀑布流网页 ...

- Python 爬虫练习: 爬取百度贴吧中的图片

背景:最近开始看一些Python爬虫相关的知识,就在网上找了一些简单已与练习的一些爬虫脚本 实现功能:1,读取用户想要爬取的贴吧 2,读取用户先要爬取某个贴吧的页数范围 3,爬取每个贴吧中用户输入的页 ...

- 初识python 之 爬虫:使用正则表达式爬取“古诗文”网页数据

通过requests.re(正则表达式) 爬取"古诗文"网页数据. 详细代码如下: #!/user/bin env python # author:Simple-Sir # tim ...

随机推荐

- 生产项目加入到SVN版本控制

零.介绍 每天定时备份是通过ftp打包和同步的方式,这些都是比较粗的备份,没法恢复到指定时间的文件,所以需要用到svn控制版本. (请不要问我为什么不用git) 一.现有项目文件加入版本控制 因为项目 ...

- Photoshop快捷键

ctrl+del :铺后景色alt+del:铺前景色ctrl+d:取消选框ctrl+t:拉伸(挡住文字)TAB:显示(隐藏)工具栏ctrl+alt+i:反选ctrl+r:辅佐线ctrl+j:复制并添加 ...

- ado.net中的几个对象

Connection:用于连接数据源 Command:对数据源执行命令 DataReader:在只读和只写的连接模式下从数据源读取数据. DataAdpter:从数据源读取数据并使用所读取的数据填充数 ...

- App开发中甲乙方冲突会闹出啥后果?H5 APP 开发可以改变现状吗

随着各种应用的全面App化,因App而起的合作纠纷也日益增多,其中不乏最终对簿公堂的情形.WeX5(html5开发工具)为您汇总了三个典型的真实案例,方便您体会甲乙方冲突情景. 在围观别人争吵之余,您 ...

- python 数据类型(列表)学习笔记

列表 创建列表: name_list = ['alex', 'seven', 'eric'] 或 name_list = list(['alex', 'seven', 'eric']) 其实今天学习的 ...

- WIN32api总结

1.鼠标操作: win32api.SetCursorPos((101,156)) win32api.mouse_event(win32con.MOUSEEVENT_LEFTDOWN,0,0,0,0) ...

- objective-c常用数学方法

1. 三角函数 double sin (double);正弦 double cos (double);余弦 double tan (double);正切 2 .反三角函数 double as ...

- matlab高斯模板生成,K是归一化系数,上面是一个半径200的高斯模板用来做MSR

R3=; F=zeros(*R3+,*R3+); sigma=R3/; r=; :*R3+ :*R3+ r=(x-R3)*(x-R3)+(y-R3)*(y-R3); ...

- failed with: java.lang.NullPointerException

failed with: java.lang.NullPointerException 需要在nutch的配置文件 'conf/nutch-site.xml'. 里设置如下,不然就报上面的错误了. 当 ...

- POJ 3349 Snowflake Snow Snowflakes(哈希)

http://poj.org/problem?id=3349 题意 :分别给你n片雪花的六个角的长度,让你比较一下这n个雪花有没有相同的. 思路:一开始以为把每一个雪花的六个角的长度sort一下,然后 ...