Python爬虫使用selenium爬取qq群的成员信息(全自动实现自动登陆)

前言

本文的文字及图片来源于网络,仅供学习、交流使用,不具有任何商业用途,版权归原作者所有,如有问题请及时联系我们以作处理。

作者: python小爬虫

PS:如有需要Python学习资料的小伙伴可以加点击下方链接自行获取

http://note.youdao.com/noteshare?id=3054cce4add8a909e784ad934f956cef

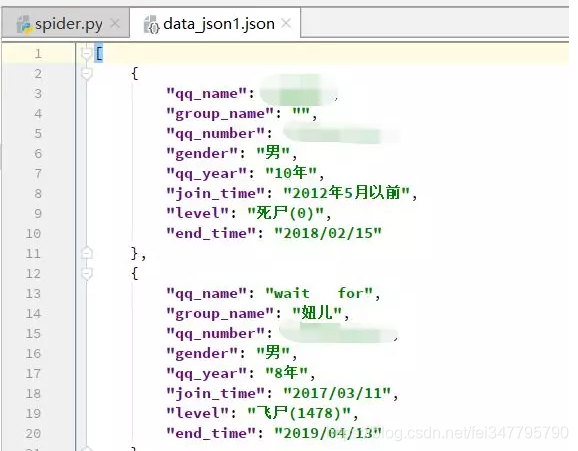

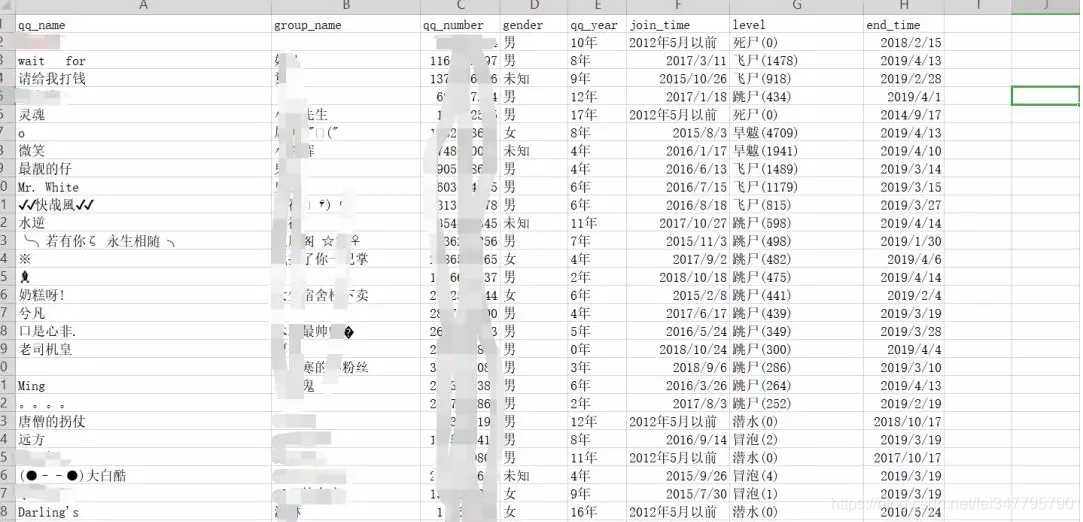

效果图,其中涉及一些真名我就打码了,还有qq号我也打码了,见谅

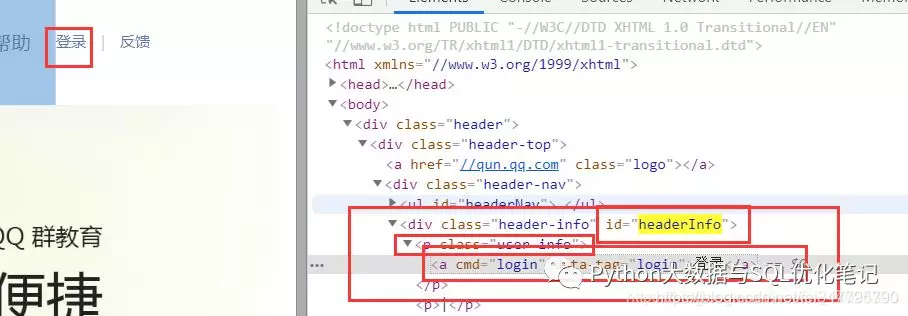

分析登陆的元素,下图一目了然,怎么获取这个登陆元素应该都知道了

代码奉上

url = 'https://qun.qq.com/'

# 构建谷歌驱动器

browser = webdriver.Chrome()

# 请求url

browser.get(url)

# 模拟登陆,首先找到登陆的id,并点击

browser.find_element_by_css_selector('#headerInfo p a').click()

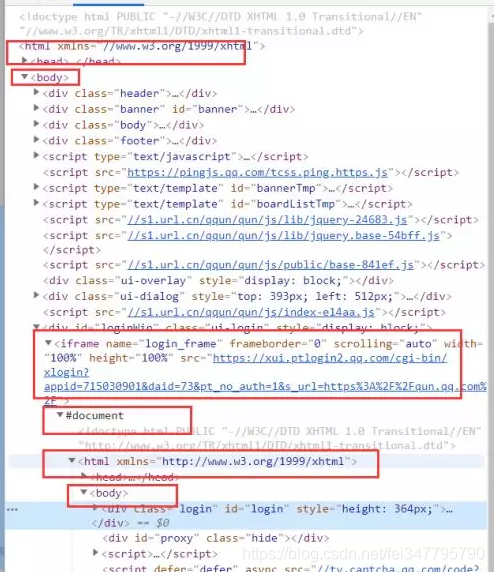

点击之后出现这么一个框框(这个框框可把我折磨的阿)原因是这样的,寻常的获取这个框框是不能获取到的

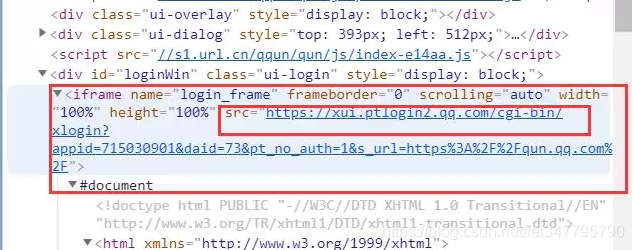

5.先看看这个框所在的位置,这个框框竟然在另一个html代码里面,也就是说在浏览器看的时候,出现了两个html标签,老实说,我是第一次看到这种情况的,奈何我的html也不好,连入门都算不上,没办法,我就去百度了,果然黄天不负有心人,说是因为iframe这个标签可以再放html代码,所以就是这种情况了

既然知道了是怎么一回事之后,那就可以继续操作了,首先我们先找到iframe这个标签,然后获取它的src属性,这个链接就是这个框框登陆的链接了,如果不获取这个iframe标签的src属性,那么我们使用selenium是获取不到这个框框的元素的。

# 点击之后会弹出一个登陆框,这时候我们用显示等待来等待这个登陆框加载出来

WebDriverWait(browser, 1000).until(

EC.presence_of_all_elements_located(

(By.CSS_SELECTOR, '#loginWin iframe')

)

)

print('登陆框已加载')

# 登陆框加载之后,我们发现整个登陆框其实就是另一个网网页

# 如果在原网页操作这个登陆框的话,是不能操作的

# 所以我们只需要提取iframe标签的src属性,然后再去访问这个url即可实现

# 自动登陆

# 找到iframe标签并获取src

iframe_url = browser.find_element_by_css_selector('#loginWin iframe').get_attribute('src')

# 再访问这个url

browser.get(iframe_url)

# 找到快捷登陆的头像并点击

# 首先用显示等待这个头像已经加载完成

WebDriverWait(browser, 1000).until(

EC.presence_of_all_elements_located(

(By.ID, 'qlogin_list')

)

)

browser.find_element_by_css_selector('#qlogin_list a').click()

print('登陆成功')

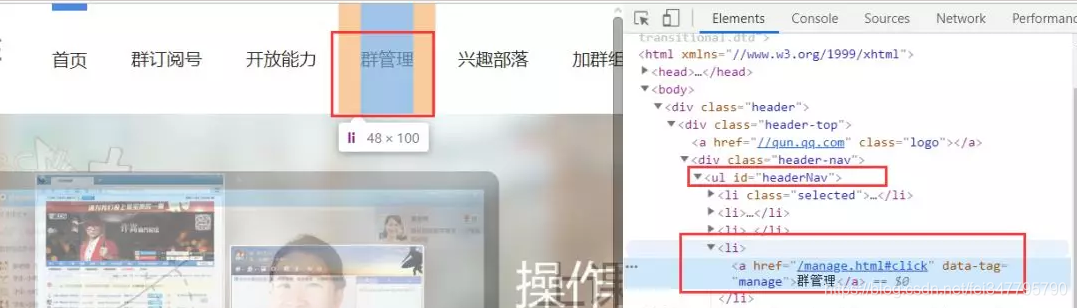

登陆成功之后我们需要的是群管理,是ul标签的第四个li标签,通过xpath获取

# 登陆成功之后,我们就找到群管理的标签并点击,首先等待这个元素加载完成

WebDriverWait(browser, 1000).until(

EC.presence_of_all_elements_located(

(By.XPATH, './/ul[@id="headerNav"]/li[4]')

)

)

browser.find_element_by_xpath('.//ul[@id="headerNav"]/li[4]').click()

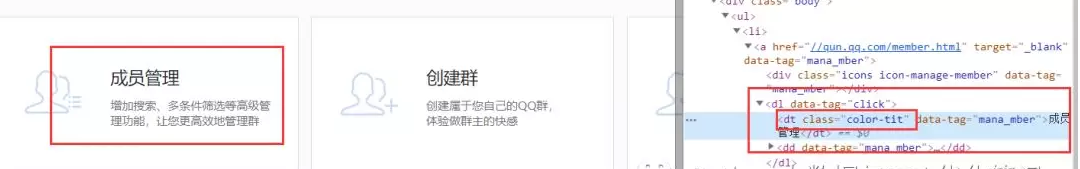

8.点击群管理之后,进入群管理界面,我们需要的是成员管理

# 点击之后,我们找到成员管理标签并点击

WebDriverWait(browser, 1000).until(

EC.presence_of_all_elements_located(

(By.CLASS_NAME, 'color-tit')

)

)

browser.find_element_by_class_name('color-tit').click()

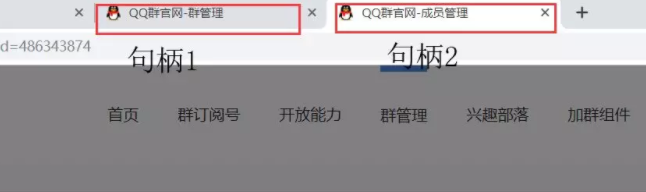

9.点击成员管理之后会重新新建一个窗口,这个时候就会出现句柄,我们需要将当然窗口的句柄切换到新打开的这个界面,不然的话,是获取不到新打开界面的信息的,注释已经写了

# 打印全部窗口句柄

# print(browser.window_handles)

# 打印当前窗口句柄

# print(browser.current_window_handle)

# 注意这里点击成员管理之后会自动跳转到一个新窗口打开这个页面

# 所以我们需要将窗口句柄切换到这个新窗口

browser.switch_to.window(browser.window_handles[1])

# 解释一下browser.switch_to.window是获取当前一共有几个窗口

# 这里是2个

# browser.switch_to.window这个是指定当前游标切换到哪个窗口

# 其实也可以这么写

# all_window = browser.switch_to.window返回的是一个列表

# browser.switch_to.window(all_window[1])

# 效果是一样的

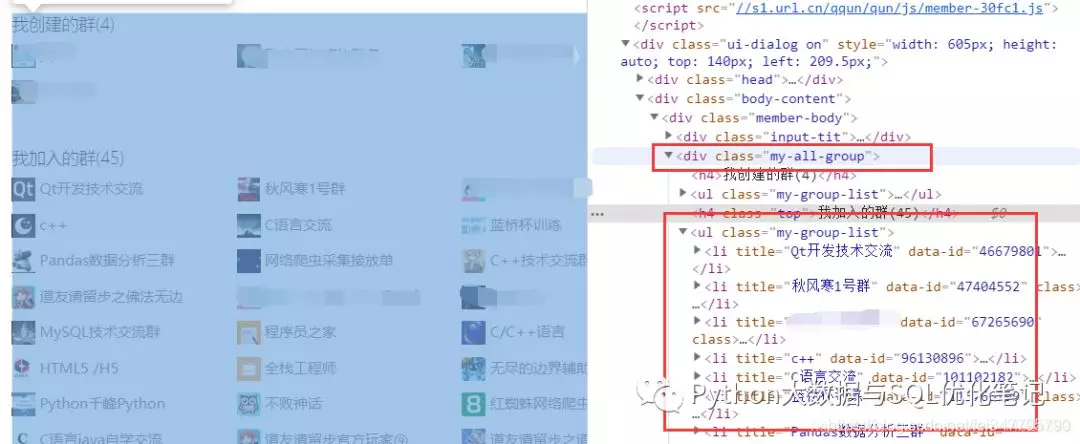

10.我们需要的是我加入的群信息

# 切换句柄之后,我们显示等待窗口出来

WebDriverWait(browser, 1000).until(

EC.presence_of_all_elements_located(

(By.CLASS_NAME, 'my-all-group')

)

)

# 筛选出我加入的群标签

lis = browser.find_elements_by_xpath('.//div[@class="my-all-group"]/ul[2]/li')

11.遍历列表,取出信息

# 遍历

num= 0

while True:

if num == len(lis):

break

try:

# 按顺序选择群并获取信息

# 先点击该群获取成员信息

lis[num].click()

# 显示等待信息加载完成

WebDriverWait(browser, 1000).until(

EC.presence_of_all_elements_located(

(By.CLASS_NAME, 'list')

)

)

# 获取该群当前有多少人,后面翻页需要

groupMemberNum = eval(browser.find_element_by_id('groupMemberNum').text)

# 每一次翻页都会刷新21条信息,所以写个循环

# 这里加1是因为假如一个群有36人,那么count=1,如果循环的话就不会翻页了

# 也就是只能抓到一页的数据,大家可以自己想想其中的流程就知道了

count = groupMemberNum // 21 + 1

# 这里我只爬取每个群的一部分,如果想爬取全部成员信息

# 请注释下面的if语句

if count > 2:

count = 1

# 每次循环都进行翻页

# while count:

# count -= 1

#

# browser.execute_script('document.documentElement.scrollTop=100000')

# time.sleep(2)

time.sleep(2)

# 开始获取成员信息

trs = browser.find_elements_by_class_name('mb')

if trs:

# 遍历

for tr in trs:

tds = tr.find_elements_by_tag_name('td')[2:]

if len(tds) == 8:

# qq网名

qq_name = tds[0].text

# 群名称

group_name = tds[1].text

# qq号

qq_number = tds[2].text

# 性别

gender = tds[3].text

# qq年龄

qq_year = tds[4].text

# 入群时间

join_time = tds[5].text

# 等级(积分)

level = None

# 最后发言时间

end_time = tds[6].text

# 声明一个字典存储数据

data_dict = {}

data_dict['qq_name'] = qq_name

data_dict['group_name'] = group_name

data_dict['qq_number'] = qq_number

data_dict['gender'] = gender

data_dict['qq_year'] = qq_year

data_dict['join_time'] = join_time

data_dict['level'] = level

data_dict['end_time'] = end_time

print(data_dict)

elif len(tds) == 9:

# qq网名

qq_name = tds[0].text

# 群名称

group_name = tds[1].text

# qq号

qq_number = tds[2].text

# 性别

gender = tds[3].text

# qq年龄

qq_year = tds[4].text

# 入群时间

join_time = tds[5].text

# 等级(积分)

level = tds[6].text

# 最后发言时间

end_time = tds[7].text

# 声明一个字典存储数据

data_dict = {}

data_dict['qq_name'] = qq_name

data_dict['group_name'] = group_name

data_dict['qq_number'] = qq_number

data_dict['gender'] = gender

data_dict['qq_year'] = qq_year

data_dict['join_time'] = join_time

data_dict['level'] = level

data_dict['end_time'] = end_time

data_list.append(data_dict)

print(data_dict)

browser.find_element_by_id('changeGroup').click()

time.sleep(3)

WebDriverWait(browser, 1000).until(

EC.presence_of_all_elements_located(

(By.CLASS_NAME, 'ui-dialog')

)

)

lis = browser.find_elements_by_xpath('.//div[@class="my-all-group"]/ul[2]/li')

num += 1

except Exception as e:

lis = browser.find_elements_by_xpath('.//div[@class="my-all-group"]/ul[2]/li')

num += 1

continue

完整代码附上

# 导入需要的包

# 爬取qq群的成员信息

from selenium import webdriver

from selenium.webdriver.support.ui import WebDriverWait

from selenium.webdriver.support import expected_conditions as EC

from selenium.webdriver.common.by import By

import time

import json

import csv

# 开始登陆

def login_spider():

url = 'https://qun.qq.com/'

# 构建谷歌驱动器

browser = webdriver.Chrome()

# 请求url

browser.get(url)

# 模拟登陆,首先找到登陆的id,并点击

browser.find_element_by_css_selector('#headerInfo p a').click()

# 点击之后会弹出一个登陆框,这时候我们用显示等待来等待这个登陆框加载出来

WebDriverWait(browser, 1000).until(

EC.presence_of_all_elements_located(

(By.CSS_SELECTOR, '#loginWin iframe')

)

)

print('登陆框已加载')

# 登陆框加载之后,我们发现整个登陆框其实就是另一个网网页

# 如果在原网页操作这个登陆框的话,是不能操作的

# 所以我们只需要提取iframe标签的src属性,然后再去访问这个url即可实现

# 自动登陆

# 找到iframe标签并获取是如此熟悉

iframe_url = browser.find_element_by_css_selector('#loginWin iframe').get_attribute('src')

# 再访问这个url

browser.get(iframe_url)

# 找到快捷登陆的头像并点击

# 首先用显示等待这个头像已经加载完成

WebDriverWait(browser, 1000).until(

EC.presence_of_all_elements_located(

(By.ID, 'qlogin_list')

)

)

browser.find_element_by_css_selector('#qlogin_list a').click()

print('登陆成功')

return browser

# 切换句柄操作

def switch_spider(browser):

# 登陆成功之后,我们就找到群管理的标签并点击,首先等待这个元素加载完成

WebDriverWait(browser, 1000).until(

EC.presence_of_all_elements_located(

(By.XPATH, './/ul[@id="headerNav"]/li[4]')

)

)

browser.find_element_by_xpath('.//ul[@id="headerNav"]/li[4]').click()

# 点击之后,我们找到成员管理标签并点击

WebDriverWait(browser, 1000).until(

EC.presence_of_all_elements_located(

(By.CLASS_NAME, 'color-tit')

)

)

browser.find_element_by_class_name('color-tit').click()

# 打印全部窗口句柄

# print(browser.window_handles)

# 打印当前窗口句柄

# print(browser.current_window_handle)

# 注意这里点击成员管理之后会自动跳转到一个新窗口打开这个页面

# 所以我们需要将窗口句柄切换到这个新窗口

browser.switch_to.window(browser.window_handles[1])

# 解释一下browser.switch_to.window是获取当前一共有几个窗口

# 这里是2个

# browser.switch_to.window这个是指定当前游标切换到哪个窗口

# 其实也可以这么写

# all_window = browser.switch_to.window返回的是一个列表

# browser.switch_to.window(all_window[1])

# 效果是一样的

return browser

# 开始采集数据

def start_spider(browser):

# 声明一个列表存储字典

data_list = []

# 切换句柄之后,我们显示等待窗口出来

WebDriverWait(browser, 1000).until(

EC.presence_of_all_elements_located(

(By.CLASS_NAME, 'my-all-group')

)

)

# 筛选出我加入的群标签

lis = browser.find_elements_by_xpath('.//div[@class="my-all-group"]/ul[2]/li')

# 遍历

num = 0

while True:

try:

# 按顺序选择群并获取信息

# 先点击该群获取成员信息

lis[num].click()

# 显示等待信息加载完成

WebDriverWait(browser, 1000).until(

EC.presence_of_all_elements_located(

(By.CLASS_NAME, 'list')

)

)

# 获取该群当前有多少人,后面翻页需要

groupMemberNum = eval(browser.find_element_by_id('groupMemberNum').text)

# 每一次翻页都会刷新21条信息,所以写个循环

# 这里加1是因为假如一个群有36人,那么count=1,如果循环的话就不会翻页了

# 也就是只能抓到一页的数据,大家可以自己想想其中的流程就知道了

count = groupMemberNum // 21 + 1

# 这里我只爬取每个群的一部分,如果想爬取全部成员信息

# 请注释下面的if语句

if count > 5:

count = 5

# 每次循环都进行翻页

while count:

count -= 1

browser.execute_script('document.documentElement.scrollTop=100000')

time.sleep(2)

time.sleep(3)

# 开始获取成员信息

trs = browser.find_elements_by_class_name('mb')

if trs:

# 遍历

for tr in trs:

tds = tr.find_elements_by_tag_name('td')[2:]

if len(tds) == 8:

# qq网名

qq_name = tds[0].text

# 群名称

group_name = tds[1].text

# qq号

qq_number = tds[2].text

# 性别

gender = tds[3].text

# qq年龄

qq_year = tds[4].text

# 入群时间

join_time = tds[5].text

# 等级(积分)

level = None

# 最后发言时间

end_time = tds[6].text

# 声明一个字典存储数据

data_dict = {}

data_dict['qq_name'] = qq_name

data_dict['group_name'] = group_name

data_dict['qq_number'] = qq_number

data_dict['gender'] = gender

data_dict['qq_year'] = qq_year

data_dict['join_time'] = join_time

data_dict['level'] = level

data_dict['end_time'] = end_time

print(data_dict)

elif len(tds) == 9:

# qq网名

qq_name = tds[0].text

# 群名称

group_name = tds[1].text

# qq号

qq_number = tds[2].text

# 性别

gender = tds[3].text

# qq年龄

qq_year = tds[4].text

# 入群时间

join_time = tds[5].text

# 等级(积分)

level = tds[6].text

# 最后发言时间

end_time = tds[7].text

# 声明一个字典存储数据

data_dict = {}

data_dict['qq_name'] = qq_name

data_dict['group_name'] = group_name

data_dict['qq_number'] = qq_number

data_dict['gender'] = gender

data_dict['qq_year'] = qq_year

data_dict['join_time'] = join_time

data_dict['level'] = level

data_dict['end_time'] = end_time

data_list.append(data_dict)

print(data_dict)

browser.find_element_by_id('changeGroup').click()

time.sleep(3)

WebDriverWait(browser, 1000).until(

EC.presence_of_all_elements_located(

(By.CLASS_NAME, 'ui-dialog')

)

)

lis = browser.find_elements_by_xpath('.//div[@class="my-all-group"]/ul[2]/li')

num += 1

except Exception as e:

continue

return data_list

def main():

browser = login_spider()

browser = switch_spider(browser)

data_list = start_spider(browser)

# 将数据写入json文件

with open('data_json.json', 'a+', encoding='utf-8') as f:

json.dump(data_list, f)

print('json文件写入完成')

# 这里的编码格式不要写错了,不然会出现乱码,因为群里面的大神名字贼骚

with open('data_csv.csv', 'w', encoding='utf-8-sig', newline='') as f:

# 表头

title = data_list[0].keys()

# 声明writer

writer = csv.DictWriter(f, title)

# 写入表头

writer.writeheader()

# 批量写入数据

writer.writerows(data_list)

print('csv文件写入完成')

if __name__ == '__main__':

main()

Python爬虫使用selenium爬取qq群的成员信息(全自动实现自动登陆)的更多相关文章

- python爬虫——用selenium爬取京东商品信息

1.先附上效果图(我偷懒只爬了4页) 2.京东的网址https://www.jd.com/ 3.我这里是不加载图片,加快爬取速度,也可以用Headless无弹窗模式 options = webdri ...

- python - 爬虫入门练习 爬取链家网二手房信息

import requests from bs4 import BeautifulSoup import sqlite3 conn = sqlite3.connect("test.db&qu ...

- 【转载】教你分分钟学会用python爬虫框架Scrapy爬取心目中的女神

原文:教你分分钟学会用python爬虫框架Scrapy爬取心目中的女神 本博文将带领你从入门到精通爬虫框架Scrapy,最终具备爬取任何网页的数据的能力.本文以校花网为例进行爬取,校花网:http:/ ...

- selenium爬取qq空间,requests爬取雪球网数据

一.爬取qq空间好友动态数据 # 爬取qq空间好友状态信息(说说,好友名称),并屏蔽广告 from selenium import webdriver from time import sleep f ...

- Python爬虫实例:爬取B站《工作细胞》短评——异步加载信息的爬取

很多网页的信息都是通过异步加载的,本文就举例讨论下此类网页的抓取. <工作细胞>最近比较火,bilibili 上目前的短评已经有17000多条. 先看分析下页面 右边 li 标签中的就是短 ...

- Python爬虫实例:爬取猫眼电影——破解字体反爬

字体反爬 字体反爬也就是自定义字体反爬,通过调用自定义的字体文件来渲染网页中的文字,而网页中的文字不再是文字,而是相应的字体编码,通过复制或者简单的采集是无法采集到编码后的文字内容的. 现在貌似不少网 ...

- Python爬虫实例:爬取豆瓣Top250

入门第一个爬虫一般都是爬这个,实在是太简单.用了 requests 和 bs4 库. 1.检查网页元素,提取所需要的信息并保存.这个用 bs4 就可以,前面的文章中已经有详细的用法阐述. 2.找到下一 ...

- python爬虫-基础入门-爬取整个网站《3》

python爬虫-基础入门-爬取整个网站<3> 描述: 前两章粗略的讲述了python2.python3爬取整个网站,这章节简单的记录一下python2.python3的区别 python ...

- python爬虫-基础入门-爬取整个网站《2》

python爬虫-基础入门-爬取整个网站<2> 描述: 开场白已在<python爬虫-基础入门-爬取整个网站<1>>中描述过了,这里不在描述,只附上 python3 ...

随机推荐

- B站弹幕爬取 / jieba分词 - 全站第一的视频弹幕都在说什么?

前言 本次爬取的视频av号为75993929(11月21的b站榜首),讲的是关于动漫革命机,这是一部超魔幻现实主义动漫(滑稽),有兴趣的可以亲身去感受一下这部魔幻大作. 准备工作 B站弹幕的爬取的接口 ...

- windows系统搭建Python环境

1.首先访问http://www.python.org/download/去下载最新的python版本. 2.安装下载包,一路next. 3.为计算机添加安装目录搭到环境变量,如图把python的安装 ...

- Jupyter Notebook 使用小记

简介 Jupyter Notebook 是一款几乎综合所有编程语言,能够把软件代码.计算输出.解释文档.多媒体资源整合在一起的多功能科学计算平台.具有如下优点: 整合所有资源 交互性编程体验 零成本重 ...

- Linux 磁盘分区、挂载

一.分区介绍 mbr分区: 1.最多支持四个主分区 2.系统只能安装在主分区上 3.扩展分区要占一个主分区 4.mbr最大只支持2TB,但拥有最好的兼容性 gpt分区: 1.支持无限多个主分区(但操作 ...

- 【Untiy】完美解决Untiy Package Manager无限加载的问题

直接上干货 打开记事本,复制一下zhei个 @echo offset HTTP_PROXY=127.0.0.1set HTTPS_PROXY=127.0.0.1start "" & ...

- Windows应急日志常用的几个事件ID

Windows应急日志常用的几个事件ID点击站内没有搜索到,可能搜索姿势不对,发一下吧,应急时可能会用到,根据日志时间点判断入侵 日志路径:C:\Windows\System32\winevt\Log ...

- ios中仿蚂蚁森林动画效果

参考链接:https://www.jianshu.com/p/0ba9d80f8e77 demo下载链接:https://gitee.com/ovix/TreeWithRandomFruitBtn

- 利用keras进行手写数字识别模型训练,并输出训练准确度

from keras.datasets import mnist (train_images, train_labels), (test_images, test_labels) = mnist.lo ...

- Thymeleaf常用语法:模板文件中表达式调用Java类的静态方法

在模板文件的表达式中,可以使用“${T(全限定类名).方法名(参数)}”这种格式来调用Java类的静态方法. 开发环境:IntelliJ IDEA 2019.2.2Spring Boot版本:2.1. ...

- Spring高级注解

目录: 1.使用限定注解:2.自定义限定注解:3.自定义bean的生命周期: 开发环境:IntelliJ IDEA 2019.2.2Spring Boot版本:2.1.8新建一个名称为demo的Spr ...