02 python爬虫-bs4

步骤

- 爬取主页面中的文章详情的url和图片地址

- 下载图片 并请求加文章详情中的页面内容

- 爬取文章详情中的标题、作者、发布时间

代码

import requests

import csv

from bs4 import BeautifulSoup

# 请求的一级页面的地址

q_url = 'http://xinfadi.com.cn/newsCenter.html?current=1'

def get_page():

headers = {

'user-agent': 'Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/83.0.4103.116 Safari/537.36 UOS'

}

r = requests.get(q_url, headers=headers)

r.encoding = 'utf-8'

res = r.text

return res

def parser_text(content):

# 把页面源代码交给BeautifulSoup进行处理,生成bs对象

# 从bs对象中查找数据

# find(标签,属性=值)

# find_all(标签,属性=值)

# return

soup = BeautifulSoup(content, 'html.parser')

# 找属性id=nowplaying的div 下的 class=list-item 的所有li find找一个 find_all找所有

# li_list = soup.find_all('ul', class_='list_con fl')

# attrs 和 class_ 是一个意思,此时可以避免class关键字

li_list = soup.find_all('ul', attrs={'class': 'list_con fl'})

data_list = list()

for li in li_list:

dataKV = {}

src = li.find('a') # 找li标签下的a标签

# http://xinfadi.com.cn + /news-118.html

dataKV['src'] = q_url.split('/newsCenter')[0] + src.get('href') # 获取href的值

# http://newlands-n.oss-cn-beijing.aliyuncs.com/IMAGE/bf1d68af-8966-4e1e-bcac-3a34233a6970.jpg

img = li.find('img') # 找li标签下的img标签

dataKV['img'] = img.get('src') # 获取src的值

# 下载图片

save_data_b(dataKV['img'])

# 请求详情页面

# http://xinfadi.com.cn/news-137.html

r = requests.get(dataKV['src'])

r.encoding = 'utf-8'

second_res = r.text

second_soup = BeautifulSoup(second_res, 'html.parser')

title = second_soup.find('span', attrs={'class': 'right'}).text

dataKV['title'] = title

spans = second_soup.find('div', attrs={'class': 'ssss'}).find_all('span')

dataKV['author'] = spans[0].text

dataKV['time'] = spans[1].text

data_list.append(dataKV)

# print("======" * 10)

return data_list

# 存为CSV

def save_data_csv(data_list):

headers = data_list[0].keys() # 获取标题

with open('new.csv', 'w', newline='', encoding='utf-8') as f:

f_csv = csv.DictWriter(f, headers)

f_csv.writeheader()

f_csv.writerows(data_list)

# 下载图片 、 mp4 、 zip 都可以这样下载

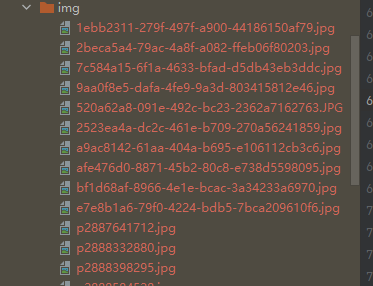

def save_data_b(url):

r = requests.get(url)

img_name = url.split("/")[-1] # p2892635176.jpg

with open('img/' + img_name, mode='wb') as f:

f.write(r.content)

if __name__ == '__main__':

# 步骤

# 1. 爬取主页面中的文章详情的url和图片地址

# 2. 下载图片 并请求加文章详情中的页面内容

# 3. 爬取文章详情中的标题、作者、发布时间

# 获取页面源代码

text = get_page()

# 解析源代码,获取需要的信息

data_list = parser_text(text)

# 存为csv数据

save_data_csv(data_list)

结果

new.csv

src,img,title,author,time

http://xinfadi.com.cn/news-137.html,http://newlands-n.oss-cn-beijing.aliyuncs.com/IMAGE/bf1d68af-8966-4e1e-bcac-3a34233a6970.jpg,【重要通知】新发地保供车辆司乘人员报备平台,admin,2022-10-13 17:49:47

http://xinfadi.com.cn/news-126.html,http://newlands-n.oss-cn-beijing.aliyuncs.com/IMAGE/2523ea4a-dc2c-461e-b709-270a56241859.jpg,【隆重招商】新发地全国名特优农产品销售中心全新招商,admin,2022-07-18 18:13:42

图片

02 python爬虫-bs4的更多相关文章

- python爬虫主要就是五个模块:爬虫启动入口模块,URL管理器存放已经爬虫的URL和待爬虫URL列表,html下载器,html解析器,html输出器 同时可以掌握到urllib2的使用、bs4(BeautifulSoup)页面解析器、re正则表达式、urlparse、python基础知识回顾(set集合操作)等相关内容。

本次python爬虫百步百科,里面详细分析了爬虫的步骤,对每一步代码都有详细的注释说明,可通过本案例掌握python爬虫的特点: 1.爬虫调度入口(crawler_main.py) # coding: ...

- python爬虫的页面数据解析和提取/xpath/bs4/jsonpath/正则(1)

一.数据类型及解析方式 一般来讲对我们而言,需要抓取的是某个网站或者某个应用的内容,提取有用的价值.内容一般分为两部分,非结构化的数据 和 结构化的数据. 非结构化数据:先有数据,再有结构, 结构化数 ...

- python爬虫入门02:教你通过 Fiddler 进行手机抓包

哟~哟~哟~ hi起来 everybody 今天要说说怎么在我们的手机抓包 通过 python爬虫入门01:教你在Chrome浏览器轻松抓包 我们知道了 HTTP 的请求方式 以及在 Chrome 中 ...

- Python爬虫--- 1.1请求库的安装与使用

来说先说爬虫的原理:爬虫本质上是模拟人浏览信息的过程,只不过他通过计算机来达到快速抓取筛选信息的目的所以我们想要写一个爬虫,最基本的就是要将我们需要抓取信息的网页原原本本的抓取下来.这个时候就要用到请 ...

- [Python爬虫] 使用 Beautiful Soup 4 快速爬取所需的网页信息

[Python爬虫] 使用 Beautiful Soup 4 快速爬取所需的网页信息 2018-07-21 23:53:02 larger5 阅读数 4123更多 分类专栏: 网络爬虫 版权声明: ...

- Python爬虫系统学习(1)

Python爬虫系统化学习(1) 前言:爬虫的学习对生活中很多事情都很有帮助,比如买房的时候爬取房价,爬取影评之类的,学习爬虫也是在提升对Python的掌握,所以我准备用2-3周的晚上时间,提升自己对 ...

- python 爬虫(二)

python 爬虫 Advanced HTML Parsing 1. 通过属性查找标签:基本上在每一个网站上都有stylesheets,针对于不同的标签会有不同的css类于之向对应在我们看到的标签可能 ...

- Python爬虫入门

Python爬虫简介(来源于维基百科): 网络爬虫始于一张被称作种子的统一资源地址(URLs)列表.当网络爬虫访问这些统一资源定位器时,它们会甄别出页面上所有的超链接,并将它们写入一张"待访列表",即 ...

- python爬虫代码

原创python爬虫代码 主要用到urllib2.BeautifulSoup模块 #encoding=utf-8 import re import requests import urllib2 im ...

- 一个简单的多线程Python爬虫(一)

一个简单的多线程Python爬虫 最近想要抓取拉勾网的数据,最开始是使用Scrapy的,但是遇到了下面两个问题: 前端页面是用JS模板引擎生成的 接口主要是用POST提交参数的 目前不会处理使用JS模 ...

随机推荐

- #平衡树#洛谷 1110 [ZJOI2007]报表统计

题目 分析 最小值只需要开两棵平衡树,一棵维护所有元素,一棵维护相邻最小值, 对于全局最小值,对于每次插入查找前驱后继更新最小值即可, 相邻最小值,对于每个原数列的数维护它的开头和结尾是什么数, 然后 ...

- MogDB企业应用 之 Rust驱动

引子 Rust 是一门系统编程语言,专注于安全,尤其是并发安全,支持函数式和命令式以及泛型等编程范式的多范式语言.Rust 在语法上和类似 C++,但是设计者想要在保证性能的同时提供更好的内存安全. ...

- HarmonyOS应用兼容稳定性云测试

兼容性测试 兼容性测试主要验证HarmonyOS应用在华为真机设备上运行的兼容性问题,包括首次安装.再次安装.启动.卸载.崩溃.黑白屏.闪退.运行错误.无法回退.无响应.设计约束场景.具体兼容性测 ...

- 开发指导—利用CSS动画实现HarmonyOS动效(二)

注:本文内容分享转载自HarmonyOS Developer官网文档 点击查看<开发指导-利用CSS动画实现HarmonyOS动效(一)> 3. background-position ...

- linux 性能自我学习 ———— 不可中断进程和僵尸进程 [四]

前言 简单介绍一下不可中断进程和僵尸进程. 正文 先来看下进程的状态: 那么这一列的状态是什么呢? R 是Running 或 Runnable 的缩写, 表示进程在cpu 的就绪队列中,正在运行或者正 ...

- button submit你以为你阻止了默认事件?

前言 先解决掉一个误区: 很多人写button的时候,就这样写: <button><botton> 你认为就是默认的submit的时候,这时候就可能出问题了. 当然之所以你没有 ...

- 重走py 之路 ——普通操作与函数(三)

前言 本节主要介绍函数,但是函数是由操作组成的.那么就分为两部,一部分为操作一部分为函数. 正文 py世界中的操作. 操作 if: 在学习任何一门语言中,关系if,要关系另外一件事,那就是if是否只能 ...

- MVC如何创建区域

前言 MVC 划分区域可以为项目成立不同的小模块,方便团队之间开发,与增强项目结构的清晰度. 正文 建立区域: 在areas里面建立区域.,然后填写命名. 然后区域注册即可: 但是这样做依然无法解决项 ...

- 龙蜥社区开源 coolbpf,BPF 程序开发效率提升百倍 | 龙蜥技术

简介: coolbpf,可以酷玩的BPF!来看看让BPF加了双翅膀的它究竟有多硬核? 文/系统运维 SIG(Special Interest Group) 引言 BPF 是一个新的动态跟踪技术,目前这 ...

- 千万商家的智能决策引擎--AnalyticDB如何助力生意参谋双十一

作者:算法&健兮,阿里巴巴数据技术及产品部技术专家 生意参谋介绍 生意参谋是阿里官方打造的全渠道.全链路.一站式数据平台,致力于为用户提供经营分析.市场洞察.客群洞察等多样化数据服务,帮助用户 ...