week07 codelab02 C72

ss

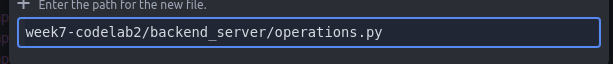

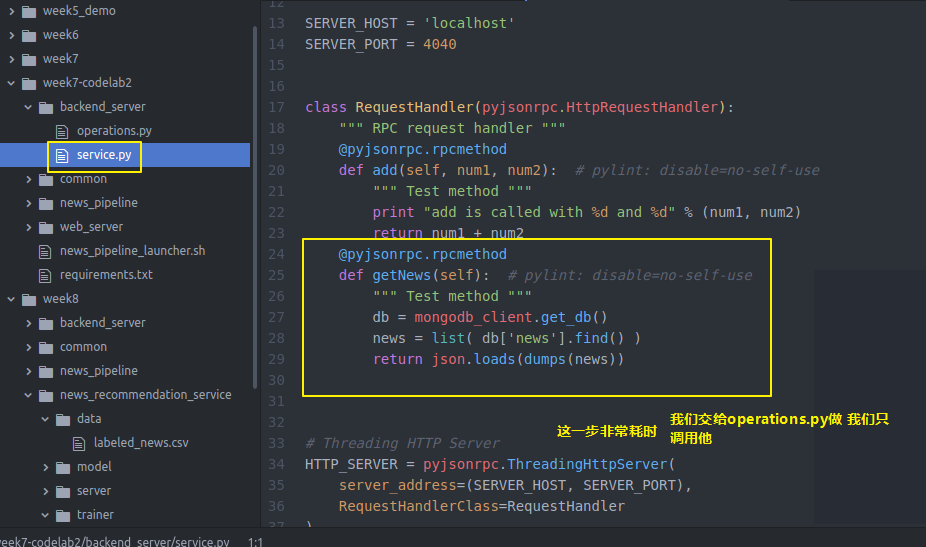

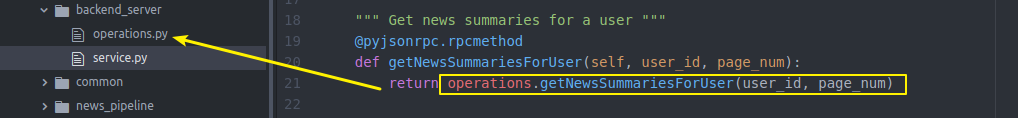

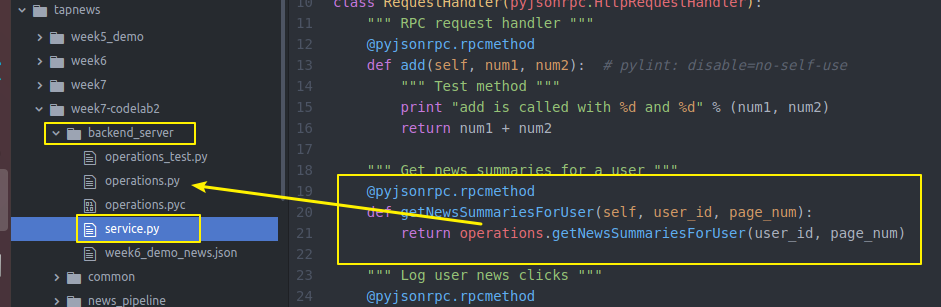

我们要改一下backendserver的service

因为要写几个api还要做很多操作

我们单独写出来 然后由service来调用

import json

import os

import pickle

import random

import redis

import sys from bson.json_util import dumps

from datetime import datetime # import common package in parent directory

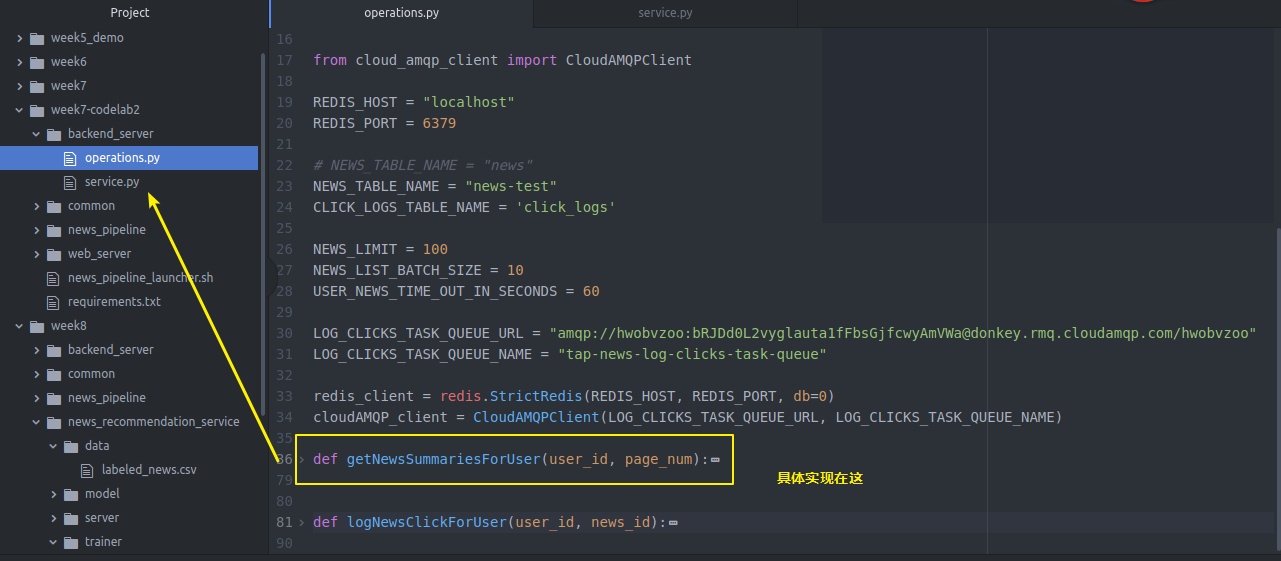

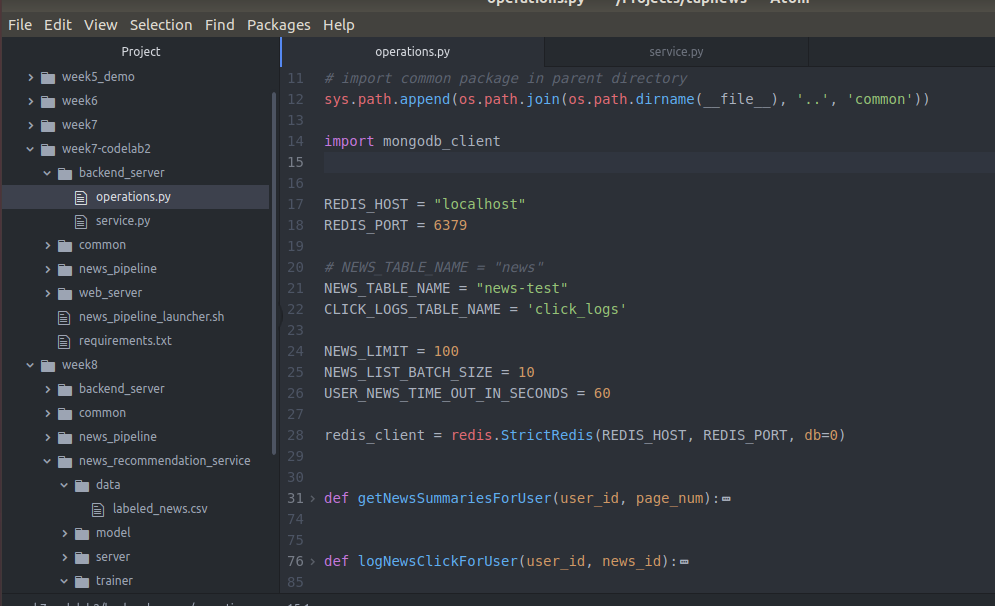

sys.path.append(os.path.join(os.path.dirname(__file__), '..', 'common')) import mongodb_client REDIS_HOST = "localhost"

REDIS_PORT = # NEWS_TABLE_NAME = "news"

NEWS_TABLE_NAME = "news-test"

CLICK_LOGS_TABLE_NAME = 'click_logs' NEWS_LIMIT =

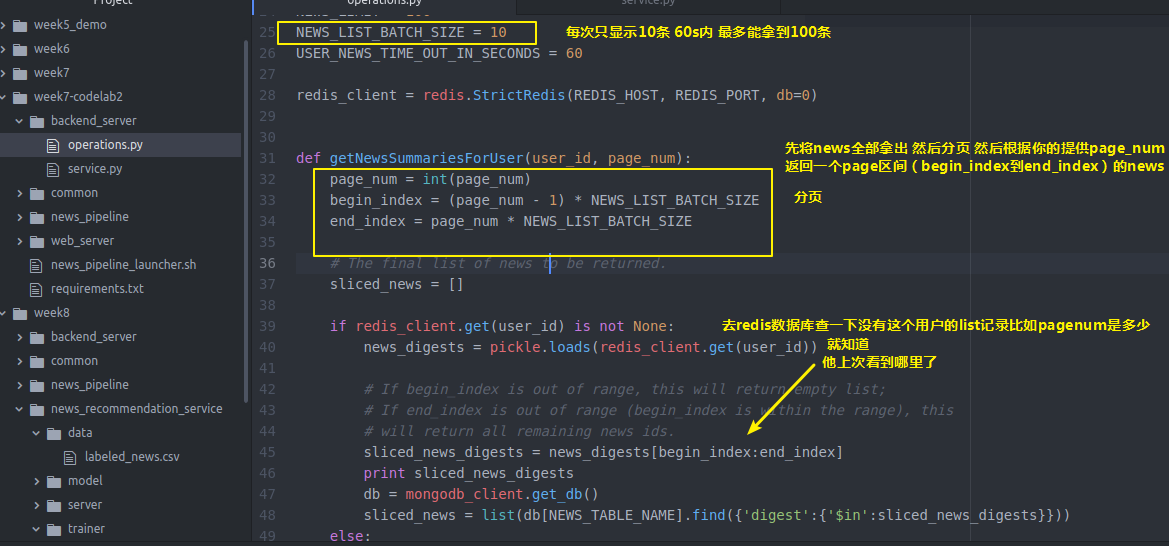

NEWS_LIST_BATCH_SIZE =

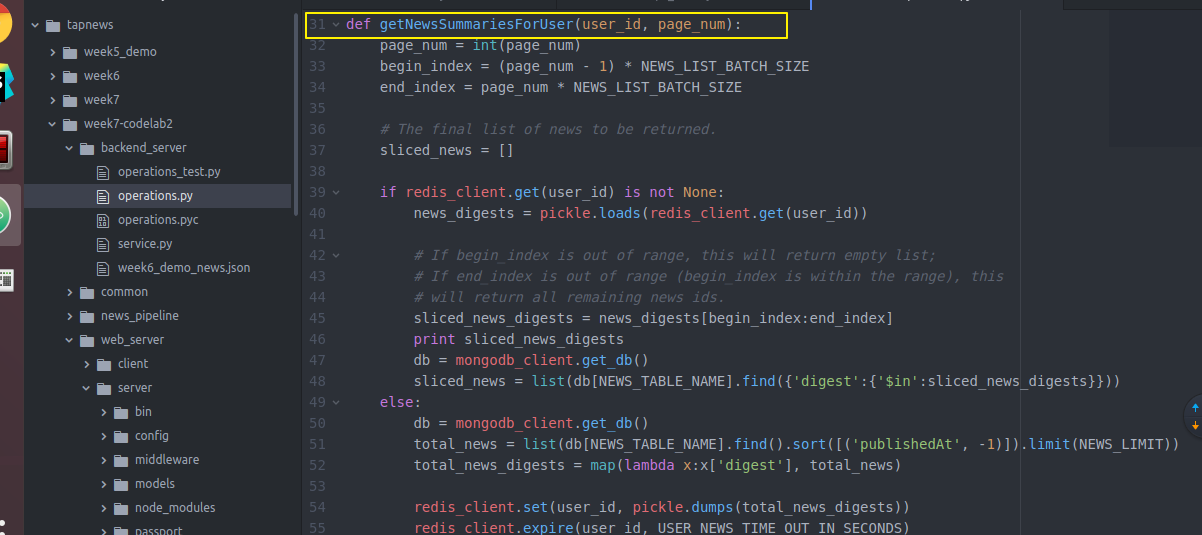

USER_NEWS_TIME_OUT_IN_SECONDS = redis_client = redis.StrictRedis(REDIS_HOST, REDIS_PORT, db=) def getNewsSummariesForUser(user_id, page_num):

page_num = int(page_num)

begin_index = (page_num - ) * NEWS_LIST_BATCH_SIZE

end_index = page_num * NEWS_LIST_BATCH_SIZE # The final list of news to be returned.

sliced_news = [] if redis_client.get(user_id) is not None:

news_digests = pickle.loads(redis_client.get(user_id)) # If begin_index is out of range, this will return empty list;

# If end_index is out of range (begin_index is within the range), this

# will return all remaining news ids.

sliced_news_digests = news_digests[begin_index:end_index]

print sliced_news_digests

db = mongodb_client.get_db()

sliced_news = list(db[NEWS_TABLE_NAME].find({'digest':{'$in':sliced_news_digests}}))

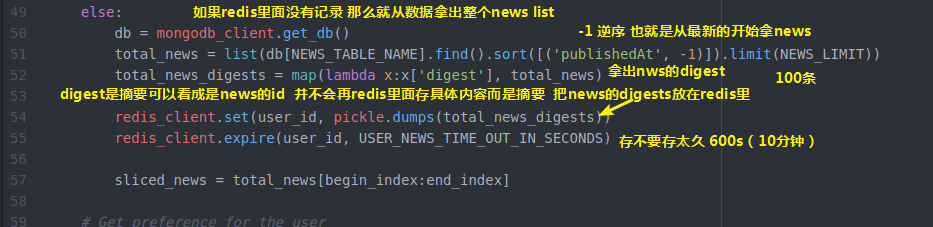

else:

db = mongodb_client.get_db()

total_news = list(db[NEWS_TABLE_NAME].find().sort([('publishedAt', -)]).limit(NEWS_LIMIT))

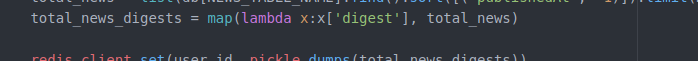

total_news_digests = map(lambda x:x['digest'], total_news) redis_client.set(user_id, pickle.dumps(total_news_digests))

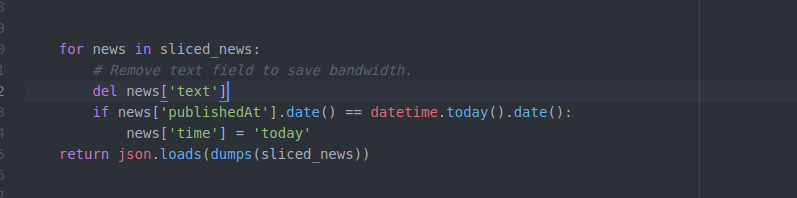

redis_client.expire(user_id, USER_NEWS_TIME_OUT_IN_SECONDS) sliced_news = total_news[begin_index:end_index] for news in sliced_news:

# Remove text field to save bandwidth.

del news['text']

if news['publishedAt'].date() == datetime.today().date():

news['time'] = 'today'

return json.loads(dumps(sliced_news))

operations.py

具体实现

可以自己设置这个过期时间

我们都是下拉获得新闻 你也可以设计一个向上拉强制刷新的功能 比如向上拉触发一个函数cleanRedis来强制清空redis(类似新浪知乎)这样 即使100条获取完了没得获取了

也能强制刷新列表(之后写吧)

import json

import os

import pickle

import random

import redis

import sys from bson.json_util import dumps

from datetime import datetime # import common package in parent directory

sys.path.append(os.path.join(os.path.dirname(__file__), '..', 'common')) import mongodb_client REDIS_HOST = "localhost"

REDIS_PORT = # NEWS_TABLE_NAME = "news"

NEWS_TABLE_NAME = "news-test"

CLICK_LOGS_TABLE_NAME = 'click_logs' NEWS_LIMIT =

NEWS_LIST_BATCH_SIZE =

USER_NEWS_TIME_OUT_IN_SECONDS = redis_client = redis.StrictRedis(REDIS_HOST, REDIS_PORT, db=) def getNewsSummariesForUser(user_id, page_num):

page_num = int(page_num)

begin_index = (page_num - ) * NEWS_LIST_BATCH_SIZE

end_index = page_num * NEWS_LIST_BATCH_SIZE # The final list of news to be returned.

sliced_news = [] if redis_client.get(user_id) is not None:

news_digests = pickle.loads(redis_client.get(user_id)) # If begin_index is out of range, this will return empty list;

# If end_index is out of range (begin_index is within the range), this

# will return all remaining news ids.

sliced_news_digests = news_digests[begin_index:end_index]

print sliced_news_digests

db = mongodb_client.get_db()

sliced_news = list(db[NEWS_TABLE_NAME].find({'digest':{'$in':sliced_news_digests}}))

else:

db = mongodb_client.get_db()

total_news = list(db[NEWS_TABLE_NAME].find().sort([('publishedAt', -)]).limit(NEWS_LIMIT))

total_news_digests = map(lambda x:x['digest'], total_news) redis_client.set(user_id, pickle.dumps(total_news_digests))

redis_client.expire(user_id, USER_NEWS_TIME_OUT_IN_SECONDS) sliced_news = total_news[begin_index:end_index] for news in sliced_news:

# Remove text field to save bandwidth.

del news['text']

if news['publishedAt'].date() == datetime.today().date():

news['time'] = 'today'

return json.loads(dumps(sliced_news))

operations.py

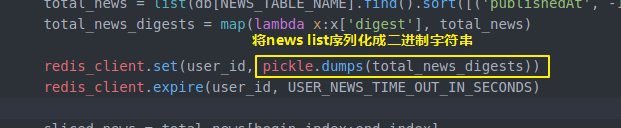

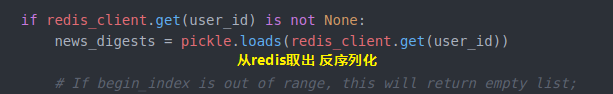

上面代码提到的比如 lamda表达式配合map摘取新闻中的digest字段

还有pickle对字符串序列化和反序列化

配合使用

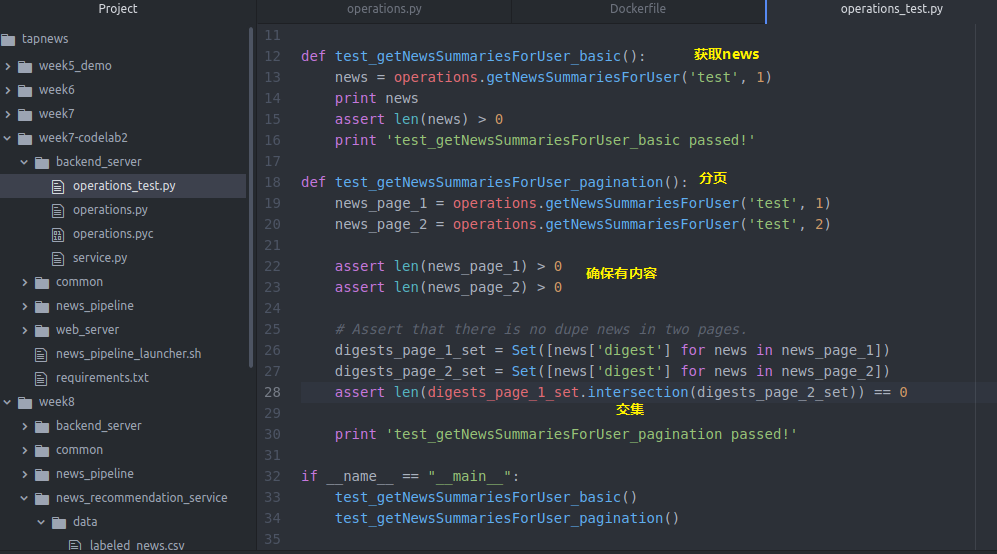

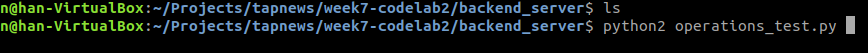

我们写个test

import operations

import os

import sys from sets import Set # import common package in parent directory

sys.path.append(os.path.join(os.path.dirname(__file__), '..', 'common')) # Start Redis and MongoDB before running following tests. def test_getNewsSummariesForUser_basic():

news = operations.getNewsSummariesForUser('test', )

print news

assert len(news) >

print 'test_getNewsSummariesForUser_basic passed!' def test_getNewsSummariesForUser_pagination():

news_page_1 = operations.getNewsSummariesForUser('test', )

news_page_2 = operations.getNewsSummariesForUser('test', ) assert len(news_page_1) >

assert len(news_page_2) > # Assert that there is no dupe news in two pages.

digests_page_1_set = Set([news['digest'] for news in news_page_1])

digests_page_2_set = Set([news['digest'] for news in news_page_2])

assert len(digests_page_1_set.intersection(digests_page_2_set)) == print 'test_getNewsSummariesForUser_pagination passed!' if __name__ == "__main__":

test_getNewsSummariesForUser_basic()

test_getNewsSummariesForUser_pagination()

operations_test.py

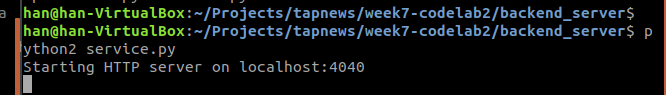

下面我们来运行一下

后端api完成让那个了

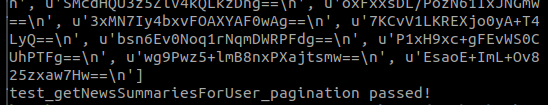

没回到前端webserver的client的Base

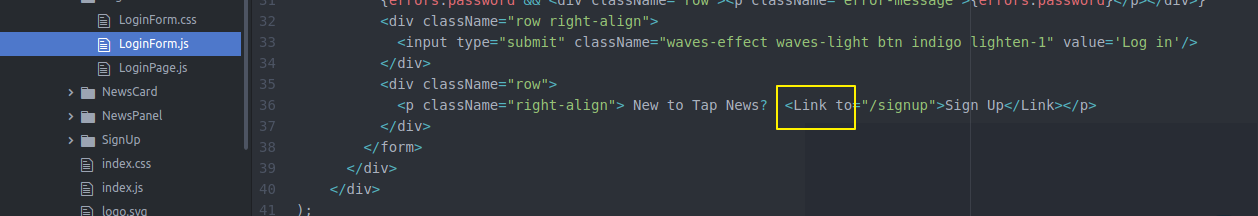

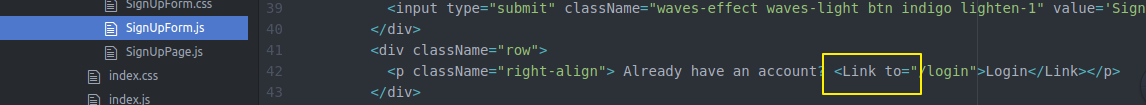

将原来的超链接换成router的link to

同理 loginForm也要修改

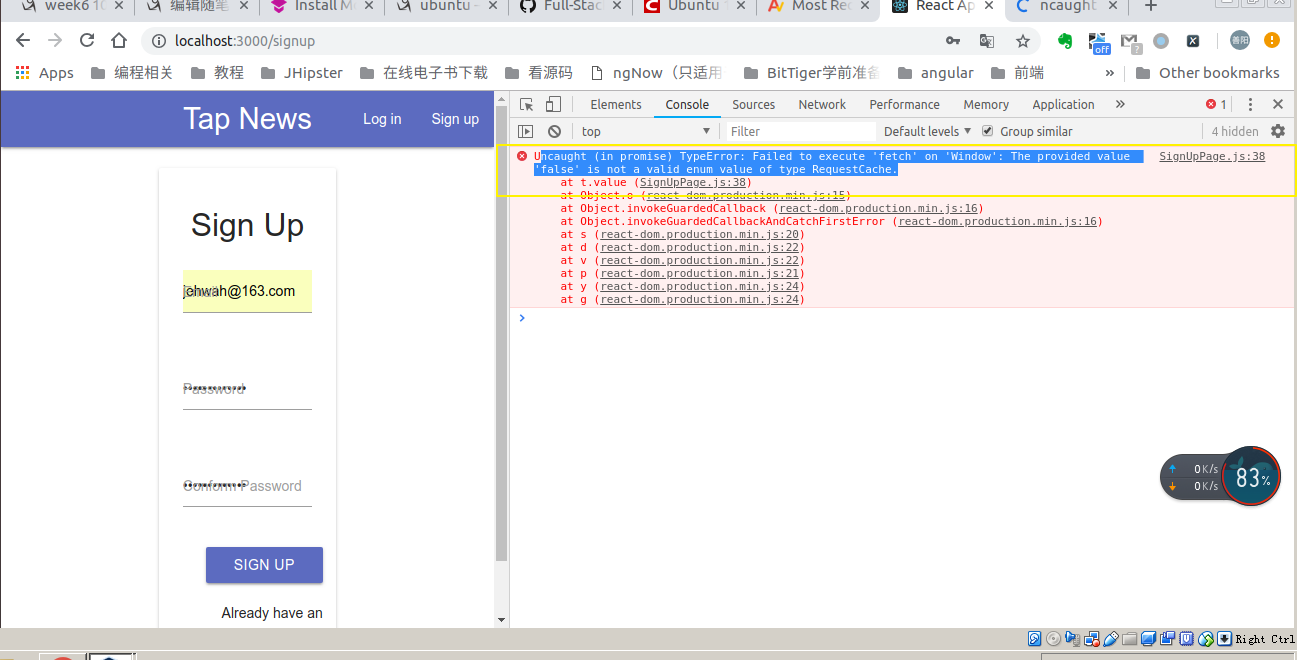

signup也是.

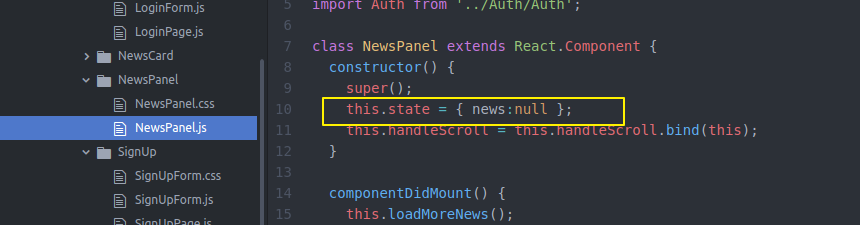

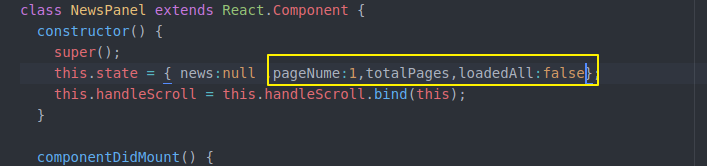

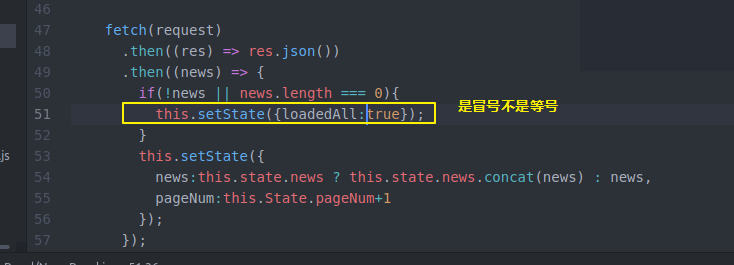

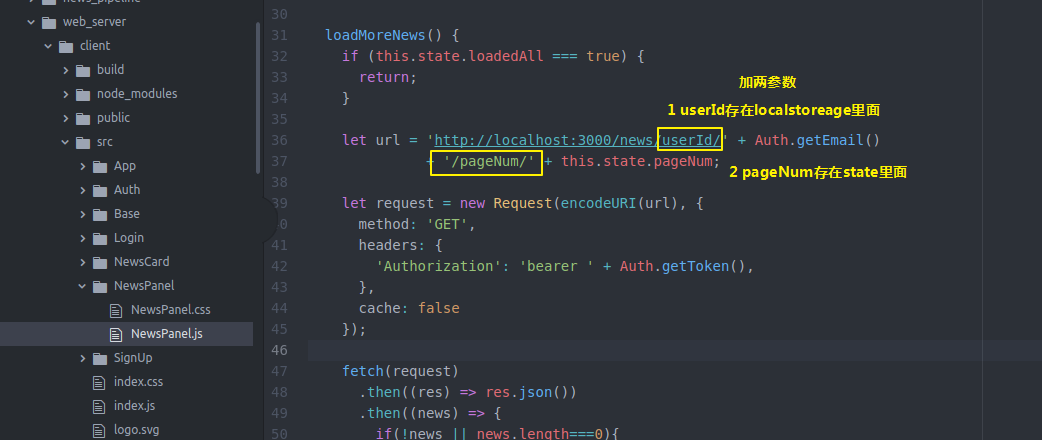

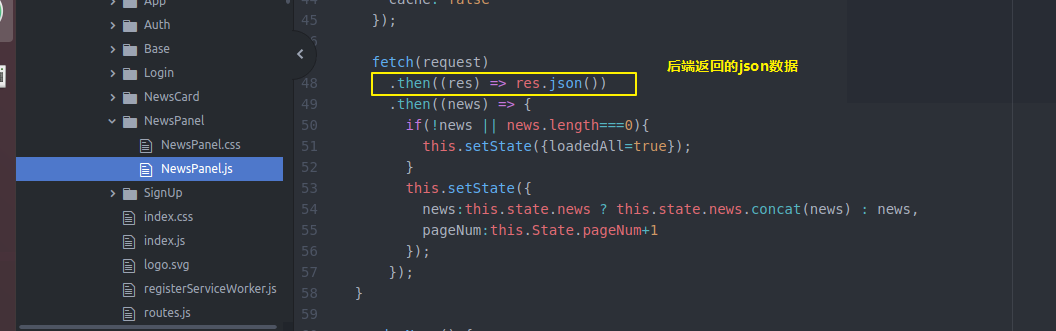

然后还要在NewsPannel做一些工作 之前比较简单 只是state保存一些信息 通过loadmorenews获得更多news

现在我们state除了这些 还要记录分页 总页数 加载完没有

然后loadmorenews

然后做个判断

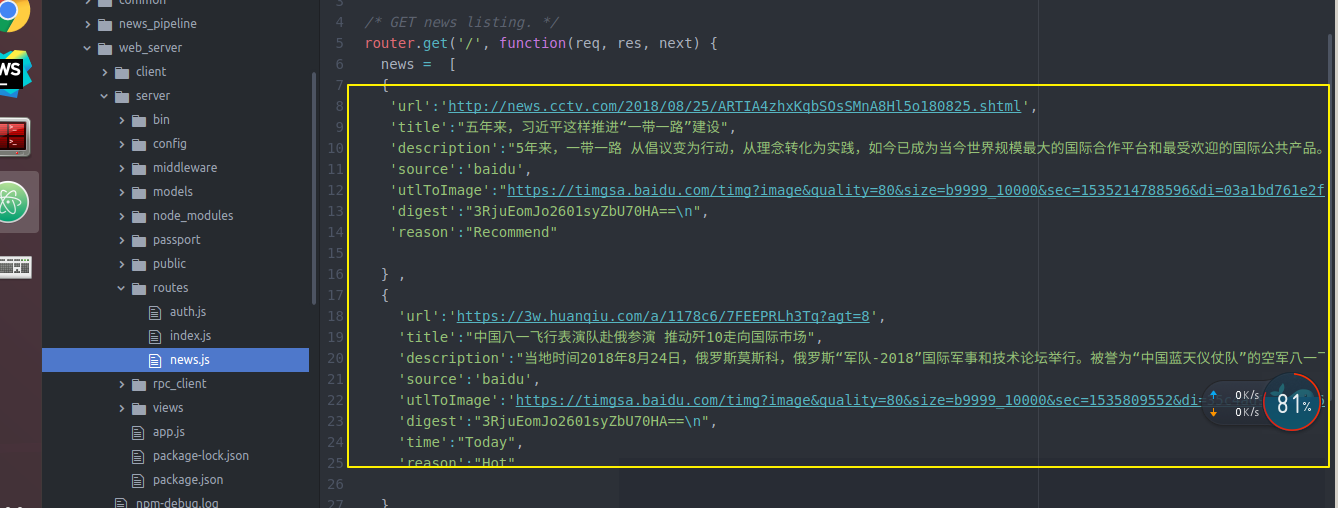

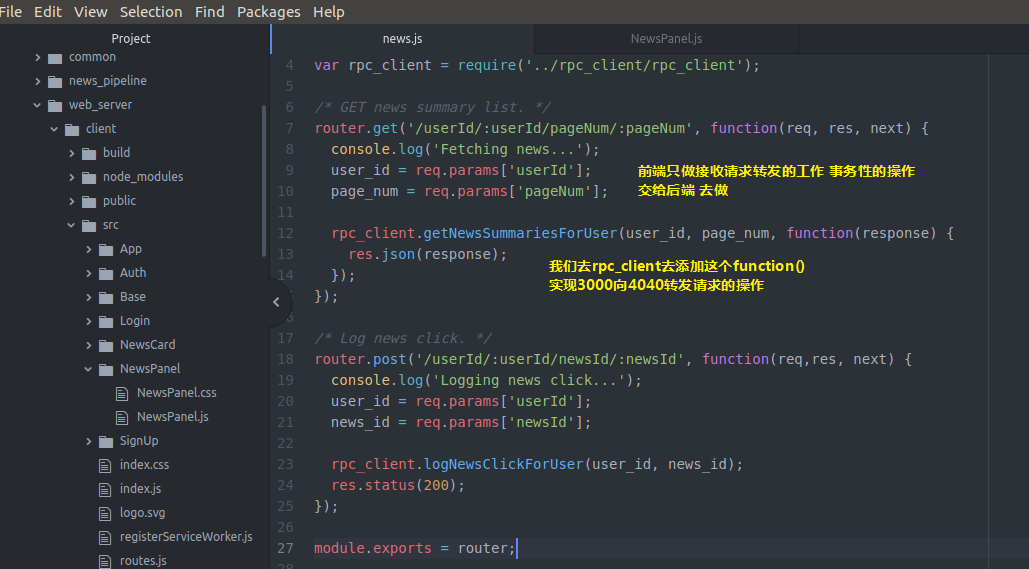

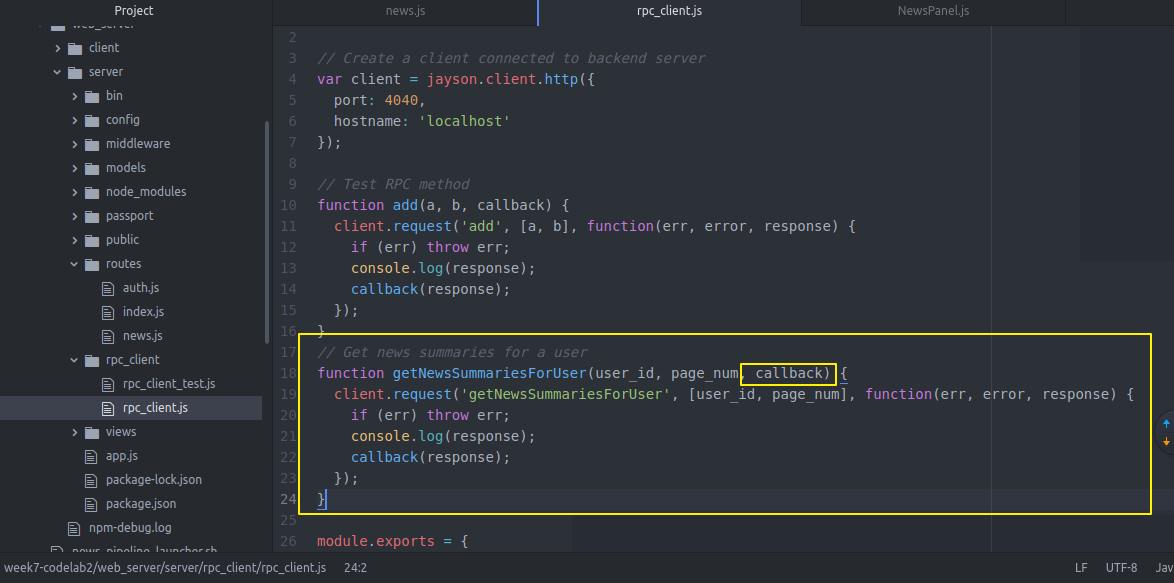

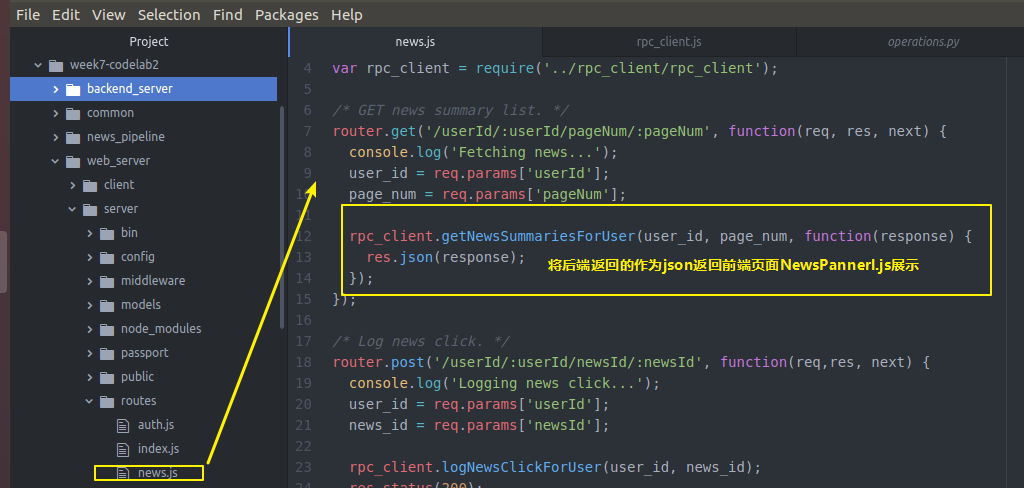

然后 还记得我们的获取新闻的api对象的webserver的server端的news.js是临时数据

news.js吗 我们去修改一下 让他从真正的后端backendserver从数据库拿数据

var express = require('express');

var router = express.Router();

var rpc_client = require('../rpc_client/rpc_client');

/* GET news summary list. */

router.get('/userId/:userId/pageNum/:pageNum', function(req, res, next) {

console.log('Fetching news...');

user_id = req.params['userId'];

page_num = req.params['pageNum'];

rpc_client.getNewsSummariesForUser(user_id, page_num, function(response) {

res.json(response);

});

});

/* Log news click. */

router.post('/userId/:userId/newsId/:newsId', function(req,res, next) {

console.log('Logging news click...');

user_id = req.params['userId'];

news_id = req.params['newsId'];

rpc_client.logNewsClickForUser(user_id, news_id);

res.status();

});

module.exports = router;

news.js

所以我们回去带上这两个参数

ok

再回到webserver server去

然后我们的真正的后端backend server

具体实现

等这些操作完成后又回到web server的server去了

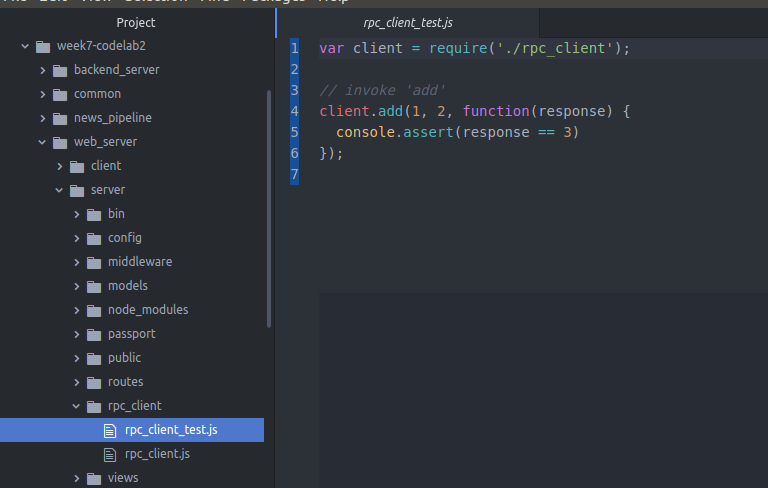

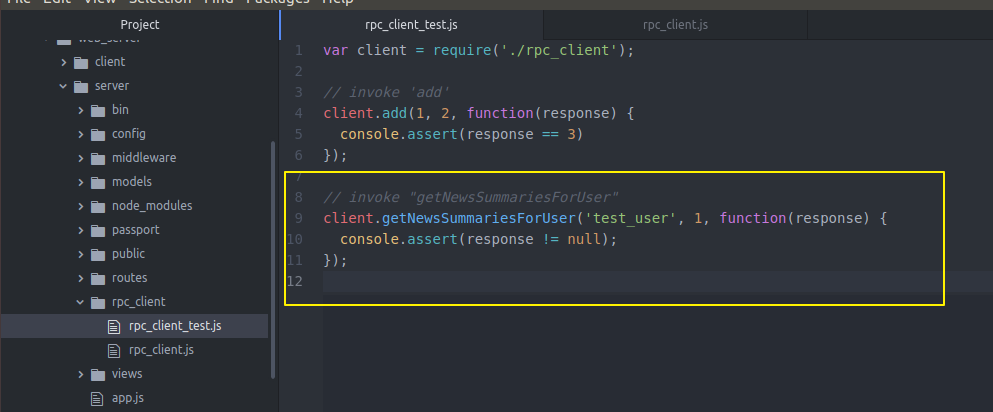

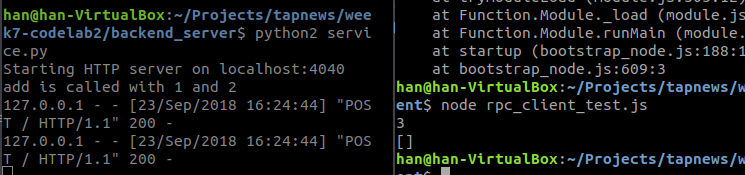

我们洗个test验证一下

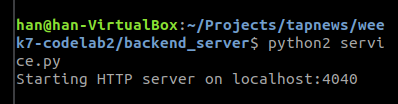

我们先将后端骑起来

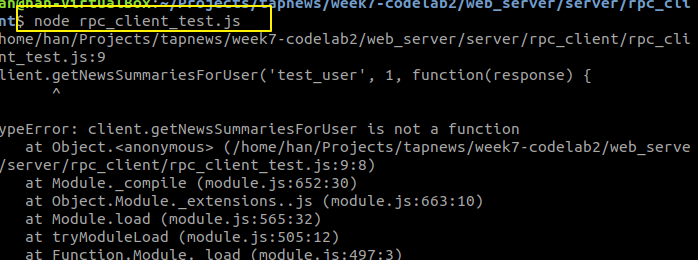

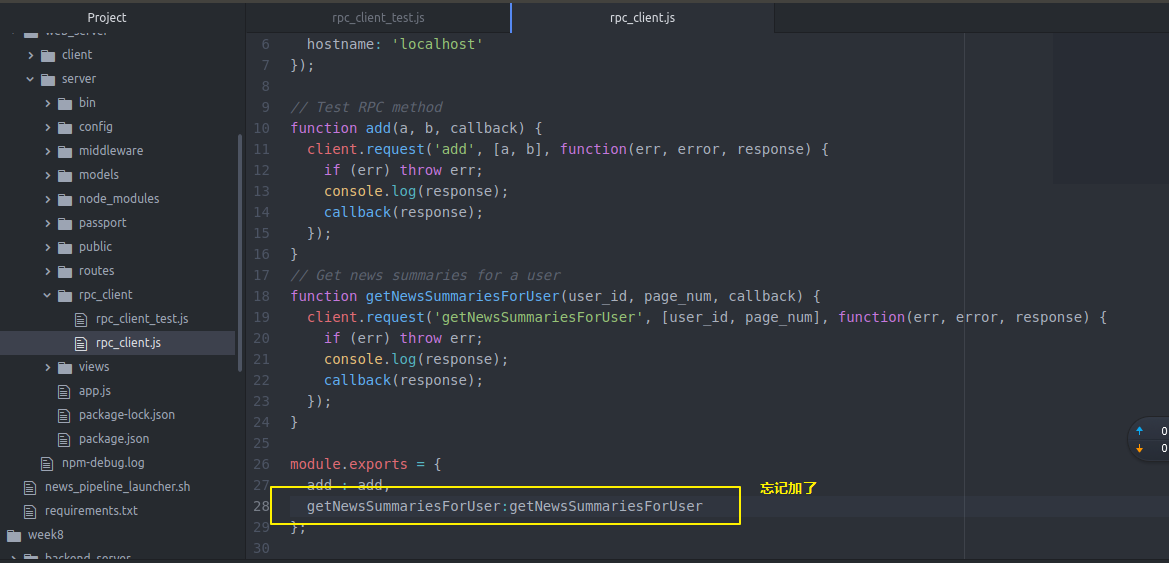

他说找不到这个方法

我们去看看

在运行

返回空 因为没有这个userid

下面前端和后端调通(从网页上看到效果)

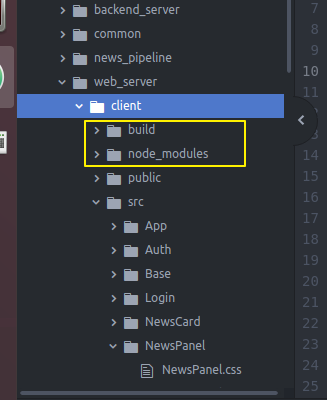

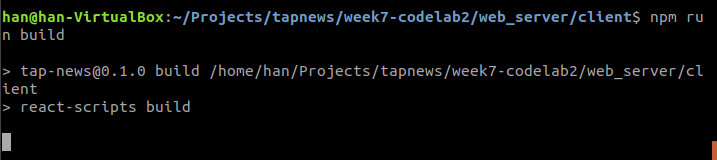

首先在web server的client先build一下(将前端页面文件传到build文件中)

然后去server 起一个端口 npm start 就可以只开一个端口来调试了

week07 codelab02 C72的更多相关文章

- Week07《Java程序设计》第七次作业总结

Week07<Java程序设计>第七次作业总结 1. 本周学习总结 1.1 思维导图:Java图形界面总结 答: 1.2 可选:使用常规方法总结其他上课内容. 答: 1. Swing组件: ...

- 20162328蔡文琛week07

学号 2016-2017-2 <程序设计与数据结构>第X周学习总结 教材学习内容总结 多态引用在不同的时候可以指向不同类型的对象. 多态引用在运行时才将方法调用用于它的定义绑定在一起. 引 ...

- week07 13.3 NewsPipeline之 三News Deduper之 tf_idf 查重

我们运行看结果 安装包sklearn 安装numpy 安装scipy 终于可以啦 我们把安装的包都写在文件里面吧 4行4列 轴对称 只需要看一半就可以 横着看 竖着看都行 数值越接近1 表示越相似 我 ...

- week07 13.4 NewsPipeline之 三 News Deduper

还是循环将Q2中的东西拿出来 然后查重(去mongodb里面把一天之内的新闻都拿出来,然后把拿到的新的新闻和mongodb里一天内的新闻组一个 tf-idf的对比)可看13.3 相似度检查 如果超过一 ...

- week07 13.2 NewsPipeline之 二 News Fetcher - Xpath

我们使用Xpath来专门做一个scrapter 我们专门弄个文件夹 里面全部是 各个新闻源(CNN BBC等)的scraper来抓取网站的text内容 主要函数(就是传入text内容的那个url)然后 ...

- week07 13.1 NewsPipeline之 一 NewsMonitor

我们要重构一下代码 因为我们之前写了utils 我们的NewsPipeline部分也要用到 所以我们把他们单独独立得拿出来 删掉原来的 将requirements.txt也拿出去 现在我们搬家完成 我 ...

- 20162328蔡文琛 大二week07

20162328 2017-2018-1 <程序设计与数据结构>第7周学习总结 教材学习内容总结 树是非线性结构,其元素组织为一个层次结构. 树的度表示树种任意节点的最大子节点数. 有m个 ...

- Python基础-week07 Socket网络编程

一 客户端/服务器架构 1.定义 又称为C/S架构,S 指的是Server(服务端软件),C指的是Client(客户端软件) 本章的中点就是教大写写一个c/s架构的软件,实现服务端软件和客户端软件基于 ...

- shell脚本批量收集linux服务器的硬件信息快速实现

安装ansible批量管理系统.(没有的话,ssh远程命令循环也可以) 在常用的数据库里面新建一张表,用你要收集的信息作为列名,提供可以用shell插入.

随机推荐

- layer.open弹出窗口后在子页面修改弹窗的title

在子页面修改layer.open弹窗的title,代码如下: var index = parent.layer.getFrameIndex(window.name); //先得到当前iframe层的索 ...

- 剑指offer 5.栈和队列 用两个栈实现队列

题目描述 用两个栈来实现一个队列,完成队列的Push和Pop操作. 队列中的元素为int类型. 解题思路:1,整体思路是元素先依次进入栈1,再从栈1依次弹出到栈2,然后弹出栈2顶部的元素,整个过程 ...

- 图形化SVN管理搭建 subversion edge自行修改密码

参考文章: https://blog.csdn.net/buyaore_wo/article/details/84313467 安装版本: Subversion Edge 5.2.3 (Linux 6 ...

- C# winform使用combobox遍历文件夹内所有文件

参考:https://www.cnblogs.com/hxh88/p/5814291.html 相关函数解析: 1.指定目录包含的文件和子目录 DirectoryInfo.GetFiles():获取目 ...

- Linux基础入门-文件系统操作与磁盘管理

一.简单文件系统操作: df (-h) 查看磁盘容量: rootfs作为系统启动时内核载入内存之后,在挂载真正的磁盘之前的一个临时文件系统: /dev/sda2 对应主机硬盘的分区,后面的a表示第几块 ...

- Excel文件上传,高亮错误的行和列

/// <summary> /// Excel模板写入错误信息 /// </summary> /// <param name="fileName"&g ...

- python基础知识13---函数对象、函数嵌套、名称空间与作用域、装饰器

阅读目录 一 函数对象 二 函数嵌套 三 名称空间与作用域 四 闭包函数 五 装饰器 六 练习题 一 函数对象 1 函数是第一类对象,即函数可以当作数据传递 #1 可以被引用 #2 可以当作参数传递 ...

- MariaDB——(一)CentOS 6.5 下 MariaDB 10.0.15 YUM 安装

1.配置yum源: 在MariaDB官网提供了yum源在线生成器,选择合适的系统和版本后,会生成所需的repo文件内容: 在/etc/yum.repos.d/目录下新建一个MariaDB.repo文件 ...

- outlook 2013撤消已经发送的邮件

使用Outlook 2013发送邮件的时候,发送后,发现邮件写错了或者其它原因需要撤消发送邮件,这里介绍一下. 工具/原料 outlook 2013 方法/步骤 需要打开已经发送的邮件 点 ...

- note 12 集合Set

集合Set +无序不重复元素(键)集 +和字典类似,但是无"值" 创建 x = set() x = {key1,key2,...} 添加和删除 x.add('body') x.re ...