python爬虫学习之使用BeautifulSoup库爬取开奖网站信息-模块化

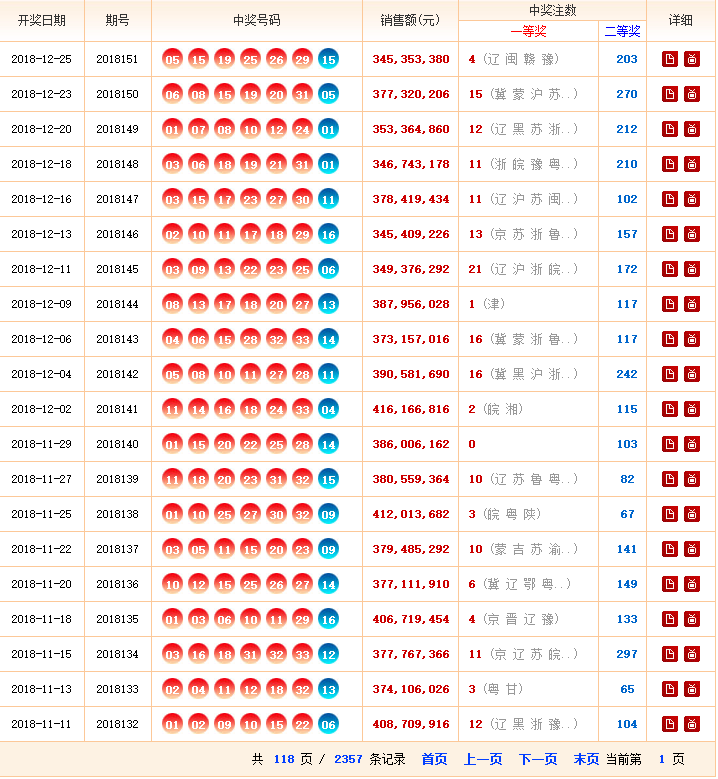

实例需求:运用python语言爬取http://kaijiang.zhcw.com/zhcw/html/ssq/list_1.html这个开奖网站所有的信息,并且保存为txt文件和excel文件。

实例环境:python3.7

BeautifulSoup库、xlwt库(需手动安装)

urllib库、re库(内置的python库,无需手动安装)

实例网站:

第一步,点击链接http://kaijiang.zhcw.com/zhcw/html/ssq/list_1.html进入网站,查看网站基本信息,注意一共要爬取118页数据。

第二步,查看网页源代码,熟悉网页结构,标签等信息。

实例思路:

一个爬虫程序的结构:

1、调度模块(Scheduler):安排发起网络请求的策略

2、网络模块(network):发起网络请求,并接受服务器返回

3、爬虫模块(Spider):解析、爬取数据

4、Item模块:定义爬取的数据项

5、Piplines模块:对已经爬取的数据做后续处理(存入数据库、存入文件系统、传递给流式处理框架,等等)

下面的示例程序基本实现了上述几个模板

实例代码:

getWinningNum.py

#encoding=utf-8 import re

from bs4 import BeautifulSoup

import urllib.request

from save2excel import SavaBallDate #4、 Item模块 定义爬取的数据项

class DoubleColorBallItem(object):

date = None

order = None

red1 = None

red2 = None

red3 = None

red4 = None

red5 = None

red6 = None

blue = None

money = None

firstPrize = None

secondPrize = None class GetDoubleColorBallNumber(object):

def __init__(self):

self.urls = []

self.urls = self.getUrls()

self.items = self.spider(self.urls)

self.pipelines(self.items)

SavaBallDate(self.items) # 获取 urls 的函数

def getUrls(self):

URL = r'http://kaijiang.zhcw.com/zhcw/html/ssq/list_1.html'

htmlContent = self.getResponseContent(URL)

soup = BeautifulSoup(htmlContent, 'lxml')

tag = soup.find_all('p')[-1]

pages = tag.strong.get_text()

for i in range(1, int(pages)+1):

url = r'http://kaijiang.zhcw.com/zhcw/html/ssq/list_' + str(i) + '.html'

self.urls.append(url)

return self.urls #3、 网络模块(NETWORK)发起网络请求,并接受服务器返回

def getResponseContent(self, url):

try:

response = urllib.request.urlopen(url)

except URLError as e:

raise e

else:

return response.read().decode("utf-8") #3、 爬虫模块(Spider) 解析、爬取数据

def spider(self,urls):

items = []

for url in urls:

try:

htmlContent = self.getResponseContent(url)

soup = BeautifulSoup(htmlContent, 'lxml')

tags = soup.find_all('tr', attrs={})

for tag in tags:

if tag.find('em'):

item = DoubleColorBallItem()

tagTd = tag.find_all('td')

item.date = tagTd[0].get_text()

item.order = tagTd[1].get_text()

tagEm = tagTd[2].find_all('em')

item.red1 = tagEm[0].get_text()

item.red2 = tagEm[1].get_text()

item.red3 = tagEm[2].get_text()

item.red4 = tagEm[3].get_text()

item.red5 = tagEm[4].get_text()

item.red6 = tagEm[5].get_text()

item.blue = tagEm[6].get_text()

item.money = tagTd[3].find('strong').get_text()

item.firstPrize = tagTd[4].find('strong').get_text()

item.secondPrize = tagTd[5].find('strong').get_text()

items.append(item)

except Exception as e:

raise e

# print(str(e))

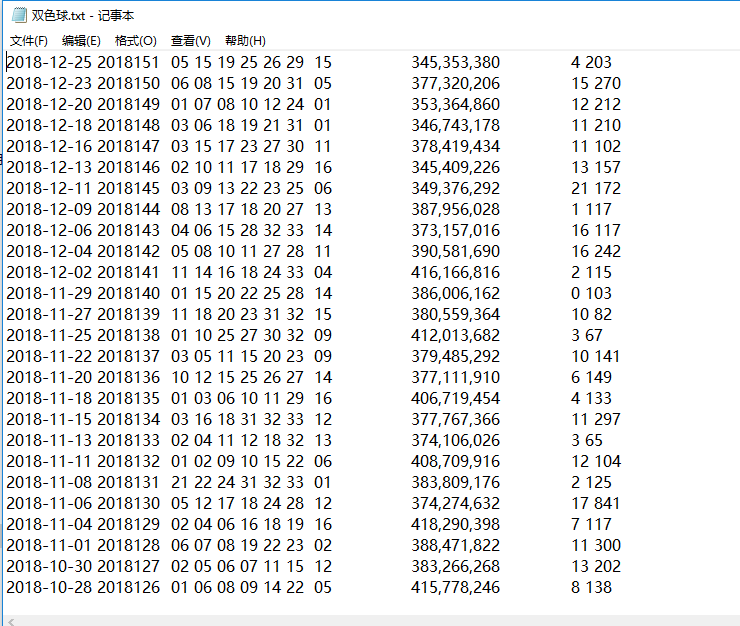

return items # Piplines模块:对已经爬取的数据做后续处理(存入数据库、存入文件系统、传递给流式处理框架,等等)

def pipelines(self,items):

fileName = u'双色球.txt'

with open(fileName, 'w') as fp: # a 为追加 w 为覆盖若存在

for item in items:

fp.write('%s %s \t %s %s %s %s %s %s %s \t %s \t %s %s \n'

%(item.date,item.order,item.red1,item.red2,item.red3,item.red4,item.red5,item.red6,item.blue,item.money,item.firstPrize,item.secondPrize)) if __name__ == '__main__':

GDCBN = GetDoubleColorBallNumber()

save2excel.py

#encoding=utf-8

import xlwt class SavaBallDate(object):

def __init__(self, items):

self.items = items

self.run(self.items) def run(self,items):

fileName = u'双色球.xls'

book = xlwt.Workbook(encoding='utf-8')

sheet=book.add_sheet('ball', cell_overwrite_ok=True)

sheet.write(0, 0, u'开奖日期')

sheet.write(0, 1, u'期号')

sheet.write(0, 2, u'红1')

sheet.write(0, 3, u'红2')

sheet.write(0, 4, u'红3')

sheet.write(0, 5, u'红4')

sheet.write(0, 6, u'红5')

sheet.write(0, 7, u'红6')

sheet.write(0, 8, u'蓝')

sheet.write(0, 9, u'销售金额')

sheet.write(0, 10, u'一等奖')

sheet.write(0, 11, u'二等奖')

i = 1

while i <= len(items):

item = items[i-1]

sheet.write(i, 0, item.date)

sheet.write(i, 1, item.order)

sheet.write(i, 2, item.red1)

sheet.write(i, 3, item.red2)

sheet.write(i, 4, item.red3)

sheet.write(i, 5, item.red4)

sheet.write(i, 6, item.red5)

sheet.write(i, 7, item.red6)

sheet.write(i, 8, item.blue)

sheet.write(i, 9, item.money)

sheet.write(i, 10, item.firstPrize)

sheet.write(i, 11, item.secondPrize)

i += 1

book.save(fileName) if __name__ == '__main__':

pass

实例结果:

数据量有点大,可能需要等一会儿,下面为程序运行结束后的文件夹。

__pycache__文件夹为程序运行自动生成的文件夹,不用管。

python爬虫学习之使用BeautifulSoup库爬取开奖网站信息-模块化的更多相关文章

- python爬虫学习(一):BeautifulSoup库基础及一般元素提取方法

最近在看爬虫相关的东西,一方面是兴趣,另一方面也是借学习爬虫练习python的使用,推荐一个很好的入门教程:中国大学MOOC的<python网络爬虫与信息提取>,是由北京理工的副教授嵩天老 ...

- Python爬虫学习——使用selenium和phantomjs爬取js动态加载的网页

1.安装selenium pip install selenium Collecting selenium Downloading selenium-3.4.1-py2.py3-none-any.wh ...

- [Python爬虫] 使用 Beautiful Soup 4 快速爬取所需的网页信息

[Python爬虫] 使用 Beautiful Soup 4 快速爬取所需的网页信息 2018-07-21 23:53:02 larger5 阅读数 4123更多 分类专栏: 网络爬虫 版权声明: ...

- Python爬虫教程-13-爬虫使用cookie爬取登录后的页面(人人网)(下)

Python爬虫教程-13-爬虫使用cookie爬取登录后的页面(下) 自动使用cookie的方法,告别手动拷贝cookie http模块包含一些关于cookie的模块,通过他们我们可以自动的使用co ...

- python爬虫(三) 用request爬取拉勾网职位信息

request.Request类 如果想要在请求的时候添加一个请求头(增加请求头的原因是,如果不加请求头,那么在我们爬取得时候,可能会被限制),那么就必须使用request.Request类来实现,比 ...

- Python爬虫学习三------requests+BeautifulSoup爬取简单网页

第一次第一次用MarkDown来写博客,先试试效果吧! 昨天2018俄罗斯世界杯拉开了大幕,作为一个伪球迷,当然也得为世界杯做出一点贡献啦. 于是今天就编写了一个爬虫程序将腾讯新闻下世界杯专题的相关新 ...

- Python爬虫学习之使用beautifulsoup爬取招聘网站信息

菜鸟一只,也是在尝试并学习和摸索爬虫相关知识. 1.首先分析要爬取页面结构.可以看到一列搜索的结果,现在需要得到每一个链接,然后才能爬取对应页面. 关键代码思路如下: html = getHtml(& ...

- python爬虫入门四:BeautifulSoup库(转)

正则表达式可以从html代码中提取我们想要的数据信息,它比较繁琐复杂,编写的时候效率不高,但我们又最好是能够学会使用正则表达式. 我在网络上发现了一篇关于写得很好的教程,如果需要使用正则表达式的话,参 ...

- Python爬虫学习笔记-1.Urllib库

urllib 是python内置的基本库,提供了一系列用于操作URL的功能,我们可以通过它来做一个简单的爬虫. 0X01 基本使用 简单的爬取一个页面: import urllib2 request ...

随机推荐

- wpf 给listview的数据源转换为集合

目的是点击某个按钮把一条数据从 itemssource中移除 private void delete_Click_1(object sender, RoutedEventArgs e) { DtsIn ...

- dos命令 创建数据库,建表,两表联查,三表联查(mysql---第一篇)

首先打开mysql的控制台,输入密码进行登录 (ps:本文的mysql控制台,是运用的php的集成环境(phpstudy),点击运行,找到mysql命令行,直接打开就可以了) 登陆成功后,就可以进行 ...

- css伪类及伪元素用法

注:该表引自W3School教程 伪元素的分类及作用: 接下来让博主通过一些生动的实例(之前的作业或小作品)来说明几种常用伪类的用法和效果,其他的读者可以自己尝试: :active 大致效果为用鼠标 ...

- 28. pt-table-sync

前提:得有checksum表 pt-table-sync --replicate=pt.checksum \h=192.168.100.101,P=3306,u=admin,p=admin \h=19 ...

- 使用nginx反向代理实现隐藏端口号

使用nginx反向代理实现隐藏端口号 在服务器上下载安装nginx,主要是修改配置nginx.conf. 用proxy_pass里面配置要转发的域名+端口,相当于这一部分是被域名替换的部分,在http ...

- 修改pudb颜色

2019-02-19,18点20vim调整颜色vim ~/.vimrc 这个pudb的配色用上的方法改不了.调试状态时候按o和回车能切换console和调试界面. 成功了.通过修改pudb源代码来实现 ...

- 解决sqlserver还原数据库失败命令

1.使用Master数据库 2.选择数据库 select * from master.sys.sysprocesses where dbid=db_id('database') 3.查出进程使用kil ...

- Python中logging日志模块的使用

参考https://www.cnblogs.com/CJOKER/p/8295272.html

- es6数组

将两类对象转为真正的数组 Array.from方法用于将两类对象转为真正的数组:类似数组的对象(array-like object)和可遍历(iterable)的对象(包括ES6新增的数据结构Set和 ...

- 前端面试题---vue部分

1.vue的两大核心思想 组件化和数据驱动 2.如何理解vue中的MVVM模式 Model-View-ViewModel(简称为mvvm)是一种设计思想,model层代表数据模型,也可以再model中 ...