hadoop-hdfs编程

1、开发环境搭建

一、新建一个普通的java工程

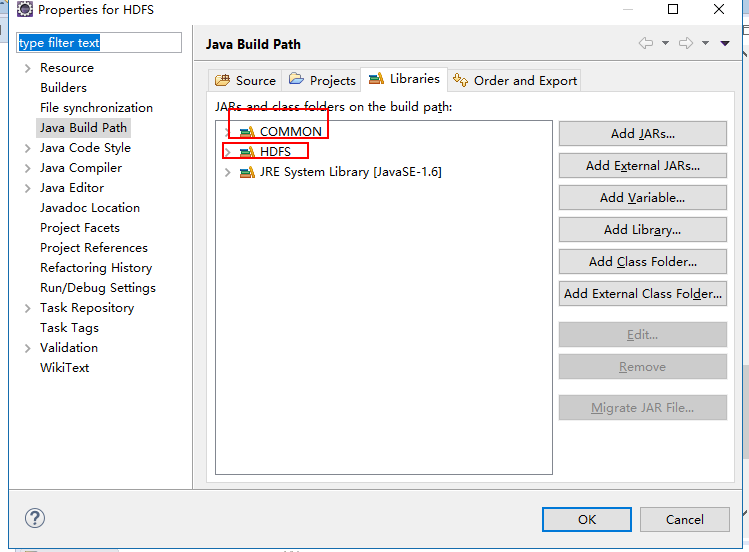

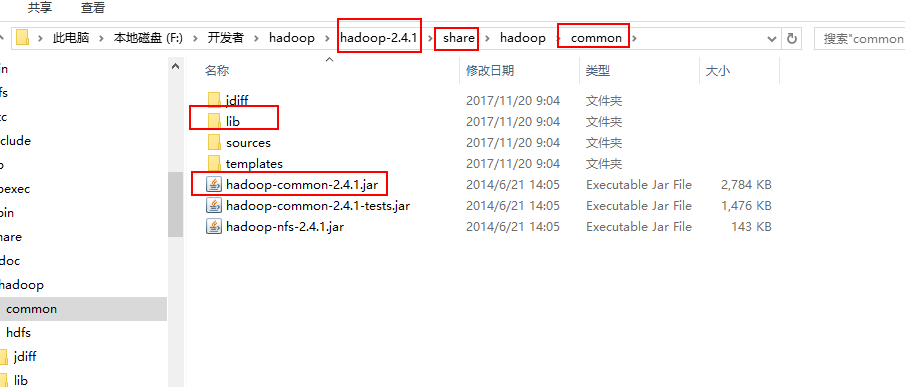

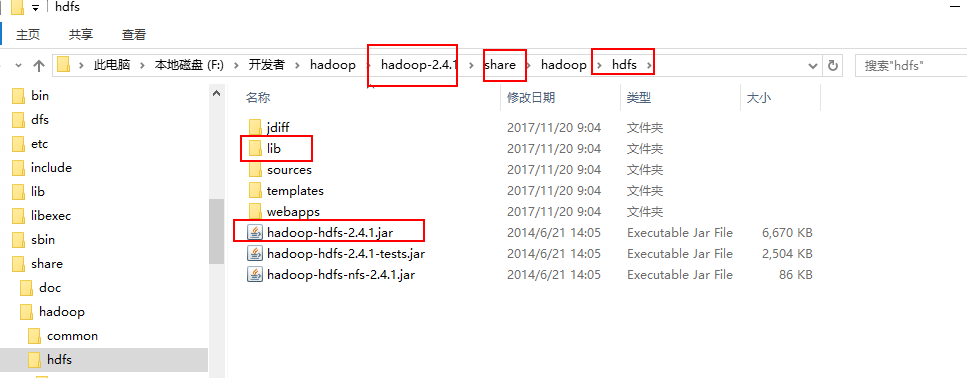

二、引入hdfs相关的jar包

需要引入的jar包:

common下的jar

hdfs下的jar

2、编写HDFS相关的程序

package com.cvicse.ump.hadoop.hdfs; import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FSDataOutputStream;

import org.apache.hadoop.fs.FileStatus;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path; public class FileOperation { //创建文件

public static void createFile(String dst,byte[] contents) throws Exception{

Configuration conf = new Configuration();

FileSystem fs = FileSystem.get(conf);

Path dstPath = new Path(dst);

FSDataOutputStream outputStream = fs.create(dstPath);;

outputStream.write(contents);

outputStream.close();

fs.close();

System.out.println(dst+",文件创建成果");

} //上传文件

public static void uploadFile(String src,String dst) throws Exception{

Configuration conf = new Configuration();

FileSystem fs = FileSystem.get(conf);

Path srcPath = new Path(src);

Path dstPath = new Path(dst);

fs.copyFromLocalFile(srcPath, dstPath);

System.out.println("Upload to "+conf.get("fs.default.name"));

System.out.println("------list files---------"+"\n");

FileStatus[] fileStatus = fs.listStatus(dstPath);

for(FileStatus file:fileStatus){

System.out.println(file.getPath());

}

fs.close(); } //删除目录

public static void delete(String filePath)throws Exception{ Configuration conf = new Configuration();

FileSystem fs = FileSystem.get(conf);

Path path = new Path(filePath);

boolean isOk = fs.deleteOnExit(path);

if(isOk){

System.out.println("delete OK.");

}else{

System.out.println("delete failure.");

}

fs.close(); }

//创建目录

public static void mkdir(String path)throws Exception{

Configuration conf = new Configuration();

FileSystem fs = FileSystem.get(conf);

Path srcPath = new Path(path);

boolean isOK = fs.mkdirs(srcPath);

if(isOK){

System.out.println("create dir ok!");

}else{

System.out.println("create dir failure!");

}

fs.close();

} //下载文件

public static void downFile(String src,String dst)throws Exception{

Configuration conf = new Configuration();

FileSystem fs = FileSystem.get(conf);

Path srcPath = new Path(src);

Path dstPath = new Path(dst); fs.copyToLocalFile(srcPath, dstPath);

System.out.println("down load over"); } public static void main(String[] args) throws Exception {

/*String dst = args[0];

byte[] contents = "hello,dyh".getBytes();

createFile(dst, contents);*/ /*String src = args[0];

String dst = args[1];

uploadFile(src, dst);*/ /*String filePath = args[0];

delete(filePath);*/ /*String path = args[0];

mkdir(path);*/ String src = args[0];

String dst = args[1];

downFile(src, dst);

} }

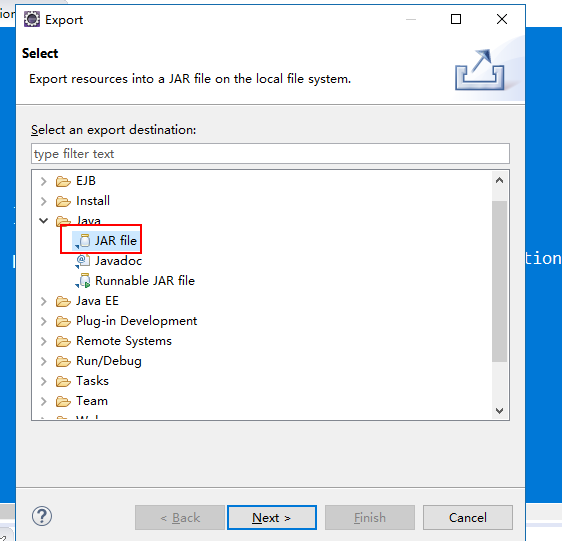

导出jar包

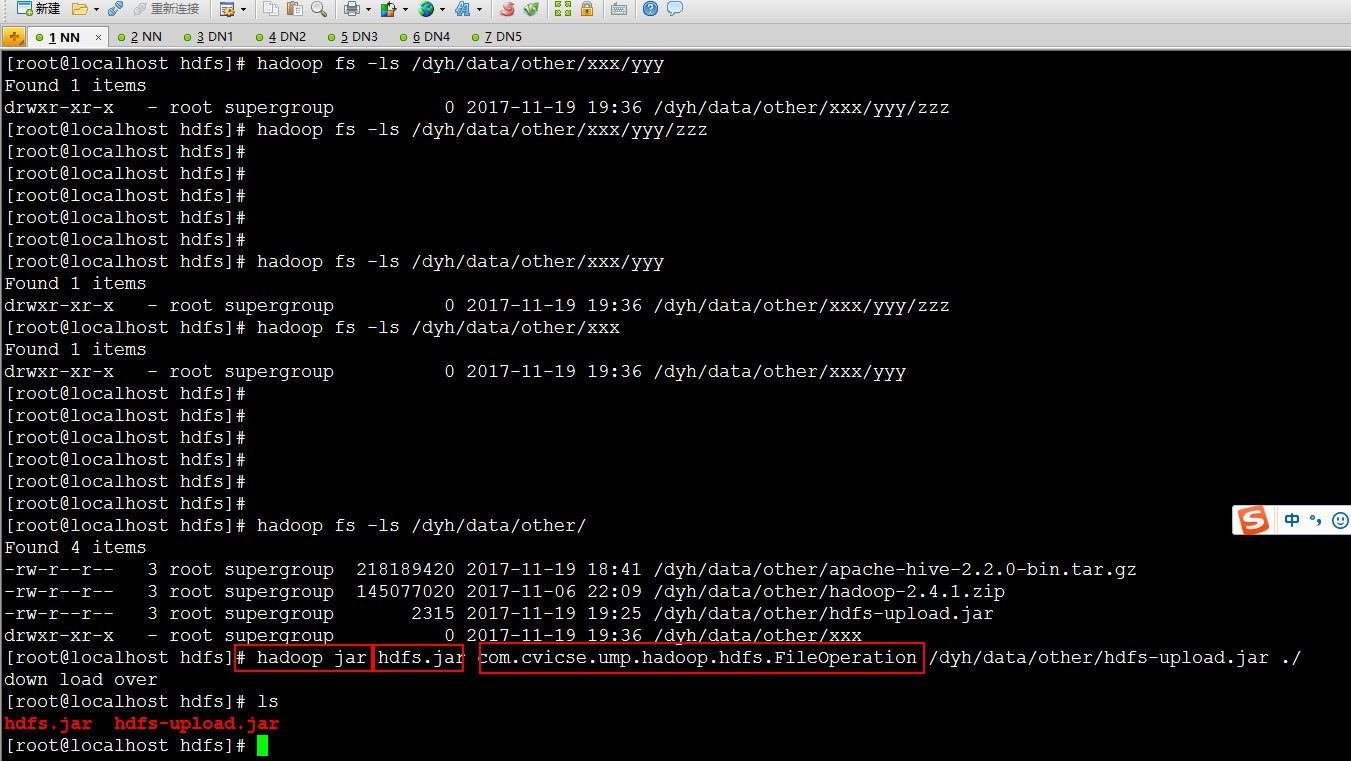

上传jar到HADOOP运行环境,并执行

执行命令:hadoop jar jar包名字 main函数所在的类

hadoop-hdfs编程的更多相关文章

- Hadoop HDFS编程 API入门系列之HDFS_HA(五)

不多说,直接上代码. 代码 package zhouls.bigdata.myWholeHadoop.HDFS.hdfs3; import java.io.FileInputStream;import ...

- Hadoop HDFS编程 API入门系列之简单综合版本1(四)

不多说,直接上代码. 代码 package zhouls.bigdata.myWholeHadoop.HDFS.hdfs4; import java.io.IOException; import ja ...

- Hadoop HDFS编程 API入门系列之HdfsUtil版本2(七)

不多说,直接上代码. 代码 package zhouls.bigdata.myWholeHadoop.HDFS.hdfs1; import java.io.FileInputStream;import ...

- Hadoop HDFS编程 API入门系列之HdfsUtil版本1(六)

不多说,直接上代码. 代码 package zhouls.bigdata.myWholeHadoop.HDFS.hdfs2; import java.io.FileOutputStream;impor ...

- Hadoop HDFS编程 API入门系列之合并小文件到HDFS(三)

不多说,直接上代码. 代码 package zhouls.bigdata.myWholeHadoop.HDFS.hdfs7; import java.io.IOException;import ja ...

- Hadoop HDFS编程 API入门系列之路径过滤上传多个文件到HDFS(二)

不多说,直接上代码. 代码 package zhouls.bigdata.myWholeHadoop.HDFS.hdfs6; import java.io.IOException;import jav ...

- Hadoop HDFS编程 API入门系列之从本地上传文件到HDFS(一)

不多说,直接上代码. 代码 package zhouls.bigdata.myWholeHadoop.HDFS.hdfs5; import java.io.IOException; import ja ...

- Hadoop HDFS编程 API入门系列之RPC版本2(九)

不多说,直接上代码. 代码 package zhouls.bigdata.myWholeHadoop.RPC.rpc2; public class LoginServiceImpl implement ...

- Hadoop HDFS编程 API入门系列之RPC版本1(八)

不多说,直接上代码. 代码 package zhouls.bigdata.myWholeHadoop.RPC.rpc1; import java.io.IOException;import java. ...

- Hadoop MapReduce编程 API入门系列之压缩和计数器(三十)

不多说,直接上代码. Hadoop MapReduce编程 API入门系列之小文件合并(二十九) 生成的结果,作为输入源. 代码 package zhouls.bigdata.myMapReduce. ...

随机推荐

- C#语言————第二章 C#语言快速热身

第二章 C#语言快速热身 ***********一.选择结构**************** 1:if选择结构与java的if选择结构语法完全相同 2:switch选择结构 ①:常量表达式的值可 ...

- centos7下安装指定版本mysql5.7.23

现在mysql版本已经到MySQL 8.0(GA)稳定版本了,所以需求是想简单又快速在centos7下安装指定版本例如MySQL 5.7(GA)版本有下面这种方法 首先需要到mysql官网这里下载对应 ...

- JQuery实现1024小游戏

最近用Jqery写了一个1024小游戏,由于是第一次写小游戏,所以就选了一个基础的没什么难度游戏.具体实现如下: 首先在开发时将整个游戏分成两层(自认为),底层是游戏的数据结构以及对数据的操作,上层是 ...

- 为PHP7安装Windows Server 2012 R2过程记录

因为要安装php-7.0.6-Win32-VC14-x64,需要先安装vcredist2015_x64_14.0.23026.0. 之前安装了Windows Server 2012 R2后,一直无法成 ...

- MATLAB三维作图——隐函数

MATLAB三维作图——隐函数 作者:凯鲁嘎吉 - 博客园http://www.cnblogs.com/kailugaji/ 对于三维隐函数,没有显式表达式,无法通过Matlab现成的3-D画图函数 ...

- golang的一些基础数据类型转换

int -- string //string到int value_int,err:=strconv.Atoi(string) //int到string str:=strconv.Itoa(value_ ...

- yii2 修改验证码小部件样式

<?= $form->field($model, 'verifyCode',['labelOptions' => ['class' => 'yanzhengma','style ...

- Plotagraph软件五分钟光速速成傻瓜教程

http://bbs.dji.com/thread-144203-1-1.html 让照片变成动态的

- go标准库的学习-crypto/sha256

参考:https://studygolang.com/pkgdoc 导入方式: import "crypto/sha256" sha256包实现了SHA224和SHA256哈希算法 ...

- TStack与IBM LinuxONE通过兼容性认证

近日,腾讯云TStack与IBM LinuxONE通过兼容性认证,通过腾讯云TStack,可实现便捷管理IBM LinuxONE服务器.这为腾讯和IBM在未来多方面的商业合作奠定了坚实基础,也为腾讯云 ...