highway network及mnist数据集测试

先说结论:没经过仔细调参,打不开论文所说代码链接(fq也没打开),结果和普通卷积网络比较没有优势。反倒是BN对网络起着非常重要的作用,达到了99.17%的测试精度(训练轮数还没到过拟合)。

论文为《Training Very Deep Networks》,一说其在resnet前发表,resnet模仿了它。

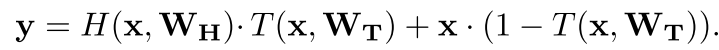

如上式,对于每个输入,都用一个layer去计算T(sigmoid激活),初始设置T的偏置为负,这样使得激活值开始比较小,便于信息流通。

以下对此做了2个测试,一个将图片Flatten后训练,一个使用卷积层。

1,Flatten

from keras.models import Model,Input

from keras.datasets import mnist

from keras.layers import Dense,Multiply,Add,Layer,Conv2D,Subtract,Lambda,Flatten,MaxPooling2D,BatchNormalization,Activation

from keras.losses import categorical_crossentropy

from keras import optimizers

from keras.utils import to_categorical

from keras import initializers

import keras.backend as K

(x_train,y_train),(x_test,y_test)=mnist.load_data() X_train=x_train.reshape(60000,-1)/255.

X_test=x_test.reshape(10000,-1)/255. y_train=to_categorical(y_train,num_classes=10)

y_test=to_categorical(y_test,num_classes=10)

自定义Block层,对应上面的公式

# 自定义highway-network的一个block

class Block(Layer):

def __init__(self,units,**kwargs):

self.units=units

self.weight_initializer=initializers.truncated_normal()

self.bh_initializer=initializers.constant(0.01)

# 根据论文,转换层使用负的偏置。这样开始训练时转换层输出小,信息基本原样流通

# 开始设置为-1,不行,这个参数还是敏感的

self.bt_initializer=initializers.constant(-0.3)

super(Block,self).__init__(**kwargs)

def build(self,input_shape):

self.h_w=self.add_weight(name='hw',shape=(input_shape[-1],self.units),initializer=self.weight_initializer,trainable=True)

self.t_w=self.add_weight(name='tw',shape=(input_shape[-1],self.units),initializer=self.weight_initializer,trainable=True)

self.h_b=self.add_weight(name='hb',shape=(input_shape[-1],),initializer=self.bh_initializer,trainable=True)

self.t_b=self.add_weight(name='tb',shape=(input_shape[-1],),initializer=self.bt_initializer,trainable=True)

super(Block,self).build(input_shape)

def call(self,inputs):

h_out=K.relu(K.dot(inputs,self.h_w)+self.h_b)

t_out=K.sigmoid(K.dot(inputs,self.t_w)+self.t_b)

out1=t_out*h_out

out2=(1-t_out)*inputs

return out1+out2

先降维一下,再叠加10个Block,使用带动量的SGD训练,参数为134,090

block_layers=10

inputs=Input(shape=(784,))

x=Dense(64,activation='relu')(inputs)

for i in range(block_layers):

x=Block(64)(x)

x=Dense(10,activation='softmax')(x)

model=Model(inputs,x) model.compile(optimizer=optimizers.Adam(),loss=categorical_crossentropy,metrics=['accuracy']) model.summary()

model.fit(X_train,y_train,batch_size=32,epochs=20,verbose=2,validation_split=0.3)

观测训练后,选定epochs为6,再用完整数据集训练一遍,测试精度97.5%

model.fit(X_train,y_train,batch_size=32,epochs=6,verbose=2)

model.evaluate(X_test,y_test)# 97.5%

作为对比,以下简单卷积网络测试精度即可达到97.83%,参数159,010

inputs=Input(shape=(784,))

x=Dense(200,activation='relu')(inputs)

x=Dense(10,activation='softmax')(x)

model=Model(inputs,x)

2,CNN

此处不再赘述,仅对模型创建过程说明一下,叠加10层,参数172,010,batch_size调整为128,训练后未在完整数据集再训练一遍,直接测试集精度为98.48%。但这也不够高。

layer_size=10

inputs=Input((28,28,1))

x=Conv2D(16,3,activation='relu',padding='same')(inputs)

for i in range(layer_size):

t=Conv2D(16,3,activation='sigmoid',padding='same',bias_initializer=initializers.constant(-1.))(x)

h=Conv2D(16,3,activation='relu',padding='same',bias_initializer=initializers.random_uniform())(x)

out1=Multiply()([t,h])

sub=Lambda(lambda p:1-p)(t)

out2=Multiply()([x,sub])

x=Add()([out1,out2])

x=Flatten()(x)

x=Dense(10,activation='softmax')(x)

model=Model(inputs,x)

model.summary()

3,BatchNormalization

调整验证集比例为20%

inputs=Input((28,28,1))

x=Conv2D(32,3,padding='same')(inputs)

x=BatchNormalization()(x)

x=Activation('tanh')(x)

x=Conv2D(32,3,padding='same',activation='tanh')(x)

x=MaxPooling2D()(x)

x=Conv2D(64,3,padding='same')(x)

x=BatchNormalization()(x)

x=Activation('tanh')(x)

x=Conv2D(64,3,padding='same',activation='tanh')(x)

x=MaxPooling2D()(x)

x=Flatten()(x)

x=Dense(10,activation='softmax')(x)

model=Model(inputs,x)

model.compile(optimizer=optimizers.SGD(momentum=0.8,nesterov=True),loss=categorical_crossentropy,metrics=['accuracy']) model.fit(X_train,y_train,batch_size=128,epochs=30,validation_split=0.2,verbose=2)

看看训练过程,可以看到,到训练30轮为止,验证损失仍没有上升迹象

Train on 48000 samples, validate on 12000 samples

Epoch 1/30

- 23s - loss: 0.2314 - accuracy: 0.9346 - val_loss: 0.1393 - val_accuracy: 0.9606

Epoch 2/30

- 23s - loss: 0.0756 - accuracy: 0.9778 - val_loss: 0.0675 - val_accuracy: 0.9810

Epoch 3/30

- 23s - loss: 0.0565 - accuracy: 0.9843 - val_loss: 0.0570 - val_accuracy: 0.9834

Epoch 4/30

- 23s - loss: 0.0451 - accuracy: 0.9870 - val_loss: 0.0519 - val_accuracy: 0.9851

Epoch 5/30

- 23s - loss: 0.0390 - accuracy: 0.9890 - val_loss: 0.0444 - val_accuracy: 0.9871

Epoch 6/30

- 23s - loss: 0.0335 - accuracy: 0.9905 - val_loss: 0.0431 - val_accuracy: 0.9878

Epoch 7/30

- 23s - loss: 0.0294 - accuracy: 0.9921 - val_loss: 0.0413 - val_accuracy: 0.9883

Epoch 8/30

- 23s - loss: 0.0267 - accuracy: 0.9928 - val_loss: 0.0396 - val_accuracy: 0.9899

Epoch 9/30

- 23s - loss: 0.0241 - accuracy: 0.9933 - val_loss: 0.0385 - val_accuracy: 0.9886

Epoch 10/30

- 23s - loss: 0.0222 - accuracy: 0.9942 - val_loss: 0.0391 - val_accuracy: 0.9877

Epoch 11/30

- 23s - loss: 0.0200 - accuracy: 0.9950 - val_loss: 0.0378 - val_accuracy: 0.9887

Epoch 12/30

- 23s - loss: 0.0188 - accuracy: 0.9950 - val_loss: 0.0381 - val_accuracy: 0.9881

Epoch 13/30

- 23s - loss: 0.0166 - accuracy: 0.9960 - val_loss: 0.0354 - val_accuracy: 0.9902

Epoch 14/30

- 23s - loss: 0.0156 - accuracy: 0.9961 - val_loss: 0.0379 - val_accuracy: 0.9886

Epoch 15/30

- 23s - loss: 0.0145 - accuracy: 0.9967 - val_loss: 0.0341 - val_accuracy: 0.9906

Epoch 16/30

- 23s - loss: 0.0133 - accuracy: 0.9971 - val_loss: 0.0345 - val_accuracy: 0.9902

Epoch 17/30

- 23s - loss: 0.0122 - accuracy: 0.9973 - val_loss: 0.0341 - val_accuracy: 0.9908

Epoch 18/30

- 23s - loss: 0.0113 - accuracy: 0.9978 - val_loss: 0.0346 - val_accuracy: 0.9900

Epoch 19/30

- 23s - loss: 0.0102 - accuracy: 0.9983 - val_loss: 0.0334 - val_accuracy: 0.9902

Epoch 20/30

- 23s - loss: 0.0097 - accuracy: 0.9982 - val_loss: 0.0326 - val_accuracy: 0.9910

Epoch 21/30

- 23s - loss: 0.0091 - accuracy: 0.9984 - val_loss: 0.0325 - val_accuracy: 0.9907

Epoch 22/30

- 23s - loss: 0.0083 - accuracy: 0.9987 - val_loss: 0.0325 - val_accuracy: 0.9905

Epoch 23/30

- 23s - loss: 0.0077 - accuracy: 0.9989 - val_loss: 0.0324 - val_accuracy: 0.9908

Epoch 24/30

- 23s - loss: 0.0073 - accuracy: 0.9990 - val_loss: 0.0330 - val_accuracy: 0.9900

Epoch 25/30

- 23s - loss: 0.0067 - accuracy: 0.9992 - val_loss: 0.0337 - val_accuracy: 0.9913

Epoch 26/30

- 23s - loss: 0.0065 - accuracy: 0.9992 - val_loss: 0.0318 - val_accuracy: 0.9907

Epoch 27/30

- 23s - loss: 0.0062 - accuracy: 0.9993 - val_loss: 0.0328 - val_accuracy: 0.9907

Epoch 28/30

- 23s - loss: 0.0056 - accuracy: 0.9995 - val_loss: 0.0316 - val_accuracy: 0.9914

Epoch 29/30

- 23s - loss: 0.0052 - accuracy: 0.9996 - val_loss: 0.0313 - val_accuracy: 0.9912

Epoch 30/30

- 23s - loss: 0.0049 - accuracy: 0.9997 - val_loss: 0.0313 - val_accuracy: 0.9911

完整数据集训练30轮后,测试精度99.17%。

后续可以尝试更深的网络,使用resnet。或者直接使用inception等。

highway network及mnist数据集测试的更多相关文章

- Tensorflow MNIST 数据集测试代码入门

本系列文章由 @yhl_leo 出品,转载请注明出处. 文章链接: http://blog.csdn.net/yhl_leo/article/details/50614444 测试代码已上传至GitH ...

- mxnet卷积神经网络训练MNIST数据集测试

mxnet框架下超全手写字体识别—从数据预处理到网络的训练—模型及日志的保存 import numpy as np import mxnet as mx import logging logging. ...

- 从零到一:caffe-windows(CPU)配置与利用mnist数据集训练第一个caffemodel

一.前言 本文会详细地阐述caffe-windows的配置教程.由于博主自己也只是个在校学生,目前也写不了太深入的东西,所以准备从最基础的开始一步步来.个人的计划是分成配置和运行官方教程,利用自己的数 ...

- Caffe系列4——基于Caffe的MNIST数据集训练与测试(手把手教你使用Lenet识别手写字体)

基于Caffe的MNIST数据集训练与测试 原创:转载请注明https://www.cnblogs.com/xiaoboge/p/10688926.html 摘要 在前面的博文中,我详细介绍了Caf ...

- Caffe初试(二)windows下的cafee训练和测试mnist数据集

一.mnist数据集 mnist是一个手写数字数据库,由Google实验室的Corinna Cortes和纽约大学柯朗研究院的Yann LeCun等人建立,它有60000个训练样本集和10000个测试 ...

- windows下使用caffe测试mnist数据集

在win10机子上装了caffe,感谢大神们的帖子,要入坑caffe-windows的朋友们看这里,还有这里,安装下来基本没什么问题. 好了,本博文写一下使用caffe测试mnist数据集的步骤. 1 ...

- Ubuntu14.04+caffe+cuda7.5 环境搭建以及MNIST数据集的训练与测试

Ubuntu14.04+caffe+cuda 环境搭建以及MNIST数据集的训练与测试 一.ubuntu14.04的安装: ubuntu的安装是一件十分简单的事情,这里给出一个参考教程: http:/ ...

- Windows下mnist数据集caffemodel分类模型训练及测试

1. MNIST数据集介绍 MNIST是一个手写数字数据库,样本收集的是美国中学生手写样本,比较符合实际情况,大体上样本是这样的: MNIST数据库有以下特性: 包含了60000个训练样本集和1000 ...

- 实践详细篇-Windows下使用VS2015编译的Caffe训练mnist数据集

上一篇记录的是学习caffe前的环境准备以及如何创建好自己需要的caffe版本.这一篇记录的是如何使用编译好的caffe做训练mnist数据集,步骤编号延用上一篇 <实践详细篇-Windows下 ...

随机推荐

- 粗暴,干就完了----徐晓冬似的C语言自学笔记-----实现一个链表结构

#include <stdio.h> #include <stdlib.h> #define N 5 /*N 假定数组长度为5*/ typedef struct snode { ...

- hbuilderX创建vue项目之添加router路由(前端萌新)

作为一个刚刚接触前端不久的新人来说,熟悉了一种目录结构或者项目创建方法以后,恨不得一辈子不会变! 可是人要生活,就要工作,既然是打工,当然要满足雇佣者的要求. 今天我来说说 hbuilderX 这个开 ...

- Java日期工具类DateUtils详解(转)

jar包 appache下的 common-lang3 一. 对指定的日期新增年.月.周.日.小时.分钟.秒.毫秒 public static Date addDays(Date date, int ...

- Python模块之目录

1.加密算法有关 hmac模块 hashlib模块 2.进程有关 multiprocessing模块 3.线程有关 threading模块 4.协程有关 asyncio模块 5.系统命令调用 sub ...

- OFDM留空中央直流子载波目的及原理

目的: 降低峰均比! 原理: IDFT公式: 直流分量k接近0,公式近似于对X(k)进行累加,因此直流分量会产生较大的信号能量,造成严重的峰均比. 详细内容可参考: https://dwz.cn/Zl ...

- Navicat Premium 12 卸载和注册表的删除

卸载就不用我说了,win10也好,win7也好直接windows设置里的卸载,或者你觉得别的软件卸载的比较干净也行 不过还是不会删掉注册表,甚至文件夹都不删除, ... 这是卸载 ,在此说一下,为了安 ...

- mysql 查看当前正在执行的语句

查看当前正在执行的语句 show processlist:show processlist; 结束正在执行的语句进程 kill 进程id

- 安装conda后取消命令行前出现的base,取消每次启动自动激活conda的基础环境, 使用ubuntu 自带的Python环境

方法一: 退出base环境回到系统自带的环境 conda deactivate 方法二 1,通过将auto_activate_base参数设置为false实现: conda config --set ...

- django快速实现完整登录系统,把登陆注册串在一起并增加cookie(六)

1.使用之前创建的项目和应用 mysite3 account 2.使用之前的数据库构造 class User(models.Model): username=models.CharField(max ...

- js创建链表

首先要明确,我们为什么要创建链表呢?数组的大小是固定的,从数组的起点或中间插入或移除的成本很高,因为需要移动元素.尽管JS的Array类方法可以做这些,但是情况也是这样.链表存储有序的元素集合,但不同 ...