Python爬取6271家死亡公司数据,看十年创业公司消亡史

前言

文的文字及图片来源于网络,仅供学习、交流使用,不具有任何商业用途,版权归原作者所有,如有问题请及时联系我们以作处理。

作者: 朱小五 凹凸玩数据

PS:如有需要Python学习资料的小伙伴可以加点击下方链接自行获取

http://note.youdao.com/noteshare?id=3054cce4add8a909e784ad934f956cef

前段时间老罗和王校长都成为自己的创业公司成了失信人,小五打算上IT桔子看看他们的公司。

意外发现IT桔子出了个死亡公司库,统计了2000-2019年之间比较出名的公司“死亡”数据。

小五利用python将其中的死亡公司数据爬取下来,借此来观察最近十年创业公司消亡史。

获取数据

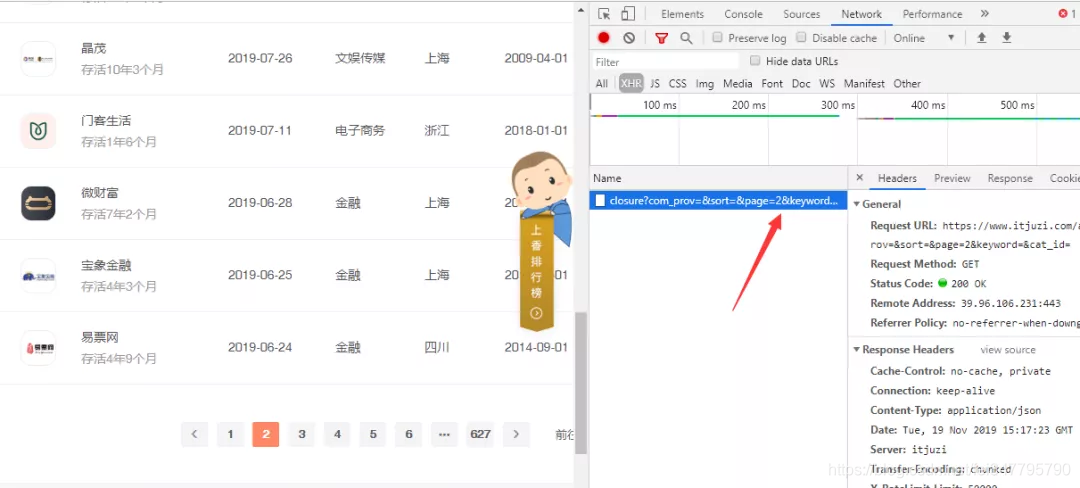

F12,Network查看异步请求XHR,翻页。

成功找到返回json格式数据的url,

https://www.itjuzi.com/api/closure?com_prov=&fund_status=&sort=&page=1

不了解json的读者可以看【python玩转Json数据】,部分爬虫代码

def main():

data = pd.DataFrame(columns=['com_name','born','close','live_time','total_money','cat_name','com_prov','closure_type'])

for i in range(1,2): #设置爬取N页

url= 'https://www.itjuzi.com/api/closure?com_prov=&fund_status=&sort=&page='+ str(i)

html = requests.get(url=url, headers=headers).content

doc = json.loads(html.decode('utf-8'))['data']['info']

for j in range(10): #一页10个死亡公司

data = data.append({'com_name':doc[j]['com_name'],'born':doc[j]['born'],'cat_name':doc[j]['cat_name'],

'closure_type':doc[j]['closure_type'],'close':doc[j]['com_change_close_date'],'com_prov':doc[j]['com_prov'],

'live_time':doc[j]['live_time'],'total_money':doc[j]['total_money']},ignore_index=True)

time.sleep(random.random())

return data

成功获取6271家死亡公司数据。

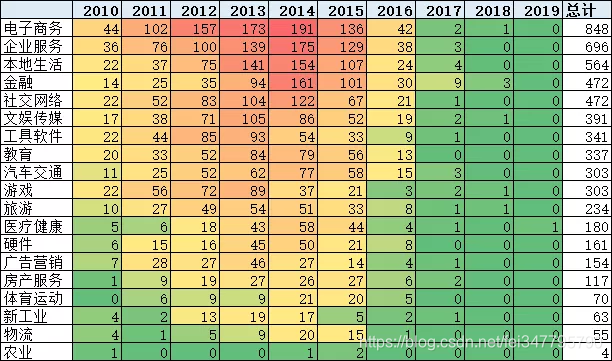

数说10年生死相

截止 2019 年 11 月 24 日,共有近6271家公司在 IT 桔子数据库中被标注为“已关闭”,我们挑选最近十年(2010-2019)的5765家公司,来看一看这十年,创业公司的消亡。

大家常说1998年是中国互联网元年,2010年是移动互联网的元年。

也难怪,2010年的移动互联网实在是太热闹了。微信、小米、美团、爱奇艺等都在这一年相继成立。

百度在谷歌退出中国后成为最大的受益者,淘宝成为阿里新的增长点,腾讯则宣布QQ同时在线超1亿人。自此,百度、阿里和腾讯正式成为“三巨头”——BAT。除此之外,网易的网游、新浪的微博、搜狐的视频和输入法也开始发力出击,移动互联网的竞争正式拉开帷幕。

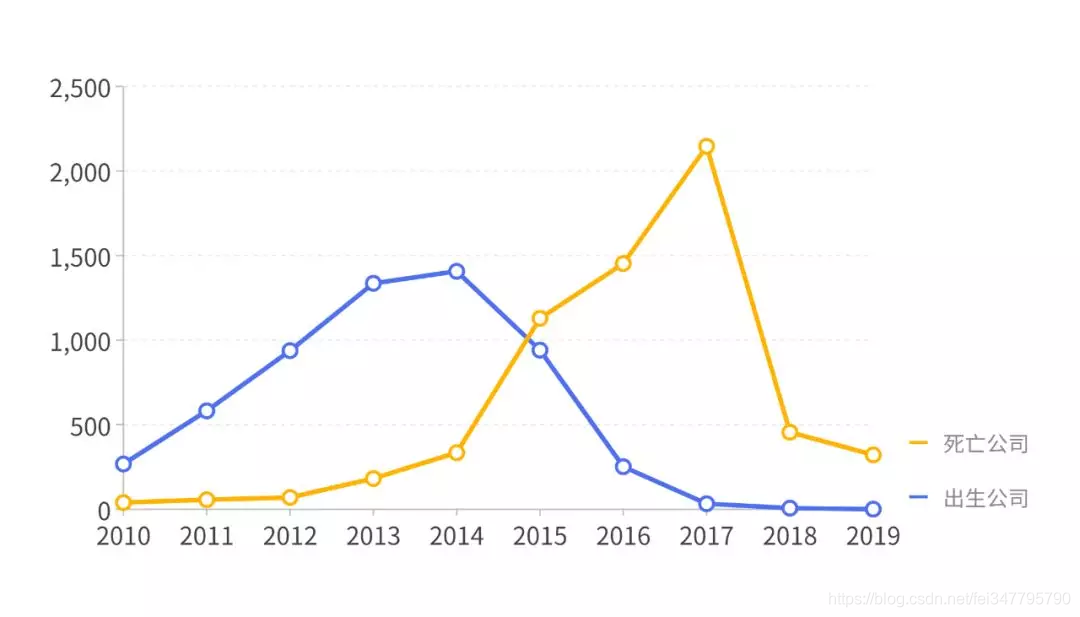

2010 年来,历年出生及死亡的公司数量趋势如下图。

2013、2014 年是公司诞生潮,三年后,正好对应了2016、2017的一波死亡潮。在2017 年,超过 2000 家公司倒闭。

在这十年间,诸多“风口”起起伏伏。网约车、团购、直播、基因检测、共享单车、短视频、比特币、VR|AR、无人货架、人工智能、直播带货……

每一个风口上,都站着数百头“猪”,试图借力分一杯羹。

百团大战、垂直电商大战、外卖大战、打车大战、单车大战,在这些著名的战场里,各种桥段令吃瓜群众们目不暇接。有老大老二打架,老三打没了;有老二老三合并,继续和老大抗衡的;也有老大老二合并,将其他家远远甩在后面的……

还有像冲顶大会之类直播答题一样,办起来的时候,各家分庭抗礼来势汹汹,却从2018年的公历新年开始,没有挺到农历新年。

风口消亡的背后,是无数创业公司烧掉的钱,每个公司在一开始,都坚信可以烧倒对手,但烧着烧着把自己烧光了,却再也拿不到融资。

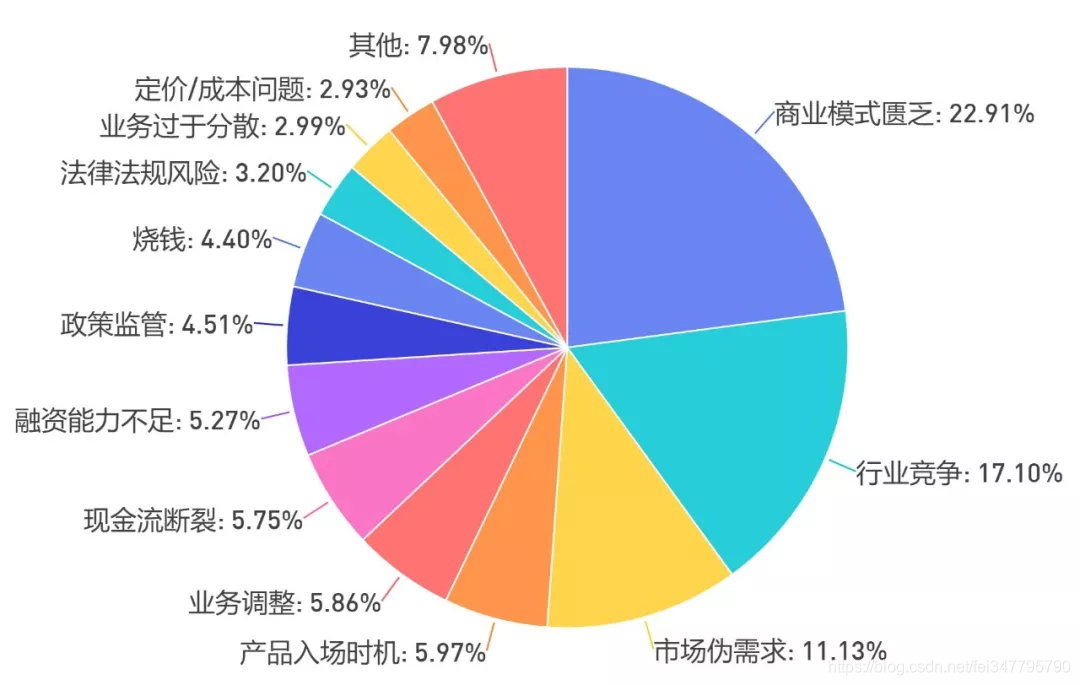

创业公司的消亡,究其原因必然是多方面的,除行业竞争激烈这一核心因素外,最主要的还是商业模式的匮乏。创业者内在对于如何维稳、如何盈利等方面欠缺的了解、思考与准备,不足以在行业稳定后,支撑他在风口来临之初的一腔热血豪情。

另外,“伪风口”与“伪需求”也曾迷住众多创业公司的眼。“共享经济”衍生出的共享单车、共享充电宝红红火火,但共享电话、共享厕纸、共享篮球什么的,倒也不必。

比较有意思的是,这个死亡公司数据库还加了一个#上香排行榜#,排行第一的果然是大名鼎鼎的“快播”。

还真是有的公司死了,(在人心里)他还活着;

有的公司活着,(在人心里)他已经死去。

代码

import requests

import json

import pandas as pd

import time

import random

from fake_useragent import UserAgent

ua = UserAgent()

headers = {'User-Agent':ua.random} #伪装请求头

def main():

data = pd.DataFrame(columns=['com_name','born','close','live_time','total_money','cat_name','com_prov','closure_type'])

for i in range(1,2): #设置爬取N页

url= 'https://www.itjuzi.com/api/closure?com_prov=&fund_status=&sort=&page='+ str(i)

html = requests.get(url=url, headers=headers).content

doc = json.loads(html.decode('utf-8'))['data']['info']

for j in range(10): #一页10个死亡公司

data = data.append({'com_name':doc[j]['com_name'],'born':doc[j]['born'],'cat_name':doc[j]['cat_name'],

'closure_type':doc[j]['closure_type'],'close':doc[j]['com_change_close_date'],'com_prov':doc[j]['com_prov'],

'live_time':doc[j]['live_time'],'total_money':doc[j]['total_money']},ignore_index=True)

time.sleep(random.random())

return data

if __name__ == "__main__":

final_result = main()

#final_result.to_csv("final_result.csv", index_label="index_label",encoding='utf-8-sig')

Python爬取6271家死亡公司数据,看十年创业公司消亡史的更多相关文章

- Python爬取6271家死亡公司数据,一眼看尽十年创业公司消亡史!

小五利用python将其中的死亡公司数据爬取下来,借此来观察最近十年创业公司消亡史. 获取数据 F12,Network查看异步请求XHR,翻页. 成功找到返回json格式数据的url, 很多人 ...

- python 爬取天猫美的评论数据

笔者最近迷上了数据挖掘和机器学习,要做数据分析首先得有数据才行.对于我等平民来说,最廉价的获取数据的方法,应该是用爬虫在网络上爬取数据了.本文记录一下笔者爬取天猫某商品的全过程,淘宝上面的店铺也是类似 ...

- Python爬取链家二手房源信息

爬取链家网站二手房房源信息,第一次做,仅供参考,要用scrapy. import scrapy,pypinyin,requests import bs4 from ..items import L ...

- Python 爬取大众点评 50 页数据,最好吃的成都火锅竟是它!

前言 文的文字及图片来源于网络,仅供学习.交流使用,不具有任何商业用途,版权归原作者所有,如有问题请及时联系我们以作处理. 作者: 胡萝卜酱 PS:如有需要Python学习资料的小伙伴可以加点击下方链 ...

- 适合初学者的Python爬取链家网教程

前言 文的文字及图片来源于网络,仅供学习.交流使用,不具有任何商业用途,版权归原作者所有,如有问题请及时联系我们以作处理. 作者: TinaLY PS:如有需要Python学习资料的小伙伴可以加点击下 ...

- 使用python爬取东方财富网机构调研数据

最近有一个需求,需要爬取东方财富网的机构调研数据.数据所在的网页地址为: 机构调研 网页如下所示: 可见数据共有8464页,此处不能直接使用scrapy爬虫进行爬取,因为点击下一页时,浏览器只是发起了 ...

- [转]使用python爬取东方财富网机构调研数据

最近有一个需求,需要爬取东方财富网的机构调研数据.数据所在的网页地址为: 机构调研 网页如下所示: 可见数据共有8464页,此处不能直接使用scrapy爬虫进行爬取,因为点击下一页时,浏览器只是发起了 ...

- Python爬取上交所一年大盘数据

前言 文的文字及图片来源于网络,仅供学习.交流使用,不具有任何商业用途,版权归原作者所有,如有问题请及时联系我们以作处理. 作者: 半个码农2018 PS:如有需要Python学习资料的小伙伴可以加点 ...

- Python爬取某网站文档数据完整教程(附源码)

基本开发环境 (https://jq.qq.com/?_wv=1027&k=NofUEYzs) Python 3.6 Pycharm 相关模块的使用 (https://jq.qq.com/?_ ...

随机推荐

- vscode 格式化代码 与 eslint 有冲突的问题解决

项目中配置了eslint后,在使用vue界面里格式化的时候总是不一致.然后在配置中加了配置也无效(File - Preference - Setting) 查了下原因是在vue开发的时候我们一般都安装 ...

- 使用fidder对安卓模拟器进行抓包

本文主要介绍fiddler4对安卓模拟器的抓包设置 首先在官网下载fiddler4进行安装,然后下载安卓模拟器,这里使用网易的MuMu模拟器. 1.fiddler4的设置对于fiddler4的设置,首 ...

- 使用pip安装python库的几种方式

操作系统 : CentOS7.5.1804_x64 Python 版本 : 3.6.8 1.使用pip在线安装 1.1 安装单个package 格式如下: pip install SomePackag ...

- Java 面试宝典!并发编程 71 道题及答案全送上!

金九银十跳槽季已经开始,作为 Java 开发者你开始刷面试题了吗?别急,我整理了71道并发相关的面试题,看这一文就够了! 1.在java中守护线程和本地线程区别? java中的线程分为两种:守护线程( ...

- 【朝花夕拾】Android性能篇之(八)来自官网的自白

前言 转载请声明,转自[https://www.cnblogs.com/andy-songwei/p/10823372.html],谢谢! Android性能优化无疑是Android中的一个重点,也是 ...

- [Spring cloud 一步步实现广告系统] 6. Service实现&Zuul配置&Test

DAO层设计实现 这里我们使用Spring DATA JPA来实现数据库操作,当然大家也可以使用Mybatis,都是一样的,我们依然以用户表操作为例: /** * AdUserRepository f ...

- Winform中设置ZedGraph鼠标悬浮显示举例最近曲线上的点的坐标值和X轴与Y轴的标题

场景 Winform中设置ZedGraph鼠标双击获取距离最近曲线上的点的坐标值: https://blog.csdn.net/BADAO_LIUMANG_QIZHI/article/details/ ...

- netcore3.0使用Session

首先需要明确一点,netcore使用session不能直接使用,必须引用nuget包并做注册之后才能使用. 例如下面的例子,若未注册session服务会报 HttpContext.Session.Se ...

- 关于vue-detools chorme创建安装完成,但是控制台不显示问题

搜了一下发现挺多人遇到这个问题的,绝大多数的回答都是在main.js中添加下面代码 Vue.config.devtools = true; 但是发现并不行. 后来看到有人说刷新然后在按F12就好了,居 ...

- GIT命令行统计代码提交行数

项目中遇到写报告的时候要反馈某个人或者某个功能的代码量,又没有集成CI这些插件,可以简单的用GIT命令统计下代码提交量: --统计某个人的提交代码 git log --author="old ...