python_进程池以及线程池

可以重复利用的线程

直接上代码

from threading import Thread, current_thread

from queue import Queue

# 重写线程类

class MyThread(Thread):

def __init__(self):

super().__init__()

self.daemon = True # 守护线程

self.queue = Queue(10)

self.start() # 实例化的时候开启线程 def run(self): # 子线程只有这一个线程, 从队列里面拿任务

while True:

task, args, kwargs = self.queue.get() # 拿任务 也是元组

task(*args, **kwargs) # 可能有,可能没有,所有传入不定长参数

self.queue.task_done() # 结束任务 def apply_async(self, func, args=(), kwargs={}): # 自写任务,不是重写任务, 充当生产者, 给线程提供任务(把任务扔到队列)

self.queue.put((func, args, kwargs)) def join_R(self): # 主线程等待子线程结束

self.queue.join() # task_done 为0 的时候就阻塞 def func():

print(1, current_thread()) def func2(*args, **kwargs):

print(2, current_thread())

print('func: ', args, kwargs) t = MyThread()

t.apply_async(func)

t.apply_async(func2, args=(1,2), kwargs={'a':1, 'b':2})

print("任务提交完成")

t.join_R()

print("任务完成")

结果:

任务提交完成

1 <MyThread(Thread-1, started daemon -1223214272)>

2 <MyThread(Thread-1, started daemon -1223214272)>

func: (1, 2) {'a': 1, 'b': 2}

任务完成 任务完成后,主线程就开始退出, 因此守护线程被杀死

线程池的简单实现

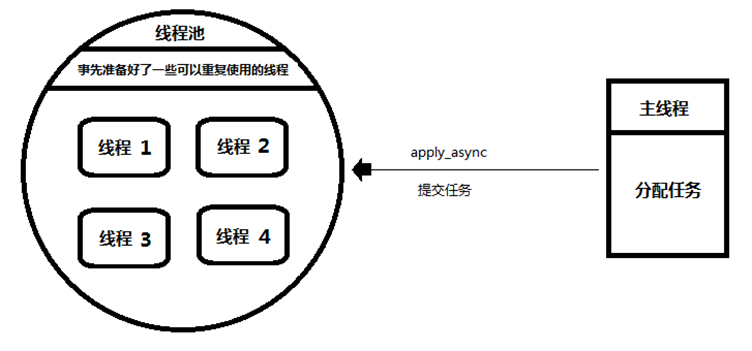

池的概念

主线程: 相当于生产者,只管向线程池提交任务。

并不关心线程池是如何执行任务的。

因此,并不关心是哪一个线程执行的这个任务。

线程池: 相当于消费者,负责接收任务,

并将任务分配到一个空闲的线程中去执行。

代码实现如下:

from threading import Thread, current_thread

from queue import Queue class T_pool:

def __init__(self, n): # 准备多少个池

super().__init__()

self.queue = Queue()

for i in range(n): # 在池里开多少个线程

Thread(target=self.fun, daemon=Thread).start() # 守护进程 并启动 def fun(self): # 生产者

while True:

task = self.queue.get()

task()

self.queue.task_done() def apply_async(self, task): # 消费者

self.queue.put(task) def join(self):

self.queue.join() def func():

print(current_thread()) def func2():

print(current_thread()) p = T_pool(2)

p.apply_async(func)

p.apply_async(func2)

p.join()

结果:

<Thread(Thread-1, started daemon -1223324864)>

<Thread(Thread-1, started daemon -1223324864)>

Python自带的池

内置线程池

from multiprocessing.pool import ThreadPool # 线程池

from multiprocessing import pool # 进程池

# 内置线程池

def fun(*args, **kwargs):

print(args, kwargs) p = ThreadPool(2) # 直接使用内置的

p.apply_async(fun, args=(1,2), kwds={'a':1})

p.close() # 要求:在join前必须要close,这样就不允许再提交任务了

p.join()

结果:

(1, 2) {'a': 1}

内置进程池

from multiprocessing import Pool # 进程池

# 内置进程池

def fun(*args, **kwargs):

print(args, kwargs) if __name__ == '__main__': # 必须要有一个main测试

p = Pool(2) # pool的实例化必须在main测试之下

p.apply_async(fun, args=(1,2), kwds={'a':1})

p.close() # 要求:在join前必须要close,这样就不允许再提交任务了

p.join()

结果:

(1, 2) {'a': 1}

池的其他操作 操作一: close - 关闭提交通道,不允许再提交任务

操作一: close - 关闭提交通道,不允许再提交任务 操作二: terminate - 中止进程池,中止所有任务

操作二: terminate - 中止进程池,中止所有任务  操作三: 结果操作

操作三: 结果操作

结果操作

from multiprocessing.pool import ThreadPool

import time

def func(n):

if n == 1:

return 1

elif n == 2:

return 2

return func(n-1) + func(n-2) pool = ThreadPool() a_result = pool.apply_async(func, args=(35,))

print("note1:",time.asctime(time.localtime(time.time())))

result = a_result.get() # 会阻塞,知道结果产生了

print("note2:",time.asctime(time.localtime(time.time())))

结果:

note1: Mon Sep 17 00:07:31 2018

note2: Mon Sep 17 00:07:34 2018

使用池来实现并发服务器

使用线程池来实现并发服务器

import socket

from multiprocessing.pool import ThreadPool # 线程池

from multiprocessing import Pool, cpu_count

'''

使用线程池来实现

并发服务器

'''

print(cpu_count()) server = socket.socket()

server.bind(('0.0.0.0', 8080))

server.listen(1000) def work_thread(conn):

while True:

data = conn.recv(1000)

if data:

print(data)

conn.send(data) else:

conn.close()

break if __name__ == '__main__': t_pool = ThreadPool(5) # 使用线程池, 通常分配2倍的cpu个数

while True:

conn,addr = server.accept()

t_pool.apply_async(work_thread, args=(conn,)) # 接收的是个任务, conn做为参数

使用进程池来实现并发服务器

import socket

from multiprocessing.pool import ThreadPool # 线程池

from multiprocessing import Pool, cpu_count

'''

使用进程池来实现

并发服务器

'''

print(cpu_count()) server = socket.socket()

server.bind(('0.0.0.0', 9000))

server.listen(1000) def work_process(server):

t_pool = ThreadPool(cpu_count()*2) # 使用线程池, 通常分配2倍的cpu个数

while True:

conn,addr = server.accept()

t_pool.apply_async(work_thread, args=(conn,)) # 接收的是个任务, conn做为参数 def work_thread(conn):

while True:

data = conn.recv(1000)

if data:

print(data)

conn.send(data) else:

conn.close()

break n = cpu_count() # 获取当前计算机的CPU核心数量

p = Pool(n)

for i in range(n): # 充分利用CPU, 为每个CPU分配一个进程

p.apply_async(work_process, args=(server,)) p.close()

p.join()

客户端:

import socket click = socket.socket()

click.connect(('127.0.0.1', 8888)) while True:

data = input("请输入你要发送的数据:")

click.send(data.encode())

print("接收到的消息: {}".format(click.recv(1024).decode()))

总结完毕。

作者:含笑半步颠√

博客链接:https://www.cnblogs.com/lixy-88428977

声明:本文为博主学习感悟总结,水平有限,如果不当,欢迎指正。如果您认为还不错,欢迎转载。转载与引用请注明作者及出处。

python_进程池以及线程池的更多相关文章

- python系列之 - 并发编程(进程池,线程池,协程)

需要注意一下不能无限的开进程,不能无限的开线程最常用的就是开进程池,开线程池.其中回调函数非常重要回调函数其实可以作为一种编程思想,谁好了谁就去掉 只要你用并发,就会有锁的问题,但是你不能一直去自己加 ...

- 第三十八天 GIL 进程池与线程池

今日内容: 1.GIL 全局解释器锁 2.Cpython解释器并发效率验证 3.线程互斥锁和GIL对比 4.进程池与线程池 一.全局解释器锁 1.GIL:全局解释器锁 GIL本质就是一把互斥锁,是夹在 ...

- python并发编程之进程池,线程池,协程

需要注意一下不能无限的开进程,不能无限的开线程最常用的就是开进程池,开线程池.其中回调函数非常重要回调函数其实可以作为一种编程思想,谁好了谁就去掉 只要你用并发,就会有锁的问题,但是你不能一直去自己加 ...

- 基于concurrent.futures的进程池 和线程池

concurrent.futures:是关于进程池 和 线程池 的 官方文档 https://docs.python.org/dev/library/concurrent.futures.html 现 ...

- GIL锁、进程池与线程池

1.什么是GIL? 官方解释: ''' In CPython, the global interpreter lock, or GIL, is a mutex that prevents multip ...

- python自带的进程池及线程池

进程池 """ python自带的进程池 """ from multiprocessing import Pool from time im ...

- 内存池、进程池、线程池介绍及线程池C++实现

本文转载于:https://blog.csdn.net/ywcpig/article/details/52557080 内存池 平常我们使用new.malloc在堆区申请一块内存,但由于每次申请的内存 ...

- python并发编程之进程池,线程池concurrent.futures

进程池与线程池 在刚开始学多进程或多线程时,我们迫不及待地基于多进程或多线程实现并发的套接字通信,然而这种实现方式的致命缺陷是:服务的开启的进程数或线程数都会随着并发的客户端数目地增多而增多, 这会对 ...

- python之进程池与线程池

一.进程池与线程池介绍 池子使用来限制并发的任务数目,限制我们的计算机在一个自己可承受的范围内去并发地执行任务 当并发的任务数远远超过了计算机的承受能力时,即无法一次性开启过多的进程数或线程数时就应该 ...

- 12 并发编程-(线程)-线程queue&进程池与线程池

queue 英 /kjuː/ 美 /kju/ 队列 1.class queue.Queue(maxsize=0) #队列:先进先出 import queue q=queue.Queue() q.put ...

随机推荐

- [图形计算器]Desmos

一.图形计算器 var elt = document.getElementById('calculator'); var calculator = Desmos.GraphingCalculator( ...

- nginx架构分析之 事件驱动模型

事件驱动模型 事件驱动模型是实现异步非阻塞的一个手段.事件驱动模型中,一个进程(线程)就可以了. 对于web服务器来说,客户端A的请求连接到服务端时,服务端的某个进程(Nginx worker pro ...

- Vector与ArrayList 的理解

最近在看Vector与ArrayList的源码,看下他们的区别与联系. Vector是线程安全的集合类,ArrayList并不是线程安全的类.Vector类对集合的元素操作时都加了synchroniz ...

- SpringMVC实现文件下载的两种方式及多文件下载

1.传统方法 @RequestMapping("/download") public String download( String fileName ,String filePa ...

- LB中使用到的一致性Hash算法的简单实现

1.类的Diagram 2.代码实现 2.1.Node类,每个Node代表集群里面的一个节点或者具体说是某一台物理机器: package consistencyhash; import lombok. ...

- Python3基础 内置函数 dir 查询对象的方法列表

Python : 3.7.3 OS : Ubuntu 18.04.2 LTS IDE : pycharm-community-2019.1.3 ...

- 两个字符串对比提升比较性能用 StringComparison.OrdinalIgnoreCase

如果用string.ToLower() 或者 string.ToUpper()字符串在进行大小写转换时会消耗额外的性能 用这个比较性能更好 StringPwd1.Equals(Md5(PassWord ...

- OS X 恢复模式重置 Mac 用户登录密码

关闭你的 Mac.按住 Command + R(⌘R) 组合键,并点按开机按钮,直到出现 标志,进入恢复模式(Recovery Mode)(当然,你也可以先按开机键,在听到启动声后,立即按住 ⌘R ...

- Data Flow ORB-SLAM for Real-Time Performance on Embedded GPU Boards

张宁 Data Flow ORB-SLAM for Real-Time Performance on Embedded GPU Boards 数据流ORB-SLAM可在嵌入式GPU板上实现实时性能链接 ...

- 【APM】Pinpoint 使用教程(二)

本例介绍Pinpoint使用教程 Pinpoint安装部署参考:[APM]Pinpoint 安装部署(一) 查看应用调用关系拓扑图 进入pintpoint->选择应用-〉选择查看的时间周期,即可 ...