Iris Classification on Tensorflow

Iris Classification on Tensorflow

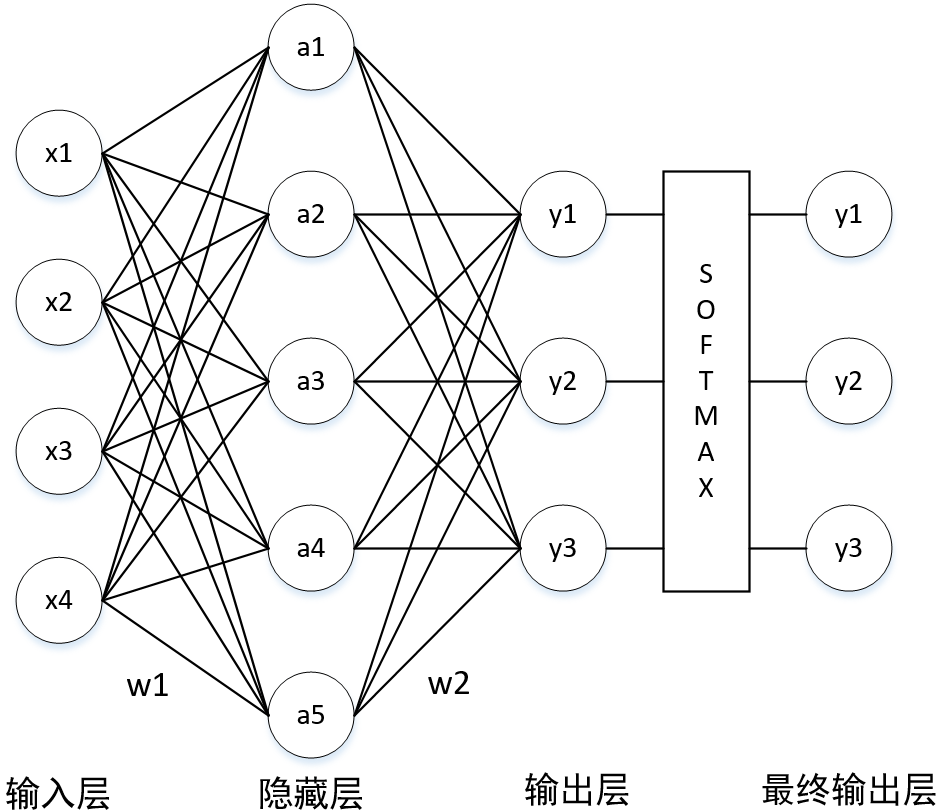

Neural Network

formula derivation

a & = x \cdot w_1 \\

y & = a \cdot w_2 \\

& = x \cdot w_1 \cdot w_2 \\

y & = softmax(y)

\end{align}

\]

code (training only)

y = a \cdot w_2

\]

w1 = tf.Variable(tf.random_normal([4,5], stddev=1, seed=1))

w2 = tf.Variable(tf.random_normal([5,3], stddev=1, seed=1))

x = tf.placeholder(tf.float32, shape=(None, 4), name='x-input')

a = tf.matmul(x, w1)

y = tf.matmul(a, w2)

既然是有监督学习,那就在训练阶段必须要给出 label,以此来计算交叉熵

# 用来存储数据的标签

y_ = tf.placeholder(tf.float32, shape=(None, 3), name='y-input')

隐藏层的激活函数是 sigmoid

y = tf.sigmoid(y)

softmax 与 交叉熵(corss entropy) 的组合函数,损失函数是交叉熵的均值

# softmax & corss_entropy

cross_entropy = tf.nn.softmax_cross_entropy_with_logits_v2(labels=y_, logits=y)

# mean

cross_entropy_mean = tf.reduce_mean(cross_entropy)

为了防止神经网络过拟合,需加入正则化项,一般选取 “L2 正则化”

loss = cross_entropy_mean + \

tf.contrib.layers.l2_regularizer(regulation_lamda)(w1) + \

tf.contrib.layers.l2_regularizer(regulation_lamda)(w2)

为了加速神经网络的训练过程,需加入“指数衰减”技术

表示训练过程的计算图,优化方法选择了 Adam 算法,本质是反向传播算法。还可以选择“梯度下降法”(GradientDescentOptimizer)

train_step = tf.train.AdamOptimizer(learning_rate=learning_rate).minimize(loss)

训练阶段

with tf.Session() as sess: # Session 最好在“上下文机制”中开启,以防资源泄露

init_op = tf.global_variables_initializer() # 初始化网络中节点的参数,主要是 w1,w2

sess.run(init_op)

steps = 10000

for i in range(steps):

beg = (i * batch_size) % dataset_size # 计算 batch

end = min(beg+batch_size, dataset_size) # 计算 batch

sess.run(train_step, feed_dict={x:X[beg:end], y_:Y[beg:end]}) # 反向传播,训练网络

if i % 1000 == 0:

total_corss_entropy = sess.run( # 计算交叉熵

cross_entropy_mean, # 计算交叉熵

feed_dict={x:X, y_:Y} # 计算交叉熵

)

print("After %d training steps, cross entropy on all data is %g" % (i, total_corss_entropy))

在训练阶段中,需要引入“滑动平均模型”来提高模型在测试数据上的健壮性(这是书上的说法,而我认为是泛化能力)

全部代码

# -*- encoding=utf8 -*-

from sklearn.datasets import load_iris

import tensorflow as tf

def label_convert(Y):

l = list()

for y in Y:

if y == 0:

l.append([1,0,0])

elif y == 1:

l.append([0, 1, 0])

elif y == 2:

l.append([0, 0, 1])

return l

def load_data():

iris = load_iris()

X = iris.data

Y = label_convert(iris.target)

return (X,Y)

if __name__ == '__main__':

X,Y = load_data()

learning_rate = 0.001

batch_size = 10

dataset_size = 150

regulation_lamda = 0.001

w1 = tf.Variable(tf.random_normal([4,5], stddev=1, seed=1))

w2 = tf.Variable(tf.random_normal([5,3], stddev=1, seed=1))

x = tf.placeholder(tf.float32, shape=(None, 4), name='x-input')

y_ = tf.placeholder(tf.float32, shape=(None, 3), name='y-input')

a = tf.matmul(x, w1)

y = tf.matmul(a, w2)

y = tf.sigmoid(y)

cross_entropy = tf.nn.softmax_cross_entropy_with_logits_v2(labels=y_, logits=y)

cross_entropy_mean = tf.reduce_mean(cross_entropy)

loss = cross_entropy_mean + \

tf.contrib.layers.l2_regularizer(regulation_lamda)(w1) + \

tf.contrib.layers.l2_regularizer(regulation_lamda)(w2)

train_step = tf.train.AdamOptimizer(learning_rate=learning_rate).minimize(loss)

with tf.Session() as sess:

init_op = tf.global_variables_initializer()

sess.run(init_op)

steps = 10000

for i in range(steps):

beg = (i * batch_size) % dataset_size

end = min(beg+batch_size, dataset_size)

sess.run(train_step, feed_dict={x:X[beg:end], y_:Y[beg:end]})

if i % 1000 == 0:

total_corss_entropy = sess.run(

cross_entropy_mean,

feed_dict={x:X, y_:Y}

)

print("After %d training steps, cross entropy on all data is %g" % (i, total_corss_entropy))

print(sess.run(w1))

print(sess.run(w2))

Experiment Result

random split cross validation

Iris Classification on Tensorflow的更多相关文章

- Iris Classification on Keras

Iris Classification on Keras Installation Python3 版本为 3.6.4 : : Anaconda conda install tensorflow==1 ...

- Implementing a CNN for Text Classification in TensorFlow

参考: 1.Understanding Convolutional Neural Networks for NLP 2.Implementing a CNN for Text Classificati ...

- [转] Implementing a CNN for Text Classification in TensorFlow

Github上的一个开源项目,文档讲得极清晰 Github - https://github.com/dennybritz/cnn-text-classification-tf 原文- http:// ...

- Iris Classification on PyTorch

Iris Classification on PyTorch code # -*- coding:utf8 -*- from sklearn.datasets import load_iris fro ...

- CNN tensorflow text classification CNN文本分类的例子

from:http://deeplearning.lipingyang.org/tensorflow-examples-text/ TensorFlow examples (text-based) T ...

- python tensorflow model

step01_formula # -*- coding: utf-8 -*- """ 단순 선형회귀방정식 : x(1) -> y - y = a*X + b (a ...

- Chinese-Text-Classification,用卷积神经网络基于 Tensorflow 实现的中文文本分类。

用卷积神经网络基于 Tensorflow 实现的中文文本分类 项目地址: https://github.com/fendouai/Chinese-Text-Classification 欢迎提问:ht ...

- TensorFlow 中文资源全集,官方网站,安装教程,入门教程,实战项目,学习路径。

Awesome-TensorFlow-Chinese TensorFlow 中文资源全集,学习路径推荐: 官方网站,初步了解. 安装教程,安装之后跑起来. 入门教程,简单的模型学习和运行. 实战项目, ...

- 在 TensorFlow 中实现文本分类的卷积神经网络

在TensorFlow中实现文本分类的卷积神经网络 Github提供了完整的代码: https://github.com/dennybritz/cnn-text-classification-tf 在 ...

随机推荐

- Java语言基础问题

1. 一个Java类文件中可以有几个公有类 在eclipse中测试代码时会出现上图所示的错误,此处只允许用final或abstract来修饰类,也就是一个类文件中只能有一个public修饰的类,此下对 ...

- 实验一Java开发环境的熟悉-3

实现学生成绩管理功能(增删改,排序,查找),并进行测试(正常情况,异常情况,边界情况). 代码:

- jenkins 添加 证书凭证Credentials

jenkins 添加 证书凭证Credentials 大家都知道jenkins在拉取git项目代码的时候,如果没有配置 “证书凭证Credentials” 或者配置的不对, 就会出现红色报错,最终导致 ...

- xcode 各版本下载地址及其它工具下载地址

官方下载地址:https://developer.apple.com/downloads/

- 【cocos2d-js官方文档】事件分发监听机制(摘录)

简介 游戏开发中一个很重要的功能就是交互,如果没有与用户的交互,那么游戏将变成动画,而处理用户交互就需要使用事件监听器了. 总概: 事件监听器(cc.EventListener) 封装用户的事件处理逻 ...

- hadoop管理

hadoop管理工具: 一,dfsadmin工具 dfsadmin 工具用途比较广,既可以查找HDFS状态信息,又可以在HDFS上执行管理操作,以hdfs dfsadmin形式调用,且需要超级用户权限 ...

- java virtual machine launcher Error:Could not create the Java Virtual Machine. Error:A Fatal exception has occurred,Program will exit.

Error:Could not create the Java Virtual Machine. Error:A Fatal exception has occurred,Program will e ...

- java中的锁之AbstractQueuedSynchronizer源码分析(一)

一.AbstractQueuedSynchronizer类介绍. 该抽象类有两个内部类,分别是静态不可继承的Node类和公有的ConditionObject类.AbstractQueuedSynchr ...

- 20171130-2-python orm

https://www.cnblogs.com/pycode/p/mysql-orm.html https://www.cnblogs.com/Hiberniane/archive/2011/01/3 ...

- STL之stack容器

1.stack容器 1) stack是堆栈容器,是一种“先进后出”的容器. 2)stack是简单地装饰deque容器而成为另外的一种容器. 3)头文件.#include <stack> 2 ...