caffe中 softmax 函数的前向传播和反向传播

1.前向传播:

template <typename Dtype>

void SoftmaxLayer<Dtype>::Forward_cpu(const vector<Blob<Dtype>*>& bottom,

const vector<Blob<Dtype>*>& top) {

const Dtype* bottom_data = bottom[]->cpu_data();

Dtype* top_data = top[]->mutable_cpu_data();

Dtype* scale_data = scale_.mutable_cpu_data();

int channels = bottom[]->shape(softmax_axis_);

int dim = bottom[]->count() / outer_num_; //dim表示要分类的类别数,count()得到的是总共的输入Blob数,outer_num_得到的是是每一类的Blob数

caffe_copy(bottom[]->count(), bottom_data, top_data); //先将输入拷贝到输出缓冲区

// We need to subtract the max to avoid numerical issues, compute the exp,

// and then normalize,减去最大值,避免数值问题,计算指数,归一化

for (int i = ; i < outer_num_; ++i) {

// 初始化scale_的data域为第一个平面,其中scale用来存放临时计算结果

caffe_copy(inner_num_, bottom_data + i * dim, scale_data);

for (int j = ; j < channels; j++) {

for (int k = ; k < inner_num_; k++) {

scale_data[k] = std::max(scale_data[k],

bottom_data[i * dim + j * inner_num_ + k]);

}

}

// 输出缓冲区减去最大值

caffe_cpu_gemm<Dtype>(CblasNoTrans, CblasNoTrans, channels, inner_num_,

, -., sum_multiplier_.cpu_data(), scale_data, ., top_data);

// exponentiation

caffe_exp<Dtype>(dim, top_data, top_data);

// sum after exp

caffe_cpu_gemv<Dtype>(CblasTrans, channels, inner_num_, .,

top_data, sum_multiplier_.cpu_data(), ., scale_data);

// division

for (int j = ; j < channels; j++) {

caffe_div(inner_num_, top_data, scale_data, top_data);

top_data += inner_num_;

}

}

}

一般的我们有top[0]来存放数据,top[1]来存放标签(对于bottom也一样)

2.反向传播:

template <typename Dtype>

void SoftmaxLayer<Dtype>::Backward_cpu(const vector<Blob<Dtype>*>& top,

const vector<bool>& propagate_down,

const vector<Blob<Dtype>*>& bottom) {

const Dtype* top_diff = top[]->cpu_diff();

const Dtype* top_data = top[]->cpu_data();

Dtype* bottom_diff = bottom[]->mutable_cpu_diff();

Dtype* scale_data = scale_.mutable_cpu_data();

int channels = top[]->shape(softmax_axis_);

int dim = top[]->count() / outer_num_;

caffe_copy(top[]->count(), top_diff, bottom_diff); //先用top_diff初始化bottom_diff

for (int i = ; i < outer_num_; ++i) {

// 计算top_diff和top_data的点积,然后从bottom_diff中减去该值

for (int k = ; k < inner_num_; ++k) {

scale_data[k] = caffe_cpu_strided_dot<Dtype>(channels,

bottom_diff + i * dim + k, inner_num_,

top_data + i * dim + k, inner_num_);

}

// 减值

caffe_cpu_gemm<Dtype>(CblasNoTrans, CblasNoTrans, channels, inner_num_, ,

-., sum_multiplier_.cpu_data(), scale_data, ., bottom_diff + i * dim);

}

// 逐点相乘

caffe_mul(top[]->count(), bottom_diff, top_data, bottom_diff);

}

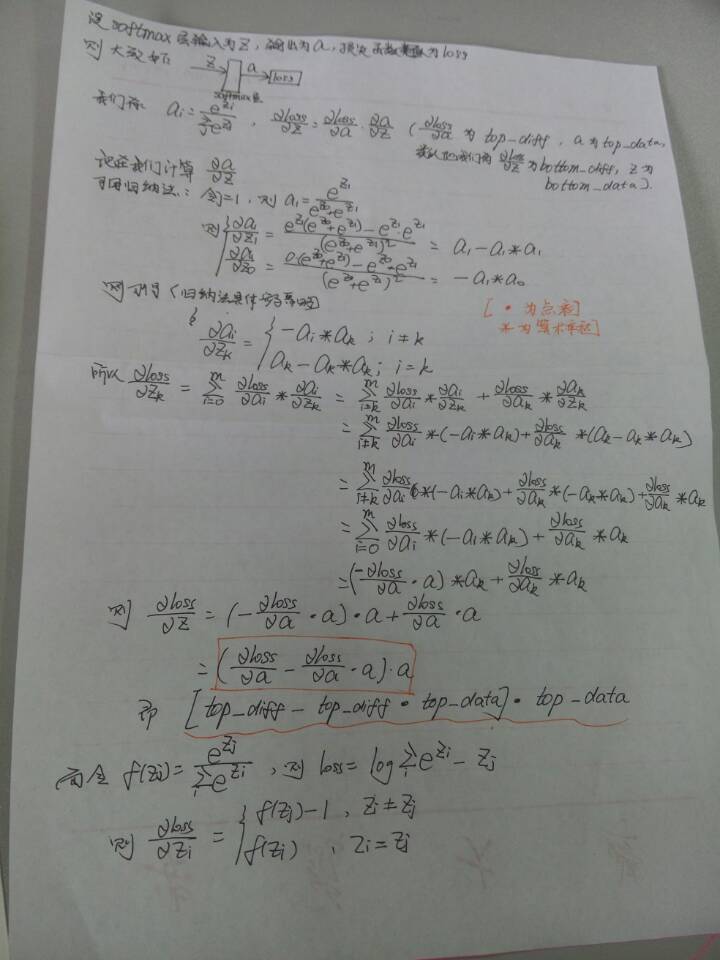

解释:

补充:最后部分,Zi!=Zj和Zi=Zj部分写反了,大家注意一下~

caffe中 softmax 函数的前向传播和反向传播的更多相关文章

- 机器学习(ML)八之正向传播、反向传播和计算图,及数值稳定性和模型初始化

正向传播 正向传播的计算图 通常绘制计算图来可视化运算符和变量在计算中的依赖关系.下图绘制了本节中样例模型正向传播的计算图,其中左下角是输入,右上角是输出.可以看到,图中箭头方向大多是向右和向上,其中 ...

- 小白学习之pytorch框架(6)-模型选择(K折交叉验证)、欠拟合、过拟合(权重衰减法(=L2范数正则化)、丢弃法)、正向传播、反向传播

下面要说的基本都是<动手学深度学习>这本花书上的内容,图也采用的书上的 首先说的是训练误差(模型在训练数据集上表现出的误差)和泛化误差(模型在任意一个测试数据集样本上表现出的误差的期望) ...

- caffe中的前向传播和反向传播

caffe中的网络结构是一层连着一层的,在相邻的两层中,可以认为前一层的输出就是后一层的输入,可以等效成如下的模型 可以认为输出top中的每个元素都是输出bottom中所有元素的函数.如果两个神经元之 ...

- caffe中softmax源码阅读

(1) softmax函数 (1) 其中,zj 是softmax层的bottom输入, f(zj)是softmax层的top输 ...

- BP原理 - 前向计算与反向传播实例

Outline 前向计算 反向传播 很多事情不是需要聪明一点,而是需要耐心一点,踏下心来认真看真的很简单的. 假设有这样一个网络层: 第一层是输入层,包含两个神经元i1 i2和截距b1: 第二层是隐含 ...

- 反向传播算法(前向传播、反向传播、链式求导、引入delta)

参考链接: 一文搞懂反向传播算法

- caffe中softmax loss源码阅读

(1) softmax loss <1> softmax loss的函数形式为: (1) zi为softmax的输入,f(zi)为softmax的输出. <2> sof ...

- 前向传播和反向传播实战(Tensor)

前面在mnist中使用了三个非线性层来增加模型复杂度,并通过最小化损失函数来更新参数,下面实用最底层的方式即张量进行前向传播(暂不采用层的概念). 主要注意点如下: · 进行梯度运算时,tensorf ...

- caffe中python接口的使用

下面是基于我自己的接口,我是用来分类一维数据的,可能不具通用性: (前提,你已经编译了caffe的python的接口) 添加 caffe塻块的搜索路径,当我们import caffe时,可以找到. 对 ...

随机推荐

- centos Install Docker

安装必备软件 $ yum -y install iptables iptables-services net-tools vim wget $ wget -P ~ https://github.com ...

- hihoCoder#1743:K-偏差排列(矩阵快速幂+状压dp)

题意 如果一个 \(1\to N\) 的排列 \(P=[P_1, P_2, ... P_N]\) 中的任意元素 \(P_i\) 都满足 \(|P_i-i| ≤ K\) ,我们就称 \(P\) 是 \( ...

- 字符串格式化format方法

通过位置参数传参 print('{}, {}'.format('KeithTt', 18)) # KeithTt, 18 位置参数可以通过索引调用 print('{1}, {0}'.format('K ...

- AAD Service Principal获取azure user list (Microsoft Graph API)

本段代码是个通用性很强的sample code,不仅能够操作AAD本身,也能通过Azure Service Principal的授权来访问和控制Azure的订阅资源.(Azure某种程度上能看成是两个 ...

- JSP总结(一)——基础(汇总)

前言:原本呢,是打算只写个JSP的内置对象总结,但是没想到这个家伙的JSP总结非常不错,我就拿来用了. 注:后缀为汇总的基本上是整理一些网上的. 借鉴地址:http://www.cnblogs.com ...

- loadrunner之Java Vuser协议脚本编写

步骤:1.根据自己使用的lr版面选择jdk 1)LR11 1.6 32位 2)LR12 1.7 32位 2.安装好jdk,并搭建java环境变量,安装好java代码编写工具 3.在sr ...

- 【转载】关闭XenServer中挂起(hang)虚机的方法

在XenServer中,碰到VM挂起(hang)的情况,也不是那么少见,而VM长时间挂起,那么很影响心情和后续的操作. 一般情况下,为了关闭VM或者重启VM,我们推荐这样的操作顺序: 进入到VM内,使 ...

- JAVA记录-SpringMVC国际化配置

1.搭建SpringMVC框架,不过多阐述 2.spring-mvc.xml加入以下配置: <!-- 国际化资源配置,资源文件绑定器--> <bean id="messag ...

- scala面向对象.高阶函数,柯里化,Actor编程简介

1.定义一个类 class Person{ //用val修饰的变量是只读属性,有getter但是没有setter val id ="111" //用var修饰的变量既有getter ...

- 解决logstash启动缓慢问题

在部署logstash时,头几次启动时长还可以,最后高达半小时以上启动启动不了,上网查资料说,系统的“熵”过低,导致jruby启动缓慢.需要安装haveged.但是我安装完后还是慢 https://h ...