Python 爬取高清桌面壁纸

今天写了一个脚本用来爬取ZOL桌面壁纸网站的高清图片;

链接:http://desk.zol.com.cn/1920x1080/

本程序只爬了美女板块的图片,若要下载其他板块,只需修改程序中的”meinv“即可

代码如下:

#coding=utf-8

import urllib

import re

import time

class Spider:

baseUrl='http://desk.zol.com.cn/'

pic_index=0

itemGroupPic=[]

def __init__(self,page_count):

time.sleep(1)

url=self.baseUrl+"meinv/1920x1080/"

for i in range(10, page_count):

time.sleep(5)

html=self.getHtml(url,i)

getbi=self.getPageImageGroup(html)

bizhi_url=self.getbizhiurlList(getbi)

def getHtml(self,url,page_index):

url=url+str(page_index)+".html"

page = urllib.urlopen(url)

html = page.read()

return html

def getPageImageGroup(self,html):

reg=r'<a class="pic" href="/bizhi/.*?.html'

imgre=re.compile(reg)

imagelist=re.findall(imgre,html)

return imagelist

def getbizhiurlList(self,imagelist):

for iurl in imagelist:

reg=r'bizhi/.*?.html'

imgre=re.compile(reg)

itmeimageurl=re.findall(imgre,iurl)

self.itemGroupPic.append(itmeimageurl)

def GetCurrentUrlAndDownload(self,url):

page = urllib.urlopen(url)

html = page.read() #read()出来的文本和网页右键源代码有点出入,这里需要优化

reg=r'<img id="bigImg" src="http://.*.jpg"'

imgre=re.compile(reg)

urllist=re.findall(imgre,html)

for _u in urllist:

reg1=r'http://.*.jpg'

imgre1=re.compile(reg1)

itmeimageurl=re.findall(imgre1,_u)

print u'正在下载'+str(self.pic_index)+u'图片'

#D:\PictureAvi目录要事先创建好

urllib.urlretrieve(itmeimageurl[0],'D:\PictureAvi\%s.jpg' % self.pic_index)

self.pic_index+=1

#获取当前页面的url,next_html

next_reg=r'<a id="pageNext" class="next" href=".*.html"'

next_imgre=re.compile(next_reg)

next_urllist=re.findall(next_imgre,html)

if(len(next_urllist)==0):

return ""

#获取真正的next_html

next_reg_child=r'bizhi.*?.html'

next_imgre_child=re.compile(next_reg_child)

real_url=re.findall(next_imgre_child,next_urllist[0])

return real_url[0]

def MatchUrl(self,imagelist):

for imgurl in imagelist:

url=self.baseUrl+imgurl[0]

next_url=self.GetCurrentUrlAndDownload(url)

#递归获取下一个url

while(next_url != ''):

_itme_next_url=self.baseUrl+next_url

next_url=self.GetCurrentUrlAndDownload(_itme_next_url)

if __name__ == '__main__':

spider = Spider(15)

spider.MatchUrl(spider.itemGroupPic)

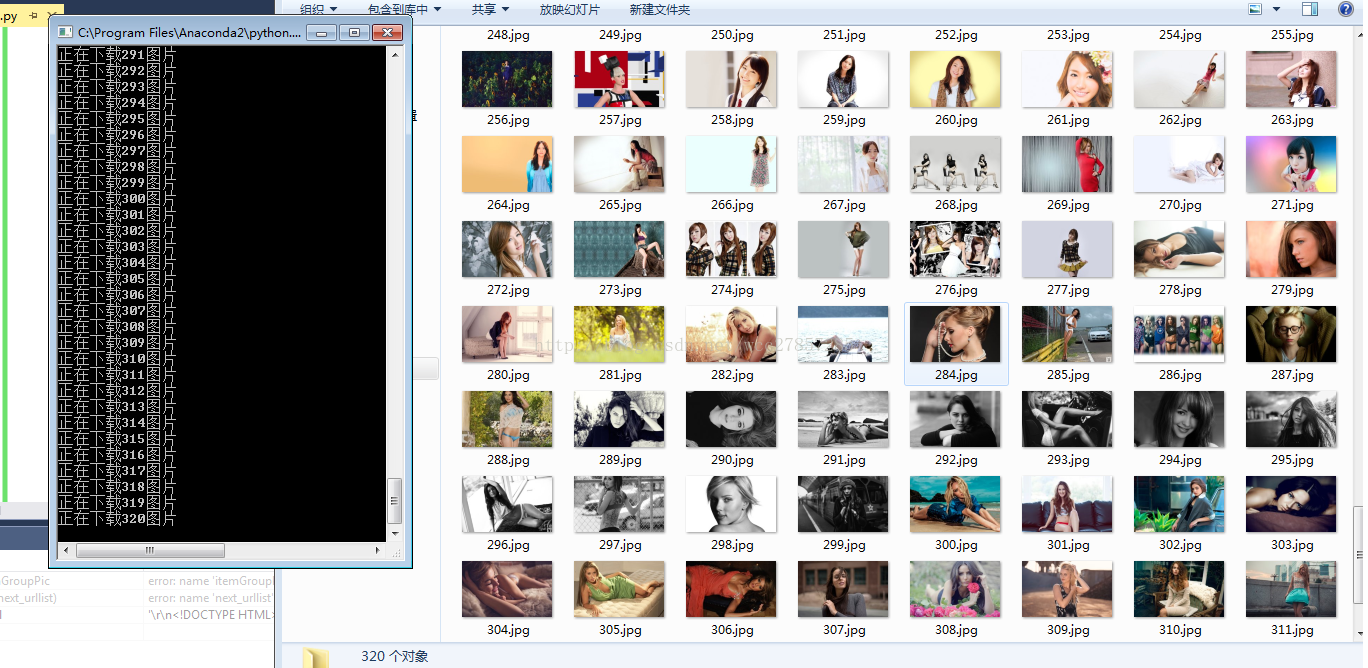

print u'结束下载'运行结果如下:

运行环境是py2.7,原理很简单,并没有用到类似scrapy这样的框架,也没用什么动态获取

1.通过urllib获取网页源代码

2.找到规律,通过正则表达式找到url

3.用urllib下载到本地文件

未完待续。。。。。

Python 爬取高清桌面壁纸的更多相关文章

- Python 爬取 "王者荣耀.英雄壁纸" 过程中的矛和盾

1. 前言 学习爬虫,最好的方式就是自己编写爬虫程序. 爬取目标网站上的数据,理论上讲是简单的,无非就是分析页面中的资源链接.然后下载.最后保存. 但是在实施过程却会遇到一些阻碍. 很多网站为了阻止爬 ...

- python3爬取高清壁纸(1)

这次爬取的目标是:美桌网首页 > 桌面壁纸 > 卡通动漫 类别下的壁纸. 我们先随机选取一个专辑来爬(http://www.win4000.com/wallpaper_detail_545 ...

- python3爬取高清壁纸(2)

上次只是爬取一个专辑的图片,这次要爬取一整个页面的所有专辑的图片. 在上次的代码的基础上进行修改就行了,从专辑的索引页面开始,爬取该页面上所有的专辑的链接,再套用上次的代码就行了. 若要爬取多个页面只 ...

- python爬取高匿代理IP(再也不用担心会进小黑屋了)

为什么要用代理IP 很多人学习python,不知道从何学起.很多人学习python,掌握了基本语法过后,不知道在哪里寻找案例上手.很多已经做案例的人,却不知道如何去学习更加高深的知识.那么针对这三类人 ...

- python 爬取王者荣耀高清壁纸

代码地址如下:http://www.demodashi.com/demo/13104.html 一.前言 打过王者的童鞋一般都会喜欢里边设计出来的英雄吧,特别想把王者荣耀的英雄的高清图片当成电脑桌面 ...

- 初识python 之 爬虫:爬取某网站的壁纸图片

用到的主要知识点:requests.get 获取网页HTMLetree.HTML 使用lxml解析器解析网页xpath 使用xpath获取网页标签信息.图片地址request.urlretrieve ...

- Python爬取视频指南

摘自:https://www.jianshu.com/p/9ca86becd86d 前言 前两天尔羽说让我爬一下菜鸟窝的教程视频,这次就跟大家来说说Python爬取视频的经验 正文 https://w ...

- Python 爬取所有51VOA网站的Learn a words文本及mp3音频

Python 爬取所有51VOA网站的Learn a words文本及mp3音频 #!/usr/bin/env python # -*- coding: utf-8 -*- #Python 爬取所有5 ...

- python爬取网站数据

开学前接了一个任务,内容是从网上爬取特定属性的数据.正好之前学了python,练练手. 编码问题 因为涉及到中文,所以必然地涉及到了编码的问题,这一次借这个机会算是彻底搞清楚了. 问题要从文字的编码讲 ...

随机推荐

- 在DataWorks中实现指定UDF只能被指定账户访问

背景 之前写过一篇文章是关于“DataWorks和MaxCompute内部权限体系的区别”有兴趣的朋友可以点击阅读查看详情.但是还是有些同学会问,我如何在DataWorks中实现我的具体某个Resou ...

- Android基础控件TextView

1.常用属性 <TextView android:id="@+id/text11" //组件id android:layout_width="match_paren ...

- SpringBoot学习笔记(二):SpringBoot访问静态文件、捕获全局异常、集成Thymeleaf、集成JSP

SpringBoot访问静态文件 什么是静态文件? 不需要通过web容器去得到的文件,直接通过路径就能得到的文件,比如项目的css,js,img等文件. 所有的资源文件都应该在src/main/res ...

- 08-background详解

<!DOCTYPE html> <html lang="en"> <head> <meta charset="UTF-8&quo ...

- 【深度学习】CNN 中 1x1 卷积核的作用

[深度学习]CNN 中 1x1 卷积核的作用 最近研究 GoogLeNet 和 VGG 神经网络结构的时候,都看见了它们在某些层有采取 1x1 作为卷积核,起初的时候,对这个做法很是迷惑,这是因为之前 ...

- 网络结构解读之inception系列三:BN-Inception(Inception V2)

网络结构解读之inception系列三:BN-Inception(Inception V2) BN的出现大大解决了训练收敛问题.作者主要围绕归一化的操作做了一系列优化思路的阐述,值得细看. Batch ...

- nfs 原理详解

一.NFS介绍 1)什么是NFS 它的主要功能是通过网络让不同的机器系统之间可以彼此共享文件和目录.NFS服务器可以允许NFS客户端将远端NFS服务器端的共享目录挂载到本地的NFS客户端中.在本地的N ...

- Luogu P4933 大师(dp)

P4933 大师 题意 题目背景 建筑大师最近在跟着数学大师ljt12138学数学,今天他学了等差数列,ljt12138决定给他留一道练习题. 题目描述 ljt12138首先建了\(n\)个特斯拉电磁 ...

- [编织消息框架][netty源码分析]5 EventLoopGroup 实现类NioEventLoopGroup职责与实现

分析NioEventLoopGroup最主有两个疑问 1.next work如何分配NioEventLoop 2.boss group 与child group 是如何协作运行的 从EventLoop ...

- LL(1),LR(0),SLR(1),LALR(1),LR(1)对比与分析

前言:考虑到这几种文法如果把具体内容讲下来肯定篇幅太长,而且繁多的符号对初学者肯定是极不友好的,而且我相信看这篇博客的人已经对这几个文法已经有所了解了,本篇博客的内容只是对 这几个文法做一下对比,加深 ...