Tensorflow-各种优化器总结与比较

优化器总结

机器学习中,有很多优化方法来试图寻找模型的最优解。比如神经网络中可以采取最基本的梯度下降法。

梯度下降法(Gradient Descent)

梯度下降法是最基本的一类优化器,目前主要分为三种梯度下降法:标准梯度下降法(GD, Gradient Descent),随机梯度下降法(SGD, Stochastic Gradient Descent)及批量梯度下降法(BGD, Batch Gradient Descent)。

标准梯度下降法(GD)

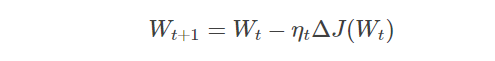

- 假设要学习训练的模型参数为WW,代价函数为J(W)J(W),则代价函数关于模型参数的偏导数即相关梯度为ΔJ(W)ΔJ(W),学习率为ηtηt,则使用梯度下降法更新参数为:

其中,WtWt表示tt时刻的模型参数。

- 从表达式来看,模型参数的更新调整,与代价函数关于模型参数的梯度有关,即沿着梯度的方向不断减小模型参数,从而最小化代价函数。

- 基本策略可以理解为”在有限视距内寻找最快路径下山“,因此每走一步,参考当前位置最陡的方向(即梯度)进而迈出下一步。可以形象的表示为:

评价:标准梯度下降法主要有两个缺点:

- 训练速度慢:每走一步都要要计算调整下一步的方向,下山的速度变慢。在应用于大型数据集中,每输入一个样本都要更新一次参数,且每次迭代都要遍历所有的样本。会使得训练过程及其缓慢,需要花费很长时间才能得到收敛解。

- 容易陷入局部最优解:由于是在有限视距内寻找下山的反向。当陷入平坦的洼地,会误以为到达了山地的最低点,从而不会继续往下走。所谓的局部最优解就是鞍点。落入鞍点,梯度为0,使得模型参数不在继续更新。

批量梯度下降法(BGD)

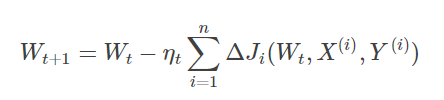

- 假设批量训练样本总数为nn,每次输入和输出的样本分别为X(i),Y(i)X(i),Y(i),模型参数为WW,代价函数为J(W)J(W),每输入一个样本ii代价函数关于WW的梯度为ΔJi(Wt,X(i),Y(i))ΔJi(Wt,X(i),Y(i)),学习率为ηtηt,则使用批量梯度下降法更新参数表达式为:

其中,WtWt表示tt时刻的模型参数。

- 从表达式来看,模型参数的调整更新与全部输入样本的代价函数的和(即批量/全局误差)有关。即每次权值调整发生在批量样本输入之后,而不是每输入一个样本就更新一次模型参数。这样就会大大加快训练速度。

- 基本策略可以理解为,在下山之前掌握了附近的地势情况,选择总体平均梯度最小的方向下山。

评价:

- 批量梯度下降法比标准梯度下降法训练时间短,且每次下降的方向都很正确。

随机梯度下降法(SGD)

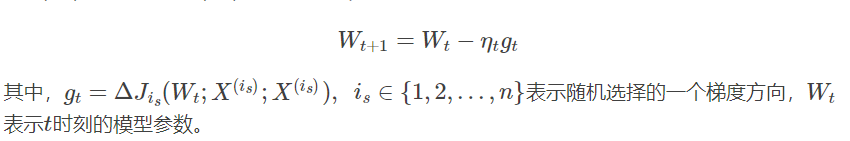

- 对比批量梯度下降法,假设从一批训练样本nn中随机选取一个样本isis。模型参数为WW,代价函数为J(W)J(W),梯度为ΔJ(W)ΔJ(W),学习率为ηtηt,则使用随机梯度下降法更新参数表达式为:

- E(gt)=ΔJ(Wt)E(gt)=ΔJ(Wt),这里虽然引入了随机性和噪声,但期望仍然等于正确的梯度下降。

- 基本策略可以理解为随机梯度下降像是一个盲人下山,不用每走一步计算一次梯度,但是他总能下到山底,只不过过程会显得扭扭曲曲。

评价:

- 优点:

- 虽然SGD需要走很多步的样子,但是对梯度的要求很低(计算梯度快)。而对于引入噪声,大量的理论和实践工作证明,只要噪声不是特别大,SGD都能很好地收敛。

- 应用大型数据集时,训练速度很快。比如每次从百万数据样本中,取几百个数据点,算一个SGD梯度,更新一下模型参数。相比于标准梯度下降法的遍历全部样本,每输入一个样本更新一次参数,要快得多。

- 缺点:

- SGD在随机选择梯度的同时会引入噪声,使得权值更新的方向不一定正确。

- 此外,SGD也没能单独克服局部最优解的问题

动量优化法

动量优化方法是在梯度下降法的基础上进行的改变,具有加速梯度下降的作用。一般有标准动量优化方法Momentum、NAG(Nesterov accelerated gradient)动量优化方法。

NAG在Tensorflow中与Momentum合并在同一函数tf.train.MomentumOptimizer中,可以通过参数配置启用。

Momentum

- 使用动量(Momentum)的随机梯度下降法(SGD),主要思想是引入一个积攒历史梯度信息动量来加速SGD。

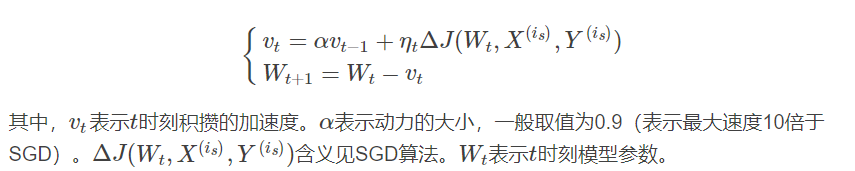

- 从训练集中取一个大小为nn的小批量{X(1),X(2),...,X(n)}{X(1),X(2),...,X(n)}样本,对应的真实值分别为Y(i)Y(i),则Momentum优化表达式为:

- 动量主要解决SGD的两个问题:一是随机梯度的方法(引入的噪声);二是Hessian矩阵病态问题(可以理解为SGD在收敛过程中和正确梯度相比来回摆动比较大的问题)。

- 理解策略为:由于当前权值的改变会受到上一次权值改变的影响,类似于小球向下滚动的时候带上了惯性。这样可以加快小球向下滚动的速度。

NAG

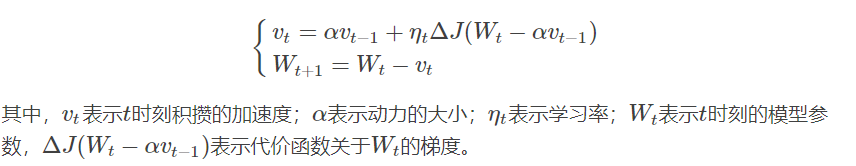

- 牛顿加速梯度(NAG, Nesterov accelerated gradient)算法,是Momentum动量算法的变种。更新模型参数表达式如下:

- Nesterov动量梯度的计算在模型参数施加当前速度之后,因此可以理解为往标准动量中添加了一个校正因子。

- 理解策略:在Momentun中小球会盲目地跟从下坡的梯度,容易发生错误。所以需要一个更聪明的小球,能提前知道它要去哪里,还要知道走到坡底的时候速度慢下来而不是又冲上另一个坡。计算Wt−αvt−1Wt−αvt−1可以表示小球下一个位置大概在哪里。从而可以提前知道下一个位置的梯度,然后使用到当前位置来更新参数。

- 在凸批量梯度的情况下,Nesterov动量将额外误差收敛率从O(1/k)(k步后)O(1/k)(k步后)改进到O(1/k2)O(1/k2)。然而,在随机梯度情况下,Nesterov动量对收敛率的作用却不是很大。

自适应学习率优化算法

自适应学习率优化算法针对于机器学习模型的学习率,传统的优化算法要么将学习率设置为常数要么根据训练次数调节学习率。极大忽视了学习率其他变化的可能性。然而,学习率对模型的性能有着显著的影响,因此需要采取一些策略来想办法更新学习率,从而提高训练速度。

目前的自适应学习率优化算法主要有:AdaGrad算法,RMSProp算法,Adam算法以及AdaDelta算法。

AdaGrad算法

思想:

- AdaGrad算法,独立地适应所有模型参数的学习率,缩放每个参数反比于其所有梯度历史平均值总和的平方根。具有代价函数最大梯度的参数相应地有个快速下降的学习率,而具有小梯度的参数在学习率上有相对较小的下降。

算法描述:

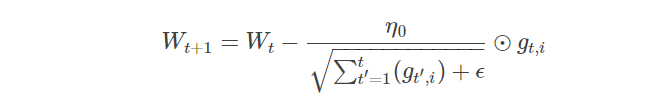

- AdaGrad算法优化策略一般可以表示为:

假定一个多分类问题,ii表示第ii个分类,tt表示第tt迭代同时也表示分类ii累计出现的次数。η0η0表示初始的学习率取值一般为0.01,ϵϵ是一个取值很小的数(一般为1e-8)为了避免分母为0。WtWt表示tt时刻即第tt迭代模型的参数,gt,i=ΔJ(Wt,i)gt,i=ΔJ(Wt,i)表示tt时刻,指定分类ii,代价函数J(⋅)J(⋅)关于WW的梯度。

- 从表达式可以看出,对出现比较多的类别数据,Adagrad给予越来越小的学习率,而对于比较少的类别数据,会给予较大的学习率。因此Adagrad适用于数据稀疏或者分布不平衡的数据集。

- Adagrad 的主要优势在于不需要人为的调节学习率,它可以自动调节;缺点在于,随着迭代次数增多,学习率会越来越小,最终会趋近于0。

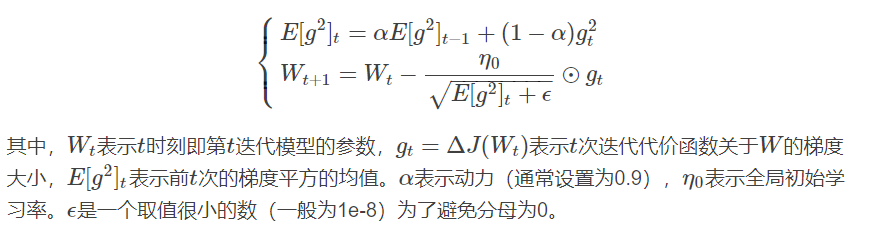

RMSProp算法

思想:

- RMSProp算法修改了AdaGrad的梯度积累为指数加权的移动平均,使得其在非凸设定下效果更好。

算法描述:

- RMSProp算法的一般策略可以表示为:

- RMSProp借鉴了Adagrad的思想,观察表达式,分母为E[g2]t+ϵ−−−−−−−−√E[g2]t+ϵ。由于取了个加权平均,避免了学习率越来越低的的问题,而且能自适应地调节学习率。

- RMSProp算法在经验上已经被证明是一种有效且实用的深度神经网络优化算法。目前它是深度学习从业者经常采用的优化方法之一。

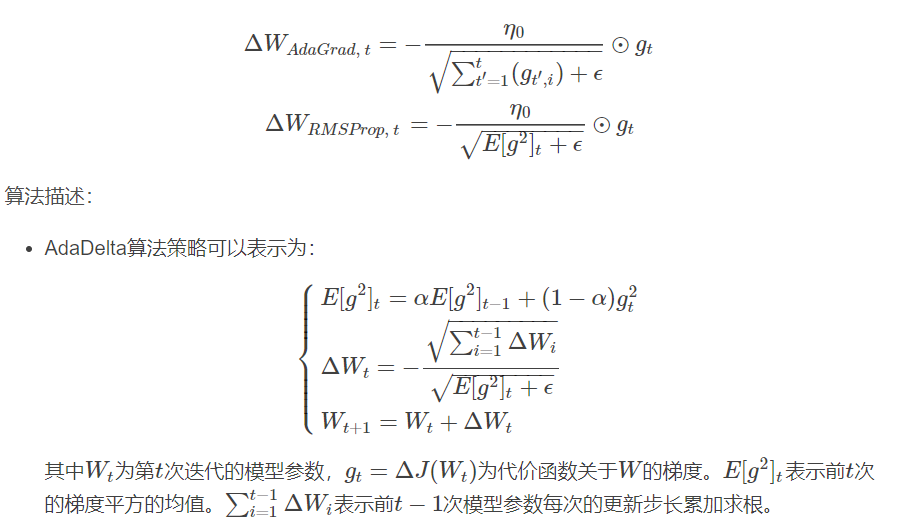

AdaDelta算法

思想:AdaGrad算法和RMSProp算法都需要指定全局学习率,AdaDelta算法结合两种算法每次参数的更新步长即:

- 从表达式可以看出,AdaDelta不需要设置一个默认的全局学习率。

评价:

- 在模型训练的初期和中期,AdaDelta表现很好,加速效果不错,训练速度快。

- 在模型训练的后期,模型会反复地在局部最小值附近抖动。

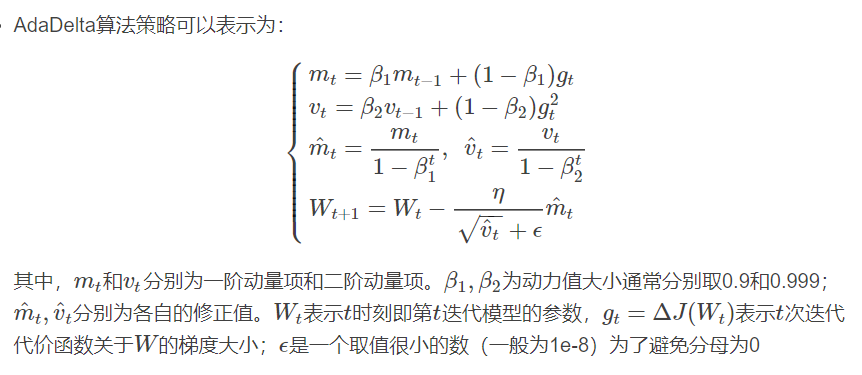

Adam算法

思想:

- 首先,Adam中动量直接并入了梯度一阶矩(指数加权)的估计。其次,相比于缺少修正因子导致二阶矩估计可能在训练初期具有很高偏置的RMSProp,Adam包括偏置修正,修正从原点初始化的一阶矩(动量项)和(非中心的)二阶矩估计。

算法描述:

评价:Adam通常被认为对超参数的选择相当鲁棒,尽管学习率有时需要从建议的默认修改。

各种优化器的比较

终于结束的漫长的理论分析,下面对各种优化器做一些有趣的比较。

可视化比较

(1) 示例一

上图描述了在一个曲面上,6种优化器的表现,从中可以大致看出:

① 下降速度:

- 三个自适应学习优化器Adagrad、RMSProp与AdaDelta的下降速度明显比SGD要快,其中,Adagrad和RMSProp齐头并进,要比AdaDelta要快。

- 两个动量优化器Momentum和NAG由于刚开始走了岔路,初期下降的慢;随着慢慢调整,下降速度越来越快,其中NAG到后期甚至超过了领先的Adagrad和RMSProp。

② 下降轨迹:

- SGD和三个自适应优化器轨迹大致相同。两个动量优化器初期走了“岔路”,后期也调整了过来。

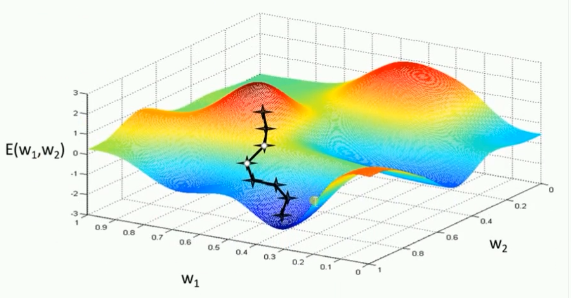

(2) 示例二

上图在一个存在鞍点的曲面,比较6中优化器的性能表现,从图中大致可以看出:

- 三个自适应学习率优化器没有进入鞍点,其中,AdaDelta下降速度最快,Adagrad和RMSprop则齐头并进。

- 两个动量优化器Momentum和NAG以及SGD都顺势进入了鞍点。但两个动量优化器在鞍点抖动了一会,就逃离了鞍点并迅速地下降,后来居上超过了Adagrad和RMSProp。

- 很遗憾,SGD进入了鞍点,却始终停留在了鞍点,没有再继续下降。

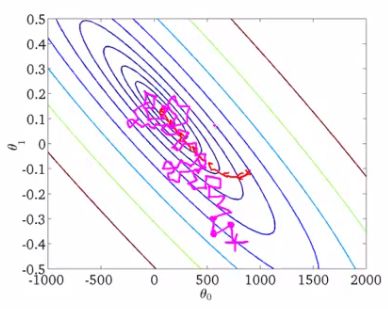

(3) 示例三

上图比较了6种优化器收敛到目标点(五角星)的运行过程,从图中可以大致看出:

① 在运行速度方面

- 两个动量优化器Momentum和NAG的速度最快,其次是三个自适应学习率优化器AdaGrad、AdaDelta以及RMSProp,最慢的则是SGD。

② 在收敛轨迹方面

- 两个动量优化器虽然运行速度很快,但是初中期走了很长的”岔路”。

- 三个自适应优化器中,Adagrad初期走了岔路,但后来迅速地调整了过来,但相比其他两个走的路最长;AdaDelta和RMSprop的运行轨迹差不多,但在快接近目标的时候,RMSProp会发生很明显的抖动。

- SGD相比于其他优化器,走的路径是最短的,路子也比较正。

应用于简单分类问题的比较

使用SGD优化器

#梯度下降:SGD优化器

train_step=tf.compat.v1.train.GradientDescentOptimizer(0.2).minimize(loss)

# Iter 0,Testing Accuracy 0.9236

# Iter 1,Testing Accuracy 0.9449

# Iter 2,Testing Accuracy 0.9508

# Iter 3,Testing Accuracy 0.9527

# Iter 4,Testing Accuracy 0.9591

# Iter 5,Testing Accuracy 0.962

# Iter 6,Testing Accuracy 0.9643

# Iter 7,Testing Accuracy 0.9672

# Iter 8,Testing Accuracy 0.9675

# Iter 9,Testing Accuracy 0.9696

# Iter 10,Testing Accuracy 0.9702

自适应学习率-使用AdaGrad优化器

#使用自适应学习率,使用AdaGrad优化器

train_step=tf.compat.v1.train.AdagradOptimizer(0.2).minimize(loss)

# Iter 0,Testing Accuracy 0.855

# Iter 1,Testing Accuracy 0.8647

# Iter 2,Testing Accuracy 0.957

# Iter 3,Testing Accuracy 0.9633

# Iter 4,Testing Accuracy 0.9683

# Iter 5,Testing Accuracy 0.9723

# Iter 6,Testing Accuracy 0.9707

# Iter 7,Testing Accuracy 0.9727

# Iter 8,Testing Accuracy 0.9748

# Iter 9,Testing Accuracy 0.9738

# Iter 10,Testing Accuracy 0.9752

使用RMSProp优化器

#使用自适应学习率:使用RMSProp优化器

train_step=tf.compat.v1.train.RMSPropOptimizer(0.02).minimize(loss)

# Iter 0,Testing Accuracy 0.9007

# Iter 1,Testing Accuracy 0.9102

# Iter 2,Testing Accuracy 0.9165

# Iter 3,Testing Accuracy 0.9298

# Iter 4,Testing Accuracy 0.9373

# Iter 5,Testing Accuracy 0.9205

# Iter 6,Testing Accuracy 0.9306

# Iter 7,Testing Accuracy 0.9422

# Iter 8,Testing Accuracy 0.9297

# Iter 9,Testing Accuracy 0.9417

# Iter 10,Testing Accuracy 0.9359

使用Adam优化器

# 使用自适应学习绿:使用Adam优化器

train_step=tf.compat.v1.train.AdamOptimizer(0.02,0.9).minimize(loss)

# Iter 0,Testing Accuracy 0.8112

# Iter 1,Testing Accuracy 0.8114

# Iter 2,Testing Accuracy 0.81

# Iter 3,Testing Accuracy 0.7948

# Iter 4,Testing Accuracy 0.8212

# Iter 5,Testing Accuracy 0.8145

# Iter 6,Testing Accuracy 0.8443

# Iter 7,Testing Accuracy 0.8678

# Iter 8,Testing Accuracy 0.8394

# Iter 9,Testing Accuracy 0.8934

# Iter 10,Testing Accuracy 0.8917

使用AdaDelta优化器

#使用自适应学习绿:使用AdaDelta优化器

train_step=tf.compat.v1.train.AdadeltaOptimizer(0.02).minimize(loss)

# Iter 0,Testing Accuracy 0.4545

# Iter 1,Testing Accuracy 0.5644

# Iter 2,Testing Accuracy 0.7053

# Iter 3,Testing Accuracy 0.759

# Iter 4,Testing Accuracy 0.7785

# Iter 5,Testing Accuracy 0.7925

# Iter 6,Testing Accuracy 0.8028

# Iter 7,Testing Accuracy 0.8114

# Iter 8,Testing Accuracy 0.8165

# Iter 9,Testing Accuracy 0.82

# Iter 10,Testing Accuracy 0.8237

动量优化法-Momentum优化器

#使用动量优化法:Momentum优化器

train_step=tf.compat.v1.train.MomentumOptimizer(0.2,0.5).minimize(loss)

# Iter 0,Testing Accuracy 0.8425

# Iter 1,Testing Accuracy 0.8539

# Iter 2,Testing Accuracy 0.9527

# Iter 3,Testing Accuracy 0.9588

# Iter 4,Testing Accuracy 0.9665

# Iter 5,Testing Accuracy 0.9697

# Iter 6,Testing Accuracy 0.9699

# Iter 7,Testing Accuracy 0.9724

# Iter 8,Testing Accuracy 0.9723

# Iter 9,Testing Accuracy 0.9719

# Iter 10,Testing Accuracy 0.9731

动量优化法-NAG优化器

#使用动量优化法:使用NAG优化器

train_step=tf.compat.v1.train.MomentumOptimizer(learning_rate=0.2,momentum=0.5,use_nesterov=True).minimize(loss)

# Iter 0,Testing Accuracy 0.8483

# Iter 1,Testing Accuracy 0.8606

# Iter 2,Testing Accuracy 0.953

# Iter 3,Testing Accuracy 0.9558

# Iter 4,Testing Accuracy 0.9601

# Iter 5,Testing Accuracy 0.9657

# Iter 6,Testing Accuracy 0.9666

# Iter 7,Testing Accuracy 0.9683

# Iter 8,Testing Accuracy 0.9721

# Iter 9,Testing Accuracy 0.9721

# Iter 10,Testing Accuracy 0.9717

NAG在Tensorflow中与Momentum合并在同一函数tf.train.MomentumOptimizer中,可以通过参数配置启用。

综上,比较来说AdaGrad优化器和Momentum优化器相对来说比较好

Tensorflow-各种优化器总结与比较的更多相关文章

- TensorFlow从0到1之TensorFlow优化器(13)

高中数学学过,函数在一阶导数为零的地方达到其最大值和最小值.梯度下降算法基于相同的原理,即调整系数(权重和偏置)使损失函数的梯度下降. 在回归中,使用梯度下降来优化损失函数并获得系数.本节将介绍如何使 ...

- tensorflow优化器-【老鱼学tensorflow】

tensorflow中的优化器主要是各种求解方程的方法,我们知道求解非线性方程有各种方法,比如二分法.牛顿法.割线法等,类似的,tensorflow中的优化器也只是在求解方程时的各种方法. 比较常用的 ...

- DNN网络(三)python下用Tensorflow实现DNN网络以及Adagrad优化器

摘自: https://www.kaggle.com/zoupet/neural-network-model-for-house-prices-tensorflow 一.实现功能简介: 本文摘自Kag ...

- Tensorflow 中的优化器解析

Tensorflow:1.6.0 优化器(reference:https://blog.csdn.net/weixin_40170902/article/details/80092628) I: t ...

- tensorflow的几种优化器

最近自己用CNN跑了下MINIST,准确率很低(迭代过程中),跑了几个epoch,我就直接stop了,感觉哪有问题,随即排查了下,同时查阅了网上其他人的blog,并没有发现什么问题 之后copy了一篇 ...

- 莫烦大大TensorFlow学习笔记(8)----优化器

一.TensorFlow中的优化器 tf.train.GradientDescentOptimizer:梯度下降算法 tf.train.AdadeltaOptimizer tf.train.Adagr ...

- TensorFlow使用记录 (六): 优化器

0. tf.train.Optimizer tensorflow 里提供了丰富的优化器,这些优化器都继承与 Optimizer 这个类.class Optimizer 有一些方法,这里简单介绍下: 0 ...

- TensorFlow优化器及用法

TensorFlow优化器及用法 函数在一阶导数为零的地方达到其最大值和最小值.梯度下降算法基于相同的原理,即调整系数(权重和偏置)使损失函数的梯度下降. 在回归中,使用梯度下降来优化损失函数并获得系 ...

- Tensorflow 2.0 深度学习实战 —— 详细介绍损失函数、优化器、激活函数、多层感知机的实现原理

前言 AI 人工智能包含了机器学习与深度学习,在前几篇文章曾经介绍过机器学习的基础知识,包括了监督学习和无监督学习,有兴趣的朋友可以阅读< Python 机器学习实战 >.而深度学习开始只 ...

- TensorFlow优化器浅析

本文基于tensorflow-v1.15分支,简单分析下TensorFlow中的优化器. optimizer = tf.train.GradientDescentOptimizer(learning_ ...

随机推荐

- [LeetCode]Path Sum系列

1.二叉树路径求指定和,需要注意的是由于有负数,所以即使发现大于目标值也不能返回false,而且返回true的条件有两个,到叶节点且等于sum,缺一不可 public boolean hasPathS ...

- 转【深入理解SQL的四种连接-左外连接、右外连接、内连接、全连接】

转自:https://www.jb51.net/article/39432.htm 1.内联接(典型的联接运算,使用像 = 或 <> 之类的比较运算符).包括相等联接和自然联接. ...

- 【STL 源码剖析】浅谈 STL 迭代器与 traits 编程技法

大家好,我是小贺. 点赞再看,养成习惯 文章每周持续更新,可以微信搜索「herongwei」第一时间阅读和催更,本文 GitHub : https://github.com/rongweihe/Mor ...

- 第二章节 BJROBOT IMU 自动校正 【ROS全开源阿克曼转向智能网联无人驾驶车】

1.把小车平放在地板上,用资料里的虚拟机,打开一个终端 ssh 过去主控端启动roslaunch znjrobot bringup.launch . 2.再打开一个终端,ssh 过去主控端,在 ~/c ...

- 在 CAP 中使用 AOP ( Castle.DynamicProxy )

简介 本篇文章主要介绍如何在 CAP 中集成使用 Castle.DynamicProxy,Castle DynamicProxy 是一个用于在运行时动态生成轻量级.NET代理的库.代理对象允许在不修改 ...

- http ContentLength 为0 下载问题

如图 通过http 下载某个东西 , WebResponse response = request.GetResponse(); response 调试如图 ContentLength 为0 ...

- .net core 中使用Log4net输出日志到Mysql数据库中

.net core 中使用Log4net输出日志到数据库中去 1.使用Nuget安装log4net 和 mysql.data 2.设置log4net 的配置文件 log4net.config 可以设置 ...

- Flutter 基础组件:按钮

前言 Material组件库中提供了多种按钮组件如RaisedButton.FlatButton.OutlineButton等,它们都是直接或间接对RawMaterialButton组件的包装定制,所 ...

- Tomcat-8.5.23 基于域名和端口的虚拟主机

下载tomcat yum install java -y cd /opt/ wget http://mirror.bit.edu.cn/apache/tomcat/tomcat-8/v8.5.23/b ...

- appium识别工具介绍