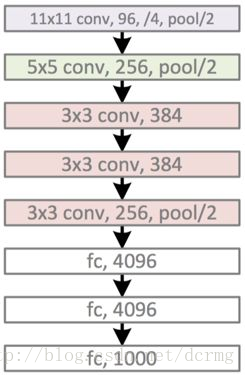

AlexNet神经网络结构

Alexnet是2014年Imagenet竞赛的冠军模型,准确率达到了57.1%, top-5识别率达到80.2%。

AlexNet包含5个卷积层和3个全连接层,模型示意图:

精简版结构:

conv1阶段

输入数据:227×227×3

卷积核:11×11×3;步长:4;数量(也就是输出个数):96

卷积后数据:55×55×96 (原图N×N,卷积核大小n×n,卷积步长大于1为k,输出维度是(N-n)/k+1)

relu1后的数据:55×55×96

Max pool1的核:3×3,步长:2

Max pool1后的数据:27×27×96

norm1:local_size=5 (LRN(Local Response Normalization) 局部响应归一化)

最后的输出:27×27×96

AlexNet采用了Relu激活函数,取代了之前经常使用的S函数和T函数,Relu函数也很简单:

ReLU(x) = max(x,0)

AlexNet另一个创新是LRN(Local Response Normalization) 局部响应归一化,LRN模拟神经生物学上一个叫做 侧抑制(lateral inhibitio)的功能,侧抑制指的是被激活的神经元会抑制相邻的神经元。LRN局部响应归一化借鉴侧抑制的思想实现局部抑制,使得响应比较大的值相对更大,提高了模型的泛化能力。

LRN只对数据相邻区域做归一化处理,不改变数据的大小和维度。

LRN概念是在AlexNet模型中首次提出,在GoogLenet中也有应用,但是LRN的实际作用存在争议,如在2015年Very Deep Convolutional Networks for Large-Scale Image Recognition 论文中指出LRN基本没什么用。

AlexNet还应用了Overlapping(重叠池化),重叠池化就是池化操作在部分像素上有重合。池化核大小是n×n,步长是k,如果k=n,则是正常池化,如果 k<n, 则是重叠池化。官方文档中说明,重叠池化的运用减少了top-5和top-1错误率的0.4%和0.3%。重叠池化有避免过拟合的作用。

conv2阶段

输入数据:27×27×96

卷积核:5×5;步长:1;数量(也就是输出个数):256

卷积后数据:27×27×256 (做了Same padding(相同补白),使得卷积后图像大小不变。)

relu2后的数据:27×27×256

Max pool2的核:3×3,步长:2

Max pool2后的数据:13×13×256 ((27-3)/2+1=13 )

norm2:local_size=5 (LRN(Local Response Normalization) 局部响应归一化)

最后的输出:13×13×256

在AlexNet的conv2中使用了same padding,保持了卷积后图像的宽高不缩小。

conv3阶段

输入数据:13×13×256

卷积核:3×3;步长:1;数量(也就是输出个数):384

卷积后数据:13×13×384 (做了Same padding(相同补白),使得卷积后图像大小不变。)

relu3后的数据:13×13×384

最后的输出:13×13×384

conv3层没有Max pool层和norm层

conv4阶段

输入数据:13×13×384

卷积核:3×3;步长:1;数量(也就是输出个数):384

卷积后数据:13×13×384 (做了Same padding(相同补白),使得卷积后图像大小不变。)

relu4后的数据:13×13×384

最后的输出:13×13×384

conv4层也没有Max pool层和norm层

conv5阶段

输入数据:13×13×384

卷积核:3×3;步长:1;数量(也就是输出个数):256

卷积后数据:13×13×256 (做了Same padding(相同补白),使得卷积后图像大小不变。)

relu5后的数据:13×13×256

Max pool5的核:3×3,步长:2

Max pool2后的数据:6×6×256 ((13-3)/2+1=6 )

最后的输出:6×6×256

conv5层有Max pool,没有norm层

fc6阶段

输入数据:6×6×256

全连接输出:4096×1

relu6后的数据:4096×1

drop out6后数据:4096×1

最后的输出:4096×1

AlexNet在fc6全连接层引入了drop out的功能。dropout是指在深度学习网络的训练过程中,对于神经网络单元,按照一定的概率(一般是50%,这种情况下随机生成的网络结构最多)将其暂时从网络中丢弃(保留其权值),不再对前向和反向传输的数据响应。注意是暂时,对于随机梯度下降来说,由于是随机丢弃,故而相当于每一个mini-batch都在训练不同的网络,drop out可以有效防止模型过拟合,让网络泛化能力更强,同时由于减少了网络复杂度,加快了运算速度。还有一种观点认为drop

out有效的原因是对样本增加来噪声,变相增加了训练样本。

fc7阶段

输入数据:4096×1

全连接输出:4096×1

relu7后的数据:4096×1

drop out7后数据:4096×1

最后的输出:4096×1

fc8阶段

输入数据:4096×1

全连接输出:1000

fc8输出一千种分类的概率。

AlexNet与在其之前的神经网络相比改进:

1. 数据增广(Data Augmentation增强)

常用的数据增强的方法有 水平翻转、随机裁剪、平移变换、颜色、光照、对比度变换

2. Dropout

有效防止过拟合。

3. Relu激活函数

用ReLU代替了传统的S或者T激活函数。

4. Local Response Normalization 局部响应归一化

参考了生物学上神经网络的侧抑制的功能,做了临近数据归一化,提高来模型的泛化能力,这一功能的作用有争议。

5. Overlapping Pooling 重叠池化

重叠池化减少了系统的过拟合,减少了top-5和top-1错误率的0.4%和0.3%。

6. 多GPU并行训练

AlexNet将网络分成了上下两部分,两部分的结构完全一致,这两部分由两块不同的GPU来训练,提高了训练速度。AlexNet大约有6000万个参数。

AlexNet神经网络结构的更多相关文章

- 深度神经网络结构以及Pre-Training的理解

Logistic回归.传统多层神经网络 1.1 线性回归.线性神经网络.Logistic/Softmax回归 线性回归是用于数据拟合的常规手段,其任务是优化目标函数:$h(\theta )=\thet ...

- GoogLeNet 神经网络结构

GoogLeNet是2014年 ILSVRC 冠军模型,top-5 错误率 6.7% ,GoogLeNet做了更大胆的网络上的尝试而不像vgg继承了lenet以及alexnet的一些框架,该模型虽然有 ...

- 神经网络结构在命名实体识别(NER)中的应用

神经网络结构在命名实体识别(NER)中的应用 近年来,基于神经网络的深度学习方法在自然语言处理领域已经取得了不少进展.作为NLP领域的基础任务-命名实体识别(Named Entity Recognit ...

- Evolution of Image Classifiers,进化算法在神经网络结构搜索的首次尝试 | ICML 2017

论文提出使用进化算法来进行神经网络结构搜索,整体搜索逻辑十分简单,结合权重继承,搜索速度很快,从实验结果来看,搜索的网络准确率挺不错的.由于论文是个比较早期的想法,所以可以有很大的改进空间,后面的很大 ...

- CARS: 华为提出基于进化算法和权值共享的神经网络结构搜索,CIFAR-10上仅需单卡半天 | CVPR 2020

为了优化进化算法在神经网络结构搜索时候选网络训练过长的问题,参考ENAS和NSGA-III,论文提出连续进化结构搜索方法(continuous evolution architecture searc ...

- EAS:基于网络转换的神经网络结构搜索 | AAAI 2018

论文提出经济实惠且高效的神经网络结构搜索算法EAS,使用RL agent作为meta-controller,学习通过网络变换进行结构空间探索.从指定的网络开始,通过function-preservin ...

- 经典卷积神经网络结构——LeNet-5、AlexNet、VGG-16

经典卷积神经网络的结构一般满足如下表达式: 输出层 -> (卷积层+ -> 池化层?)+ -> 全连接层+ 上述公式中,“+”表示一个或者多个,“?”表示一个或者零个,如“卷积层+ ...

- CNN 卷积神经网络结构

cnn每一层会输出多个feature map, 每个Feature Map通过一种卷积滤波器提取输入的一种特征,每个feature map由多个神经元组成,假如某个feature map的shape是 ...

- 神经网络结构:DenseNet

论文地址:密集连接的卷积神经网络 博客地址(转载请引用):https://www.cnblogs.com/LXP-Never/p/13289045.html 前言 在计算机视觉还是音频领域,卷积神经网 ...

随机推荐

- java.util.Calendar简介

Calendar是一个抽象类,我们无法直接实例化它,它有一个具体子类实体类java.util.GregorianCalendar,这个类实现的就是我们日常所用的公历历法,或者叫做阳历.我们可以直接使用 ...

- 第二课 GCC入门之静态库以及共享库

序言: 前面一课讲了gcc的简单入门,包括gcc编译步骤:预处理:编译:汇编:链接.今天这节课就来讲下linux的库也欢迎大家吐糟共同学习. 原理: linux系统中分为2种库:静态库和共享库.静态库 ...

- 10 Spring框架 AOP (三) Spring对AspectJ的整合

上两节我们讲了Spring对AOP的实现,但是在我们的开发中我们不太使用Spring自身的对AOP的实现,而是使用AspectJ,AspectJ是一个面向切面的框架,它扩展了Java语言.Aspect ...

- HDU - 6321 Problem C. Dynamic Graph Matching (状压dp)

题意:给定一个N个点的零图,M次操作,添加或删除一条边,每一次操作以后,打印用1,2,...N/2条边构成的匹配数. 分析:因为N的范围很小,所以可以把点的枚举状态用二进制表示集合.用一维数组dp[S ...

- [转]Linux下RPM软件包的安装及卸载 yum操作

在 Linux 操作系统下,几乎所有的软件均通过RPM 进行安装.卸载及管理等操作.RPM 的全称为Redhat Package Manager ,是由Redhat 公司提出的,用于管理Linux 下 ...

- Python学习笔记之Python的enumerate函数

Python 的 enumerate() 函数就像是一个神秘的黑箱,你无法简单地用一句话来概括这个函数的作用与用法. enumerate() 函数属于非常有用的高级用法,而对于这一点,很多初学者甚至中 ...

- Oracle数据库使用总结

--1.使用月份作为条件筛选(to_char函数与extract函数使用) select * from test_date where to_char(dqsj,'mm') like '%07%'; ...

- 尽可能的构建一个拓展性比"较好"的项目,会让你后期迭代好受点

转载请注明出处:王亟亟的大牛之路 这礼拜基本都在忙自己项目上的事,然后之后会"重新整理"后把这部分的功能开源出来,这里@下队友 NeglectedByBoss 本周还是没有停更收纳 ...

- webstorm打开带有node_modules文件夹的工程时很卡

ctrl+alt+s打开settings 在webstorm中配置这个就可以不加载出来node_modules使页面加载快

- Image合并添加文字内容

场景:将一个头像.二维码.文字信息添加到一张背景图片中,将这些信息合成一张图片. 代码已经测试验证.代码中图片自己随意找几张测试即可. 代码: import com.sun.image.codec.j ...