【云原生 · Kubernetes】部署zookeeper

部署zookeeper

1.1 zookeeper概述

ZooKeeper是一种 为分布式应用所设计的高可用、高性能 且一致的 开源协调服务,它提供了一项基本服务:分布式锁服务。由于ZooKeeper的开源特性,后来的开发者在分布式锁的基础上,摸索了出了其他的使用方法:配置维护、组服务、分布式消息队列、分布式通知/协调等。 在分布式协调技术方面做得比较好的就是Google的Chubby还有Apache的ZooKeeper都是分布式锁的实现者。Chbby是非开源的,Google自家用。后来雅虎模仿Chubby开

发出了ZooKeeper,也实现了类似的分布式锁的功能,并且将ZooKeeper作为一种开源的程序捐献给了Apache。注意:ZooKeeper性能上的特点决定了它能够用在大型的、分布式的系统中。可靠性方面来,它并不会因为一个节

点的错误 而崩溃。除此之外,它严格的序列访问控制 意味着复杂的控制原语 可以应用在客户端上。ZooKeeper在一致性、可用性、容错性的保证,也是ZooKeeper的成功之处,它获得的一切成功都与它采用的协议——Zab协议

是密不可分的。 ZooKeeper在实现这些服务(分布式锁、配置维护、组服务等)时,首先它设计一种新的数据结构——Znode,然后在该数据结构的基础上定义了一些原语,也就是一些关于该数据结构的一些操作。有了这些数据

结构和原语还不够,因为ZooKeeper是工作在一个分布式的环境下,服务是通过消息以网络的形式发送给分布式应用程序,所以还需要一个通知机制——Watcher机制。那么总结一下,ZooKeeper所提供的服务主要是通过:数据结构+原语+watcher机制,三个部分来实现的。

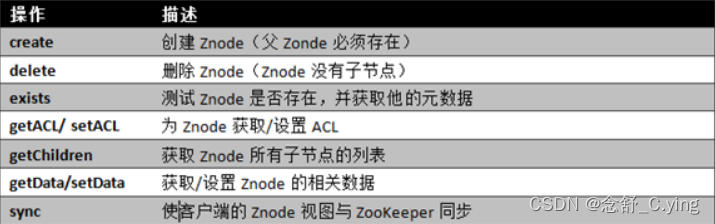

1.2 ZooKeeper服务中操作

在ZooKeeper中有9个基本操作,如下图所示: 图ZooKeeper类方法描述

更新ZooKeeper操作是有限制的。delete或setData必须明确要更新的Znode的版本号,我们可以调用exists找到。如果版本号不匹配,更新将会失败。 更新ZooKeeper操作是非阻塞式的。因此客户端如果失去了一个更新(由

于另一个进程在同时更新这个Znode),他可以在不阻塞其他进程执行的情况下,选择重新尝试或进行其他操作。

尽管ZooKeeper可以被看做是一个文件系统,但是处于便利,摒弃了一些文件系统地操作原语。因为文件非常的小并且使整体读写的,所以不需要打开、关闭或是寻地的操作。

1.3 Watch触发器

(1) watch概述 ZooKeeper可以为所有的读操作设置watch,这些读操作包括:exists()、getChildren()及getData()。watch事件是一次性的触发器,当watch的对象状态发生改变时,将会触发此对象上watch所对应的事

件。watch事件将被异步地发送给客户端,并且ZooKeeper为watch机制提供了有序的一致性保证。理论上,客户端接收watch事件的时间要快于其看到watch对象状态变化的时间。

(2) watch类型 ZooKeeper所管理的watch可以分为两类: ① 数据watch(data watches):getData和exists负责设置数据watch ② 孩子watch(child watches):getChildren负责设置孩子watch 可以通过操作返回的数据来设置不同的watch: ① getData和exists:返回关于节点的数据信息 ② getChildren:返回孩子列表 因此 ① 一个成功的setData操作将触发Znode的数据watch ② 一个成功的create操作将触发Znode的数据watch以及孩子watch ③ 一个成功的delete操作将触发Znode的数据watch以及孩子watch

(3) watch注册与处触器: ① exists操作上的watch,在被监视的Znode创建、删除或数据更新时被触发。 ② getData操作上的watch,在被监视的Znode删除或数据更新时被触发。在被创建时不能被触发,因为只有Znode一定存在,getData操作才会成功。 ③ getChildren操作上的watch,在被监视的Znode的子节点创建或删除,或是这个Znode自身被删除时被触发。可以通过查看watch事件类型来区分是Znode,还是他的子节点被删除:NodeDelete表示Znode被删除,NodeDeletedChanged表示子节点被删除。

1.3 ZooKeeper中的时间

ZooKeeper有多种记录时间的形式,其中包含以下几个主要属性:

(1) Zxid 致使ZooKeeper节点状态改变的每一个操作都将使节点接收到一个Zxid格式的时间戳,并且这个时间戳全局有序。也就是说,也就是说,每个对 节点的改变都将产生一个唯一的Zxid。如果Zxid1的值小于Zxid2的值,那么Zxid1所对应的事件发生在Zxid2所对应的事件之前。实际 上,ZooKeeper的每个节点维护者三个Zxid值,为别为:cZxid、mZxid、pZxid。 ① cZxid: 是节点的创建时间所对应的Zxid格式时间戳。 ② mZxid:是节点的修改时间所对应的Zxid格式时间戳。 实现中Zxid是一个64为的数字,它高32位是epoch用来标识leader关系是否改变,每次一个leader被选出来,它都会有一个 新的epoch。低32位是个递增计数。

(2) 版本号 对节点的每一个操作都将致使这个节点的版本号增加。每个节点维护着三个版本号,他们分别为: ① version:节点数据版本号 ② cversion:子节点版本号 ③ aversion:节点所拥有的ACL版本号

1.4 zookeeper 的应用

(1) Master启动 在引入了Zookeeper以后启动两个主节点,“主节点-A"和"主节点-B” 启动以后,都向ZooKeeper去注册一个节点(znode)。假设"主节点-A"锁注册znode是"master-00001", “主节点-B"注册的节点是"master00002”,注册完以后进行选举,编号最小的节点将在选举中获胜获得锁成为主节点,也就是"主节点-A"将会获得锁成为主节点,然后"主节点-B"将被阻塞成为一个备用节点。通过这种方式就完成了对两个Master进程的调度。

(2) Master故障 如果"主节点-A"挂了,此时它所注册的节点将被自动删除,ZooKeeper会自动感知节点的变化,然后再次发出选举,此时”主节点-B"将在选举中获胜,替代"主节点-A"成为主节点。

1.5 zookeeper的配置

[root@vm2 ~]# wget http://mirror.bit.edu.cn/apache/zookeeper/zookeeper-3.4.12/zookeeper3.4.12.tar.gz

[root@vm2 ~]# tar xfz zookeeper-3.4.12.tar.gz -C /usr/local/

[root@vm2 ~]# cd /usr/local/

[root@vm2 local]# ln -s zookeeper-3.4.12 zookeeper

[root@vm2 conf]# cd zookeeper/conf

[root@vm2 conf]# cp zoo_sample.cfg zoo.cfg

zoo.cfg文件如下:

tickTime = 2000

dataDir = /opt/zookeeper-3.4.9/data

dataLogDir = /opt/zookeeper-3.4.9/logs

tickTime = 2000

clientPort = 2181

initLimit = 5

syncLimit = 2

server.1=node1:2888:3888

server.2=node2:2888:3888

server.3=node3:2888:3888

syncLimit 配置follower和leader之间发送消息,请求和应答的最大时间长度。 server.id=host:port1:port2 server.id 其中id为一个数字,表示zk进程的id,这个id也是data目录下myid文件的内容 host 是该zk进程所在的IP地址 port1 表示follower和leader交换消息所使用的端口port2 表示选举leader所使用的端口 在data里会放置一个myid文件,里面就个数字,用来唯一标识这个服务。

这个id是很重要的,一定要保证整个集群中唯一 ZooKeeper会根据这个id来取出server.x上的配置。

[root@vm2 zookeeper]# pwd

/usr/local/zookeeper

[root@vm2 zookeeper]# bin/zkServer.sh start

[root@vm2 zookeeper]# bin/zkCli.sh

[zk: localhost:2181(CONNECTED) 4] ls /

[inspiry, zookeeper, firstZone]

[zk: localhost:2181(CONNECTED) 5] rmr /firstZone

[zk: localhost:2181(CONNECTED) 6] ls /

[inspiry, zookeeper]

[zk: localhost:2181(CONNECTED) 7]

[zk: localhost:2181(CONNECTED) 9] create /firstZnode mydata

Created /firstZnode

[zk: localhost:2181(CONNECTED) 10] get /firstZnode

mydata

cZxid = 0x120000000c

ctime = Mon Jun 11 19:19:36 CST 2018

mZxid = 0x120000000c

mtime = Mon Jun 11 19:19:36 CST 2018

pZxid = 0x120000000c

cversion = 0

dataVersion = 0

aclVersion = 0

ephemeralOwner = 0x0

dataLength = 6

numChildren = 0

[zk: localhost:2181(CONNECTED) 11] set /firstZnode "welcome to Inspiry"

cZxid = 0x120000000c

ctime = Mon Jun 11 19:19:36 CST 2018

mZxid = 0x120000000d

mtime = Mon Jun 11 19:20:11 CST 2018

pZxid = 0x120000000c

cversion = 0

dataVersion = 1

aclVersion = 0

ephemeralOwner = 0x0

dataLength = 18

numChildren = 0

[zk: localhost:2181(CONNECTED) 12] get /firstZnode

welcome to Inspiry

cZxid = 0x120000000c

ctime = Mon Jun 11 19:19:36 CST 2018

mZxid = 0x120000000d

mtime = Mon Jun 11 19:20:11 CST 2018

pZxid = 0x120000000c

cversion = 0

dataVersion = 1

aclVersion = 0

ephemeralOwner = 0x0

dataLength = 18

numChildren = 0

[zk: localhost:2181(CONNECTED) 13]

[zk: localhost:2181(CONNECTED) 13] ls /

[inspiry, zookeeper, firstZnode]

[zk: localhost:2181(CONNECTED) 14]

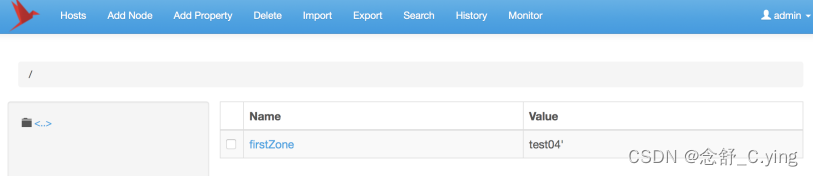

1.6 关于管理界面zkui

[root@meteor ~]# git clone https://github.com/DeemOpen/zkui.git

正克隆到 'zkui'...

remote: Counting objects: 527, done.

remote: Total 527 (delta 0), reused 0 (delta 0), pack-reused 526

接收对象中: 100% (527/527), 478.39 KiB | 300.00 KiB/s, done.

处理 delta 中: 100% (217/217), done.

[root@meteor ~]#

[root@meteor ~]# cd zkui/

[root@meteor zkui]# mvn clean package

[root@meteor zkui]# ls target/

archive-tmp generated-sources surefire-reports zkui-2.0-SNAPSHOT.jar

classes maven-archiver test-classes zkui-2.0-SNAPSHOT-jar-with-dependencies.jar

[root@meteor zkui]#

[root@meteor zkui]# vim config.cfg

[root@meteor zkui]# grep -Pv "^(#|$)" config.cfg

serverPort=9090

zkServer=meteor:2181,vm1:2181,vm2:2181

scmRepo=http://myserver.com/@rev1=

scmRepoPath=//appconfig.txt

ldapAuth=false

ldapDomain=mycompany,mydomain

ldapUrl=ldap://<ldap_host>:<ldap_port>/dc=mycom,dc=com

ldapRoleSet={"users": [{ "username":"domain\\user1" , "role": "ADMIN" }]}

userSet = {"users": [{ "username":"admin" , "password":"******","role": "ADMIN" },{

"username":"appconfig" , "password":"******","role": "USER" }]}

env=prod

jdbcClass=org.h2.Driver

jdbcUrl=jdbc:h2:zkui

jdbcUser=root

jdbcPwd=manager

loginMessage=Please login using admin/manager or appconfig/appconfig.

sessionTimeout=300

zkSessionTimeout=5

blockPwdOverRest=false

https=false

keystoreFile=/home/user/keystore.jks

keystorePwd=password

keystoreManagerPwd=password

defaultAcl=

X-Forwarded-For=false

[root@meteor zkui]#

[root@meteor zkui]# nohup java -jar target/zkui-2.0-SNAPSHOT-jar-with-dependencies.jar &

[1] 17262

[root@meteor zkui]# nohup: 忽略输入并把输出追加到"nohup.out"

[root@meteor zkui]# ls

config.cfg images Makefile nohup.out README.md src zkui.h2.db

docker LICENSE-2.0.txt nbactions.xml pom.xml run.sh target zkui-out.log

[root@meteor zkui]# firewall-cmd --add-port=9090/tcp --perm

success

[root@meteor zkui]# firewall-cmd --reload

success

[root@meteor zkui]#

可以在pom.xml文件中添加如下内容:

<distributionManagement>

<repository>

<id>releases</id>

<url>http://192.168.20.221:8081/repository/maven-releases/</url>

</repository>

<snapshotRepository>

<id>snapshots</id>

<url>http://192.168.20.221:8081/repository/maven-snapshots/</url>

</snapshotRepository>

</distributionManagement>

然后执行deploy,把包存储到nexus上

[root@meteor zkui]# mvn deploy

注:需要在cluster中的所有机器上都部署并启动exhibitor ,exhibitor还可以监控zookeeper进程的状态,如果发现zookeeper进程down掉,exhibitor会自动拉起zookeeper进程;而且exhibitor还可以在界面上配置、重启

zookeeper,它是一款非常不错的zookeeper进程管理程序。

期待下次的分享,别忘了三连支持博主呀~

我是 念舒_C.ying ,期待你的关注~

附专栏链接

【云原生 · Kubernetes】部署 kube-proxy 组件

【云原生 · Kubernetes】部署高可用kube-scheduler集群

【云原生 · Kubernetes】部署高可用 kube-controller-manager 集群

【云原生 · Kubernetes】runtime组件

【云原生 · Kubernetes】apiserver高可用

【云原生 · Kubernetes】部署zookeeper的更多相关文章

- 系列文章:云原生Kubernetes日志落地方案

在Logging这块做了几年,最近1年来越来越多的同学来咨询如何为Kubernetes构建一个日志系统或者是来求助在这过程中遇到一系列问题如何解决,授人以鱼不如授人以渔,于是想把我们这些年积累的经验以 ...

- [云原生]Kubernetes - 集群搭建(第2章)

目录 一.前置知识点 二.kubeadm部署方式介绍 三.安装要求 四.最终目标 五.准备环境 六.环境初始化 6.1 设置系统主机名以及Hosts文件的相互解析 6.2 安装依赖文件(所有节点) 6 ...

- 干货 | 京东云原生容器—SpringCloud实践(一)

"云原生"成为近年热词并不是一种偶然,它不是一个软件,也不是一种框架,而是一堆理念集合,以及围绕这些理念所产生的一些最佳实践的工具.云原生天然就是作用于服务架构的,可以视作一个服务 ...

- 云原生项目实践DevOps(GitOps)+K8S+BPF+SRE,从0到1使用Golang开发生产级麻将游戏服务器—第1篇

项目初探 项目地址: 原项目:https://github.com/lonng/nanoserver 调过的:https://github.com/Kirk-Wang/nanoserver 这将是一个 ...

- 从Kubernetes到“云原生全家桶”,网易如何让业务部署提效280%?

近日,网易云轻舟微服务团队接受了CNCF的采访,分享了网易云在云原生领域尤其是Kubernetes方面的实践经验.以下为案例全文:公司:网易地点:中国杭州行业:互联网技术 挑战它的游戏业务是世界上最大 ...

- 干货 | 京东云托管Kubernetes集成镜像仓库并部署原生DashBoard

在上一篇"Cloud Native 实操系列"文章中,我们为大家介绍了如何通过京东云原生容器实现Eureka的部署(

- Apache ShardingSphere 5.1.2 发布|全新驱动 API + 云原生部署,打造高性能数据网关

在 Apache ShardingSphere 5.1.1 发布后,ShardingSphere 合并了来自全球的团队或个人的累计 1028 个 PR,为大家带来 5.1.2 新版本.该版本在功能.性 ...

- 如何将云原生工作负载映射到 Kubernetes 中的控制器

作者:Janakiram MSV 译者:殷龙飞 原文地址:https://thenewstack.io/how-to-map-cloud-native-workloads-to-kubernetes- ...

- 《Kubernetes与云原生应用》系列之容器设计模式

http://www.infoq.com/cn/articles/kubernetes-and-cloud-native-app-container-design-pattern <Kubern ...

- Kubernetes 入门必备云原生发展简史

作者|张磊 阿里云容器平台高级技术专家,CNCF 官方大使 "未来的软件一定是生长于云上的"这是云原生理念的最核心假设.而所谓"云原生",实际上就是在定义一条能 ...

随机推荐

- LibreCAD常用命令

目录 常见命令 常见命令 .text_center { text-align: center } \3cp>.text_left { } 动作命令 命令 绘制直线 相对坐标系 @长度<角度 ...

- 知乎问题之:.NET AOT编译后能替代C++吗?

标题上的Native库是指:Native分为静态库( 作者:nscript链接:https://www.zhihu.com/question/536903224/answer/2522626086 ( ...

- Java Socket底层实现浅析

最近在学Java的socket编程,发现Java可以很简单的通过socketAPI实现网络通信,但是我一直有个疑问,Java的socket的底层是怎么实现的? 如果没记错的话Java的底层是C和C++ ...

- golang 实现笛卡尔积(泛型)

背景 input: [[a,b],[c],[d,e]] output: [[a,c,d],[a,c,e],[b,c,d],[b,c,e]] 思路:分治 预处理第一项:[a,b] -> [[a], ...

- Prometheus 监控外部 Kubernetes 集群

转载自:https://www.qikqiak.com/post/monitor-external-k8s-on-prometheus/ 在实际环境中很多企业是将 Prometheus 单独部署在集群 ...

- 8.第七篇 验证kube-apiserver及kubeconfig配置详解

文章转载自:https://mp.weixin.qq.com/s?__biz=MzI1MDgwNzQ1MQ==&mid=2247483818&idx=1&sn=7572b791 ...

- Logstash:使用Logstash将电子邮件导入到Elasticsearch

- Alertmanager篇

报一直是整个监控系统中的重要组成部分,Prometheus监控系统中,采集与警报是分离的.警报规则在 Prometheus 定义,警报规则触发以后,才会将信息转发到给独立的组件 Alertmanage ...

- 1_Layui

一. 引言 官网: https://www.layui.com/ 在官网首页, 可以很方便的下载Layui Layui是一款经典模块化前端UI框架, 我们只需要定义简单的HTML,CSS,JS即可实现 ...

- NSIS检测到窗口最小化闪烁提示

#检测到窗口为最小化时闪烁提示 !include nsDialogs.nsh #编写:水晶石 Name "IsIconic Example" OutFile "IsIco ...