hadoop1.2.1伪分布模式安装教程

1:软件环境准备

1.1Hadoop:

我们使用hadoop Release 1.2.1(stable)版本,下载链接:

http://mirrors.ustc.edu.cn/apache/hadoop/common/hadoop-1.2.1/

我们选择hadoop-1.2.1-bin.tar.gz文件下载。

1.2Java:

Java在这里使用的是jdk1.7版本的,当然也可以使用1.6的,下载链接:

http://www.oracle.com/technetwork/java/javase/downloads/jdk7-downloads-1880260.html

我们选择Linux x86的jdk-7u40-linux-i586.tar.gz版本下载,因为我的Linux机器是32位的;如果Linux机器是64的就必须选择64位的下载,可以选择jdk-7u40-linux-x64.tar.gz;这个步骤非常重要,不同的机器必须要配置不同的jdk版本。

2:安装到Linux中

2.1创建目录:

首先我们创建一个目录:

mkdir /data/installation,该目录存储下载好的的两个安装文件包。

mkdir /data/software/hadoop,该目录存储hadoop程序文件。

mkdir /data/software/java,该目录存储jdk的文件。

mkdir /data/software/eclipse,该目录存储eclipse的文件。

注意:在实际安装的时候我们最好单独为运行hadoop程序建立一个账号,并赋予相关权限。在这里我直接以root身份安装。

2.2解压安装包文件:

把刚刚下载好的文件都放到/data/installation/目录下。

首先解压java安装包文件,运行以下命令:

tar -xzvf /data/installation/jdk-7u40-linux-x64.tar.gz -C /data/software/java/

然后解压hadoop安装包文件,运行以下命令:

tar -xzvf /data/installation/hadoop-1.2.1-bin.tar.gz -C /data/software/hadoop/

最后解压eclipse安装包文件,运行以下命令:

tar -xzvf /data/installation/eclipse-standard-kepler-SR1-linux-gtk.tar.gz -C /data/software/eclipse/

3:配置Hadoop

Hadoop环境的配置关重要,首先必须要配置java运行环境。

3.1配置java环境:

添加JAVA_HOME,CLASSPATH环境变量:

使用vi /etc/profile命令编辑profile文件,在文件末尾加上以下内容:

HADOOP_INSTALL=/data/software/hadoop/hadoop-1.2.1/

JAVA_HOME=/data/software/java/jdk1.7.0_40

PATH=$JAVA_HOME/bin:$HADOOP_INSTALL/bin:$PATH

CLASSPATH=$JAVA_HOME/lib

export JAVA_HOME PATH CLASSPATH HADOOP_INSTALL

然后保存,退出,使用source /etc/profile使刚刚的更改立即生效。

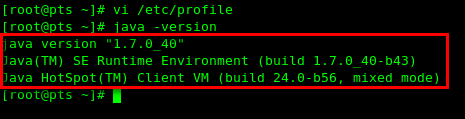

然后使用java –version命令,查看是否配置成功,如果成功会出现以下信息:

java version "1.7.0_40"

Java(TM) SE Runtime Environment (build 1.7.0_40-b43)

Java HotSpot(TM) Client VM (build 24.0-b56, mixed mode)

3.2配置ssh环境:

使用以下命令设置ssh无密码连接:

ssh-keygen -t dsa -P "" -f ~/.ssh/id_dsa

cat ~/.ssh/id_dsa.pub >> ~/.ssh/authorized_keys

测试ssh配置是否成功:

ssh localhost

可以看到配置成功了,连接无需使用密码了;

配置ssh无密码访问有很多种方法,以上只是其中一种,以下是另外一种方法:

cd ~

ssh-keygen -t rsa

cd .ssh

cp id_rsa.pub authorized_keys

ssh hostname //测试连接hostname是否成功

3.3配置hadoop环境:

我们首先进入到/data/software/hadoop/hadoop-1.2.1/conf这个目录,然后可以看到haddoop-env.sh,core-site.xml,mapred-site.xml,hdfs-site.xml这四个文件以及需要在完全分布模式配置的slaves和masters文件:

3.3.1配置hadoop-env.sh:

首先我们用vi hadoop-env.sh命令编辑打开hadoop-env.sh文件,找到JAVA_HOME关键字所在的行,把前面的#号去掉,然后填写实际的JAVA_HOME地址:

export JAVA_HOME=/data/software/java/jdk1.7.0_40

3.3.2配置core-site.xml:

vi core-site.xml打开core-site.xml文件,然后在configuration标签中加入以下内容:

<property>

<name>fs.default.name</name>

<value>hdfs://localhost:9000</value>

</propety>

<!—fs.default.name:用来配置namenode,指定HDFS文件系统的URL,通过该URL我们可以访问文件系统的内容,也可以把localhost换成本机IP地址;如果是完全分布模式,则必须把localhost改为实际namenode机器的IP地址;如果不写端口,则使用默认端口8020。 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/data/tmp/hadoop_tmp</value>

</property>

<!-- hadoop.tmp.dir:Hadoop的默认临时路径,这个最好配置,如果在新增节点或者其他情况下莫名其妙的DataNode启动不了,就删除此文件中的tmp目录即可。不过如果删除了NameNode机器的此目录,那么就需要重新执行NameNode格式化的命令。该目录必须预先手工创建。-->

3.3.3配置hdfs-site.xml:

在configuration标签中加入以下内容,所有不存在的目录都要预先创建:

<property>

<name>dfs.data.dir</name>

<value>/data/appdata/hadoopdata</value>

</property>

<!--配置HDFS存储目录,数据存放目录,用于datanode存放数据-->

<property>

<name>dfs.name.dir</name>

<value>/data/appdata/hadoopname</value>

</property>

<!—用来存储namenode的文件系统元数据,包括编辑日志和文件系统映像,如果更换地址的话,则需要重新使用hadoop namenode –format命令格式化namenode-->

<property>

<name>dfs.replication</name>

<value>1</value>

</proerty>

<!—用来设置文件系统冗余备份数量,因为只有一个节点,所有设置为1,系统默认数量为3-->

3.3.4配置mapred-site.xml:

在configuration标签中加入以下内容:

<property>

<name>mapred.job.tracker</name>

<value>localhost:9001</value>

</property>

<!—该项配置用来配置jobtracker节点,localhost也可以换成本机的IP地址;真实分布模式下注意更改成实际jobtracker机器的IP地址-->

4:启动hadoop

4.1:测试hadoop配置是否成功:

4.2:格式化namenode:

cd /data/software/hadoop/hadoop-1.2.1/bin

./hadoop namenode –format

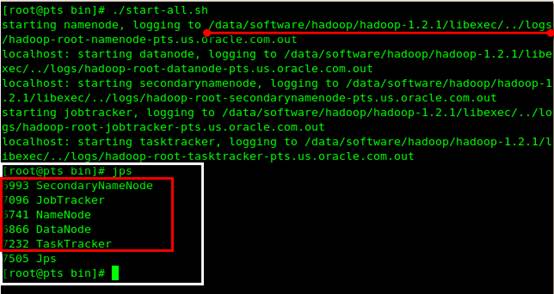

4.3:启动hadoop进程,运行start-all.sh:

cd /data/software/hadoop/hadoop-1.2.1/bin

./start-all.sh

我们可以通过java的jps命令来查看进程是否启动成功,从下图可以看到,我们已经成功启动SecondaryNamenode,JobTracker,NameNode,DataNode,TraskTracker五个进程,而刚好这五个进程是hadoop所需要的。如果有一个进程没有启动成功,就表示整个集群没有正常工作,我们可以进入/data/software/hadoop/hadoop-1.2.1/libexec/../logs/目录下查看失败日记。

4.4:从浏览器查看hadoop信息:

我们可以从本机或者其他机器的浏览器访问hadoop。

查看jobtracker信息:

http://192.168.0.107:50030/jobtracker.jsp

上图显示的只是该页面的部分信息。

查看namenode信息:

http://192.168.0.107:50070/dfshealth.jsp

上图显示的只是该页面的部分信息。

查看trasktracker信息:

http://192.168.0.107:50060/tasktracker.jsp

5:hadoop实例

在这里我们来测试下hadoop自带的examples例子,该例子里面有个wordcount类,wordcount用来计算文件里面每一个单词出现了多少次数。examples jar包位于hadoop安装目录下,名称叫做hadoop-examples-1.2.1.jar:

5.1:进入到bin目录中去

首先我们进入到bin目录中去:

cd /data/software/hadoop/hadoop-1.2.1/bin

5.2:创建文件夹

然后我们创建一个input文件夹,并且创建3个文件,给每个文件写一些内容:

mkdir input

echo “hello hadoop” >input/f1.txt

echo “hello word” >input/f2.txt

echo “hello java” >input/f3.txt

5.3:在hadoop中创建文件夹

使用以下命令在hadoop中创建文件夹:

hadoop dfs –mkdir input

然后我们查看在hadoop中是否已经创建该文件夹:

hadoop dfs –ls /user/root

我们可以看到已经成功在hadoop中创建了input文件夹。

5.4:把文件复制到hadoop中

使用以下命令把文件从Linux中复制到hadoop中:

hadoop dfs –put input/* input

查看文件是否在hadoop中:

hadoop dfs –ls input

查看文件内容是否一致:

hadoop dfs –cat input/f1.txt

可以看到,文件已经成功放入hadoop文件系统中了。

5.5:从浏览器中查看文件内容

我们也可以从浏览器中浏览整个hdfs文件系统的目录,打开namenode链接:

http://192.168.0.107:50070/dfshealth.jsp

然后里面会有个Browse the filesystem超级链接,点击进去就可以看到相应的目录结构了。

5.6:运行examples例子

我们使用以下命令来运行wordcount程序:

hadoop jar ../hadoop-examples-1.2.1.jar wordcount input output

注意当前目录是bin目录,而jar包在上一级目录中,则定位jar包需要用到..来表示上级目录,wordcount表示jar包中的类名,表示要执行这个类,input是输入文件夹,output是输出文件夹,必须不存在,它由程序自动创建,如果预先存在output文件夹,则会报错。

我们可以看到程序已经运行成功,接下来就是查看运行结果了。

5.7:查看运行结果

我们可以查看output文件夹的内容来检查程序是否成功创建文件夹,通过查看output文件里面的part-r-00000文件的内容来检查程序执行结果:

我们可以看到hadoop出现一次,hello出现3次,java出现一次,world出现一次,这跟预期是一样的,说明执行成功。

6:关闭hadoop进程

如果我们要关闭hadoop集群,则只需要运行stop-all.sh:

cd /data/software/hadoop/hadoop-1.2.1/bin

./stop-all.sh

可以看到只有一个jps进程在运行,其它hadoop的进程都已经关闭了。

hadoop1.2.1伪分布模式安装教程的更多相关文章

- Hadoop1.2.1完全分布模式安装教程

假设有三台机器,它们的IP地址和对应的主机名为: 192.168.12.18 localhost.localdomain 192.168.2.215 rhel5 ...

- Hadoop-1.0.4伪分布安装与配置

1.采用伪分布模式安装 将hadoop-****.tar.gz复制到linux的/usr/local目录下. 2.解压,重命名 #tar -xzvf hadoop-1.0.4.ta ...

- 伪分布模式安装hadoop

准备工具: 虚拟机:VMware Linux系统:CentOS hadoop-1.1.2.tar.gz jdk-7u75-linux-x64.gz CentOS的网络配置 1.设置主机中VMware ...

- Hadoop 伪分布模式安装

( 温馨提示:图片中有id有姓名,不要盗用哦,可参考流程,有问题评论区留言哦 ) 一.任务目标 1.了解Hadoop的3种运行模式 2.熟练掌握Hadoop伪分布模式安装流程 3.培养独立完成Hado ...

- Hadoop学习笔记(3)hadoop伪分布模式安装

为了学习这部分的功能,我们这里的linux都是使用root用户登录的.所以每个命令的前面都有一个#符号. 伪分布模式安装步骤: 关闭防火墙 修改ip地址 修改hostname 设置ssh自动登录 安装 ...

- Spark新手入门——2.Hadoop集群(伪分布模式)安装

主要包括以下三部分,本文为第二部分: 一. Scala环境准备 查看 二. Hadoop集群(伪分布模式)安装 三. Spark集群(standalone模式)安装 查看 Hadoop集群(伪分布模式 ...

- Hadoop单点伪分布模式安装

Hadoop单点伪分布模式安装 概述 单点 single-node,单节点,即一台计算机. 伪分布式模式 pseudo-distributed mode 所谓集群,表面上看是多台计算机联合完成任务:但 ...

- Hadoop1.2.1伪分布模式安装指南

一.前置条件 1.操作系统准备 (1)Linux可以用作开发平台及产品平台. (2)win32只可用作开发平台,且需要cygwin的支持. 2.安装jdk 1.6或以上 3.安装ssh,并配置免密码登 ...

- Hadoop1.2.1伪分布模式安装指南 分类: A1_HADOOP 2014-08-17 10:52 1346人阅读 评论(0) 收藏

一.前置条件 1.操作系统准备 (1)Linux可以用作开发平台及产品平台. (2)win32只可用作开发平台,且需要cygwin的支持. 2.安装jdk 1.6或以上 3.安装ssh,并配置免密码登 ...

随机推荐

- mysql数据库从删库到跑路之mysql完整性约束

一 介绍 约束条件与数据类型的宽度一样,都是可选参数 作用:用于保证数据的完整性和一致性主要分为: PRIMARY KEY (PK) 标识该字段为该表的主键,可以唯一的标识记录 FOREIGN KEY ...

- ajax参数补充

ajax参数补充 contentType 当我们使用form表单提交数据时,有一个enctype属性,默认情况下不写 此时我们提交数据时,会默认将数据以application/x-www-form-u ...

- 64位win2003/win2008系统IIS6.0/7.5配置PHP的方法

64位win2003/win2008系统IIS6.0/7.5配置PHP的方法 32位的win2003系统配置PHP,估计很多人都已经驾轻就熟了,不过当遇到64位的系统时,估计又会遇上新的问题了.本文记 ...

- 微信小程序组件loading

操作反馈loading:官方文档 Demo Code: Page({ data: { hidden: true }, loadingChange: function () { console.log( ...

- 微信小程序组件radio

表单组件radio:官方文档 Demo Code: Page({ data: { items: [ {name: 'USA', value: '美国'}, {name: 'CHN', value: ' ...

- 虚拟机Linux系统忘记密码的情况下,修改root或其他用户密码

使用场景 linux管理员忘记root密码,需要进行找回操作. 注意事项:本文基于centos7环境进行操作,由于centos的版本是有差异的,继续之前请确定好版本. 步骤 一.重启系统,在开机过程中 ...

- TOSCA自动化测试工具--openURL

在folder下面create test case 输入自己的url,actionMode 是input, String类型

- linux下创建用户,给用户设置密码,给用户授权

1.linux下的用户是属于组的,所以需要创建一个组,划分给用户.创建命令: 在root下执行 groupadd ver 创建一个组ver 2.创建用户 useradd ...

- 《Java入门第三季》第二章 认识 Java 中的字符串

什么是 Java 中的字符串.1.在Java的世界里,字符串被作为String类型的对象处理. 2.通用的初始化的方式:String s = new String("i love you & ...

- Python3.x:访问带参数链接并且获取返回json串

Python3.x:访问带参数链接并且获取返回json串 示例一: import json import xml.dom.minidom from urllib import request, par ...