neutron网络服务

一、neutron 介绍:

1. Neutron 概述

传统的网络管理方式很大程度上依赖于管理员手工配置和维护各种网络硬件设备;而云环境下的网络已经变得非常复杂,特别是在多租户场景里,用户随时都可能需要创建、修改和删除网络,网络的连通性和隔离不已经太可能通过手工配置来保证了。

如何快速响应业务的需求对网络管理提出了更高的要求。传统的网络管理方式已经很难胜任这项工作,而“软件定义网络(software-defined networking, SDN)”所具有的灵活性和自动化优势使其成为云时代网络管理的主流。

Neutron 的设计目标是实现“网络即服务(Networking as a Service)”。为了达到这一目标,在设计上遵循了基于 SDN 实现网络虚拟化的原则,在实现上充分利用了 Linux 系统上的各种网络相关的技术。

SDN 模式服务— NeutronSDN( 软件定义网络 ), 通过使用它,网络管理员和云计算操作员可以通过程序来动态定义虚拟网络设备。Openstack 网络中的 SDN 组件就是 Quantum.但因为版权问题而改名为Neutron 。

2. Neutron网络基本概念

(1)network

network 是一个隔离的二层广播域。Neutron 支持多种类型的 network,包括 local, flat, VLAN, VxLAN 和 GRE。

local:local 网络与其他网络和节点隔离。local 网络中的 instance 只能与位于同一节点上同一网络的 instance 通信,local 网络主要用于单机测试,同宿主机可以通信。

flat:flat 网络是无 vlan tagging 的网络。flat 网络中的instance 能与位于同一网络的 instance 通信,并且可以跨多个节点(宿主机)。

vlan:vlan 网络是具有 802.1q tagging 的网络。vlan 是一个二层的广播域,同一 vlan 中的 instance 可以通信,不同 vlan 只能通过 router 通信。vlan 网络可跨节点,是应用最广泛的网络类型。

vxlan:vxlan 是基于隧道技术的 overlay 网络。vxlan 网络通过唯一的 segmentation ID(也叫 VNI)与其他 vxlan 网络区分。vxlan 中数据包会通过 VNI 封装成 UDP 包进行传输。因为二层的包通过封装在三层传输,能够克服 vlan 和物理网络基础设施的限制。

gre:gre 是与 vxlan 类似的一种 overlay 网络。主要 区别在于使用 IP 包而非 UDP 进行封装。

不同 network 之间在二层上是隔离的。

以 vlan 网络为例,network A 和 network B 会分配不同的 VLAN ID,这样就保证了 network A 中的广播包不会跑到 network B 中。当然,这里的隔离是指二层上的隔离,借助路由器不同 network 是可能在三层上通信的。

network 必须属于某个 Project( Tenant 租户),Project 中可以创建多个 network。 network 与 Project 之间是 1对多 关系。

(2)subnet

subnet 是一个 IPv4 或者 IPv6 地址段。instance 的 IP 从 subnet 中分配。每个 subnet 需要定义 IP 地址的范围和掩码。

network 与 subnet 是 1对多 关系。一个 subnet 只能属于某个 network;一个 network 可以有多个 subnet,这些 subnet 可以是不同的 IP 段,但不能重叠。

具体原因: 因为 Neutron 的 router 是通过 Linux network namespace 实现的。network namespace 是一种网络的隔离机制。通过它,每个 router 有自己独立的路由表。上面的配置有两种结果:

1. 如果两个 subnet 是通过同一个 router 路由,根据 router 的配置,只有指定的一个 subnet 可被路由。

2. 如果上面的两个 subnet 是通过不同 router 路由,因为 router 的路由表是独立的,所以两个 subnet 都可以被路由。

(3)port

port 可以看做虚拟交换机上的一个端口。port 上定义了 MAC 地址和 IP 地址,当 instance 的虚拟网卡 VIF(Virtual Interface) 绑定到 port 时,port 会将 MAC 和 IP 分配给 VIF。

subnet 与 port 是 1对多 关系。一个 port 必须属于某个 subnet;一个 subnet 可以有多个 port 。

小结:

下面总结了 Project,Network,Subnet,Port 和 VIF 之间关系。

Project 1 : m Network 1 : m Subnet 1 : m Port 1 : 1 VIF m : 1 Instance

3. Neutron 功能

Neutron 为整个 OpenStack 环境提供网络支持,包括二层交换,三层路由,负载均衡,防火墙和 VPN 等。Neutron 提供了一个灵活的框架,通过配置,无论是开源还是商业软件都可以被用来实现这些功能。

二层交换switching:

Nova 的 Instance 是通过虚拟交换机连接到虚拟二层网络的。Neutron 支持多种虚拟交换机,包括 Linux 原生的 Linux Bridge 和 Open vSwitch。 Open vSwitch(OVS)是一个开源的虚拟交换机,它支持标准的管理接口和协议。

利用 Linux Bridge 和 OVS,Neutron 除了可以创建传统的 VLAN 网络,还可以创建基于隧道技术的 Overlay 网络,比如 VxLAN 和 GRE(Linux Bridge 目前只支持 VxLAN)。在后面章节我们会学习如何使用和配置 Linux Bridge 和 Open vSwitch。

三层路由routing:

Instance 可以配置不同网段的 IP,Neutron 的 router(虚拟路由器)实现 instance 跨网段通信。router 通过 IP forwarding,iptables 等技术来实现路由和 NAT。我们将在后面章节讨论如何在 Neutron 中配置 router 来实现 instance 之间,以及与外部网络的通信。

负载均衡Load-Balancing:

Openstack 在 Grizzly 版本第一次引入了 Load-Balancing-as-a-Service(LBaaS),提供了将负载分发到多个 instance 的能力。LBaaS 支持多种负载均衡产品和方案,不同的实现以 Plugin 的形式集成到 Neutron,目前默认的 Plugin 是 HAProxy。我们会在后面章节学习 LBaaS 的使用和配置。

防火墙Firewalling:

Neutron 通过下面两种方式来保障 instance 和网络的安全性。

(1) Security Group

通过 iptables 限制进出 instance 的网络包。

(2) Firewall-as-a-Service

FWaaS,限制进出虚拟路由器的网络包,也是通过 iptables 实现。

Neutron 优点:

Openstack 中的 SDN 组件架构也属于可插拔类型。通过各种插件可以管控不同种类的交换机、路由器、防火墙、负载均衡器并实现 firewall as a service 等许多功能。通过软件来定义的网络,可以对整个云计算设施进行更为精细的掌控。

4. Neutron 部署方案

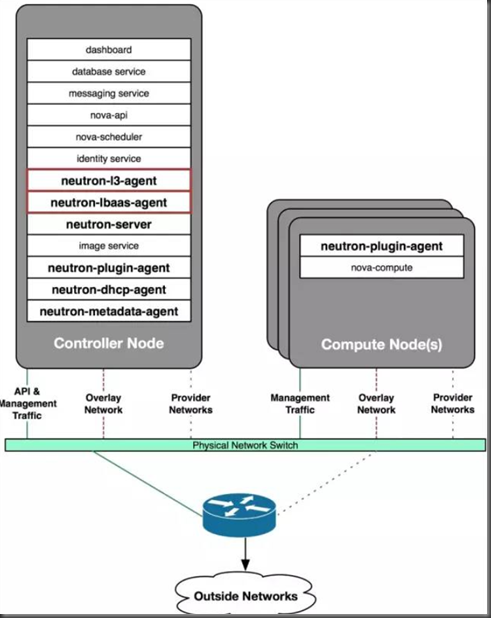

方案1:控制节点 + 计算节点:All in one架构

控制节点:部署的服务包括:neutron server, core plugin 的 agent 和 service plugin 的 agent。

计算节点:部署 core plugin 的agent,负责提供二层网络功能。

这里有几点需要说明:

1. core plugin 和 service plugin 已经集成到 neutron server,不需要运行独立的 plugin 服务。

2. 控制节点和计算节点都需要部署 core plugin 的 agent,因为通过该 agent 控制节点与计算节点才能建立二层连接。

3. 可以部署多个控制节点和计算节点。

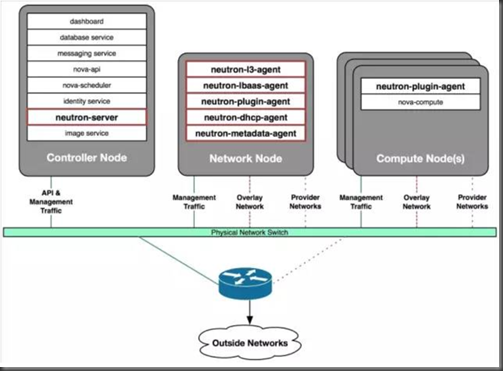

方案2:控制节点 + 网络节点 + 计算节点

在这个部署方案中,OpenStack 由控制节点,网络节点和计算节点组成。

控制节点:部署 neutron server 服务。

网络节点:部署的服务包括:core plugin 的 agent 和 service plugin 的 agent。

计算节点:部署 core plugin 的agent,负责提供二层网络功能。

这个方案的要点是将所有的 agent 从控制节点分离出来,部署到独立的网络节点上。

控制节点只负责通过 neutron server 响应 API 请求。

由独立的网络节点实现数据的交换,路由以及 load balance等高级网络服务。

可以通过增加网络节点承担更大的负载。

可以部署多个控制节点、网络节点和计算节点。

该方案特别适合规模较大的 OpenStack 环境。

5. 配置多个网卡区分不同类型的网络数据

OpenStack 至少包含下面几类网络流量:

Management 网络(管理)

用于节点之间 message queue 内部通信以及访问 database 服务,所有的节点都需要连接到 management 网络。

API 网络

OpenStack 各组件通过该网络向用户暴露 API 服务。Keystone, Nova, Neutron, Glance, Cinder, Horizon 的 endpoints 均配置在 API 网络上。通常,管理员也通过 API 网络 SSH 管理各个节点。

VM 网络

VM 网络也叫 tenant 网络,用于 instance 之间通信。

VM 网络可以选择的类型包括 local, flat, vlan, vxlan 和 gre。

VM 网络由 Neutron 配置和管理。

External 网络

External 网络指的是 VM 网络之外的网络,该网络不由 Neutron 管理。 Neutron 可以将 router attach 到 External 网络,为 instance 提供访问外部网络的能力。 External 网络可能是企业的 intranet,也可能是 internet。

这几类网络只是逻辑上的划分,物理实现上有非常大的自由度。

我们可以为每种网络分配单独的网卡;也可以多种网络共同使用一个网卡;为提高带宽和硬件冗余,可以使用 bonding 技术将多个物理网卡绑定成一个逻辑的网卡

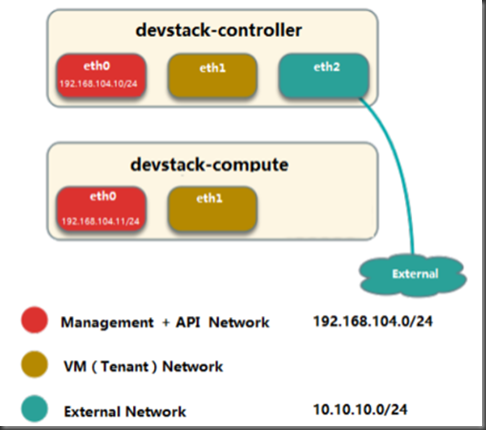

我们的实验环境采用下面的网卡分配方式:

1. 控制节点 3 网卡(eth0, eth1, eth2),计算节点 2 网卡(eth0, eth1)。

2. 合并 Management 和 API 网络,使用 eth0

3. VM 网络使用 eht1。

4. 控制节点的 eth2 与 External 网络连接

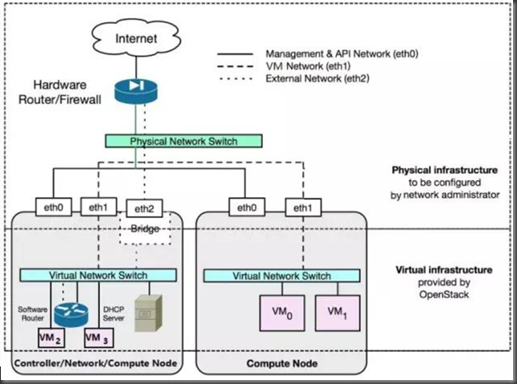

物理拓扑:

分割线上方的网络由网络管理员(就是我们啦)配置。 主要涉及 Management, API 和 external 网络。 配置的内容包括节点上的物理网卡,物理交换机和外部路由器,防火墙以及物理连线等

分割线下方是 VM 网络,由 Neutron 管理。 我们只需要通过 Web GUI 或者 CLI 操作,Neutron 会负责实现。

二、neutron架构

1. Nuetron 架构

与 OpenStack 的其他服务的设计思路一样,Neutron 也是采用分布式架构,由多个组件(子服务)共同对外提供网络服务。

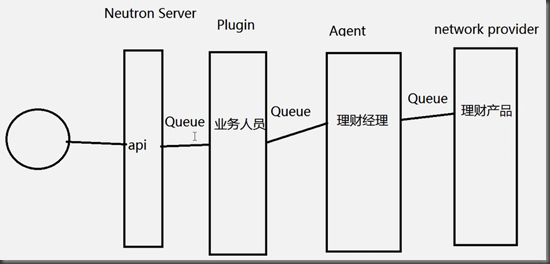

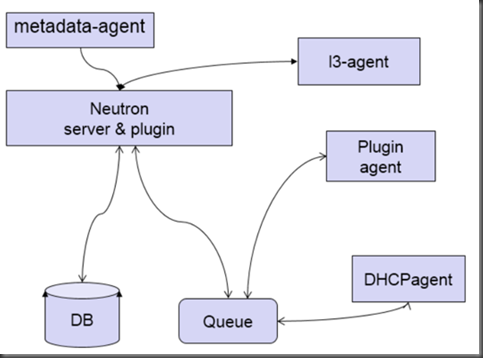

Neutron 由如下组件构成:

Neutron Server:对外提供 OpenStack 网络 API,接收请求,并调用 Plugin 处理请求。

Plugin:处理 Neutron Server 发来的请求,维护 OpenStack 逻辑网络状态, 并调用 Agent 处理请求。

Agent:处理 Plugin 的请求,负责在 network provider 上真正实现各种网络功能。

network provider:提供网络服务的虚拟或物理网络设备,例如 Linux Bridge,Open vSwitch 或者其他支持 Neutron 的物理交换机。

Queue:Neutron Server,Plugin 和 Agent 之间通过 Messaging Queue 通信和调用。

Database:存放 OpenStack 的网络状态信息,包括 Network, Subnet, Port, Router 等。

Neutron 架构非常灵活,层次较多,目的是:

为了支持各种现有或者将来会出现的优秀网络技术;支持分布式部署,获得足够的扩展性。

三、neutron server组件详解

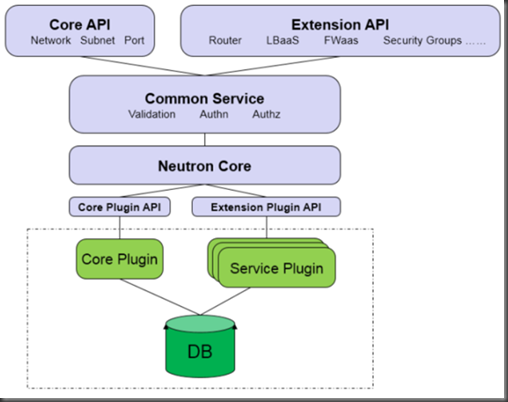

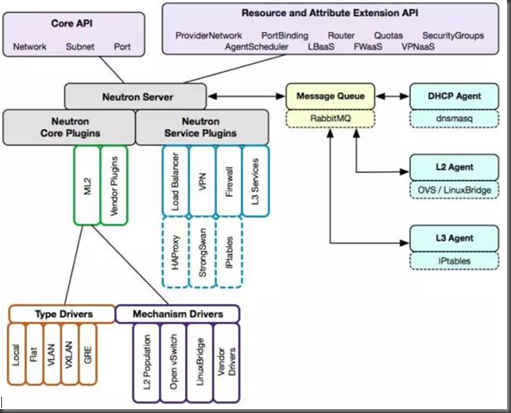

1. Neutron server 分层模型

上图是 Neutron Server 的分层结构,至上而下依次为:

Core API:对外提供管理 network, subnet 和 port 的 RESTful API。

Extension API:对外提供管理 router, load balance, firewall 等资源 的 RESTful API。

Commnon Service:认证和校验 API 请求。

Neutron Core:Neutron server 的核心处理程序,通过调用相应的 Plugin 处理请求。

Core Plugin API:定义了 Core Plgin 的抽象功能集合,Neutron Core 通过该 API 调用相应的 Core Plgin。

Extension Plugin API:定义了 Service Plgin 的抽象功能集合,Neutron Core 通过该 API 调用相应的 Service Plgin。

Core Plugin:实现了 Core Plugin API,在数据库中维护 network, subnet 和 port 的状态,并负责调用相应的 agent 在 network provider 上执行相关操作,比如创建 network。

Service Plugin:实现了 Extension Plugin API,在数据库中维护 router, load balance, security group 等资源的状态,并负责调用相应的 agent 在 network provider 上执行相关操作,比如创建 router。

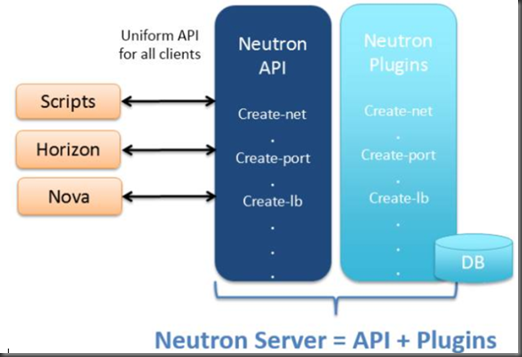

归纳起来,Neutron Server 包括两部分:

1. 提供 API 服务。

2. 运行 Plugin。

即 Neutron Server = API + Plugins

四、ML2 Core Plugin 详解:

1. Neutron 是如何支持多种 network provider

上节提到 Core Plugin,其功能是维护数据库中 network, subnet 和 port 的状态,并负责调用相应的 agent 在 network provider 上执行相关操作,比如创建 network。

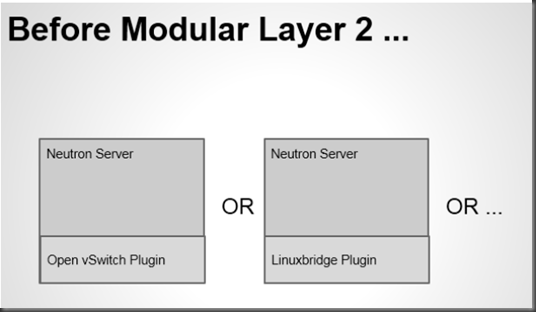

openstack中有两大常见 Core Plugin: linux bridge plugin 和 open vswitch plugin。

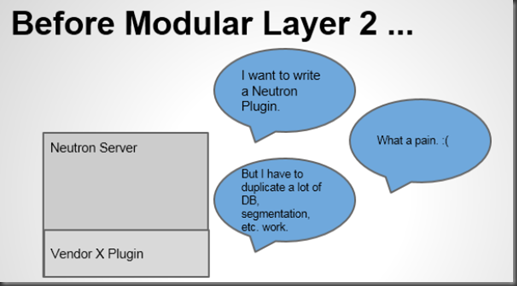

Neutron 可以通过开发不同的 plugin 和 agent 支持不同的网络技术。这是一种相当开放的架构。不过随着支持的 network provider 数量的增加,开发人员发现了两个突出的问题:

1. 只能在 OpenStack 中使用一种 core plugin,多种 network provider 无法共存。 只使用一个 core plugin 本身没有问题。但问题在于传统的 core plugin 与 core plugin agent 是一一对应的。也就是说,如果选择了 linux bridge plugin,那么 linux bridge agent 将是唯一选择,就必须在 OpenStack 的所有节点上使用 linux bridge 作为虚拟交换机(即 network provider)。

同样的,如果选择 open vswitch plugin, 所有节点上只能使用 open vswitch,而不能使用其他的 network provider。

2. 不同 plugin 之间存在大量重复代码,开发新的 plugin 工作量大。

所有传统的 core plugin 都需要编写大量重复和类似的数据库访问的代码,大大增加了 plugin 开发和维护的工作量。

3. ML2 能解决传统 core plugin 的问题

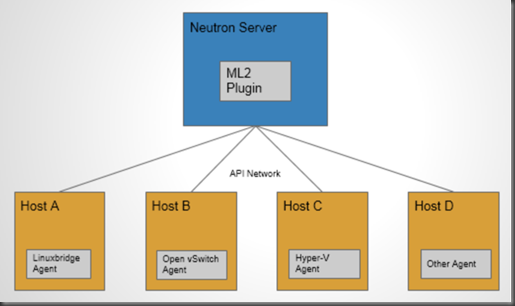

Moduler Layer 2(ML2):是 Neutron 在 Havana 版本实现的一个新的 core plugin,用于替代原有的 linux bridge plugin 和 open vswitch plugin。 作为新一代的 core plugin,提供了一个框架,允许在 OpenStack 网络中同时使用多种 Layer 2 网络技术,不同的节点可以使用不同的网络实现机制。

如上图所示,采用 ML2 plugin 后,可以在不同节点上分别部署 linux bridge agent, open vswitch agent, hyper-v agent 或其他第三方 agent。

ML2 不但支持异构部署方案,同时能够与现有的 agent 无缝集成:以前用的 agent 不需要变,只需要将 Neutron server 上的传统 core plugin 替换为 ML2。

有了 ML2,要支持新的 network provider 就变得简单多了:无需从头开发 core plugin,只需要开发相应的 mechanism driver,大大减少了要编写和维护的代码。

ML2 Core Plugin 详解:

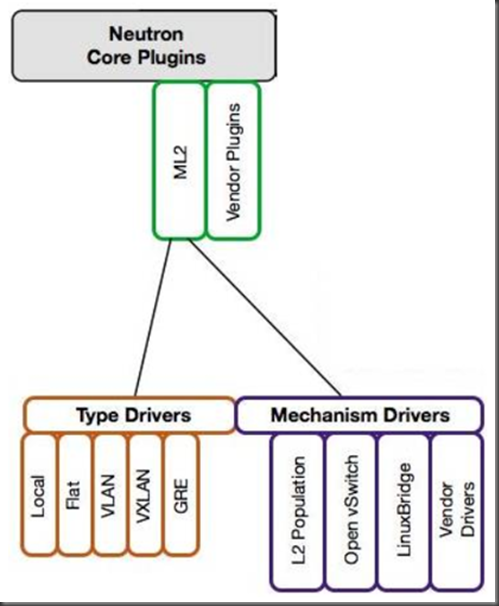

ML2 对二层网络进行抽象和建模,引入了 type driver 和 mechansim driver。这两类 driver 解耦了 Neutron 所支持的网络类型(type)与访问这些网络类型的机制(mechanism),其结果就是使得 ML2 具有非常好的弹性,易于扩展,能够灵活支持多种 type 和 mechanism。

(1) Type Driver

Neutron 支持的每一种网络类型都有一个对应的 ML2 type driver。

type driver 负责维护网络类型的状态,执行验证,创建网络等。 ML2 支持的网络类型包括 local, flat, vlan, vxlan 和 gre。 我们将在后面章节详细讨论每种 type。

(2) Mechansim Driver

Neutron 支持的每一种网络机制都有一个对应的 ML2 mechansim driver。

mechanism driver 负责获取由 type driver 维护的网络状态,并确保在相应的网络设备(物理或虚拟)上正确实现这些状态。

type 和 mechanisim 都太抽象,现在我们举一个具体的例子: type driver 为 vlan,mechansim driver 为 linux bridge,我们要完成的操作是创建 network vlan100,那么:

vlan type driver 会确保将 vlan100 的信息保存到 Neutron 数据库中,包括 network 的名称,vlan ID 等。

linux bridge mechanism driver 会确保各节点上的 linux brige agent 在物理网卡上创建 ID 为 100 的 vlan 设备 和 brige 设备,并将两者进行桥接。

mechanism driver 有三种类型:

Agent-based

包括 linux bridge, open vswitch 等。

Controller-based

包括 OpenDaylight, VMWare NSX 等。

基于物理交换机

包括 Cisco Nexus, Arista, Mellanox 等。 比如前面那个例子如果换成 Cisco 的 mechanism driver,则会在 Cisco 物理交换机的指定 trunk 端口上添加 vlan100。

本教程讨论的 mechanism driver 将涉及 linux bridge, open vswitch 和 L2 population。

linux bridge 和 open vswitch 的 ML2 mechanism driver 作用是配置各节点上的虚拟交换机。linux bridge driver 支持的 type 包括 local, flat, vlan, and vxlan。open vswitch driver 除这 4 种 type 还支持 gre。

L2 population driver 作用是优化和限制 overlay 网络中的广播流量。 vxlan 和 gre 都属于 overlay 网络。

ML2 core plugin 已经成为 OpenStack Neutron 的首选 plugin,本教程后面会讨论如何在实验环境中配置 ML2 的各种 type 和 mechansim。

五、Service Plugin / Agent 详解:

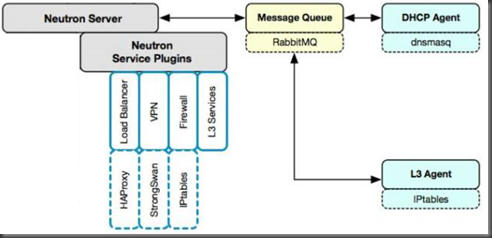

Core Plugin/Agent 负责管理核心实体:net, subnet 和 port。而对于更高级的网络服务,则由 Service Plugin/Agent 管理。

Service Plugin 及其 Agent 提供更丰富的扩展功能,包括路由,load balance,firewall等,如图所示:

DHCP

dhcp agent 通过 dnsmasq 为 instance 提供 dhcp 服务。

Routing

l3 agent 可以为 project(租户)创建 router,提供 Neutron subnet 之间的路由服务。路由功能默认通过 IPtables 实现。

Firewall

l3 agent 可以在 router 上配置防火墙策略,提供网络安全防护。另一个与安全相关的功能是 Security Group,也是通过 IPtables 实现。 Firewall 与 Security Group 的区别在于:

Firewall 安全策略位于 router,保护的是某个 project 的所有 network。

Security Group 安全策略位于 instance,保护的是单个 instance。

Firewall 与 Security Group 后面会详细分析。

Load Balance

Neutron 默认通过 HAProxy 为 project 中的多个 instance 提供 load balance 服务。

六、 Neutron 架构框架总结:

与 OpenStack 其他服务一样,Neutron 采用的是分布式架构,包括 Neutorn Server、各种 plugin/agent、database 和 message queue。

1. Neutron server 接收 api 请求。

2. plugin/agent 实现请求。

3. database 保存 neutron 网络状态。

4. message queue 实现组件之间通信。

metadata-agent 之前没有讲到,这里做个补充:

instance 在启动时需要访问 nova-metadata-api 服务获取 metadata 和 userdata,这些 data 是该 instance 的定制化信息,比如 hostname, ip, public key 等。

但 instance 启动时并没有 ip,那如何通过网络访问到 nova-metadata-api 服务呢?

答案就是 neutron-metadata-agent 该 agent 让 instance 能够通过 dhcp-agent 或者 l3-agent 与 nova-metadata-api 通信

将 Neutron 架构展开,则会得到下面第二张图:

1.Neutron 通过 plugin 和 agent 提供的网络服务。

2.plugin 位于 Neutron server,包括 core plugin 和 service plugin。

3.agent 位于各个节点,负责实现网络服务。

4.core plugin 提供 L2 功能,ML2 是推荐的 plugin。

5.使用最广泛的 L2 agent 是 linux bridage 和 open vswitch。

6.service plugin 和 agent 提供扩展功能,包括 dhcp, routing, load balance, firewall, vpn 等。

neutron网络服务的更多相关文章

- openstack第四章:neutron— 网络服务

第四篇neutron— 网络服务 一.neutron 介绍: Neutron 概述 传统的网络管理方式很大程度上依赖于管理员手工配置和维护各种网络硬件设备:而云环境下的网络已经变得非常复杂,特别是 ...

- CentOS7安装OpenStack(Rocky版)-06.安装Neutron网络服务(控制节点)

上一章介绍了独立的nova计算节点的安装方法,本章分享openstack的网络服务neutron的安装配制方法 ------------------- 完美的分割线 ----------------- ...

- openstack (5)-- 部署 Neutron 网络服务

Neutron 概念: 传统的网络管理方式很大程度上依赖于管理员手工配置和维护各种网络硬件设备:而云环境下的网络已经变得非常复杂,特别是在多租户场景里,用户随时都可能需要创建.修改和删除网络,网络的连 ...

- OpenStack核心组件-neutron网络服务

1. neutron 介绍 1.1 Neutron 概述 传统的网络管理方式很大程度上依赖于管理员手工配置和维护各种网络硬件设备:而云环境下的网络已经变得非常复杂,特别是在多租户场景里,用户随时都可能 ...

- neutron网络服务部署

控制节点执行 #第一步 登陆数据库 mysql -u root -p #导入neutron这个库 CREATE DATABASE neutron; #创建neutron这个用户和密码,并允许本地登陆和 ...

- openstack核心组件——neutron网络服务 抓取ip(9)

云计算openstack核心组件——neutron网络服务(9) 一.虚拟机获取 ip: 用 namspace 隔离 DHCP 服务 Neutron 通过 dnsmasq 提供 DHCP 服务 ...

- openstack核心组件——neutron网络服务(8)

云计算openstack核心组件——neutron网络服务(8) 一.neutron 介绍: Neutron 概述 传统的网络管理方式很大程度上依赖于管理员手工配置和维护各种网络硬件设备:而云 ...

- OpenStack Train版-10.安装neutron网络服务(网络节点:可选)

可选:安装neutron网络服务节点(neutron01网络节点192.168.0.30)网络配置按照官网文档的租户自助网络 配置系统参数 echo 'net.ipv4.ip_forward = 1' ...

- OpenStack Train版-9.安装neutron网络服务(计算节点)

在计算节点安装neutron网络服务(computel01计算节点192.168.0.20)安装组件 yum install openstack-neutron-linuxbridge ebtable ...

- OpenStack Train版-8.安装neutron网络服务(控制节点)

安装neutron网络服务(controller控制节点192.168.0.10) 创建neutron数据库 mysql -uroot CREATE DATABASE neutron; GRANT A ...

随机推荐

- npm安装node-sass报msbuild相关错误的解决办法

转自:https://blog.csdn.net/Amio_/article/details/87931733 https://www.cnblogs.com/diffx/p/10510868.htm ...

- 在JavaScript中,++在前和++在后有什么区别

一.++可以与输出语句写在一起,++写在变量前和写在变量后不是一个意思++ i 和 i ++ 区别在于运算顺序和结合方向. 在JavaScript中有两种自加运算,其运算符均为 ++,功能为将运算符自 ...

- 高大上的微信小程序中渲染html内容—技术分享

大部分Web应用的富文本内容都是以HTML字符串的形式存储的,通过HTML文档去展示HTML内容自然没有问题.但是,在微信小程序(下文简称为「小程序」)中,应当如何渲染这部分内容呢? 解决方案 wxP ...

- 使用ajax向服务端发送Form中的数据

前端代码: <form action="" id="myFormUpdate"> <p>宠物名称: <input type=&qu ...

- Apache工作流程

一个经典的Apache处理php页面的流程 需要连接mysql数据库并处理的流程 网站是一系列网页的组合 从用户角度看就是访问诸如 hhtp://www.baidu.com -----url 这是互联 ...

- C# JSON的序列化与反序列化

需要添加引用:System.ServiceModel.Web 和 System.Runtime.Serialization,然后使用Using: using System.Runtime.Serial ...

- 初学者的springmvc笔记02

springmvc笔记 springmvc拦截器,spring类型转换,spring实现文件上传/下载 1.SpringMVC标准配置 导入jar包:core contaner 在web.xml文件中 ...

- js-点击+加关注变成已关注,已关注状态时,鼠标滑动上的状态时取消关注

效果: HTML: <div class="rightBtn cur">+关注</div> CSS: .rightBtn{ width: 80px; hei ...

- C# socket异步 服务端

转自: http://blog.csdn.net/qq_20282263/article/details/54310737 private Dictionary<string, Session ...

- POJ 3692 幼儿园做游戏 最大团 模板题

Kindergarten Time Limit: 2000MS Memory Limit: 65536K Total Submissions: 6191 Accepted: 3052 Desc ...