机器学习笔记7:矩阵分解Recommender.Matrix.Factorization

参考地址:

贪心学院:https://github.com/GreedyAIAcademy/Machine-Learning

1矩阵分解概述

1.1用在什么地方

推荐系统:最著名的就那个烂大街的啤酒和尿布的故事,还有现在头条的投喂用户使用的也是推荐系统。就不多说了。

1.2推荐的原理

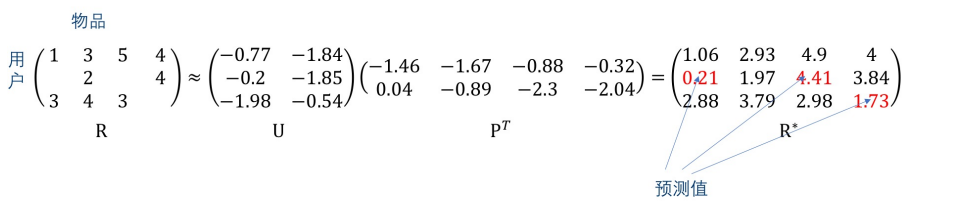

设,矩阵R代表3个用户对4部影片的评分,矩阵U和P是通过算法分解出来的矩阵,R是预测出来的矩阵。

此时我们可以看出, 矩阵R中的值很接近原始矩阵R中的值,这样填补之后的值就是我们要的数字。

2矩阵分解的原理

2.1目标函数

如1.2所示,我们希望的结果就是R*中的结果与R中的结果差值最小。

因此我们可以得到目标函数:

\\

Z = \{(i,j):r_{ij} 已知\}

\]

\(U_i P_j\)为行向量,分别来自于矩阵U和矩阵P的第i行和第j行;分别代表了第i个用户的画像向量,和第j个物品的画像向量。

2.2 损失函数

为了方便求导,我们乘个1/2,结果如下:

\\

Z = \{(i,j):r_{ij} 已知\}

\]

继续计算结果如下:

\]

得到损失梯度如下:

\\

\frac{\partial L_{ij}}{\partial P_{j}}= \frac{\partial }{\partial P_{j}} [\frac{1}{2}(R_{ij}-U_{i}\cdot P_{j})^2] = -U_i(R_{ij}-U_{i}\cdot P_{j})

\]

为了防止过拟合和训练过程中的误差,加入正则项

\]

再求偏导可得:

\\

\frac{\partial L_{ij}}{\partial P_{j}}=-U_{i}(R_{ij}-U_{i}\cdot P_{j}) + \lambda P_{j} \\

\]

2.3 通过梯度下降的方法求得结果

设定k的值,设定学习步长\(\gamma\)(learning rate),初始化U和P,重复以下步骤直到均方差满意为止:

遍历Z中的(i,j),Z={(i,j):\(r_{ij}\)已知}

P_{j}\leftarrow P_{j} - \gamma \frac{\partial L_{ij}}{\partial P_{j}} \\

\]

3 代码实现

看了上面的公式肯定是一知半解的,但看了矩阵分解函数,就会对梯度下降问题的解决方法豁然开朗

代码:

# 导入 nunpy 和 surprise 辅助库

import numpy as np

import surprise

# 计算模型

class MatrixFactorization(surprise.AlgoBase):

'''基于矩阵分解的推荐.'''

def __init__(self, learning_rate, n_epochs, n_factors, lmd):

self.lr = learning_rate # 梯度下降法的学习率

self.n_epochs = n_epochs # 梯度下降法的迭代次数

self.n_factors = n_factors # 分解的矩阵的秩(rank)

self.lmd = lmd # 防止过拟合的正则化的强度

def fit(self, trainset):

'''通过梯度下降法训练, 得到所有 u_i 和 p_j 的值'''

print('Fitting data with SGD...')

# 随机初始化 user 和 item 矩阵.

u = np.random.normal(0, .1, (trainset.n_users, self.n_factors))

p = np.random.normal(0, .1, (trainset.n_items, self.n_factors))

# 梯度下降法

for _ in range(self.n_epochs):

for i, j, r_ij in trainset.all_ratings():

err = r_ij - np.dot(u[i], p[j])

# 利用梯度调整 u_i 和 p_j

u[i] -= -self.lr * err * p[j] + self.lr * self.lmd * u[i]

p[j] -= -self.lr * err * u[i] + self.lr * self.lmd * p[j]

# 注意: 修正 p_j 时, 按照严格定义, 我们应该使用 u_i 修正之前的值, 但是实际上差别微乎其微

self.u, self.p = u, p

self.trainset = trainset

def estimate(self, i, j):

'''预测 user i 对 item j 的评分.'''

# 如果用户 i 和物品 j 是已知的值, 返回 u_i 和 p_j 的点积

# 否则使用全局平均评分rating值(cold start 冷启动问题)

if self.trainset.knows_user(i) and self.trainset.knows_item(j):

return np.dot(self.u[i], self.p[j])

else:

return self.trainset.global_mean

# 应用

from surprise import BaselineOnly

from surprise import Dataset

from surprise import Reader

from surprise import accuracy

from surprise.model_selection import cross_validate

from surprise.model_selection import train_test_split

import os

# 数据文件

file_path = os.path.expanduser('./ml-100k/u.data')

# 数据文件的格式如下:

# 'user item rating timestamp', 使用制表符 '\t' 分割, rating值在1-5之间.

reader = Reader(line_format='user item rating timestamp', sep='\t', rating_scale=(1, 5))

data = Dataset.load_from_file(file_path, reader=reader)

# 将数据随机分为训练和测试数据集

trainset, testset = train_test_split(data, test_size=.25)

# 初始化以上定义的矩阵分解类.

algo = MatrixFactorization(learning_rate=.005, n_epochs=60, n_factors=2, lmd = 0.2)

# 训练

algo.fit(trainset)

# 预测

predictions = algo.test(testset)

# 计算平均绝对误差

accuracy.mae(predictions)

#结果:0.7871327139440717

# 使用 surpise 内建的基于最近邻的方法做比较

algo = surprise.KNNBasic()

algo.fit(trainset)

predictions = algo.test(testset)

accuracy.mae(predictions)

#结果:0.7827160139309475

# 使用 surpise 内建的基于 SVD 的方法做比较

algo = surprise.SVD()

algo.fit(trainset)

predictions = algo.test(testset)

accuracy.mae(predictions)

#结果:0.7450633876817936

机器学习笔记7:矩阵分解Recommender.Matrix.Factorization的更多相关文章

- 矩阵分解(matrix factorization)

1. 基本概念 针对高维空间中的数据集,矩阵分解通过寻找到一组基及每一个数据点在该基向量下的表示,可对原始高维空间中的数据集进行压缩表示. 令 X=[x1,⋯,xm]∈Rm×n 为数据矩阵,矩阵分解的 ...

- Matrix Factorization SVD 矩阵分解

Today we have learned the Matrix Factorization, and I want to record my study notes. Some kownledge ...

- 简单的基于矩阵分解的推荐算法-PMF, NMF

介绍: 推荐系统中最为主流与经典的技术之一是协同过滤技术(Collaborative Filtering),它是基于这样的假设:用户如果在过去对某些项目产生过兴趣,那么将来他很可能依然对其保持热忱.其 ...

- Non-negative Matrix Factorization 非负矩阵分解

著名的科学杂志<Nature>于1999年刊登了两位科学家D.D.Lee和H.S.Seung对数学中非负矩阵研究的突出成果.该文提出了一种新的矩阵分解思想――非负矩阵分解(Non-nega ...

- 关于NMF(Non-negative Matrix Factorization )

著名的科学杂志<Nature>于1999年刊登了两位科学家D.D.Lee和H.S.Seung对数学中非负矩阵研究的突出成果.该文提出了一种新的矩阵分解思想――非负矩阵分解(Non-nega ...

- 吴恩达机器学习笔记59-向量化:低秩矩阵分解与均值归一化(Vectorization: Low Rank Matrix Factorization & Mean Normalization)

一.向量化:低秩矩阵分解 之前我们介绍了协同过滤算法,本节介绍该算法的向量化实现,以及说说有关该算法可以做的其他事情. 举例:1.当给出一件产品时,你能否找到与之相关的其它产品.2.一位用户最近看上一 ...

- 【RS】Matrix Factorization Techniques for Recommender Systems - 推荐系统的矩阵分解技术

[论文标题]Matrix Factorization Techniques for Recommender Systems(2009,Published by the IEEE Computer So ...

- 推荐系统(recommender systems):预测电影评分--构造推荐系统的一种方法:低秩矩阵分解(low rank matrix factorization)

如上图中的predicted ratings矩阵可以分解成X与ΘT的乘积,这个叫做低秩矩阵分解. 我们先学习出product的特征参数向量,在实际应用中这些学习出来的参数向量可能比较难以理解,也很难可 ...

- 论文笔记: Matrix Factorization Techniques For Recommender Systems

Recommender system strategies 通过例子简单介绍了一下 collaborative filtering 以及latent model,这两个方法在之前的博客里面介绍过,不累 ...

随机推荐

- gcd与exgcd

gcd 辗转相除法求gcd证明 \(gcd(a, b) == gcd(b, a\%b)\) 证明: 设: \(d\)为\(a\)与\(b\)的一个公约数, 则有\(d|b\) \(d|a\) 设: \ ...

- nlp语义理解的一点儿看法

nlp领域里,语义理解仍然是难题! 给你一篇文章或者一个句子,人们在理解这些句子时,头脑中会进行上下文的搜索和知识联想.通常情况下,人在理解语义时头脑中会搜寻与之相关的知识.知识图谱的创始人人为,构成 ...

- 第08组 Beta冲刺(1/5)

队名:955 组长博客:点这里! 作业博客:点这里! 组员情况 组员1(组长):庄锡荣 过去两天完成了哪些任务 文字/口头描述 检测网站不合理的地方,给组员定下相应时间进度的安排 展示GitHub当 ...

- cmder是一个增强型命令行工具,不仅可以使用windows下的所有命令,更爽的是可以使用linux的命令,shell命令。

cmder使用简介 Cmder is a software package created out of pure frustration over the absence of nice conso ...

- 基于springboot的flowable工作流实例实现

基于springboot的flowable工作流实例实现 flowableUI 创建实例教程 https://www.cnblogs.com/nanstar/p/11959389.html Flowa ...

- 9. Scala隐式转换和隐式值

9.1 隐式转换 9.1.1 提出问题 先看一个案例演示,引出隐式转换的实际需要=>指定某些数据类型的相互转化 object boke_demo01 { def main(args: Array ...

- 软件——解决Modelsim10.1d窗口不停弹出问题(一直弹窗)

博主在编写Verilog HDL时需要用到Modelsim,于是博主便安装了Modelsim10.1d,然后兴高采烈打开准备跑仿真时,打开软件发现Modelsim10.1d的各种窗口在不停弹出,终止进 ...

- MQTT --- 操作行为

会话状态 为实现QoS等级1和QoS等级2协议流,客户端和服务端需要将状态与客户标识符相关联,这被称为会 话状态.服务端还将订阅信息存储为会话状态的一部分.会话可以跨越一系列的网络连接.它持续到最新的 ...

- SQL Server的唯一键和唯一索引会将空值(NULL)也算作重复值

我们先在SQL Server数据库中,建立一张Students表: CREATE TABLE [dbo].[Students]( ,) NOT NULL, ) NULL, ) NULL, [Age] ...

- html 显示 pdf

html 显示 pdf文件四种方式: 1. <embed src="pdf/wobu.pdf" type="application/pdf" width= ...