tensorflow建造神经网络-【老鱼学tensorflow】

上次我们添加了一个add_layer函数,这次就要创建一个神经网络来预测/拟合相应的数据。

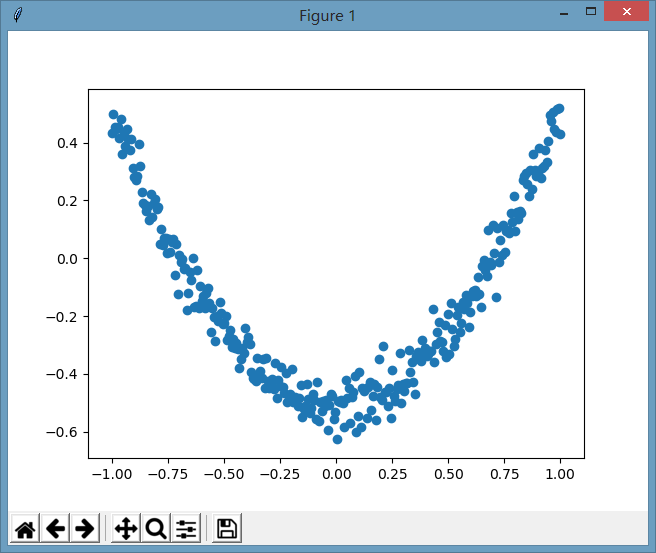

下面我们先来创建一下虚拟的数据,这个数据为二次曲线数据,但同时增加了一些噪点,其图像为:

相应的创建这些伪造数据的代码为:

import numpy as np

# 创建一列(相当于只有一个属性值),300行的x值,这里np.newaxis用于新建出列数据,使其shape为(300, 1)

x_data = np.linspace(-1, 1, 300)[:,np.newaxis]

# 增加噪点,噪点的均值为0,标准差为0.05,形状跟x_data一样

noise = np.random.normal(0, 0.05, x_data.shape)

# 定义y的函数为二次曲线的函数,但同时增加了一些噪点数据

y_data = np.square(x_data) - 0.5 + noise

有了虚拟的数据之后,我们假装不知道这个数据的规律,因此我们想要通过一个神经网络来根据这些数据来发现这些数据所蕴含的规律。

这个神经网络定义了一个隐藏层和一个输出层:

# 定义输入值,这里定义输入值的目的是为了能够使程序比较灵活,可以在神经网络启动时接收不同的实际输入值,这里输入的结构为输入的行数不国定,但列就是1列的值

xs = tf.placeholder(tf.float32, [None, 1])

ys = tf.placeholder(tf.float32, [None, 1])

# 定义一个隐藏层,输入为xs,输入size为1列,因为x_data就只有1个属性值,输出size我们假定输出的神经元有10个神经元的隐藏层,激励函数用relu

l1 = add_layer(xs, 1, 10, tf.nn.relu)

# 定义输出层,输入为l1,输入size为10列,也就是l1的列数,输出size为1,因为这里直接输出为类似y_data了,因此为1列,假定没有激励函数,也就是输出是啥就直接传递出去了。

predition = add_layer(l1, 10, 1, activation_function=None)

然后定义损失函数为差值平方和的平均值

# 定义损失函数为差值平方和的平均值

loss = tf.reduce_mean(tf.reduce_sum(tf.square(ys - predition), axis=1))

# 进行逐步优化的梯度下降优化器,学习效率为0.1,以最小化损失函数的方式进行优化

train_step = tf.train.GradientDescentOptimizer(0.1).minimize(loss)

最后进行初始化和进行训练:

# 初始化所有定义的变量

init = tf.global_variables_initializer()

sess = tf.Session()

sess.run(init)

# 学习1000次

for i in range(1000):

sess.run(train_step, feed_dict={xs:x_data, ys:y_data})

# 打印期间的误差值,看这个误差值是否在减少

if i % 50 == 0:

print(sess.run(loss, feed_dict={xs:x_data, ys:y_data}))

完整的代码为:

import tensorflow as tf

def add_layer(inputs, in_size, out_size, activation_function=None):

"""

添加层

:param inputs: 输入数据

:param in_size: 输入数据的列数

:param out_size: 输出数据的列数

:param activation_function: 激励函数

:return:

"""

# 定义权重,初始时使用随机变量,可以简单理解为在进行梯度下降时的随机初始点,这个随机初始点要比0值好,因为如果是0值的话,反复计算就一直是固定在0中,导致可能下降不到其它位置去。

Weights = tf.Variable(tf.random_normal([in_size, out_size]))

# 偏置shape为1行out_size列

biases = tf.Variable(tf.zeros([1, out_size]) + 0.1)

# 建立神经网络线性公式:inputs * Weights + biases,我们大脑中的神经元的传递基本上也是类似这样的线性公式,这里的权重就是每个神经元传递某信号的强弱系数,偏置值是指这个神经元的原先所拥有的电位高低值

Wx_plus_b = tf.matmul(inputs, Weights) + biases

if activation_function is None:

# 如果没有设置激活函数,则直接就把当前信号原封不动地传递出去

outputs = Wx_plus_b

else:

# 如果设置了激活函数,则会由此激活函数来对信号进行传递或抑制

outputs = activation_function(Wx_plus_b)

return outputs

import numpy as np

# 创建一列(相当于只有一个属性值),300行的x值,这里np.newaxis用于新建出列数据,使其shape为(300, 1)

x_data = np.linspace(-1, 1, 300)[:,np.newaxis]

# 增加噪点,噪点的均值为0,标准差为0.05,形状跟x_data一样

noise = np.random.normal(0, 0.05, x_data.shape)

# 定义y的函数为二次曲线的函数,但同时增加了一些噪点数据

y_data = np.square(x_data) - 0.5 + noise

# 定义输入值,这里定义输入值的目的是为了能够使程序比较灵活,可以在神经网络启动时接收不同的实际输入值,这里输入的结构为输入的行数不国定,但列就是1列的值

xs = tf.placeholder(tf.float32, [None, 1])

ys = tf.placeholder(tf.float32, [None, 1])

# 定义一个隐藏层,输入为xs,输入size为1列,因为x_data就只有1个属性值,输出size我们假定输出的神经元有10个神经元的隐藏层,激励函数用relu

l1 = add_layer(xs, 1, 10, tf.nn.relu)

# 定义输出层,输入为l1,输入size为10列,也就是l1的列数,输出size为1,因为这里直接输出为类似y_data了,因此为1列,假定没有激励函数,也就是输出是啥就直接传递出去了。

predition = add_layer(l1, 10, 1, activation_function=None)

# 定义损失函数为差值平方和的平均值

loss = tf.reduce_mean(tf.reduce_sum(tf.square(ys - predition), axis=1))

# 进行逐步优化的梯度下降优化器,学习效率为0.1,以最小化损失函数的方式进行优化

train_step = tf.train.GradientDescentOptimizer(0.1).minimize(loss)

# 初始化所有定义的变量

init = tf.global_variables_initializer()

sess = tf.Session()

sess.run(init)

# 学习1000次

for i in range(1000):

sess.run(train_step, feed_dict={xs:x_data, ys:y_data})

# 打印期间的误差值,看这个误差值是否在减少

if i % 50 == 0:

print(sess.run(loss, feed_dict={xs:x_data, ys:y_data}))

执行后输出为:

0.558202

0.0136704

0.0095978

0.00769082

0.00639173

0.00552368

0.00489246

0.00448871

0.00421288

0.00402797

0.00389303

0.00378238

0.00370672

0.0036429

0.0035787

0.00350686

0.00344219

0.00338799

0.00332198

0.00326401

tensorflow建造神经网络-【老鱼学tensorflow】的更多相关文章

- tensorflow分类-【老鱼学tensorflow】

前面我们学习过回归问题,比如对于房价的预测,因为其预测值是个连续的值,因此属于回归问题. 但还有一类问题属于分类的问题,比如我们根据一张图片来辨别它是一只猫还是一只狗.某篇文章的内容是属于体育新闻还是 ...

- tensorflow例子-【老鱼学tensorflow】

本节主要用一个例子来讲述一下基本的tensorflow用法. 在这个例子中,我们首先伪造一些线性数据点,其实这些数据中本身就隐藏了一些规律,但我们假装不知道是什么规律,然后想通过神经网络来揭示这个规律 ...

- tensorflow安装-【老鱼学tensorflow】

TensorFlow是谷歌基于DistBelief进行研发的第二代人工智能学习系统,其命名来源于本身的运行原理.Tensor(张量)意味着N维数组,Flow(流)意味着基于数据流图的计算,Tensor ...

- tensorflow变量-【老鱼学tensorflow】

在程序中定义变量很简单,只要定义一个变量名就可以,但是tensorflow有点类似在另外一个世界,因此需要通过当前的世界中跟tensorlfow的世界中进行通讯,来告诉tensorflow的世界中定义 ...

- tensorflow激励函数-【老鱼学tensorflow】

当我们回到家,如果家里有异样,我们能够很快就会发现家中的异样,那是因为这些异常的摆设在我们的大脑中会产生较强的脑电波. 当我们听到某个单词,我们大脑中跟这个单词相关的神经元会异常兴奋,而同这个单词无关 ...

- tensorflow卷积神经网络-【老鱼学tensorflow】

前面我们曾有篇文章中提到过关于用tensorflow训练手写2828像素点的数字的识别,在那篇文章中我们把手写数字图像直接碾压成了一个784列的数据进行识别,但实际上,这个图像是2828长宽结构的,我 ...

- tensorflow Tensorboard可视化-【老鱼学tensorflow】

tensorflow自带了可视化的工具:Tensorboard.有了这个可视化工具,可以让我们在调整各项参数时有了可视化的依据. 本次我们先用Tensorboard来可视化Tensorflow的结构. ...

- tensorflow RNN循环神经网络 (分类例子)-【老鱼学tensorflow】

之前我们学习过用CNN(卷积神经网络)来识别手写字,在CNN中是把图片看成了二维矩阵,然后在二维矩阵中堆叠高度值来进行识别. 而在RNN中增添了时间的维度,因为我们会发现有些图片或者语言或语音等会在时 ...

- tensorflow用dropout解决over fitting-【老鱼学tensorflow】

在机器学习中可能会存在过拟合的问题,表现为在训练集上表现很好,但在测试集中表现不如训练集中的那么好. 图中黑色曲线是正常模型,绿色曲线就是overfitting模型.尽管绿色曲线很精确的区分了所有的训 ...

随机推荐

- 使用mongo-express管理mongodb数据库

前面的话 本文将详细介绍一款用nodejs开发的基于Web的mongodb数据库管理工具mongo-express 安装 首先,全局安装 mongo-express 包 npm install -g ...

- Spring MVC 使用介绍(六)—— 注解式控制器(二):请求映射与参数绑定

一.概述 注解式控制器支持: 请求的映射和限定 参数的自动绑定 参数的注解绑定 二.请求的映射和限定 http请求信息包含六部分信息: ①请求方法: ②URL: ③协议及版本: ④请求头信息(包括Co ...

- Go语言的并发

一.Go语言中Goroutine的基本原理 Go语言里的并发指的是能让某个函数独立于其他函数运行的能力. Go语言的goroutine是一个独立的工作单元, Go 语言的并发同步模型来自一个叫作通信顺 ...

- ICPC中国南昌国家邀请赛和国际丝绸之路规划大赛预选赛 I J

I. Max answer 链接:https://nanti.jisuanke.com/t/38228 思路: 枚举最小值,单调栈确定最小值的边界,用线段树+前缀和维护最小值的左右区间 实现代码: # ...

- 题解:[APIO2007]风铃

你需要选一个满足下面两个条件的风铃:(1) 所有的玩具都在同一层(也就是说,每个玩具到天花板之间的杆的个数是一样的)或至多相差一层.(2) 对于两个相差一层的玩具,左边的玩具比右边的玩具要更靠下一点. ...

- 如何取消Paypal自动付款功能

在国外在线服务消费肯定会常遇到PayPal的支付方式,有些人可能PayPal有些余额可能会用这个工具来支付,但付款后,可能服务因为不满意而退掉,但第二年却自动续约了?但明明服务已退掉,这该怎么处理呢? ...

- Notepad++ 的函数参数提示错误的问题终于解决了

看第3张图片,明明我输入的是 print_double(), 提示的却是 print() 函数的参数. 这个问题困扰了我半年,今天晚上找到解决问题的办法:

- 关于进程、线程、应用程序域(AppDomain)

什么是进程?什么是线程?什么是应用程序集?及三者之间的关系(以下做一些简单的概念性的理解) 三者共同的基础对象!!!——应用程序 1.进程是操作系统用于隔离众多正在运行的应用程序的机制,进程的缺点是降 ...

- TOMCAT ---> servlet概念

1 TOMCAT ---> servlet概念 2 TOMCAT 目录结构 (各个文件夹都存放什么东西) 3 TOMCAT 程序的层级 web | |---- js,jsp,html,css ( ...

- Teamviewer远程ssh命令行更改密码启动

Teamviewer远程ssh命令行更改密码启动 设置密码 $ sudo teamviewer passwd [NewPasswd ] 查看teamviewer信息 $ teamviewer info ...