大数据入门第八天——MapReduce详解(三)MR的shuffer、combiner与Yarn集群分析

/mr的combiner /mr的排序 /mr的shuffle /mr与yarn /mr运行模式 /mr实现join /mr全局图 /mr的压缩

今日提纲

一、流量汇总排序的实现

1.需求

对日志数据中的上下行流量信息汇总,并输出按照总流量倒序排序的结果

2.分析

基本思路:实现自定义的bean来封装流量信息,并将bean作为map输出的key来传输

MR程序在处理数据的过程中会对数据排序(map输出的kv对传输到reduce之前,会排序),排序的依据是map输出的key

所以,我们如果要实现自己需要的排序规则,则可以考虑将排序因素放到key中,让key实现接口:WritableComparable然后重写key的compareTo方法

当然,这里还需要考虑的问题是如果分区导致了结果多个reducer,则单个reducer是有序的,但全局不一定有序!

3.代码

package com.mr.flowsort; import com.mr.flowsum.FlowBean;

import org.apache.commons.lang.StringUtils;

import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Mapper; import java.io.IOException; /**

* mapper

* 这个排序针对的是上次流量汇总的结果,所以输入就是上次流量汇总输出的文件

* 输出就是Bean作为输入,手机号作为输出

*

* @author zcc ON 2018/2/2

**/

public class FlowSortMapper extends Mapper<LongWritable, Text, FlowBean, Text> {

private FlowBean flowBean = new FlowBean();

private Text phone = new Text();

@Override

protected void map(LongWritable key, Text value, Context context) throws IOException, InterruptedException {

// 各手机号的总流量信息

String line = value.toString();

String[] fields = line.split("\t");

String phoneNum = fields[0];

String bean = fields[1];

// 封装设置属性方法,下面封装的方法之所以如此费劲,是由于Bean的toString()方法所致

flowBean.setFields(getUpFlow(bean), getDownFlow(bean));

phone.set(phoneNum);

// 写出去(已序列化),同样Text也不能在这里new,否则new的次数过多,浪费内存

context.write(flowBean, phone);

} private long getUpFlow(String bean) {

int start = StringUtils.ordinalIndexOf(bean, "=", 1);

int end = StringUtils.ordinalIndexOf(bean, ",", 1);

String upFlow = bean.substring(start + 1, end);

return Long.parseLong(upFlow);

} private long getDownFlow(String bean) {

int start = StringUtils.ordinalIndexOf(bean, "=", 2);

int end = StringUtils.ordinalIndexOf(bean, ",", 2);

String downFlow = bean.substring(start + 1, end);

return Long.parseLong(downFlow);

}

// 以上方法可合并

private long getFlow(String bean, int ordinal) {

int start = StringUtils.ordinalIndexOf(bean, "=", ordinal);

int end = StringUtils.ordinalIndexOf(bean, ",", ordinal);

String flow = bean.substring(start + 1, end);

return Long.parseLong(flow);

} }

FlowSortMapper

package com.mr.flowsort; import com.mr.flowsum.FlowBean;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Reducer; import java.io.IOException; /**

* reducer

*

* @author zcc ON 2018/2/2

**/

public class FlowSortReducer extends Reducer<FlowBean,Text,Text,FlowBean>{

/**

* 进来的数据是<bean,phoneNum>,而且bean是不会相同的,所以迭代器此时只有一个元素

* @param key

* @param values

* @param context

* @throws IOException

* @throws InterruptedException

*/

@Override

protected void reduce(FlowBean key, Iterable<Text> values, Context context) throws IOException, InterruptedException {

// 直接写出即可,注意此时values只有一个

context.write(values.iterator().next(), key);

}

}

FlowSortReducer

package com.mr.flowsum; import org.apache.hadoop.io.Writable;

import org.apache.hadoop.io.WritableComparable; import java.io.DataInput;

import java.io.DataOutput;

import java.io.IOException; /**

* 这里选择实现WritableComparable接口即可,因为此接口继承了Writable接口(继承树关系)

* @author zcc ON 2018/1/31

**/

public class FlowBean implements WritableComparable<FlowBean>{

private long upFlow;

private long downFlow;

private long sumFlow; /**

* 反序列化时需要显式调用空参

*/

public FlowBean() {

} public FlowBean(long upFlow, long downFlow) {

this.upFlow = upFlow;

this.downFlow = downFlow;

this.sumFlow = upFlow + downFlow;

}

public void setFields(long upFlow, long downFlow) {

this.upFlow = upFlow;

this.downFlow = downFlow;

this.sumFlow = upFlow + downFlow;

}

public long getUpFlow() {

return upFlow;

} public void setUpFlow(long upFlow) {

this.upFlow = upFlow;

} public long getDownFlow() {

return downFlow;

} public void setDownFlow(long downFlow) {

this.downFlow = downFlow;

} public long getSumFlow() {

return sumFlow;

} public void setSumFlow(long sumFlow) {

this.sumFlow = sumFlow;

} /**

* 序列化

* @param out

* @throws IOException

*/

@Override

public void write(DataOutput out) throws IOException {

out.writeLong(upFlow);

out.writeLong(downFlow);

out.writeLong(sumFlow);

} /**

* 反序列化,注意序列化与反序列化的顺序必须一致!

* @param in

* @throws IOException

*/

@Override

public void readFields(DataInput in) throws IOException {

this.upFlow = in.readLong();

this.downFlow = in.readLong();

this.sumFlow = in.readLong();

} @Override

public String toString() {

return "FlowBean{" +

"upFlow=" + upFlow +

", downFlow=" + downFlow +

", sumFlow=" + sumFlow +

'}';

} @Override

public int compareTo(FlowBean o) {

return Long.compare(this.getSumFlow(), o.getSumFlow());

}

}

FlowBean

package com.mr.flowsort; import com.mr.flowsum.*;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat; /**

* 配置Driver

*

* @author zcc ON 2018/2/2

**/

public class FlowSortDriver {

public static void main(String[] args) throws Exception{

Configuration conf = new Configuration();

Job job = Job.getInstance(conf);

// 设置本程序jar包本地位置

job.setJarByClass(FlowSortDriver.class);

// 指定本业务job要使用的mapper/reducer业务类

job.setMapperClass(FlowSortMapper.class);

job.setReducerClass(FlowSortReducer.class);

// 指定map输出的数据类型(由于可插拔的序列化机制导致)

job.setMapOutputKeyClass(FlowBean.class);

job.setMapOutputValueClass(Text.class);

// 设置自定义分区器,这里不分区

// job.setPartitionerClass(ProvincePartitioner.class);

// 设置相应分区数量的reduceTask

// job.setNumReduceTasks(5);

// 指定最终输出(reduce)的的数据类型(可选,因为有时候不需要reduce)

job.setOutputKeyClass(Text.class);

job.setOutputValueClass(FlowBean.class);

// 指定job的原始输入/输出目录(可以改为由外面输入,而不必写死)

FileInputFormat.setInputPaths(job, new Path("/flowcount/output"));

FileOutputFormat.setOutputPath(job, new Path("/flowsort/output"));

// 提交(将job中的相关参数以及java类所在的jar包提交给yarn运行)

// job.submit();

// 反馈集群信息

boolean b = job.waitForCompletion(true);

System.exit(b ? 0 :1);

}

}

FlowSortDriver

这里注意一下输入输出路径即可,这里再次提醒运行的方式:

hadoop jar zk03.jar com.mr.flowsort.FlowSortDriver

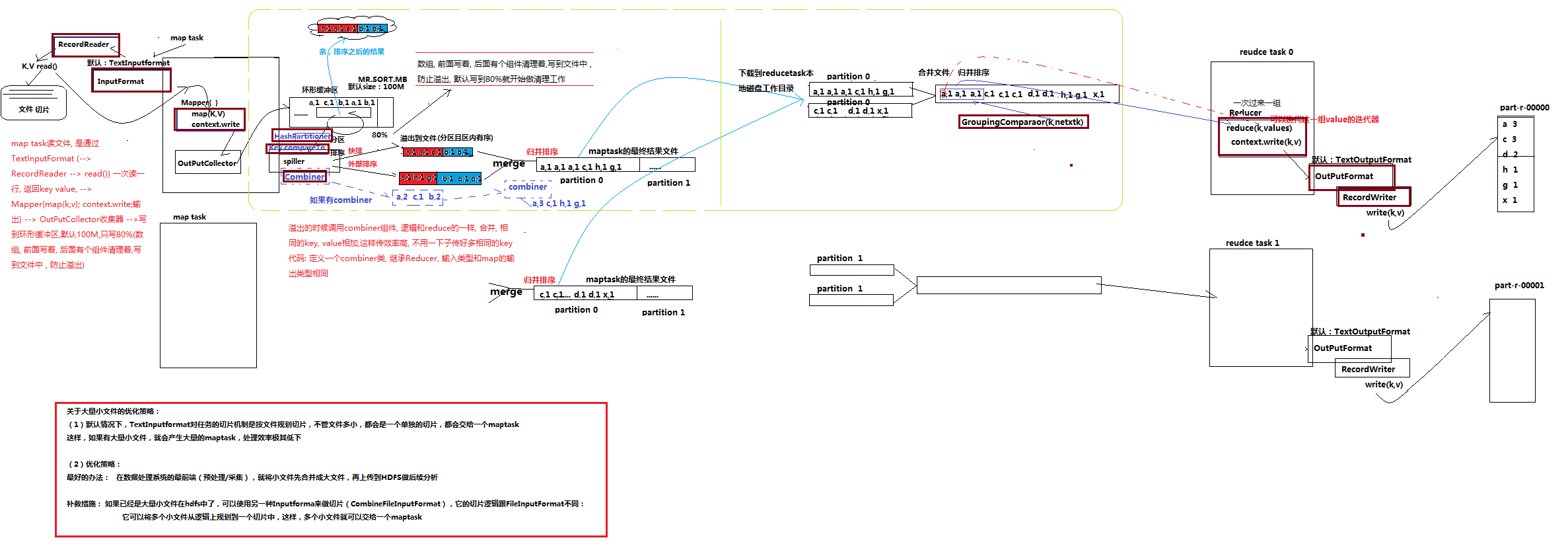

二、MR内部shuffer过程

这里对上面一整个排序的过程、数据的流向进行剖析:

(注意mr不仅仅是处理文本文件,只要更改默认的inputFormat即可,像之前的一次读一行就是由TextInputFormat决定的。所以是支持自定义的!常见的操作多行的文本的InputFormat也是有例如NLineInputFormat等定义的!)

1.概述

v mapreduce中,map阶段处理的数据如何传递给reduce阶段,是mapreduce框架中最关键的一个流程,这个流程就叫shuffle;

通俗的讲, Shuffle描述着数据从map task输出到reduce task输入的这段过程

v shuffle: 洗牌、发牌——(核心机制:数据分区,排序,缓存);

v 具体来说:就是将maptask输出的处理结果数据,分发给reducetask,并在分发的过程中,对数据按key进行了分区和排序;

2.流程详解

流程详解:

、maptask收集我们的map()方法输出的kv对,放到内存缓冲区中

、从内存缓冲区不断溢出本地磁盘文件,可能会溢出多个文件

、多个溢出文件会被合并成大的溢出文件

、在溢出过程中,及合并的过程中,都要调用partitoner进行分组和针对key进行排序

、reducetask根据自己的分区号,去各个maptask机器上取相应的结果分区数据

、reducetask会取到同一个分区的来自不同maptask的结果文件,reducetask会将这些文件再进行合并(归并排序)

、合并成大文件后,shuffle的过程也就结束了,后面进入reducetask的逻辑运算过程(从文件中取出一个一个的键值对group,调用用户自定义的reduce()方法) Shuffle中的缓冲区大小会影响到mapreduce程序的执行效率,原则上说,缓冲区越大,磁盘io的次数越少,执行速度就越快

缓冲区的大小可以通过参数调整, 参数:io.sort.mb 默认100M

推荐阅读shuffer详解的博文;http://langyu.iteye.com/blog/992916

http://blog.csdn.net/techchan/article/details/53405519

三、MR中的Combiner

(1)combiner是MR程序中Mapper和Reducer之外的一种组件

(2)combiner组件的父类就是Reducer

(3)combiner和reducer的区别在于运行的位置:

Combiner是在每一个maptask所在的节点运行

Reducer是接收全局所有Mapper的输出结果;

(4) combiner的意义就是对每一个maptask的输出进行局部汇总,以减小网络传输量

具体实现步骤:

1、 自定义一个combiner继承Reducer,重写reduce方法

2、 在job中设置: job.setCombinerClass(CustomCombiner.class)

package com.mr.wordcount; import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Reducer; import java.io.IOException; /**

* combiner

*

* @author zcc ON 2018/2/2

**/

public class WordcountCombiner extends Reducer<Text,IntWritable,Text,IntWritable>{

private IntWritable count = new IntWritable();

@Override

protected void reduce(Text key, Iterable<IntWritable> values, Context context) throws IOException, InterruptedException {

int c = 0;

for (IntWritable value : values) {

c += value.get();

}

count.set(c);

context.write(key, count);

}

}

WordcountCombiner

package com.mr.wordcount; import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat; /**

* wordcount的任务配置类

* 相当于yarn集群的客户端,在此封装MR配置参数

* @author zcc ON 2018/1/31

**/

public class WordCountDriver {

public static void main(String[] args) throws Exception{

Configuration conf = new Configuration();

Job job = Job.getInstance(conf);

// 设置本程序jar包本地位置

job.setJarByClass(WordCountDriver.class);

// 指定本业务job要使用的mapper/reducer业务类

job.setMapperClass(WordCountMapper.class);

job.setReducerClass(WordCountReducer.class);

// 指定map输出的数据类型(由于可插拔的序列化机制导致)

job.setMapOutputKeyClass(Text.class);

job.setMapOutputValueClass(IntWritable.class);

// 指定最终输出(reduce)的的数据类型(可选,因为有时候不需要reduce)

job.setOutputKeyClass(Text.class);

job.setOutputValueClass(IntWritable.class);

// 指定Combiner

job.setCombinerClass(WordcountCombiner.class);

// 指定job的原始输入/输出目录(可以改为由外面输入,而不必写死)

FileInputFormat.setInputPaths(job, new Path("/wordcount/input"));

FileOutputFormat.setOutputPath(job, new Path("/wordcount/output"));

// 提交(将job中的相关参数以及java类所在的jar包提交给yarn运行)

// job.submit();

// 反馈集群信息

boolean b = job.waitForCompletion(true);

System.exit(b ? 0 :1);

}

}

WordCountDriver

(5) combiner能够应用的前提是不能影响最终的业务逻辑

而且,combiner的输出kv应该跟reducer的输入kv类型要对应起来

注意:Combiner的输出是Reducer的输入,如果Combiner是可插拔的,添加Combiner绝不能改变最终的计算结果。所以Combiner只应该用于那种Reduce的输入key/value与输出key/value类型完全一致,且不影响最终结果的场景。

整个流程以及combiner的所处位置,参考详解:https://www.cnblogs.com/ljy2013/articles/4435657.html

四、mapreduce与yarn集群分析

1.yarn概述

Yarn是一个分布式的资源管理系统,用以提高分布式的集群环境下的资源利用率,

这些资源包括内存、IO、网络、磁盘等。其产生的原因是为了解决原MapReduce框架的不足。

最初MapReduce的committer们还可以周期性的在已有的代码上进行修改,可是随着代码的增加以及原MapReduce框架设计的不足,在原MapReduce框架上进行修改变得越来越困难,

所以MapReduce的committer们决定从架构上重新设计MapReduce,使下一代的MapReduce(MRv2/Yarn)框架具有更好的扩展性、可用性、可靠性、向后兼容性和更高的资源利用率

以及能支持除了MapReduce计算框架外的更多的计算框架。

2.yarn重要概念

1、 yarn并不清楚用户提交的程序的运行机制

2、 yarn只提供运算资源的调度(用户程序向yarn申请资源,yarn就负责分配资源)

3、 yarn中的主管角色叫ResourceManager

4、 yarn中具体提供运算资源的角色叫NodeManager

5、 这样一来,yarn其实就与运行的用户程序完全解耦,就意味着yarn上可以运行各种类型的分布式运算程序(mapreduce只是其中的一种),比如 mapreduce、storm程序,spark程序,tez ……

6、 所以,spark、storm等运算框架都可以整合在yarn上运行,只要他们各自的框架中有符合yarn规范的资源请求机制即可

7、 Yarn就成为一个通用的资源调度平台,从此,企业中以前存在的各种运算集群都可以整合在一个物理集群上,提高资源利用率,方便数据共享

3.调度过程图

新旧Haoop的mapreduce对比:https://www.ibm.com/developerworks/cn/opensource/os-cn-hadoop-yarn/

相关流程分析,参考:https://www.cnblogs.com/cxzdy/p/4943159.html

大数据入门第八天——MapReduce详解(三)MR的shuffer、combiner与Yarn集群分析的更多相关文章

- 大数据入门第八天——MapReduce详解(四)本地模式运行与join实例

一.本地模式调试MR程序 1.准备 参考之前随笔的windows开发说明处:http://www.cnblogs.com/jiangbei/p/8366238.html 2.流程 最重要的是设置Loc ...

- 大数据入门第五天——离线计算之hadoop(上)概述与集群安装

一.概述 根据之前的凡技术必登其官网的原则,我们当然先得找到它的官网:http://hadoop.apache.org/ 1.什么是hadoop 先看官网介绍: The Apache™ Hadoop® ...

- 大数据入门第九天——MapReduce详解(五)mapJoin、GroupingComparator与更多MR实例

一.数据倾斜分析——mapJoin 1.背景 接上一个day的Join算法,我们的解决join的方式是:在reduce端通过pid进行串接,这样的话: --order ,,P0001, ,,P0001 ...

- 大数据入门第九天——MapReduce详解(六)MR其他补充

一.自定义in/outputFormat 1.需求 现有一些原始日志需要做增强解析处理,流程: 1. 从原始日志文件中读取数据 2. 根据日志中的一个URL字段到外部知识库中获取信息增强到原始日志 3 ...

- 大数据入门第七天——MapReduce详解(一)入门与简单示例

一.概述 1.map-reduce是什么 Hadoop MapReduce is a software framework for easily writing applications which ...

- 大数据入门第十七天——storm上游数据源 之kafka详解(三)其他问题

一.kafka文件存储机制 1.topic存储 在Kafka文件存储中,同一个topic下有多个不同partition,每个partition为一个目录,partiton命名规则为topic名称+有序 ...

- 大数据入门第七天——MapReduce详解(二)切片源码浅析与自定义patition

一.mapTask并行度的决定机制 1.概述 一个job的map阶段并行度由客户端在提交job时决定 而客户端对map阶段并行度的规划的基本逻辑为: 将待处理数据执行逻辑切片(即按照一个特定切片大小, ...

- 大数据入门第十六天——流式计算之storm详解(一)入门与集群安装

一.概述 今天起就正式进入了流式计算.这里先解释一下流式计算的概念 离线计算 离线计算:批量获取数据.批量传输数据.周期性批量计算数据.数据展示 代表技术:Sqoop批量导入数据.HDFS批量存储数据 ...

- 大数据入门第十四天——Hbase详解(一)入门与安装配置

一.概述 1.什么是Hbase 根据官网:https://hbase.apache.org/ Apache HBase™ is the Hadoop database, a distributed, ...

随机推荐

- Sun Solairs系统添加裸设备

Sun Solaris系统添加裸设备对表空间进行扩容的大体操作步骤. 1.查看当前卷组信息 --查看当前卷组信息#vxdg list --查看当前卷组中物理磁盘的使用情况#vxdg free |gre ...

- Oracle EBS 请求参数关联

- 初始docker

什么是docker? 很多人都是使用docker但是对docker的理解其实并没有这么透彻,只知道怎么用但是不知道为什么用 什么时候去用. 一.环境配置的难题 软件开发最大的麻烦事之一,就是环境配置. ...

- windows 端口映射

netsh interface portproxy add v4tov4 listenport=8765 listenaddress=0.0.0.0 connectaddress=172.19.24. ...

- windows 下安装nodejs 要怎么设置环境变量

windows 下安装nodejs 了,也安装了npm, 但是有时候切不能直接用request(‘ws’)这一类的东西.我觉得是确实环境变量或其他设置有问题,能否给个完整的设置方案: 要设置两个东西, ...

- web开发方面会遇到哪些缓存?分别如何优化

Web缓存定义: Web缓存游走于服务器和客户端之间,这个服务器可能是源服务器(资源所驻留的服务器Add),数量可能是1个或多个. Web缓存就在服务器-客户端之间搞监控,监控请求,并且把请求输出的内 ...

- win中使用cmd杀端口

最近在win开发时,总是遇到端口占用的情况...可能是跑的程序太多了吧 当你测试一个demo时遇到这个就很恶心.. 记一下 netstat -ano | findstr 80 //列出进程极其占用的端 ...

- zabbix的日常监控-分布式监控(十)

参考博文:http://blog.51cto.com/jinlong/2051966 zabbix proxy 可以代替 zabbix server 检索客户端的数据,然后把数据汇报给 zabbix ...

- ubuntu安装pycharm并设置快捷方式

一.tar.gz包安装 从官网下载压缩包 tar zxfv pycharm-professional-2017.3.3.tar.gz cd pycharm-2017.3.3 ./bin/pycharm ...

- swoole_table测试

public function test() { $count = []; $count[] = ['key' => 'name', 'type' => ...