使用docker-compose部署Kafka集群

之前写过Kafka集群的部署,不过那是基于宿主机的,地址:Kafka基础教程(二):Kafka安装

和Zookeeper一样,有时想简单的连接Kafka用一下,那就需要开好几台虚拟机,如果Zookeeper部署在其他地方,那还得多开几台,用完还得关掉,否则太占内存,而且这样操作甚是繁琐。

于是我想了一下,可以使用docker来搭建一个简单的Zookeeper和Kafak集群,上一篇说了Zookeeper集群的docker实现(使用docker或者docker-compose部署Zookeeper集群),现在说说使用Kafka集群的docker实现。

首先,我们需要安装docker(参考:docker简单安装)

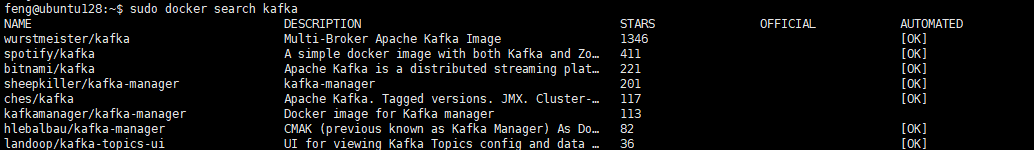

接下来我们需要镜像,不幸的是,Kafka没有官方镜像,那我们可以自己做一个,或者使用已经做好的镜像,比如dockerhub上Star最多的wurstmeister/kafka:

由于Kafka需要Zookeeper,如果直接使用docker命令行来操作,那也是一个麻烦事,所以我采用了docker-compose来实现,虽然看GitHub上的教程(点击跳转),不过还是遇到了很多坑。

先将镜像pull下来:

# Zookeeper

sudo docker pull wurstmeister/zookeeper

# Kafka

sudo docker pull wurstmeister/kafka

然后创建一个空目录,创建一个 docker-compose.yml ,根据GitHub上的教程,如果只启动单节点,那么 docker-compose.yml 内容如下:

# yaml 配

version: '2'

services:

zookeeper:

image: wurstmeister/zookeeper

restart: always

ports:

- 2181:2181

kafka:

image: wurstmeister/kafka

restart: always

depends_on:

- zookeeper

ports:

- 9092:9092

environment:

KAFKA_ADVERTISED_HOST_NAME: kafka

KAFKA_ZOOKEEPER_CONNECT: zookeeper:2181/kafka

KAFKA_LISTENERS: PLAINTEXT://:9092

KAFKA_ADVERTISED_LISTENERS: PLAINTEXT://192.168.209.128:9092

KAFKA_BROKER_ID: 1

volumes:

- /var/run/docker.sock:/var/run/docker.sock

如果是要一个kafka集群,那么 docker-compose.yml 内容如下:

# yaml 配

version: '2'

services:

zookeeper:

image: wurstmeister/zookeeper

restart: always

ports:

- 2181:2181

kafka1:

image: wurstmeister/kafka

restart: always

depends_on:

- zookeeper

ports:

- 9093:9093

environment:

KAFKA_ADVERTISED_HOST_NAME: kafka1

KAFKA_ZOOKEEPER_CONNECT: zookeeper:2181/kafka

KAFKA_LISTENERS: PLAINTEXT://:9093

KAFKA_ADVERTISED_LISTENERS: PLAINTEXT://192.168.209.128:9093

KAFKA_BROKER_ID: 1

volumes:

- /var/run/docker.sock:/var/run/docker.sock

kafka2:

image: wurstmeister/kafka

restart: always

depends_on:

- zookeeper

ports:

- 9094:9094

environment:

KAFKA_ADVERTISED_HOST_NAME: kafka2

KAFKA_ZOOKEEPER_CONNECT: zookeeper:2181/kafka

KAFKA_LISTENERS: PLAINTEXT://:9094

KAFKA_ADVERTISED_LISTENERS: PLAINTEXT://192.168.209.128:9094

KAFKA_BROKER_ID: 2

volumes:

- /var/run/docker.sock:/var/run/docker.sock

kafka3:

image: wurstmeister/kafka

restart: always

depends_on:

- zookeeper

ports:

- 9095:9095

environment:

KAFKA_ADVERTISED_HOST_NAME: kafka3

KAFKA_ZOOKEEPER_CONNECT: zookeeper:2181/kafka

KAFKA_LISTENERS: PLAINTEXT://:9095

KAFKA_ADVERTISED_LISTENERS: PLAINTEXT://192.168.209.128:9095

KAFKA_BROKER_ID: 3

volumes:

- /var/run/docker.sock:/var/run/docker.sock

另外,还有几个环境变量需要说明一下:

KAFKA_ADVERTISED_HOST_NAME:广播主机名称,一般用IP指定

KAFKA_ZOOKEEPER_CONNECT:Zookeeper连接地址,格式:zoo1:port1,zoo2:port2:/path

KAFKA_LISTENERS:Kafka启动所使用的的协议及端口

KAFKA_ADVERTISED_LISTENERS:Kafka广播地址及端口,也就是告诉客户端,使用什么地址和端口能连接到Kafka,这个很重要,如果不指定,宿主机以外的客户端将无法连接到Kafka,比如我这里因为容器与宿主机做了端口映射,所以广播地址采用的是宿主机的地址及端口,告诉客户端只要连接到宿主机的指定端口就行了

KAFKA_BROKER_ID:指定BrokerId,如果不指定,将会自己生成

接着创建容器并启动:

# 创建并启动容器,可以使用 -f 参数指定docker-compose.yml文件

sudo docker-compose up -d

# 查看状态

sudo docker-compose ps

# 停止并删除容器,可以使用 -f 参数指定docker-compose.yml文件

sudo docker-compose down

查看状态,虽然集群启动了,但是记得连接要使用宿主机的地址和端口来连接。

使用docker-compose部署Kafka集群的更多相关文章

- docker下部署kafka集群(多个broker+多个zookeeper)

网上关于kafka集群的搭建,基本是单个broker和单个zookeeper,测试研究的意义不大.于是折腾了下,终于把正宗的Kafka集群搭建出来了,在折腾中遇到了很多坑,后续有时间再专门整理份搭建问 ...

- Docker 容器部署 Consul 集群

Docker 容器部署 Consul 集群 一.docker安装与启动1.1安装docker[root@localhost /]# yum -y install docker-io 1.2更改配置文件 ...

- 使用docker安装部署Spark集群来训练CNN(含Python实例)

使用docker安装部署Spark集群来训练CNN(含Python实例) http://blog.csdn.net/cyh_24/article/details/49683221 实验室有4台神服务器 ...

- Docker安装部署es集群

Docker安装部署es集群:环境准备:已安装docker的centos服务器一台1. 拉取es版本docker pull elasticsearch:5.6.82. 新建文件夹 数据挂载目录 和 配 ...

- 庐山真面目之十微服务架构 Net Core 基于 Docker 容器部署 Nginx 集群

庐山真面目之十微服务架构 Net Core 基于 Docker 容器部署 Nginx 集群 一.简介 前面的两篇文章,我们已经介绍了Net Core项目基于Docker容器部署在Linux服 ...

- docker部署kafka集群

利用docker可以很方便的在一台机子上搭建kafka集群并进行测试.为了简化配置流程,采用docker-compose进行进行搭建. kafka搭建过程如下: 编写docker-compose.ym ...

- Docker搭建Zookeeper&Kafka集群

最近在学习Kafka,准备测试集群状态的时候感觉无论是开三台虚拟机或者在一台虚拟机开辟三个不同的端口号都太麻烦了(嗯..主要是懒). 环境准备 一台可以上网且有CentOS7虚拟机的电脑 为什么使用虚 ...

- docker 快速部署ES集群 spark集群

1) 拉下来 ES集群 spark集群 两套快速部署环境, 并只用docker跑起来,并保存到私库. 2)弄清楚怎么样打包 linux镜像(或者说制作). 3)试着改一下,让它们跑在集群里面. 4) ...

- Docker实战之Kafka集群

1. 概述 Apache Kafka 是一个快速.可扩展的.高吞吐.可容错的分布式发布订阅消息系统.其具有高吞吐量.内置分区.支持数据副本和容错的特性,适合在大规模消息处理场景中使用. 笔者之前在物联 ...

随机推荐

- Dubbo多版本控制

当系统进行升级时,一般都是采用"灰度发布(又称为金丝雀发布)"过程.即在低压力时段,让部分消费者先调用新的提供者实现类,其余的仍然调用老的实现类,在新的实现类运行没有问题的情况下, ...

- Spring boot 数据源配置。

配置文件 : spring boot 配置文件 有两种形式 ,一种是properties文件.一种是yml文件.案列使用properties文件. 数据源的默认配置 : spring boot 约定 ...

- Apifox(2)快速上手apifox

快速上手 使用场景 Apifox 是接口管理.开发.测试全流程集成工具,使用受众为整个研发技术团队,主要使用者为前端开发.后端开发和测试人员. 前端开发 接口文档管理 接口数据 Mock 接口调试 前 ...

- win10更新后任务栏卡死 的原因和解决办法

@ 目录 现象: 原因: 第一步:断网并关闭资讯和兴趣 第二步:卸载更新 第三步:关闭win10自动更新 第四步:永久关闭资讯和兴趣 现象: win10 更新后,开机任务栏卡死,点开始反应,设置页面无 ...

- 关于og4j漏洞修复解决方案及源码编译

最近log4j爆出重大漏洞,程序员要赶紧修复了!文末提供已经编译好的jar包. 建议最好修复到log4j-2.15.0-rc2版本,临时解决方案还是存在jndi漏洞. 打开log4j官网https:/ ...

- Python pyecharts绘制柱状图

本文摘抄至https://05x-docs.pyecharts.org/#/zh-cn/charts_base?id=bar%ef%bc%88%e6%9f%b1%e7%8a%b6%e5%9b%be%e ...

- Python绘制饼图

Python绘制饼图 1.1 对应代码如下图所示 import matplotlib.pyplot as pltfrom pylab import mplmpl.rcParams['font.sans ...

- SQL 注入基础

SQL注入 SQL注入是服务器端未严格校验客户端发送的数据,而导致服务端SQL语句被恶意修改并成功执行的行为. 本质:把用户输入的数据当作代码执行.任何和数据库产生交互的地方便有可能存在注入. SQL ...

- UVA10079 Pizza Cutting 题解

Content 求用 \(n\) 条直线最多能将平面分成多少块区域. 多组输入,以一个负数结束. 数据范围:\(0\leqslant n\leqslant 2.1\times 10^8\). Solu ...

- mysql如何查询某个库,某个表都有哪些字段

如下语句便可查看 SELECT column_name FROM Information_schema.columns WHERE table_Name = 'columns' AND TABLE_ ...