初识python 之 爬虫:使用正则表达式爬取“糗事百科 - 文字版”网页数据

初识python 之 爬虫:使用正则表达式爬取”古诗文“网页数据 的兄弟篇。

详细代码如下:

#!/user/bin env python

# author:Simple-Sir

# time:2019/8/1 14:50

# 爬取糗事百科(文字)网页数据 import requests,re

URLHead = 'https://www.qiushibaike.com' def getHtml(url):

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/75.0.3770.100 Safari/537.36'

}

respons = requests.get(url,headers=headers)

html = respons.text

return html

def getInfos(url):

html = getHtml(url)

authors = re.findall(r'<h2>\n(.*?)\n</h2>',html,re.DOTALL) # 获取作者

author_sex_lvl = re.findall(r'<div class="articleGender (.*?)Icon">(\d*?)</div>',html,re.DOTALL) # 获取作者性别、等级

author_sex = [] # 性别

author_lvl = [] # 等级

for i in author_sex_lvl:

author_sex.append(i[0])

author_lvl.append(i[1]) contentHerf = re.findall(r'<a href="(/article.*?)".*?class="contentHerf"',html,re.DOTALL)[1:] # 获取“详细页”href

cont = [] # 内容

for contentUrl in contentHerf:

contentHerf_all = URLHead + contentUrl

contentHtml = getHtml(contentHerf_all) # 详细页html

contents = re.findall(r'<div class="content">(.*?)</div>',contentHtml,re.DOTALL)

content_br = re.sub(r'<br/>','',contents[0]) # 剔除</br>标签

content = re.sub(r'\\xa0','',content_br)

cont.append(content)

infos = []

for i in zip(authors,author_sex,author_lvl,cont):

author,sex,lvl,text=i

info ={

'作者':author,

'性别': sex,

'等级': lvl,

'内容': text

}

infos.append(info)

return infos def main():

page = int(input('您想获取前几页的数据?\n'))

for i in range(1,page+1):

url = 'https://www.qiushibaike.com/text/page/{}'.format(i)

print('正在爬取第{}页数据:'.format(i))

for t in getInfos(url):

print(t)

print('第{}页数据已爬取完成。'.format(i))

print('所有数据已爬取完成!') if __name__ == '__main__':

main()

爬取糗事百科(文字)网页数据

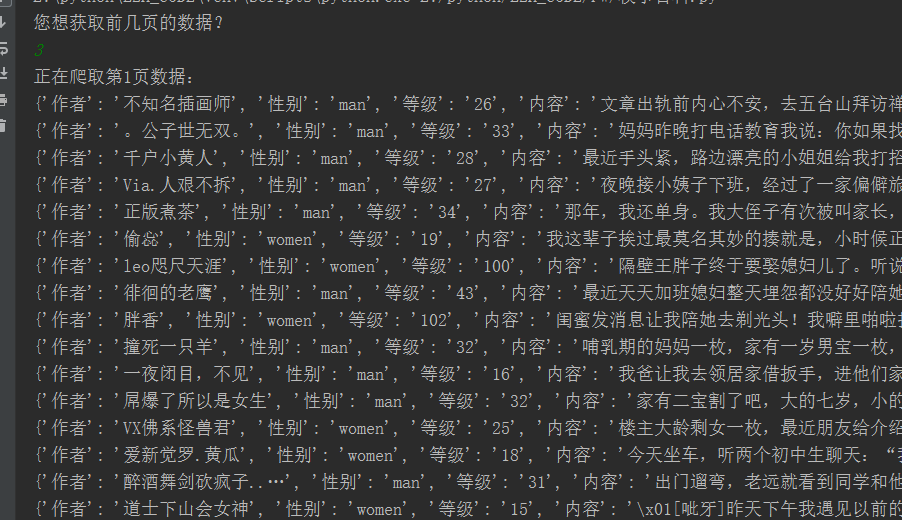

执行结果:

初识python 之 爬虫:使用正则表达式爬取“糗事百科 - 文字版”网页数据的更多相关文章

- python+正则提取+ip代理爬取糗事百科文字信息

很多网站都有反爬措施,最常见的就是封ip,请求次数过多服务器会拒绝连接,如图: 在程序中设置一个代理ip,可有效的解决这种问题,代码如下: # 需要的库 import requests import ...

- python_爬虫一之爬取糗事百科上的段子

目标 抓取糗事百科上的段子 实现每按一次回车显示一个段子 输入想要看的页数,按 'Q' 或者 'q' 退出 实现思路 目标网址:糗事百科 使用requests抓取页面 requests官方教程 使用 ...

- 爬取糗事百科热门段子的数据并保存到本地,xpath的使用

和之前的爬虫类博客的爬取思路基本一致: 构造url_list,因为糗事百科的热门栏目默认是13页,所以这个就简单了 遍历发送请求获取响应 提取数据,这里用的是xpath提取,用的是Python的第三方 ...

- 芝麻HTTP:Python爬虫实战之爬取糗事百科段子

首先,糗事百科大家都听说过吧?糗友们发的搞笑的段子一抓一大把,这次我们尝试一下用爬虫把他们抓取下来. 友情提示 糗事百科在前一段时间进行了改版,导致之前的代码没法用了,会导致无法输出和CPU占用过高的 ...

- python 爬虫实战1 爬取糗事百科段子

首先,糗事百科大家都听说过吧?糗友们发的搞笑的段子一抓一大把,这次我们尝试一下用爬虫把他们抓取下来. 本篇目标 抓取糗事百科热门段子 过滤带有图片的段子 实现每按一次回车显示一个段子的发布时间,发布人 ...

- Python爬虫实战之爬取糗事百科段子

首先,糗事百科大家都听说过吧?糗友们发的搞笑的段子一抓一大把,这次我们尝试一下用爬虫把他们抓取下来. 友情提示 糗事百科在前一段时间进行了改版,导致之前的代码没法用了,会导致无法输出和CPU占用过高的 ...

- Python爬虫实战之爬取糗事百科段子【华为云技术分享】

首先,糗事百科大家都听说过吧?糗友们发的搞笑的段子一抓一大把,这次我们尝试一下用爬虫把他们抓取下来. 友情提示 糗事百科在前一段时间进行了改版,导致之前的代码没法用了,会导致无法输出和CPU占用过高的 ...

- 2019基于python的网络爬虫系列,爬取糗事百科

**因为糗事百科的URL改变,正则表达式也发生了改变,导致了网上许多的代码不能使用,所以写下了这一篇博客,希望对大家有所帮助,谢谢!** 废话不多说,直接上代码. 为了方便提取数据,我用的是beaut ...

- 21天打造分布式爬虫-Spider类爬取糗事百科(七)

7.1.糗事百科 安装 pip install pypiwin32 pip install Twisted-18.7.0-cp36-cp36m-win_amd64.whl pip install sc ...

随机推荐

- 使用 IntelliJ IDEA 远程调试 Tomcat

一.本地 Remote Server 配置 添加一个Remote Server 如下图所示 1. 复制JVM配置参数,第二步有用 2. 填入远程tomcat主机的IP地址和想开启的调试端口(自定义) ...

- java异常处理中throws和throw的使用

异常介绍: 运行时异常.非运行时异常 在编写可能会抛出异常的方法时,它们都必须声明为有异常. 一.throws关键字 1.声明方法可能抛出的异常: 2.写在方法名后面: 3.可声明抛出多个异常,异常名 ...

- 一个超好用的 Python 标准库,彻底玩透路径操作

pathlib 学习 Python 时,尤其是在进行文件操作和数据处理时,经常会处理路径问题.最常用和常见的是 os.path 模块,它将路径当做字符串进行处理,如果使用不当可能导致难以察觉的错误,而 ...

- 程序员Meme 第02期

- Mysql实例 数据库优化

目录 一.前言 二.数据库表设计 三.数据库结构设计 四.数据库性能优化 硬件配置选择 数据库配置优化 系统配置优化 数据库安全优化 五.数据库架构扩展 增加缓存 主从复制与读写分离 分库 分表 分区 ...

- [BUUCTF]PWN——bjdctf_2020_router

bjdctf_2020_router 附件 步骤: 例行检查,64位程序,开启了NX保护 本地试运行一下程序,看看大概的情况 会让我们选择,选择4.root,没什么用,但是注意了,这边选1会执行pin ...

- ANTLR 语法设计

下面学习如何编写语法. 如何定义语法规则 一种语言模式就是一种递归的语法结构. 我们需要从一系列有代表性的输入文件中归纳出一门语言的结构.在完成这样的归纳工作后,我们就可以正式使用ANTLR语法来表达 ...

- 11 - Vue3 UI Framework - Card 组件

卡片是非常常用也是非常重要的组件,特别是在移动端的众多应用场景中,随便打开一个手机 App ,您会发现充斥着各种各样的卡片. 所以,我们也来制作一个简易的 Card 组件 返回阅读列表点击 这里 需求 ...

- 区块链开发学习第七章:第一个Dapp-猜拳游戏

第一个简单的Dapp-猜拳游戏.本智能合约的功能很简单,就是用户与电脑猜拳,用户选择出手后,电脑随机一个选项,然后调用智能合约方法把两个选项值传过去,在智能合约上进行比较,并通过区块链合约事件广播结果 ...

- java 编程基础 Class对象 反射:代理模式和静态代理

生活中的代理 类(对象)代理模式 代理模式是面向对象编程中比较常见的设计模式. 1. 用户只关心接口功能,而不在乎谁提供了功能.上图中接口是 Subject 2. 接口真正实现者是上图的 RealSu ...