利用Python爬虫刷店铺微博等访问量最简单有效教程

一、安装必要插件

测试环境:Windows 10 + Python 3.7.0

(1)安装Selenium

pip install selenium

pip install requests

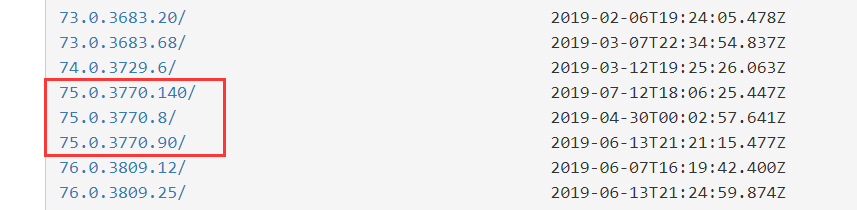

每个版本支持的 Chrome版本是不一样的,必须要对应的版本才能驱动浏览器。

官方网站被墙,可以下载全版本的:http://npm.taobao.org/mirrors/chromedriver

比如我的Chrome浏览器和Webdriver版本对应都用V75的:

(4)Chrome WebDriver安装

1. Windows 安装方法:

下载压缩包解压,chromedriver.exe 和python.exe 都放到python根目录下即可。

2. Linux 安装方法:

把解压的文件放到 /usr/bin 目录下,并且修改好权限。

二、代码模板

目标:使用代码控制浏览器访问指定的链接,并且每次访问使用不同的代理。

代理:使用的是大象代理的api接口提取代理IP。

这段代码稳定性还不错,超时等错误就会重启脚本继续获取新的代理IP,保证脚本能够长时间运行。

import random

import requests

import time

from selenium import webdriver

import sys

import os # 随机获取浏览器标识

def get_UA():

UA_list = [

"Mozilla/5.0 (Linux; Android 4.1.1; Nexus 7 Build/JRO03D) AppleWebKit/535.19 (KHTML, like Gecko) Chrome/18.0.1025.166 Safari/535.19",

"Mozilla/5.0 (Linux; U; Android 4.0.4; en-gb; GT-I9300 Build/IMM76D) AppleWebKit/534.30 (KHTML, like Gecko) Version/4.0 Mobile Safari/534.30",

"Mozilla/5.0 (Linux; U; Android 2.2; en-gb; GT-P1000 Build/FROYO) AppleWebKit/533.1 (KHTML, like Gecko) Version/4.0 Mobile Safari/533.1",

"Mozilla/5.0 (Windows NT 6.2; WOW64; rv:21.0) Gecko/20100101 Firefox/21.0",

"Mozilla/5.0 (Android; Mobile; rv:14.0) Gecko/14.0 Firefox/14.0",

"Mozilla/5.0 (Windows NT 6.2; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/27.0.1453.94 Safari/537.36"

]

randnum = random.randint(0, len(UA_list)-1)

h_list = UA_list[randnum]

return h_list # 获取代理IP

def get_ip():

# 这里填写大象代理api地址,num参数必须为1,每次只请求一个IP地址

url = 'http://www.baidu.com'

response = requests.get(url)

response.close()

ip = response.text

print(ip)

return ip if __name__ == '__main__':

url = "https://www.hao123.com/"

# 无限循环,每次都要打开一个浏览器窗口,不是标签

while 1:

# 调用函数获取浏览器标识, 字符串

headers = get_UA()

# 调用函数获取IP代理地址,这里获取是字符串,而不是像前两个教程获得的是数组

proxy = get_ip()

# 使用chrome自定义

chrome_options = webdriver.ChromeOptions()

# 设置代理

chrome_options.add_argument('--proxy-server=http://'+proxy)

# 设置UA

chrome_options.add_argument('--user-agent="'+headers+'"')

# 使用设置初始化webdriver

driver = webdriver.Chrome(chrome_options=chrome_options) try:

# 访问超时30秒

driver.set_page_load_timeout(30)

# 访问网页

driver.get(url)

# 退出当前浏览器

driver.close()

# 延迟1~3秒继续

time_delay = random.randint(1, 3)

while time_delay > 0:

print(str(time_delay) + " seconds left!!")

time.sleep(1)

time_delay = time_delay - 1

pass

except:

print("timeout")

# 退出浏览器

driver.quit()

time.sleep(1)

# 重启脚本, 之所以选择重启脚本是因为,长时间运行该脚本会出现一些莫名其妙的问题,不如重启解决

python = sys.executable

os.execl(python, python, *sys.argv)

finally:

pass

利用Python爬虫刷店铺微博等访问量最简单有效教程的更多相关文章

- 利用Python爬虫刷新某网站访问量

前言:前一段时间看到有博友写了爬虫去刷新博客访问量一篇文章,当时还觉得蛮有意思的,就保存了一下,但是当我昨天准备复现的时候居然发现文章404了.所以本篇文章仅供学习交流,严禁用于商业用途 很多人学习p ...

- 如何科学地蹭热点:用python爬虫获取热门微博评论并进行情感分析

前言:本文主要涉及知识点包括新浪微博爬虫.python对数据库的简单读写.简单的列表数据去重.简单的自然语言处理(snowNLP模块.机器学习).适合有一定编程基础,并对python有所了解的盆友阅读 ...

- 如何利用python爬虫爬取爱奇艺VIP电影?

环境:windows python3.7 思路: 1.先选取你要爬取的电影 2.用vip解析工具解析,获取地址 3.写好脚本,下载片断 4.将片断利用电脑合成 需要的python模块: ##第一 ...

- 如何利用 Python 爬虫实现给微信群发新闻早报?(详细)

1. 场景 经常有小伙伴在交流群问我,每天的早报新闻是怎么获取的? 其实,早期使用的方案,是利用爬虫获取到一些新闻网站的标题,然后做了一些简单的数据清洗,最后利用 itchat 发送到指定的社群中. ...

- 利用python爬虫关键词批量下载高清大图

前言 在上一篇写文章没高质量配图?python爬虫绕过限制一键搜索下载图虫创意图片!中,我们在未登录的情况下实现了图虫创意无水印高清小图的批量下载.虽然小图能够在一些移动端可能展示的还行,但是放到pc ...

- 利用python爬虫爬取图片并且制作马赛克拼图

想在妹子生日送妹子一张用零食(或者食物类好看的图片)拼成的马赛克拼图,因此探索了一番= =. 首先需要一个软件来制作马赛克拼图,这里使用Foto-Mosaik-Edda(网上也有在线制作的网站,但是我 ...

- python爬虫起步...开发环境搭建,最简单的方式

研究一门编程语言,一般第一步就是配置安装部署相关的编程环境.我认为啊,在学习的初期,大家不是十分了解相关的环境,或者是jar包,python模块等的相关内容,就不需要花费大量的时间去研究如何去安装它. ...

- Python爬虫学习三------requests+BeautifulSoup爬取简单网页

第一次第一次用MarkDown来写博客,先试试效果吧! 昨天2018俄罗斯世界杯拉开了大幕,作为一个伪球迷,当然也得为世界杯做出一点贡献啦. 于是今天就编写了一个爬虫程序将腾讯新闻下世界杯专题的相关新 ...

- 利用Python爬虫爬取指定天猫店铺全店商品信息

本编博客是关于爬取天猫店铺中指定店铺的所有商品基础信息的爬虫,爬虫运行只需要输入相应店铺的域名名称即可,信息将以csv表格的形式保存,可以单店爬取也可以增加一个循环进行同时爬取. 源码展示 首先还是完 ...

随机推荐

- Exploratory Testing 3.0 - 探索式测试

最近看了James Bach新发的一篇文章,名为Exploratory Testing 3.0,文章链接:http://www.satisfice.com/blog/archives/1509 这篇文 ...

- 自定义Vue组件打包、发布到npm以及使用

本文将帮助:将自己写的Vue组件打包到npm进行代码托管,以及正常发布之后如何使用自己的组件. 本文讲述的仅仅是最基础的实现,其他复杂的操作需要非常熟悉webpack的相关知识,作者将继续学习. 先附 ...

- 按需动态加载js

有些时间我们希望能按需动态加载js文件,而不是直接在HTML中写script标签. 以下为示例代码: var js = document.createElement('script'); js.asy ...

- 通过重复运行的Microsoft Flow由OAuth认证后获取Access Token并将其更新到实体记录

我是微软Dynamcis 365 & Power Platform方面的工程师罗勇,也是2015年7月到2018年6月连续三年Dynamics CRM/Business Solutions方面 ...

- [20191010]bash行计算器.txt

[20191010]bash行计算器.txt --//写一个bash行计算器,为了避免冲突,函数命名为2个=,1个=感觉不是很好(心里上^_^).--//使用bc计算器,里面函数不能使用圆括号,使用中 ...

- Python中线程的使用

并发:多个任务同一时间段进行 并行:多个任务同一时刻进行 线程的实现 线程模块 Python通过两个标准库_thread 和threading,提供对线程的支持 , threading对_thread ...

- 堆与栈(heap and stack)在c/c++的应用(概念)

在学习c/c++时,我们经常会遇到 堆与栈 的问题,今天就来讲一下各类情况下的heap,stack的应用. 程序内存布局场景下,堆与栈表示两种内存管理方式: 1.内部分配时,堆和栈表示两种不同的内存管 ...

- 软件工程基础团队第二次作业(团队项目-需求分析&系统设计)成绩汇总

一.作业题目 团队第二次作业:需求分析&系统设计 二.具体要求 1.作业任务 任务一:组长组织项目组开展需求调研工作(可采取需求调查.问卷.分析已有软件.网上资料等方法).概要设计.详细设计. ...

- Java面试题-基础篇二(干货)

11.是否可以从一个static方法内部发出对非static方法的调用? 不可以.因为非static方法是要与对象关联在一起的,必须创建一个对象后,才可以在该对象上进行方法调用,而static方法调用 ...

- selenium五十行代码自动化爬取淘宝

先看一下代码,真的只是五十行: # coding=gbk from selenium import webdriver import time options = webdriver.ChromeOp ...