第1节 storm日志告警:1、 - 5、日志监控告警业务需求、代码、集群运行、总结

如何解决短信或者邮件频繁发送的问题:每次发送的时候都先查询数据库记录,看一下有没有给这个人发送消息,上一次发送消息的时间是什么时候,如果发送时间间隔小于半个小时,就不要再发了

==========================================

6、日志监控告警系统

6.1需求分析:

实现项目中日志监控的功能,需要做到日志监控实时告警,例如系统中出现任何异常,触发任何的告警规则,都可以实时通过短信或者邮件告知相关系统负责人

6.2 案例:实现实时监控文件变化,通过自定义flume拦截器,实现文件内容添加标识(详见代码)

6.2.1 错误日志生成

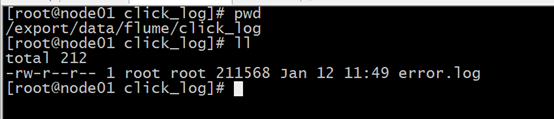

错误日志生成,直接运行loggen.sh这个脚本,就会在

/export/data/flume/click_log 这个目录下生成一个文件叫做error.log的日志文件

参见资料当中的

注意:资料中已经提供好打包运行的jar包以及运行脚本,直接运行脚本即可

6.2.2 创建kafka的对应的topic

bin/kafka-topics.sh --create --partitions 6 --replication-factor 1 --topic log_monitor --zookeeper node01:2181,node02:2181,node03:2181

6.2.3 flume自定义拦截器开发

注意:一定要将flume的自定义拦截器单独放一个项目,单独进行打包,不然与其他的代码会有冲突

功能需求:实现在每条日志前面加上一个appId来做唯一标识

第一步:创建maven项目并导入jar包;

第二步:开发我们自定义拦截器;

第三步:将我们自定义的拦截器打包成jar,放入到flume的lib目录下

注意,这里打包不需要任何的打包插件,将maven项目中的打包插件都注释掉

注意:资料当中已经提供好了的jar包,直接放到flume的lib目录下即可

第四步:配置flume的配置文件app_interceptor.conf

a1.sources = r1

a1.channels = c1

a1.sinks = k1

a1.sources.r1.type = exec

a1.sources.r1.command = tail -F /export/data/flume/click_log/error.log

a1.sources.r1.channels = c1

a1.sources.r1.interceptors = i1

a1.sources.r1.interceptors.i1.type = cn.itcast.flume.interceptor.AppInterceptor$AppInterceptorBuilder

a1.sources.r1.interceptors.i1.appId = 1

a1.channels.c1.type=memory

a1.channels.c1.capacity=10000

a1.channels.c1.transactionCapacity=100

a1.sinks.k1.type = org.apache.flume.sink.kafka.KafkaSink

a1.sinks.k1.topic = log_monitor

a1.sinks.k1.brokerList = kafka01:9092

a1.sinks.k1.requiredAcks = 1

a1.sinks.k1.batchSize = 20

a1.sinks.k1.channel = c1

第五步:启动flume

bin/flume-ng agent -n a1 -c conf -f /export/servers/apache-flume-1.6.0-cdh5.14.0-bin/conf/app_interceptor.conf -Dflume.root.logger=INFO,console

第六步:使用kafka自带的console消费我们生产的信息,查看msgId是否成功带上了

bin/kafka-console-consumer.sh --topic log_monitor --zookeeper node01:2181,node02:2181,node03:2181

6.3 storm消费kafka中的数据,实现日志监控告警

第一步:导入jar包

注意:打包的时候,打包插件一定要使用这个:

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-shade-plugin</artifactId>

<version>1.4</version>

第二步:创建数据库表

第三步:开发我们的定时任务

第四步:开发我们的规则匹配bolt

第五步:开发我们的短信与邮件通知bolt

第六步:开发我们的数据库保存bolt

第七步:程序入口主函数

以上所有,详见代码。

kafkaSpout的更多说明:

=======================================================

课程总结:

1、storm的源码托管地址

2、storm的任务提交的过程 本地创建目录树,zk创建目录树

3、storm与hdfs的整合使用

4、storm的ack机制 要知道是什么玩意儿 消息确认机制

5、storm的定时器以及与mysql的整合 搞定

6、日志监控告警系统

问题分析思路的整个过程

第1节 storm日志告警:1、 - 5、日志监控告警业务需求、代码、集群运行、总结的更多相关文章

- 第3节 storm高级应用:6、定时器任务;7、与jdbc的整合使用;8、与jdbc整合打包集群运行

======================================= 5.storm的定时器以及与mysql的整合使用 功能需求:实现每五秒钟打印出当前时间,并将发送出来的数据存入到mysq ...

- Sentry(v20.12.1) K8S 云原生架构探索,玩转前/后端监控与事件日志大数据分析,高性能+高可用+可扩展+可伸缩集群部署

Sentry 算是目前开源界集错误监控,日志打点上报,事件数据实时分析最好用的软件了,没有之一.将它部署到 Kubernetes,再搭配它本身自带的利用 Clickhouse (大数据实时分析引擎)构 ...

- storm单机运行与集群运行问题

使用trident接口时,storm读取kafka数据会将kafka消费记录保存起来,将消费记录的位置保存在tridentTopology.newStream()的第一个参数里, 如果设置成从头开始消 ...

- 第十节: 利用SQLServer实现Quartz的持久化和双机热备的集群模式 :

背景: 默认情况下,Quartz.Net作业是持久化在内存中的,即 quartz.jobStore.type = "Quartz.Simpl.RAMJobStore, Quartz" ...

- Storm集群安装部署步骤【详细版】

作者: 大圆那些事 | 文章可以转载,请以超链接形式标明文章原始出处和作者信息 网址: http://www.cnblogs.com/panfeng412/archive/2012/11/30/how ...

- [转载] 一共81个,开源大数据处理工具汇总(下),包括日志收集系统/集群管理/RPC等

原文: http://www.36dsj.com/archives/25042 接上一部分:一共81个,开源大数据处理工具汇总(上),第二部分主要收集整理的内容主要有日志收集系统.消息系统.分布式服务 ...

- Storm集群安装详解

storm有两种操作模式: 本地模式和远程模式. 本地模式:你可以在你的本地机器上开发测试你的topology, 一切都在你的本地机器上模拟出来; 远端模式:你提交的topology会在一个集群的机器 ...

- Storm入门教程 第三章Storm集群安装部署步骤、storm开发环境

一. Storm集群组件 Storm集群中包含两类节点:主控节点(Master Node)和工作节点(Work Node).其分别对应的角色如下: 主控节点(Master Node)上运行一个被称为N ...

- Spark Streaming揭秘 Day30 集群模式下SparkStreaming日志分析

Spark Streaming揭秘 Day30 集群模式下SparkStreaming日志分析 今天通过集群运行模式观察.研究和透彻的刨析SparkStreaming的日志和web监控台. Day28 ...

随机推荐

- 【STM32H7教程】第56章 STM32H7的DMA2D应用之刷色块,位图和Alpha混合

完整教程下载地址:http://www.armbbs.cn/forum.php?mod=viewthread&tid=86980 第56章 STM32H7的DMA2D应用之刷色块, ...

- U2000解决备份:服务器不可达、FTP/TFTP/SFTP IP地址与网管地址不一致

只需要将一下几点设置到位这些问题基本解决: 设置->网元软件管理->FTP设置 如果你的U2000服务器和OLT都在一个内网,那么就IP1和IP2就都输入U2000服务器的内网IP,否则按 ...

- EasyUI tree的三种选中状态

EasyUI中tree有三种选中状态,分别是checked(选中).unchecked(未选中).indeterminate(部分选中). 其中indeterminate状态比较特殊,主要表示只有部分 ...

- 微信小程序开发调试阶段不校验请求域名

在微信小程序开发官网上有说明: 在开发者工具的右上角有详情选项,可以勾选不校验合法域名,之后就可以与本地ip进行通信了!

- NAT-T和PAT(IPSec)

¥¥¥¥¥¥¥¥¥¥¥¥¥¥¥¥¥¥¥¥¥¥NAT-T技术介绍¥¥¥¥¥¥¥¥¥¥¥¥¥¥¥¥¥¥¥¥¥¥¥¥¥¥¥ 为什么TCP和UDP不能穿越:TCP和UDP有一个IP头的尾部校验(校验头部和负载 ...

- Java面向对象编程 -2.2

构造方法与匿名对象 现在的程序在使用类的时候一般都按照了如下的步骤进行: 声明并实例化对象,这个时候实例化对象中的属性并没有任何的数据存在,都是其对于数据类型的默认值 需要通过一系列的setter方法 ...

- 一种ui app写法

方法一: $(function(){ // 定义一个对象 var qx={}; qx.ui={}; qx.ui.getleft=function(){ alert('qx.ui.getleft'); ...

- FreeSWITCH 加载模块过程解读

今天来学习FreeSWITCH 加载模块过程. 哪些模块需要编译,是由源码下的 modules.conf 文件决定的. 哪些模块在程序启动时自动加载,是由 freeswitch/conf/autolo ...

- MRCP接口MRCPRecog 简介

功能:开始一个语音识别,一边讲话,一边识别,需要ASR服务器. 原型:MRCPRecog (grammar, options) grammar ---- 语法文件,可以是一个xml文件 options ...

- PAT A1131 Subway Map

dfs,选择最优路径并输出~ 这道题难度非常炸裂,要求完完整整自己推一遍,DFS才算过关!思路:一遍dfs,过程中要维护两个变量,minCnt 中途停靠最少的站.minTransfer需要换成的最少次 ...