ELK 6安装配置 nginx日志收集 kabana汉化

#ELK 6安装配置 nginx日志收集 kabana汉化

#环境 centos 7.4 ,ELK 6 ,单节点

#服务端

Logstash 收集,过滤

Elasticsearch 存储,索引日志

Kibana 可视化

#客户端

filebeat 监控、转发,作为agentfilebeat-->Logstash-->Elasticsearch-->Kibana

#基本配置

#时间同步

#关闭selinux

#内核优化

#防火墙端口

#内核

echo '

* hard nofile 65536

* soft nofile 65536

* soft nproc 65536

* hard nproc 65536

'>>/etc/security/limit.conf

echo '

vm.max_map_count = 262144

net.core.somaxconn=65535

net.ipv4.ip_forward = 1

'>>/etc/sysctl.conf

sysctl -p

#防火墙

firewall-cmd --permanent --add-port={9200/tcp,9300/tcp,5044/tcp,5601/tcp}

firewall-cmd --reload

frewall-cmd --list-all

#安装

#可以下载tar或者rpm包安装

官网 https://www.elastic.co/downloads

中文 https://www.elastic.co/cn/products

#下载rpm包

https://artifacts.elastic.co/downloads/elasticsearch/elasticsearch-6.2.2.rpm

https://artifacts.elastic.co/downloads/logstash/logstash-6.2.2.rpm

https://artifacts.elastic.co/downloads/kibana/kibana-6.2.2-x86_64.rpm

https://artifacts.elastic.co/downloads/beats/filebeat/filebeat-6.2.2-x86_64.rpm

#安装JDK, elasticsearch需要java环境

yum install java-1.8.0-openjdk -y

#配置yum源

rpm --import https://artifacts.elastic.co/GPG-KEY-elasticsearch

echo '

[elk-6]

name=elk-6

baseurl=https://artifacts.elastic.co/packages/6.x/yum

gpgcheck=1

gpgkey=https://artifacts.elastic.co/GPG-KEY-elasticsearch

enabled=1

'>/etc/yum.repos.d/elk.repo

#安装

yum install elasticsearch -y

yum install logstash -y

yum install kibana -y

yum install filebeat -y

#elasticsearch配置

#查看配置

rpm -qc elasticsearch

grep -v '^#' /etc/elasticsearch/elasticsearch.yml

cp /etc/elasticsearch/elasticsearch.yml{,.bak}

#更改配置

echo '

path.data: /var/lib/elasticsearch

path.logs: /var/log/elasticsearch

cluster.name: ELK

node.name: elk.novalocal

network.host: 0.0.0.0

http.port: 9200

discovery.zen.ping.unicast.hosts: ["172.16.50.32:9300"]

discovery.zen.minimum_master_nodes: 1

'>/etc/elasticsearch/elasticsearch.yml

#修改配置后

systemctl daemon-reload

#启动

systemctl enable elasticsearch

systemctl restart elasticsearch

#check

systemctl status elasticsearch

netstat -nltp | grep java

curl -X GET http://localhost:9200

#logstash配置

- input :数据输入

- filter:数据转化,过滤,分析

- output:数据输出

#查看配置

rpm -qc logstash

egrep -v '^#|^$' /etc/logstash/logstash.yml

cp /etc/logstash/logstash.yml{,.bak}

echo 'path.config: /etc/logstash/conf.d'>>/etc/logstash/logstash.yml

#添加一个日志处理文件

#filebeat->logstash->elasticsearch

echo '

input {

#收集本地log#

file {

type => "logtest"

path => "/var/log/logtest.txt"

start_position => "beginning"

}

#filebeat客户端#

beats {

port => 5044

}

}

#筛选

#filter { }

output {

#标准输出,调试使用#

stdout {

codec => rubydebug { }

}

# 输出到es#

elasticsearch {

hosts => ["http://172.16.50.32:9200"]

index => "%{type}-%{+YYYY.MM.dd}"

}

}

'>/etc/logstash/conf.d/logstash-01.conf

#调试(可选)

#检测配置

/usr/share/logstash/bin/logstash -f /etc/logstash/conf.d/logstash-01.conf --config.test_and_exit

#生成测试log

echo $(date +"%F-%T") log-test >>/var/log/logtest.txt

#启动,查看生成日志

/usr/share/logstash/bin/logstash -f /etc/logstash/conf.d/logstash-01.conf

#启动

systemctl enable logstash

systemctl restart logstash

#check

sleep 20

systemctl status logstash

netstat -nltp | grep java

#kibana配置

#配置

rpm -qc kibana

cp /etc/kibana/kibana.yml{,.bak}

grep -v '^#' /etc/kibana/kibana.yml.bak

echo '

server.port: 5601

server.host: "0.0.0.0"

# ES的url的一个ES节点#

#elasticsearch.url: "http://172.16.50.32:9200"

elasticsearch.url: "http://localhost:9200"

kibana.index: ".kibana"

#kibana.defaultAppId: "home"

'>/etc/kibana/kibana.yml

#启动

systemctl enable kibana

systemctl restart kibana

#check

systemctl status kibana

netstat -nltp | grep node

#防火墙对外开放tcp/5601

#浏览器访问 ip:5601

#汉化kibana (可选)

[[ -f /usr/bin/git ]] || { echo 'install git';yum install -y git &>/dev/null; }

git clone https://github.com/anbai-inc/Kibana_Hanization.git

cd Kibana_Hanization

python main.py /usr/share/kibana

#重启kibana

systemctl restart kibana

#浏览器访问kabana设置

首次打开,需要添加索引模式

#Management管理-->Index Patterns索引模式-->Create index pattern创建索引模式

填写*(索引名)-->Next step-->选择如@timestamp-->Create index pattern ,完成

#Index pattern 下面填写logstash配置的名称如type ⇒ "logs"填写logs

#filebeat配置 (轻量客户端)

yum install -y filebeat

#查看配置

rpm -qc filebeat

egrep -v '#|^$' /etc/filebeat/filebeat.yml

cp /etc/filebeat/filebeat.yml{,.bak}

#收集nginx日志试列

#安装nginx

rpm -Uvh http://nginx.org/packages/centos/7/noarch/RPMS/nginx-release-centos-7-0.el7.ngx.noarch.rpm

yum install -y nginx

systemctl start nginx

curl localhost

#查看nginx日志

tail /var/log/nginx/access.log

#配置filebeat收集nginx日志

echo '#filebeat#

filebeat.prospectors:

#nginx

- input_type: log

enable: yes

#tags: nginx-access

paths:

- /var/log/nginx/access.log

exclude_lines: ["^$"]

fields:

type: "nginx-access"

fields_under_root: true

output.logstash:

hosts: ["localhost:5044"]

#hosts: ["172.16.50.32:5044"]

#index: filebeat

'>/etc/filebeat/filebeat.yml

#启动

systemctl enable filebeat

systemctl restart filebeat

systemctl status filebeat

#在kibana查看日志

#logstash使用grok过滤nginx日志

nginx日志有main和log_json两种,默认为main普通文本格式

ELK存储为json格式,文本格式华,拆分出如ip地址、访问agent等,便于后续使用

#nginx默认日志格式

log_format main '$remote_addr - $remote_user [$time_local] "$request" '

'$status $body_bytes_sent "$http_referer" '

'"$http_user_agent" "$http_x_forwarded_for"';

#curl localhost生成日志格式如下

#127.0.0.1 - - [22/Mar/2018:18:37:37 +0800] "GET / HTTP/1.1" 200 612 "-" "curl/7.29.0" "-"

#logstash配置,使用grok过滤nginx日志

grok使用的正则表达式在grok-patterns文件

可以引用或添加自定义规则

Grok=$(find / -name grok-patterns)

echo $Grok

#/usr/share/logstash/vendor/bundle/jruby/2.3.0/gems/logstash-patterns-core-4.1.2/patterns/grok-patterns

#创建nginx正则表达式(引用grok正则)

echo '#nginx-access

WZ ([^ ]*)

NGINXACCESS %{IP:remote_ip} \- \- \[%{HTTPDATE:timestamp}\] "%{WORD:method} %{WZ:request} HTTP/%{NUMBER:httpversion}" %{NUMBER:status} %{NUMBER:bytes} %{QS:referer} %{QS:agent} %{QS:xforward}

'>/etc/logstash/conf.d/nginx-access

#重新生成logstash配置文件

echo '

input {

#收集本地log#

file {

type => "logtest"

path => "/var/log/logtest.txt"

start_position => "beginning"

}

#filebeat客户端#

beats {

port => 5044

}

}

# #筛选

filter {

# 如果是nginx访问日志

if ( [type] == "nginx-access" ) {

#按字段切割

grok {

patterns_dir=>"/etc/logstash/conf.d/nginx-access"

match => { "message" => "%{NGINXACCESS}" }

}

# 时间格式转换

date {

match => [ "timestamp", "dd/MMM/YYYY:HH:mm:ss Z" ]

}

# 删除不需要的字段

mutate {

remove_field => [ "offset", "@version", "beat", "input_type", "tags","id"]

}

}

}

output {

#标准输出,调试使用#

stdout {

codec => rubydebug { }

}

# 输出到es#

elasticsearch {

hosts => ["http://172.16.50.32:9200"]

index => "%{type}-%{+YYYY.MM.dd}"

}

}

'>/etc/logstash/conf.d/logstash-01.conf

#检测配置

/usr/share/logstash/bin/logstash -t -f /etc/logstash/conf.d/logstash-01.conf

#调试logstash

#关闭

systemctl stop logstash

#在终端启动查看

/usr/share/logstash/bin/logstash -f /etc/logstash/conf.d/logstash-01.conf

#访问nginx产生日志,在elasticsearch-head或者kabana查看nginx日志

logstash配置文件可拆分为多个,按input、filter、output类型+序列号指定优先级

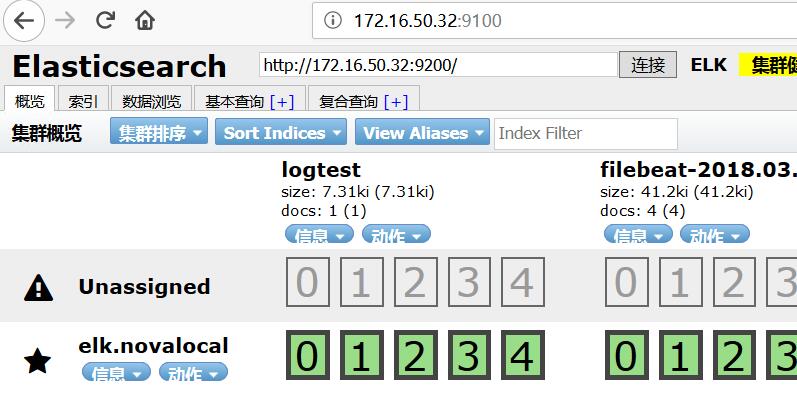

#elasticsearch调试工具(可选)

elasticsearch安装head插件

#安装NodeJS (epel源)

yum install -y nodejs

#安装npm

npm install -g cnpm --registry=https://registry.npm.taobao.org

#使用npm安装grunt

npm install -g grunt

#安装elasticsearch-head

#查看https://github.com/mobz/elasticsearch-head

mkdir /opt/head

cd /opt/head

git clone git://github.com/mobz/elasticsearch-head.git

cd elasticsearch-head

npm install

#启动

npm run start &

#配置elasticsearch访问

echo '#elasticsearch-head

http.cors.enabled: true

http.cors.allow-origin: "*"

'>>/etc/elasticsearch/elasticsearch.yml

#重启elasticsearch

systemctl restart elasticsearch

#浏览器访问9100端口

http://ip:9100/

#出现“未连接”,请修改localhost为ip地址

##################

ELK 6安装配置 nginx日志收集 kabana汉化的更多相关文章

- 转: 基于elk 实现nginx日志收集与数据分析

原文链接:https://www.cnblogs.com/wenchengxiaopenyou/p/9034213.html 一.背景 前端web服务器为nginx,采用filebeat + logs ...

- 基于elk 实现nginx日志收集与数据分析。

一.背景 前端web服务器为nginx,采用filebeat + logstash + elasticsearch + granfa 进行数据采集与展示,对客户端ip进行地域统计,监控服务器响应时间等 ...

- (转)windows 下安装配置 Nginx 详解

windows 下安装配置 Nginx 详解 本文转自https://blog.csdn.net/kingscoming/article/details/79042874 nginx功能之一可以启动一 ...

- 【Nginx】如何配置Nginx日志?这是最全面的一篇了!!

写在前面 日志对于统计排错来说非常有利的.本文总结了 Nginx 日志相关的配置如 access_log. log_format.open_log_file_cache. log_not_found. ...

- Centos7安装部署搭建gitlab平台、汉化

Centos7安装部署搭建gitlab平台.汉化 安装环境要求:内存不要小于4G,否则后期web界面可能会报错 一.准备工作 1.1 查看系统版本 首先查询系统版本,下载Gitlab的对应版本 [ro ...

- elk+redis分布式分析nginx日志

一.elk套件介绍 ELK 由 ElasticSearch . Logstash 和 Kiabana 三个开源工具组成.官方网站: https://www.elastic.co/products El ...

- elk集成安装配置

三台虚拟机 193,194,195 本机 78 流程 pythonserver -> nginx -> logstash_shipper->kafka->logstash_in ...

- ELK整合Filebeat监控nginx日志

ELK 日志分析 1. 为什么用到 ELK 一般我们需要进行日志分析场景:直接在日志文件中 grep. awk 就可以获得自己想要的信息.但在规模较大的场景中,此方法效率低下,面临问题包括日志量太大如 ...

- 利用ELK构建一个小型的日志收集平台

利用ELK构建一个小型日志收集平台 伴随着应用以及集群的扩展,查看日志的方式总是不方便,我们希望可以有一个便于我们查询及提醒功能的平台:那么首先需要剖析有几步呢? 格式定义 --> 日志收集 - ...

随机推荐

- Hibernate(十六):Hibernate二级缓存

Hibernate缓存 缓存(Cache):计算机领域非常通用的概念.它介于应用程序和永久性数据存储源(如磁盘上的文件或者数据库)之间,起作用是降低应用程序直接读取永久性数据存储源的频率,从而提高应用 ...

- 类似吸顶功能解决ios不能实时监听onscroll的触发问题

问题:近期项目需要一个类似西东功能,当页面向上滚动160px后div固定在顶部 解决方法:首先,想到的是window.onscroll方法 .fixed{position:fixed;-webkit- ...

- Vue 项目代理设置的优化

Vue 项目代理设置的优化 Vue 类的项目开发中项目结构基本都是类似于 Vue-cli 生成的方式, 这种方式开发中,最常用到的模式是开启代理进行 mock 调试或远程调试, 也就是使用了 Vue- ...

- java处理大文本方案

转载自:http://langgufu.iteye.com/blog/2107023 java处理大文件,一般用BufferedReader,BufferedInputStream这类带缓冲的Io类, ...

- Python默认版本切换

Mac上自带python2.7 版本,但是我又下了一个3.7版本(下载的版本默认安装在 /Library/Frameworks/Python.framework/Versions/3.7/bin/py ...

- Junit简单配置

Junit简单配置的步骤如下: 1.在WEB-INF目录下的lib里面放一个junit包,我用的是junit-4.9.jar: 2.选定要测试的类,右键单击该类,新建一个Junit Test Case ...

- [Codeforces 505C]Mr. Kitayuta, the Treasure Hunter

Description The Shuseki Islands are an archipelago of 30001 small islands in the Yutampo Sea. The is ...

- 2015 多校联赛 ——HDU5350(huffman)

Problem Description MZL is a mysterious mathematician, and he proposed a mysterious function at his ...

- bzoj1853[Scoi2010]幸运数字 容斥

1853: [Scoi2010]幸运数字 Time Limit: 2 Sec Memory Limit: 64 MBSubmit: 3027 Solved: 1128[Submit][Status ...

- bzoj1433

1433: [ZJOI2009]假期的宿舍 Time Limit: 10 Sec Memory Limit: 162 MBSubmit: 3371 Solved: 1425[Submit][Sta ...