Gluon sgd

from mxnet import nd,autograd,init,gluon

from mxnet.gluon import data as gdata,loss as gloss,nn num_inputs = 2

num_examples = 1000

true_w = [2,-3.4]

true_b = 4.2 features = nd.random.normal(scale=1,shape=(num_examples,num_inputs))

labels = true_w[0]*features[:,0] + true_w[1]*features[:,1] + true_b

labels += nd.random.normal(scale=0.01,shape=labels.shape) # 造小批量数据集

dataset = gdata.ArrayDataset(features,labels)

batch_size = 10

data_iter = gdata.DataLoader(dataset,batch_size,shuffle=True) # 定义网络

net = nn.Sequential()

net.add(nn.Dense(1)) net.initialize(init.Normal(sigma=0)) # 损失函数

loss = gloss.L2Loss() # 优化算法

trainer = gluon.Trainer(net.collect_params(),'sgd',{'learning_rate':0.01}) num_epochs = 3

for epoch in range(1, num_epochs + 1):

for X, y in data_iter:

print(X)

print(y)

with autograd.record():

l = loss(net(X), y)

print(l)

l.backward()

trainer.step(batch_size)

l = loss(net(features), labels)

print('epoch %d, loss: %f' % (epoch, l.mean().asnumpy()))

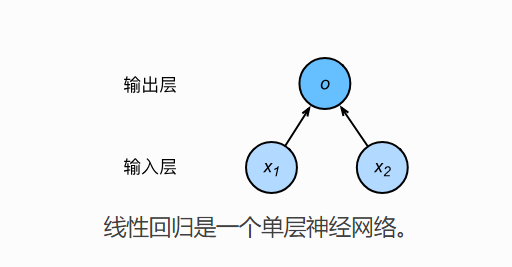

从最简单的线性回归来说,小批量随机梯度下降的时候,X,y 从迭代器中取出,也是bach_size大小的数据集,那么网络的计算,同样也是小批量的。

即代码 l = loss(net(X),y) 包含了,小批量数据集,每一个数据丢到网络中,计算出返回值以后,和真实值得损失。

Gluon sgd的更多相关文章

- 使用MxNet新接口Gluon提供的预训练模型进行微调

1. 导入各种包 from mxnet import gluon import mxnet as mx from mxnet.gluon import nn from mxnet import nda ...

- MXNet的新接口Gluon

为什么要开发Gluon的接口 在MXNet中我们可以通过Sybmol模块来定义神经网络,并组通过Module模块提供的一些上层API来简化整个训练过程.那MXNet为什么还要重新开发一套Python的 ...

- win10 + gluon + GPU

1. 下载教程 可以用浏览器下载zip格式并解压,在解压目录文件资源管理器的地址栏输入cmd进入命令行模式. 也可以 git pull https://github.com/mli/gluon-tut ...

- 机器学习笔记(6):多类逻辑回归-使用gluon

上一篇演示了纯手动添加隐藏层,这次使用gluon让代码更精减,代码来自:https://zh.gluon.ai/chapter_supervised-learning/mlp-gluon.html f ...

- 机器学习笔记(2):线性回归-使用gluon

代码来自:https://zh.gluon.ai/chapter_supervised-learning/linear-regression-gluon.html from mxnet import ...

- MXNET:权重衰减-gluon实现

构建数据集 # -*- coding: utf-8 -*- from mxnet import init from mxnet import ndarray as nd from mxnet.gluo ...

- dropout——gluon

https://blog.csdn.net/lizzy05/article/details/80162060 from mxnet import nd def dropout(X, drop_prob ...

- mxnet(gluon) 实现DQN简单小例子

参考文献 莫凡系列课程视频 增强学习入门之Q-Learning 关于增强学习的基本知识可以参考第二个链接,讲的挺有意思的.DQN的东西可以看第一个链接相关视频.课程中实现了Tensorflow和pyt ...

- Gluon 实现 dropout 丢弃法

多层感知机中: hi 以 p 的概率被丢弃,以 1-p 的概率被拉伸,除以 1 - p import mxnet as mx import sys import os import time imp ...

随机推荐

- group by 语句

user E_book go 这样的程序会出错,因为play没有使用sum,所以要分组. group by play 有函数的和没有函数的表一起使用要用 GROUP BY .AVG 求平均值,只能与数 ...

- Java - 线程封闭

保证并发安全性的方式有三: 不共享.不可变.同步 前两种方式相对第三种要简单一些. 这一篇不说语言特性和API提供的相关同步机制,主要记录一下关于共享的一些思考. 共享(shared),可以简单地认为 ...

- java 并发(五)---AbstractQueuedSynchronizer(2)

文章部分代码和照片来自参考资料 问题 : ConditionObject 的 await 和 signal 方法是如何实现的 ConditonObject ConditionObjec ...

- Nginx配置整理

不论是本地开发,还是远程到 Server 开发,还是给提供 demo 给人看效果,我们时常需要对 Nginx 做配置,Nginx 的配置项相当多,如果考虑性能配置起来会比较麻烦.不过,我们往往只是需要 ...

- ThreadLocal介绍以及源码分析

ThreadLocal 线程主变量 前面部分引用其他优秀博客,后面源码自己分析的,如有冒犯请私聊我. 用Java语言开发的同学对 ThreadLocal 应该都不会陌生,这个类的使用场景很多,特别是在 ...

- 使用 typeof 来检测对象是否undefined

需求 判断是否为undefined 解决 使用 typeof 来检测对象是否已定义: if (typeof Obj !== "undefined" && Obj ! ...

- 由ArrayList来深入理解Java中的fail-fast机制

1. fail-fast简介“快速失败”也就是fail-fast,它是Java集合的一种错误检测机制.某个线程在对collection进行迭代时,不允许其他线程对该collection进行结构上的修改 ...

- css之子元素获取(未定义高度)父元素的高度

你可能碰到过这样的需求,一个高度不固定的区域(内容由用户创造),当鼠标经过该区域或者其神马操作时,需要出现一个与该区域一样大的模版: 我们用一个span来处理这个mask.由于 .sample-1 和 ...

- ul li各属性设置

1. ul li删除前面的黑点:style=“list-style:none;” <ul style=“list-style:none;”> <li></li> & ...

- 终止ajax请求

在做搜索功能时,文本框输入文本就得请求一次数据,如果上一次的请求还没回又请求了就导致数据错误和无用的数据请求. 我们需要输入文本时候判断上一次的ajax请求是否完毕,若还没完毕就终止本次请求. 对于j ...