python爬虫:抓取下载视频文件,合并ts文件为完整视频

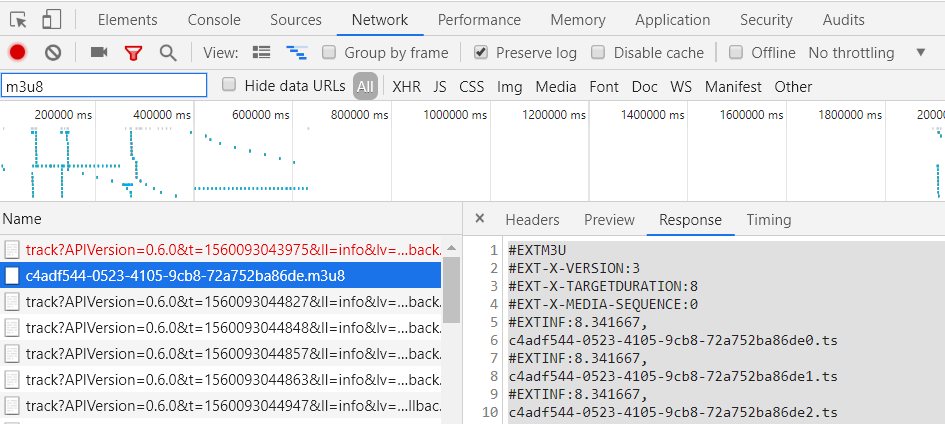

1.获取m3u8文件

2.代码

"""

@author :Eric-chen

@contact :sygcrjgx@163.com

@time :2019/6/16 15:32

@desc :

"""

import requests

import threading

import datetime

import os count = 0; def Handler(start, end, url, filename):

headers = {'Origin': 'https://xdzy.andisk.com','Referer':'https://xdzy.andisk.com/andisk/app/videoviewFrame.html',

'User-Agent':'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/74.0.3729.169 Safari/537.36'} for i in filename[start:end]:

global count r = requests.get("https://bk.andisk.com/data/3048aa1f-b2fb-4fb7-b452-3ebc96c76374/res/" + i.replace("\n", ""),

headers=headers,

stream=True) with open("C:\\Users\\chen\\Desktop\\downloadfiles/" + i.replace("\n", ""), "wb") as code:

code.write(r.content)

count = count + 1

print("下载进度:%.2f" % (count / len(filename))) def download_file(url, num_thread=100):

cwd = os.getcwd() # 获取当前目录即dir目录下

print("------------------------current working directory------------------" + cwd)

f = open('index.m3u8', 'r', encoding='utf-8')

text_list = f.readlines()

s_list = []

for i in text_list:

if i.find('#EX') == -1:

s_list.append(i) f.close()

file_size = len(s_list) # 启动多线程写文件

part = file_size // num_thread # 如果不能整除,最后一块应该多几个字节

for i in range(num_thread):

start = part * i

if i == num_thread - 1: # 最后一块

end = file_size

else:

end = start + part t = threading.Thread(target=Handler, kwargs={'start': start, 'end': end, 'url': url, 'filename': s_list})

t.setDaemon(True)

t.start() # 等待所有线程下载完成

main_thread = threading.current_thread()

for t in threading.enumerate():

if t is main_thread:

continue

t.join() def before_merge():

cwd = os.getcwd() # 获取当前目录即dir目录下

print("------------------------current working directory------------------" + cwd)

f = open('index.m3u8', 'r', encoding='utf-8')

text_list = f.readlines()

files = []

for i in text_list:

if i.find('#EX') == -1:

files.append(i)

f.close()

tmp = []

for file in files[0:568]:

tmp.append(file.replace("\n", ""))

# 合并ts文件

# os.chdir("ts/")

shell_str = '+'.join(tmp)

# print(shell_str)

shell_str = 'copy /b ' + shell_str + ' 5.mp4'+'\n'+'del *.ts'

return shell_str

def wite_to_file(cmdString):

cwd = os.getcwd() # 获取当前目录即dir目录下

print("------------------------current working directory------------------"+cwd)

f = open("combined.cmd", 'w')

f.write(cmdString)

f.close() if __name__ == '__main__':

url = "https://bk.andisk.com/data/3048aa1f-b2fb-4fb7-b452-3ebc96c76374/res/";

# 下载:开始下载

start = datetime.datetime.now().replace(microsecond=0)

download_file(url)

end = datetime.datetime.now().replace(microsecond=0)

print(end - start)

# 结束下载

#合并小文件

cmd=before_merge();

#把合并命令写到文件中

wite_to_file(cmd);

3.把bat文件复制到下载的文件路径,执行

python爬虫:抓取下载视频文件,合并ts文件为完整视频的更多相关文章

- python 爬虫抓取心得

quanwei9958 转自 python 爬虫抓取心得分享 urllib.quote('要编码的字符串') 如果你要在url请求里面放入中文,对相应的中文进行编码的话,可以用: urllib.quo ...

- Python爬虫抓取东方财富网股票数据并实现MySQL数据库存储

Python爬虫可以说是好玩又好用了.现想利用Python爬取网页股票数据保存到本地csv数据文件中,同时想把股票数据保存到MySQL数据库中.需求有了,剩下的就是实现了. 在开始之前,保证已经安装好 ...

- Python爬虫----抓取豆瓣电影Top250

有了上次利用python爬虫抓取糗事百科的经验,这次自己动手写了个爬虫抓取豆瓣电影Top250的简要信息. 1.观察url 首先观察一下网址的结构 http://movie.douban.com/to ...

- python爬虫抓取哈尔滨天气信息(静态爬虫)

python 爬虫 爬取哈尔滨天气信息 - http://www.weather.com.cn/weather/101050101.shtml 环境: windows7 python3.4(pip i ...

- Python爬虫抓取某音乐网站MP3(下载歌曲、存入Sqlite)

最近右胳膊受伤,打了石膏在家休息.为了实现之前的想法,就用左手打字.写代码,查资料完成了这个资源小爬虫.网页爬虫, 最主要的是协议分析(必须要弄清楚自己的目的),另外就是要考虑对爬取的数据归类,存储. ...

- Python爬虫抓取糗百的图片,并存储在本地文件夹

思路: 1.观察网页,找到img标签 2.通过requests和BS库来提取网页中的img标签 3.抓取img标签后,再把里面的src给提取出来,接下来就可以下载图片了 4.通过urllib的urll ...

- Python 爬虫-抓取中小企业股份转让系统公司公告的链接并下载

系统运行系统:MAC 用到的python库:selenium.phantomjs等 由于中小企业股份转让系统网页使用了javasvript,无法用传统的requests.BeautifulSoup库获 ...

- Python爬虫 -- 抓取电影天堂8分以上电影

看了几天的python语法,还是应该写个东西练练手.刚好假期里面看电影,找不到很好的影片,于是有个想法,何不搞个爬虫把电影天堂里面8分以上的电影爬出来.做完花了两三个小时,撸了这么一个程序.反正蛮简单 ...

- Python爬虫抓取 python tutorial中文版,保存为word

看到了中文版的python tutorial,发现是网页版的,刚好最近在学习爬虫,想着不如抓取到本地 首先是网页的内容 查看网页源码后发现可以使用BeautifulSoup来获取文档的标题和内容,并保 ...

- python爬虫-抓取acg12动漫壁纸排行设置为桌面壁纸

ACG-wallpaper 初学python,之前想抓取P站的一些图片来着,然后发现acg12这里有专门的壁纸榜单,就写了个抓取壁纸作为mac桌面壁纸玩玩. 功能:抓取acg12壁纸榜单的动漫壁纸,并 ...

随机推荐

- Linux安装mysql5.6.33

1.下载mysql安装包: 下载地址:http://dev.mysql.com/downloads/mysql/5.6.html#downloads 下载版本:我这里选择的5.6.33,通用版,lin ...

- JVM虚拟机运行机制

JVM虚拟机运行机制 什么是JVM?虚拟机是物理机器的软件实现.Java是用在VM上运行的WORA(Write Once Run Anywhere)概念而开发的.编译器将Java文件编译为Java . ...

- 20180805-Java ByteArrayInputStream类

ByteArrayInputStream bArray = new ByteArrayInputStream(byte [] a); ByteArrayInputStream bArray = new ...

- pl/sql中return和exit区别

经测试: 1.exit只能用于循环中,并且退出循环往下执行: 2.return可用于循环或非循环,并且退出整个程序模块不往下执行. declare i number :=1; j number :=1 ...

- 面向对象编程思想(OOP)(转发)

本文我将从面向对象编程思想是如何解决软件开发中各种疑难问题的角度,来讲述我们面向对象编程思想的理解,梳理面向对象四大基本特性.七大设计原则和23种设计模式之间的关系. 软件开发中疑难问题: 软件复杂庞 ...

- 生产环境下,oracle不同用户间的数据迁移。第一部分

:任务名称:生产环境下schema ELON数据迁移至schema TIAN ######################################## 测试一:测试参数 数据泵数据导出:exp ...

- 【OPCAutomation】 使用OPCAutomation实现对OPC数据的访问

折腾了一段时间研究OPC,理清了下位机.OPCServer 和OPCClient的关系和通信模型,终于能够来写一篇相关的博客了. 我们使用西门子的 S7 200 SMART作为下位机端,通过3G路由器 ...

- 002-Visio绘制时序图

一.概述 1.1.什么时候使用 当编码的时候,知道有的用例的业务逻辑按照比较确定的时间先后顺序进行展开.这时候,我们就需要知道我们设计的系统中的不同类之间传递消息(可以认为是不同对象函数间的调用)要按 ...

- CentOS 7.0 开端口

>>> CentOS 7.0默认使用的是firewall作为防火墙,使用iptables必须重新设置一下1.直接关闭防火墙systemctl stop firewalld.serv ...

- Harbor - 私有企业级 Docker 镜像仓库

GitHub 地址 容器镜像服务 Docker镜像的基本使用 Docker:企业级私有镜像仓库Harbor使用 Harbor 是基于 Docker Registry 的企业级镜像仓库,安装后的使用方法 ...