deep_learning_LSTM长短期记忆神经网络处理Mnist数据集

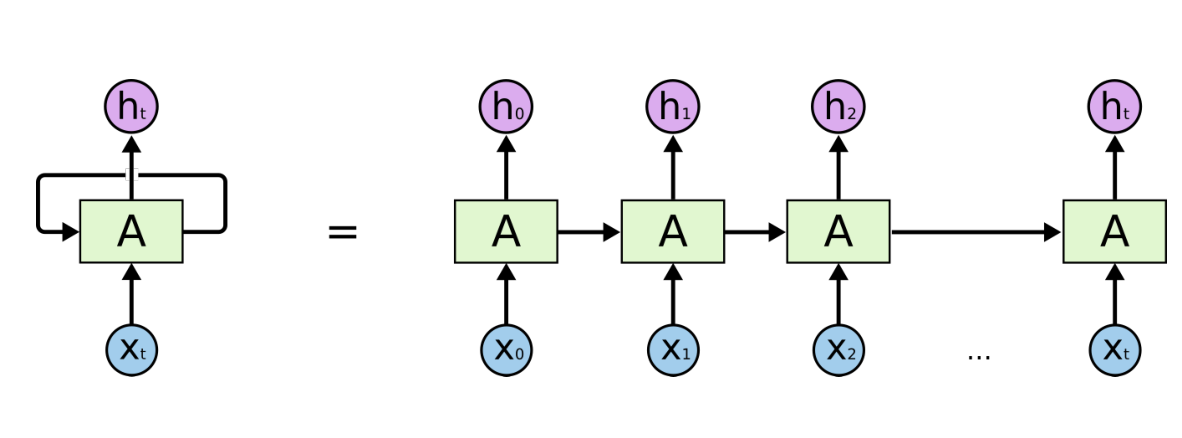

1、RNN(Recurrent Neural Network)循环神经网络模型

详见RNN循环神经网络:https://www.cnblogs.com/pinard/p/6509630.html

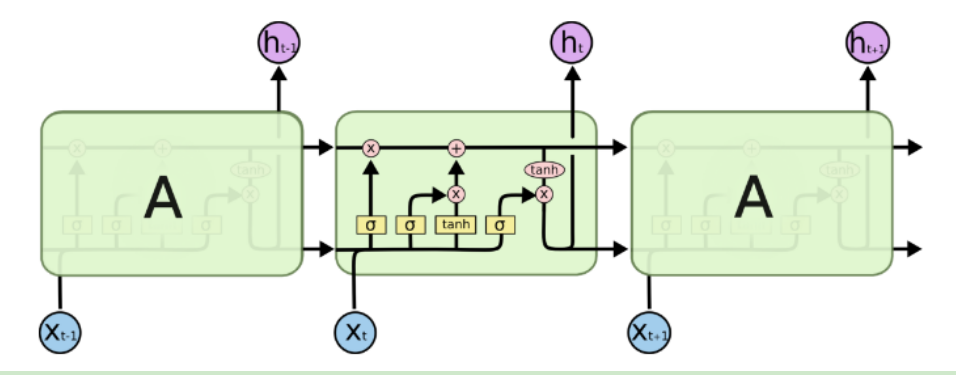

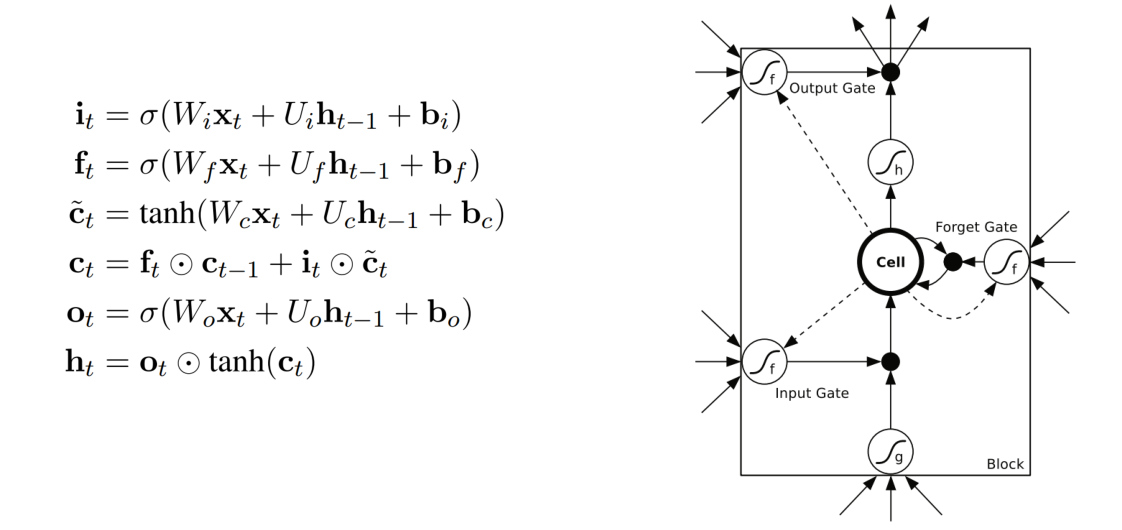

2、LSTM(Long Short Term Memory)长短期记忆神经网络模型

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

|

import tensorflow as tffrom tensorflow.examples.tutorials.mnist import input_datafrom tensorflow.contrib import rnn# 载入数据集mnist = input_data.read_data_sets("MNIST_data/", one_hot=True)# 输入图片是28*28n_inputs = 28 # 输入一行,一行有28个数据(28个像素点),即输入序列长度为28max_time = 28 # 一共28行lstm_size = 100 # 隐层单元n_classes = 10 # 10个分类batch_size = 50 # 每批次50个样本n_batch = mnist.train.num_examples // batch_size # 计算一共有多少个批次# 这里的none表示第一个维度可以是任意的长度x = tf.placeholder(tf.float32, [None, 784])# 正确的标签y = tf.placeholder(tf.float32, [None, 10])# 初始化权值weights = tf.Variable(tf.truncated_normal([lstm_size, n_classes], stddev=0.1))# 初始化偏置值biases = tf.Variable(tf.constant(0.1, shape=[n_classes]))# 定义RNN网络def RNN(X, weights, biases): inputs = tf.reshape(X, [-1, max_time, n_inputs]) # 定义LSTM基本CELL lstm_cell = rnn.BasicLSTMCell(lstm_size) # final_state[0]是cell state # final_state[1]是hidden_state outputs, final_state = tf.nn.dynamic_rnn(lstm_cell, inputs, dtype=tf.float32) results = tf.nn.softmax(tf.matmul(final_state[1], weights) + biases) return results# 计算RNN的返回结果prediction = RNN(x, weights, biases)# 损失函数cross_entropy = tf.reduce_mean(tf.nn.softmax_cross_entropy_with_logits(logits=prediction, labels=y))# 使用AdamOptimizer进行优化train_step = tf.train.AdamOptimizer(1e-4).minimize(cross_entropy)# 结果存放在一个布尔型列表中correct_prediction = tf.equal(tf.argmax(y, 1), tf.argmax(prediction, 1)) # argmax返回一维张量中最大的值所在的位置# 求准确率accuracy = tf.reduce_mean(tf.cast(correct_prediction, tf.float32)) # 把correct_prediction变为float32类型# 初始化init = tf.global_variables_initializer()with tf.Session() as sess: sess.run(init) for epoch in range(21): for batch in range(n_batch): batch_xs, batch_ys = mnist.train.next_batch(batch_size) sess.run(train_step, feed_dict={x: batch_xs, y: batch_ys}) acc = sess.run(accuracy, feed_dict={x: mnist.test.images, y: mnist.test.labels}) print("Iter " + str(epoch) + ", Testing Accuracy= " + str(acc)) |

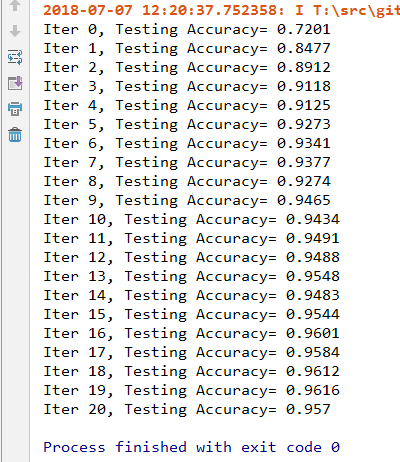

结果为:

deep_learning_LSTM长短期记忆神经网络处理Mnist数据集的更多相关文章

- TensorFlow——LSTM长短期记忆神经网络处理Mnist数据集

1.RNN(Recurrent Neural Network)循环神经网络模型 详见RNN循环神经网络:https://www.cnblogs.com/pinard/p/6509630.html 2. ...

- Python实现bp神经网络识别MNIST数据集

title: "Python实现bp神经网络识别MNIST数据集" date: 2018-06-18T14:01:49+08:00 tags: [""] cat ...

- TensorFlow——CNN卷积神经网络处理Mnist数据集

CNN卷积神经网络处理Mnist数据集 CNN模型结构: 输入层:Mnist数据集(28*28) 第一层卷积:感受视野5*5,步长为1,卷积核:32个 第一层池化:池化视野2*2,步长为2 第二层卷积 ...

- TensorFlow初探之简单神经网络训练mnist数据集(TensorFlow2.0代码)

from __future__ import print_function from tensorflow.examples.tutorials.mnist import input_data #加载 ...

- Tensorflow学习教程------普通神经网络对mnist数据集分类

首先是不含隐层的神经网络, 输入层是784个神经元 输出层是10个神经元 代码如下 #coding:utf-8 import tensorflow as tf from tensorflow.exam ...

- 使用一层神经网络训练mnist数据集

import numpy as np import tensorflow as tf from tensorflow.examples.tutorials.mnist import input_dat ...

- mxnet卷积神经网络训练MNIST数据集测试

mxnet框架下超全手写字体识别—从数据预处理到网络的训练—模型及日志的保存 import numpy as np import mxnet as mx import logging logging. ...

- Tensorflow学习教程------利用卷积神经网络对mnist数据集进行分类_利用训练好的模型进行分类

#coding:utf-8 import tensorflow as tf from PIL import Image,ImageFilter from tensorflow.examples.tut ...

- 递归神经网络之理解长短期记忆网络(LSTM NetWorks)(转载)

递归神经网络 人类并不是每时每刻都从头开始思考.正如你阅读这篇文章的时候,你是在理解前面词语的基础上来理解每个词.你不会丢弃所有已知的信息而从头开始思考.你的思想具有持续性. 传统的神经网络不能做到这 ...

随机推荐

- JavaScript简易事件触发合集

1.<input id="billing" type="text" placeholder="123" onkeyup="t ...

- Tomcat服务org.springframework.web.util.NestedServletException: Handler processing failed; nested exception is java.lang.OutOfMemoryError: Java heap space

一个运行了很久的项目,最近忽然报错:OOM( java.lang.OutOfMemoryError: Java heap space),异常如下 org.springframework.web.uti ...

- HTTP 请求中的 Form Data 与 Request Payload 的区别

HTTP 请求中的 Form Data 与 Request Payload 的区别 前端开发中经常会用到 AJAX 发送异步请求,对于 POST 类型的请求会附带请求数据.而常用的两种传参方式为:Fo ...

- caoz的梦呓:所谓打破信息不对称,其实是一种幻觉

猫宁!!! 参考链接:https://mp.weixin.qq.com/s/UzSyrhe0Vck7ItN-XU6JEg 很多创业者说,要建立怎样一个平台,要打破信息不对称,大部分时候,我都会泼冷水, ...

- WINDOWS mysql 5.7.15 安装配置方法图文教程

因本人需要需要安装Mysql,现将安装过程记录如下,在自己记录的同时,希望对有疑问的人有所帮助. 一.下载软件 1. 进入mysql官网,登陆自己的oracle账号(没有账号的自己注册一个),下载My ...

- 分享个昨天学的,sqlserver查表的所有列的列名,类型,长度的sql

select a.name as 列名, a.length as 长度,b.name as 类型 from syscolumns a left join systypes b on a.xtype ...

- sqlalchemy的常用字段

#encoding: utf-8 from sqlalchemy import create_engine,Column,Integer,String,\ Float,Boolean,DECIMAL, ...

- 字符串转 Boolean 的正确方式

String s1 = "false"; String s2 = "true"; String s3 = "fAlSe"; String s ...

- [转帖]FreeBSD、OpenBSD、NetBSD的区别

FreeBSD.OpenBSD.NetBSD的区别 Linux 的历史 http://www.361way.com/unix-bsd/1513.html 一直unix在我心目中的地位都很高,uni ...

- Oracle-DDL 3- 触发器

DDL-数据定义语句: 四.触发器 -- 触发器(trigger),与某些特定的操作绑定,当达到触发条件后会自动触发--主要用来将某些操作的过程记录下来,或者阻止某些非法的操作,保护数据 /*触发条件 ...