CNN卷积神经网络人脸识别

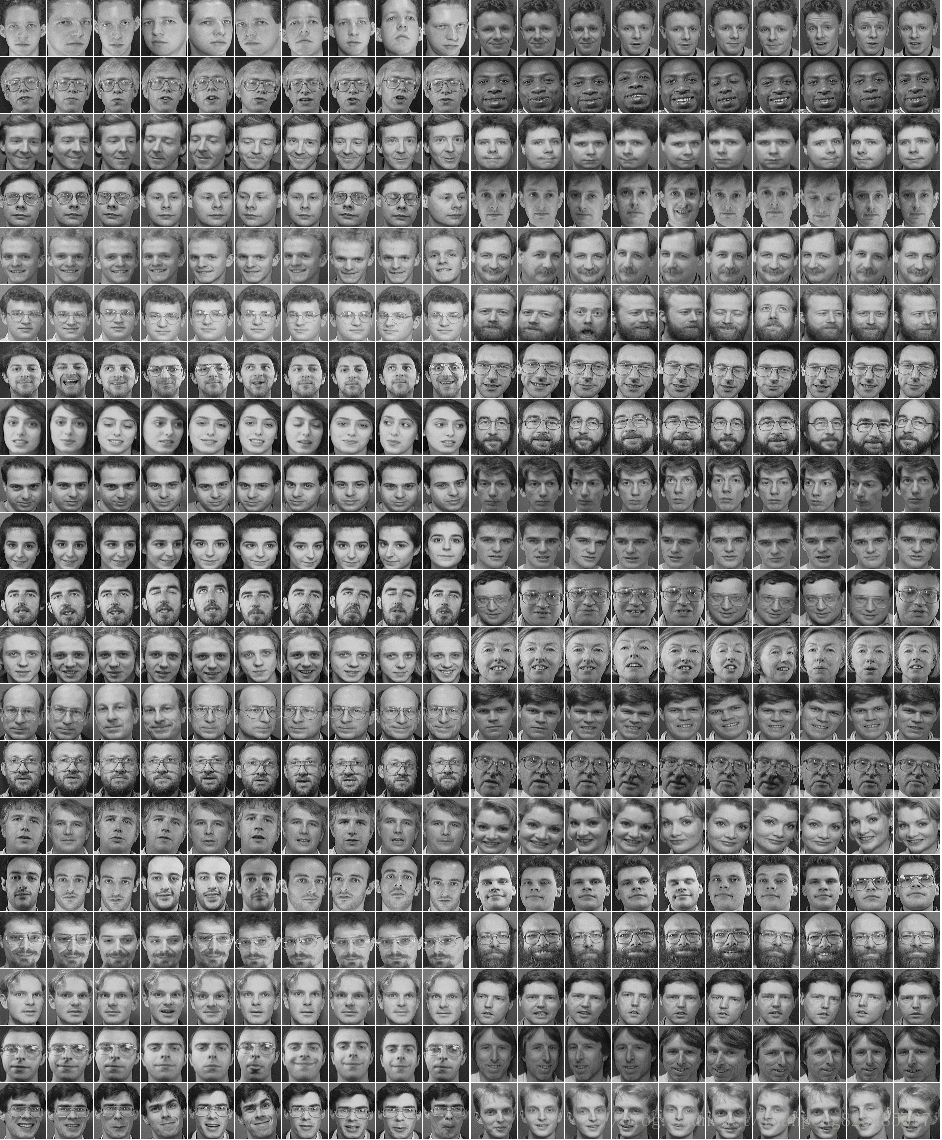

图片总共40个人,每人10张图片,每张图片高57,宽47。共400张图片。

读取图片的py文件

import numpy

import pandas

from PIL import Image

from keras import backend as K

from keras.utils import np_utils

"""

加载图像数据的函数,dataset_path即图像olivettifaces的路径

加载olivettifaces后,划分为train_data,valid_data,test_data三个数据集

函数返回train_data,valid_data,test_data以及对应的label

"""

# 400个样本,40个人,每人10张样本图。每张样本图高57*宽47,需要2679个像素点。每个像素点做了归一化处理

def load_data(dataset_path):

img = Image.open(dataset_path)

img_ndarray = numpy.asarray(img, dtype='float64') / 256

print(img_ndarray.shape)

faces = numpy.empty((400,57,47))

for row in range(20):

for column in range(20):

faces[row * 20 + column] = img_ndarray[row * 57:(row + 1) * 57, column * 47:(column + 1) * 47]

# 设置400个样本图的标签

label = numpy.empty(400)

for i in range(40):

label[i * 10:i * 10 + 10] = i

label = label.astype(numpy.int)

label = np_utils.to_categorical(label, 40) # 将40分类类标号转化为one-hot编码

# 分成训练集、验证集、测试集,大小如下

train_data = numpy.empty((320, 57,47)) # 320个训练样本

train_label = numpy.empty((320,40)) # 320个训练样本,每个样本40个输出概率

valid_data = numpy.empty((40, 57,47)) # 40个验证样本

valid_label = numpy.empty((40,40)) # 40个验证样本,每个样本40个输出概率

test_data = numpy.empty((40, 57,47)) # 40个测试样本

test_label = numpy.empty((40,40)) # 40个测试样本,每个样本40个输出概率

for i in range(40):

train_data[i * 8:i * 8 + 8] = faces[i * 10:i * 10 + 8]

train_label[i * 8:i * 8 + 8] = label[i * 10:i * 10 + 8]

valid_data[i] = faces[i * 10 + 8]

valid_label[i] = label[i * 10 + 8]

test_data[i] = faces[i * 10 + 9]

test_label[i] = label[i * 10 + 9]

return [(train_data, train_label), (valid_data, valid_label),(test_data, test_label)]

if __name__ == '__main__':

[(train_data, train_label), (valid_data, valid_label), (test_data, test_label)] = load_data('olivettifaces.gif')

oneimg = train_data[0]*256

print(oneimg)

im = Image.fromarray(oneimg)

im.show()

CNN人脸识别代码

import numpy as np

np.random.seed(1337) # for reproducibility

from keras.models import Sequential

from keras.layers import Dense, Activation, Flatten

from keras.layers import Conv2D, MaxPooling2D,AveragePooling2D

from PIL import Image

import FaceData

# 全局变量

batch_size = 128 # 批处理样本数量

nb_classes = 40 # 分类数目

epochs = 600 # 迭代次数

img_rows, img_cols = 57, 47 # 输入图片样本的宽高

nb_filters = 32 # 卷积核的个数

pool_size = (2, 2) # 池化层的大小

kernel_size = (5, 5) # 卷积核的大小

input_shape = (img_rows, img_cols,1) # 输入图片的维度

[(X_train, Y_train), (X_valid, Y_valid),(X_test, Y_test)] =FaceData.load_data('olivettifaces.gif')

X_train=X_train[:,:,:,np.newaxis] # 添加一个维度,代表图片通道。这样数据集共4个维度,样本个数、宽度、高度、通道数

X_valid=X_valid[:,:,:,np.newaxis] # 添加一个维度,代表图片通道。这样数据集共4个维度,样本个数、宽度、高度、通道数

X_test=X_test[:,:,:,np.newaxis] # 添加一个维度,代表图片通道。这样数据集共4个维度,样本个数、宽度、高度、通道数

print('样本数据集的维度:', X_train.shape,Y_train.shape)

print('测试数据集的维度:', X_test.shape,Y_test.shape)

# 构建模型

model = Sequential()

model.add(Conv2D(6,kernel_size,input_shape=input_shape,strides=1)) # 卷积层1

model.add(AveragePooling2D(pool_size=pool_size,strides=2)) # 池化层

model.add(Conv2D(12,kernel_size,strides=1)) # 卷积层2

model.add(AveragePooling2D(pool_size=pool_size,strides=2)) # 池化层

model.add(Flatten()) # 拉成一维数据

model.add(Dense(nb_classes)) # 全连接层2

model.add(Activation('sigmoid')) # sigmoid评分

# 编译模型

model.compile(loss='categorical_crossentropy',optimizer='adadelta',metrics=['accuracy'])

# 训练模型

model.fit(X_train, Y_train, batch_size=batch_size, epochs=epochs,verbose=1, validation_data=(X_test, Y_test))

# 评估模型

score = model.evaluate(X_test, Y_test, verbose=0)

print('Test score:', score[0])

print('Test accuracy:', score[1])

y_pred = model.predict(X_test)

y_pred = y_pred.argmax(axis=1) # 获取概率最大的分类,获取每行最大值所在的列

for i in range(len(y_pred)):

oneimg = X_test[i,:,:,0]*256

im = Image.fromarray(oneimg)

im.show()

print('第%d个人识别为第%d个人'%(i,y_pred[i]))

CNN卷积神经网络人脸识别的更多相关文章

- cnn 卷积神经网络 人脸识别

卷积网络博大精深,不同的网络模型,跑出来的结果是不一样,在不知道使用什么网络的情况下跑自己的数据集时,我建议最好去参考基于cnn的手写数字识别网络构建,在其基础上进行改进,对于一般测试数据集有很大的帮 ...

- Deep Learning模型之:CNN卷积神经网络(一)深度解析CNN

http://m.blog.csdn.net/blog/wu010555688/24487301 本文整理了网上几位大牛的博客,详细地讲解了CNN的基础结构与核心思想,欢迎交流. [1]Deep le ...

- cnn(卷积神经网络)比较系统的讲解

本文整理了网上几位大牛的博客,详细地讲解了CNN的基础结构与核心思想,欢迎交流. [1]Deep learning简介 [2]Deep Learning训练过程 [3]Deep Learning模型之 ...

- [转]Theano下用CNN(卷积神经网络)做车牌中文字符OCR

Theano下用CNN(卷积神经网络)做车牌中文字符OCR 原文地址:http://m.blog.csdn.net/article/details?id=50989742 之前时间一直在看 Micha ...

- day-16 CNN卷积神经网络算法之Max pooling池化操作学习

利用CNN卷积神经网络进行训练时,进行完卷积运算,还需要接着进行Max pooling池化操作,目的是在尽量不丢失图像特征前期下,对图像进行downsampling. 首先看下max pooling的 ...

- 3层-CNN卷积神经网络预测MNIST数字

3层-CNN卷积神经网络预测MNIST数字 本文创建一个简单的三层卷积网络来预测 MNIST 数字.这个深层网络由两个带有 ReLU 和 maxpool 的卷积层以及两个全连接层组成. MNIST 由 ...

- Deep Learning论文笔记之(四)CNN卷积神经网络推导和实现(转)

Deep Learning论文笔记之(四)CNN卷积神经网络推导和实现 zouxy09@qq.com http://blog.csdn.net/zouxy09 自己平时看了一些论文, ...

- CNN(卷积神经网络)、RNN(循环神经网络)、DNN(深度神经网络)的内部网络结构有什么区别?

https://www.zhihu.com/question/34681168 CNN(卷积神经网络).RNN(循环神经网络).DNN(深度神经网络)的内部网络结构有什么区别?修改 CNN(卷积神经网 ...

- CNN(卷积神经网络)、RNN(循环神经网络)、DNN,LSTM

http://cs231n.github.io/neural-networks-1 https://arxiv.org/pdf/1603.07285.pdf https://adeshpande3.g ...

随机推荐

- WPF仿网易云音乐系列(三、播放进度条+控制按钮)

一.简介 上一篇,咱们基本把左侧导航栏给搞定,这一篇文章,开始来做一下播放进度条和控制按钮:老规矩,咱们先来看一下原版的效果: 首先,它这个专辑图片,有一个按钮效果,鼠标移入会显示出伸缩箭头:移出后消 ...

- (转)C#中的那些全局异常捕获

C#中的那些全局异常捕获(原文链接:http://www.cnblogs.com/taomylife/p/4528179.html) 1.WPF全局捕获异常 public partia ...

- JWT认证原理及使用

一.JWT原理: 参考文章:https://www.jianshu.com/p/180a870a308a 1.传统的登录方式: 浏览器输入用户名密码,服务端校验通过,根据用户信息生成一个token,将 ...

- H5 70-清除浮动方式五

<!DOCTYPE html> <html lang="en"> <head> <meta charset="UTF-8&quo ...

- struts2的基本使用

struts2在web中当作前端控制器,接收来自页面的请求,使用过滤器拦截模式对请求进行拦截并交给相应配置的action类处理. 所以在web中使用最重要的是struts2的核心过滤器StrutsPr ...

- Linux系统tree工具

当用户在linux平台中需要需要查看一个非当前目录的目录下有哪些文件和子文件时,最普通的办法就是cd该目录,然后再ls,这个操作令人不舒适,因为查看完以后,用户还需要切换到原来的目录.现在介绍一款非常 ...

- PyCharm中快速给选中的代码加上{}、<>、()、[]

快捷键Ctrl + Shift + S 呼出下图所示界面:

- ocrosoft 1015 习题1.22 求一元二次方程a*x^2 + b*x + c = 0的根

http://acm.ocrosoft.com/problem.php?id=1015 题目描述 求一元二次方程a*x2 + b*x + c = 0的根.系数a.b.c为浮点数,其值在运行时由键盘输入 ...

- 一、npm基础

一.什么是npm? npm 是模块管理工具,可以下载.更新第三方模块,也可以发布自己的模块共替他人使用,主要目的在于分享和重用代码: 二.下载安装node,更新npm node 下载网址 https ...

- vue传参二

<template> <ul> <li v-for="(value,key,index) in list" :key="index" ...