Hadoop spark mongo复制集

启动hadoop

cd /usr/local/hadoop/hadoop

$hadoop namenode -format # 启动前格式化namenode

$./sbin/start-all.sh

检查是否启动成功

[hadoop@hadoop1 hadoop]$ jps

16855 NodeManager

16999 Jps

16090 NameNode

16570 ResourceManager

16396 SecondaryNameNode

[hadoop@hadoop1 hadoop]$

/usr/local/hadoop/hadoop

[hadoop@hadoop2 hadoop]$ jps

1378 NodeManager

1239 DataNode

1528 Jps

[hadoop@hadoop2 hadoop]$ 停止

$./sbin/stop-all.sh 启动spark

cd /usr/local/hadoop/spark/

./sbin/start-all.sh 检查是否启动成功

[hadoop@hadoop1 spark]$ jps

16855 NodeManager

17223 Master

17447 Jps

17369 Worker

16090 NameNode

16570 ResourceManager

16396 SecondaryNameNode

[hadoop@hadoop1 spark]$

[hadoop@hadoop2 spark]$ jps

1378 NodeManager

1239 DataNode

2280 Worker

2382 Jps

[hadoop@hadoop2 spark]$ 停止

$./sbin/stop-all.sh

pyspark_mongo复制集_hdfs_hbase 启动mongo复制集

[

/usr/local/mongodb/安装后,初始化

mkdir -p /mnt/mongodb_data/{data,log};

mkdir conf/;

vim /usr/local/mongodb/conf/mongod.conf; [

mv /mnt/mongodb_data/data /mnt/mongodb_data/data$(date +"%Y%m%d_%H%I%S"); mkdir /mnt/mongodb_data/data;

]

``

bind_ip=0.0.0.0

port=

dbpath=/mnt/mongodb_data/data

logpath=/mnt/mongodb_data/log/mongod.log

pidfilepath=/usr/local/mongodb/mongo.pid

fork=true

logappend=true scp /usr/local/mongodb/conf/mongod.conf root@hadoop2:/usr/local/mongodb/conf/; 启动服务

/usr/local/mongodb/bin/mongod -f /usr/local/mongodb/conf/mongod.conf

进入读写窗设置admin账号

/usr/local/mongodb/bin/mongo

use admin;

db.createUser(

{

user: "admin",

pwd: "admin123",

roles: [ { role: "userAdminAnyDatabase", db: "admin" } ,"clusterAdmin"]

}

); 检验是否添加成功

db.getUsers()

关闭服务mongod

db.shutdownServer()

退出mongo

exit 对配置文件加入ip限制和复制集配置

vim /usr/local/mongodb/conf/mongod.conf;

replSet=repl_test

keyFile=/usr/local/mongodb/conf/keyFile

shardsvr=true

directoryperdb=true /usr/local/mongodb/bin/mongod -f /usr/local/mongodb/conf/mongod.conf

进入任一节点mongo窗,进入读写

/usr/local/mongodb/bin/mongo

use admin;

db.auth("admin","admin123");

设置复制集

rs.status();

rs.();

rs.status();

rs.add("hadoop2:27017");

rs.status();

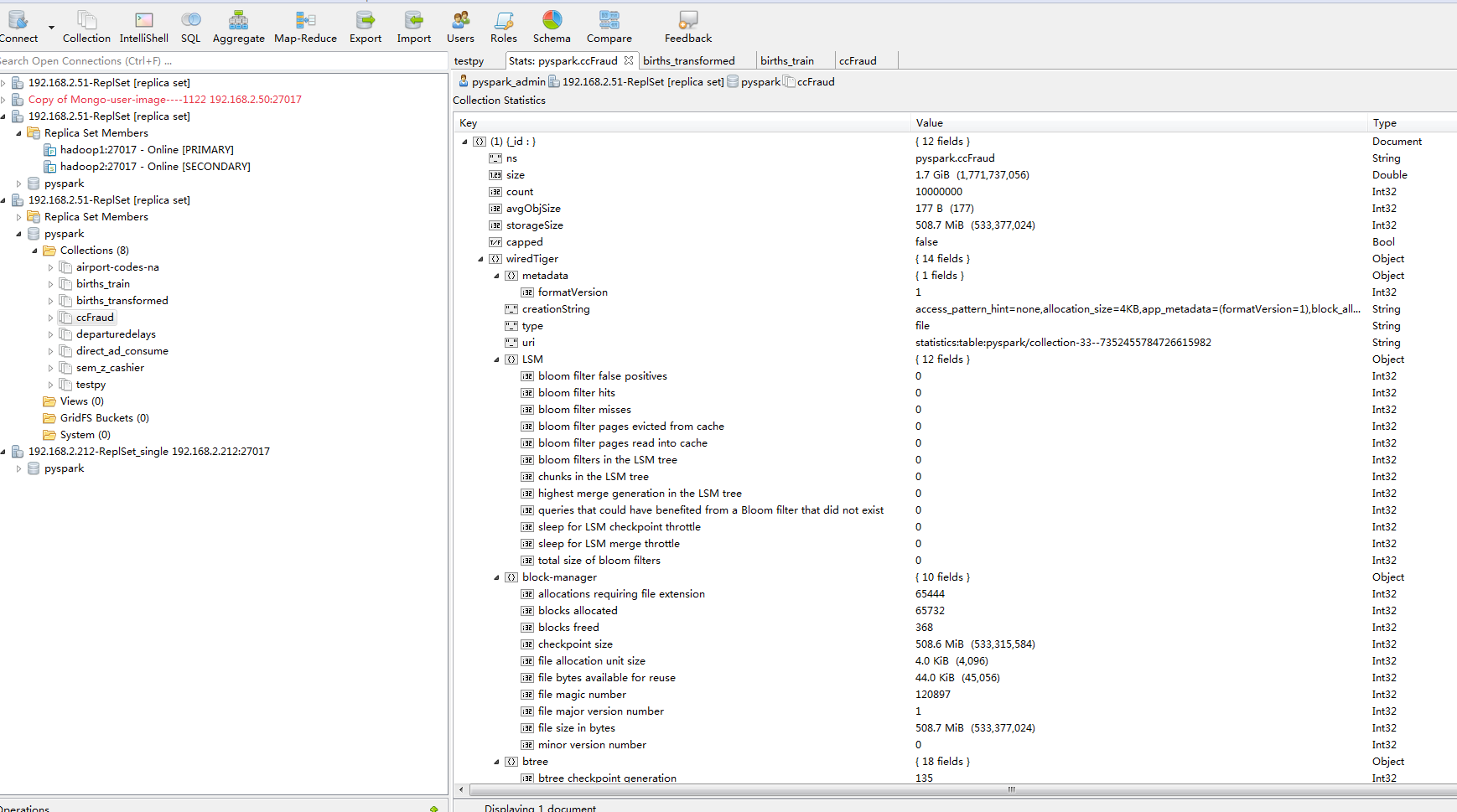

复制集无误后,库表、角色、用户设计; use pyspark;

db.createUser(

{

user: "pyspark_admin",

pwd: "admin123",

roles: [ "readWrite", "dbAdmin" ]

}

);

db.getRoles();

db.getUsers(); db.auth("pyspark_admin","admin123");

show collections;

db.createCollection('direct_ad_consume');

db.createCollection('sem_z_cashier');

show collections; db.createCollection('testpy');

db.createCollection('departuredelays');

db.createCollection('airport-codes-na'); db.createCollection('ccFraud'); db.sem_z_cashier.drop();

] spark数据源;

单个大文件hdfs、hbase

序列化文件mongo复制集,可以考虑spark-mongo组件 执行spark

cd /usr/local/hadoop/ 启动hadoop

cd /usr/local/hadoop/hadoop

$hadoop namenode -format # 启动前格式化namenode

$./sbin/start-all.sh

检查是否启动成功

[hadoop@hadoop1 hadoop]$ jps

NodeManager

Jps

NameNode

ResourceManager

SecondaryNameNode

[hadoop@hadoop1 hadoop]$

/usr/local/hadoop/hadoop

[hadoop@hadoop2 hadoop]$ jps

NodeManager

DataNode

Jps

[hadoop@hadoop2 hadoop]$ 停止

$./sbin/stop-all.sh 启动spark

cd /usr/local/hadoop/spark/

./sbin/start-all.sh 检查是否启动成功

[hadoop@hadoop1 spark]$ jps

NodeManager

Master

Jps

Worker

NameNode

ResourceManager

SecondaryNameNode

[hadoop@hadoop1 spark]$

[hadoop@hadoop2 spark]$ jps

NodeManager

DataNode

Worker

Jps

[hadoop@hadoop2 spark]$ 停止

$./sbin/stop-all.sh

Hadoop spark mongo复制集的更多相关文章

- mongo复制集脑裂问题如何处理

mongo replication 脑裂问题如何处理: 一.问题描述:一套mongo replication有4个节点.1个仲裁节点.在停止实例(或实例毁坏)的时候,导致所有节点都变为SECONDAR ...

- mongo 复制集命令

1.登录primary2.use admin >rs.add("new_node:port") 或 rs.add({"_id":4,"host& ...

- mongo复制集、分片集(亲测)

1.1 架构思路: 192.168.50.131 192.168.50.131 192.168.50.132 mongos mongos mongos ...

- 单机Mongo复制集安装配置(数据库版本:4.x)

官方文档: https://docs.mongodb.com/manual/tutorial/deploy-replica-set-with-keyfile-access-control/#dep ...

- hadoop - spark on yarn 集群搭建

一.环境准备 1. 机器: 3 台虚拟机 机器 角色 l-qta3.sp.beta.cn0 NameNode,ResourceManager,spark的master l-querydiff1.sp ...

- 工作中Hadoop,Spark,Phoenix,Impala 集群中遇到坑及解决方案

1.HDFS 修复 问题描述:其他部门在yarn平台上跑spark 程序错误的生成了海量的不到100K的小文件,导致namenode压力过大,其中一个namenode宕机后,没有及时发现 使得edit ...

- MongoDB复制集搭建(3.4.17版)

==版本== mongodb-linux-x86_64-rhel70-3.4.17.tgz ==准备== 3个节点,我这里的IP及hostname分别是: 10.11.2.52 dscn49 10.1 ...

- docker添加mongo4.0.3并配置复制集

1.创建docker 具体略过 自行百度 2.创建数据持久化目录文件(/data/mongo0是个例子 命名随意) 拉取mongo docker pull mongo:4.0.3 3.启动容器 do ...

- Hadoop+Spark:集群环境搭建

环境准备: 在虚拟机下,大家三台Linux ubuntu 14.04 server x64 系统(下载地址:http://releases.ubuntu.com/14.04.2/ubuntu-14.0 ...

随机推荐

- [BZOJ1572] [Usaco2009 Open]工作安排Job(贪心 + 堆)

传送门 把任务按照d排序 一次加入到堆中,如果当前放不进堆中,并且比堆中最小的大, 就从堆中弹出一个数,再把当前的数放进去 #include <queue> #include <cs ...

- [SDOI2008]仪仗队 (欧拉函数)

题目描述 作为体育委员,C君负责这次运动会仪仗队的训练.仪仗队是由学生组成的N * N的方阵,为了保证队伍在行进中整齐划一,C君会跟在仪仗队的左后方,根据其视线所及的学生人数来判断队伍是否整齐(如下图 ...

- 【bzoj1193】[HNOI2006]马步距离

[HNOI2006]马步距离 Description Input 只包含4个整数,它们彼此用空格隔开,分别为xp,yp,xs,ys.并且它们的都小于10000000. Output 含一个整数,表示从 ...

- 请问 内网的 dns服务器 为什么和 外网的dns服务器 一样??

公司内的内网使用192.169.X.X的内网地址,但是在DNS段填写的是210.34.X.X,显然这是一个公网固定IP,我不明白的是:为什么内部网客户端使用的DNS服务器是公网上的IP呢?内网客户端能 ...

- robotframework安装和配置【转IBM:https://www.ibm.com/developerworks/cn/opensource/os-cn-robot-framework/index.html】

内容 概览 Robot Framework 介绍 Robot Framework 的安装和配置 RIDE 编辑器介绍 创建测试项目 简单的测试用例的编写 总结 相关主题 评论 Robot Fr ...

- 【Tomcat】使用tomcat manager 管理和部署项目,本地部署项目到服务器

在部署tomcat项目的时候,除了把war文件直接拷贝到tomcat的webapp目录下,还有一种方法可以浏览器中管理和部署项目,那就是使用tomcat manager. 默认情况下,tomcat m ...

- Codeforces 271D - Good Substrings [字典树]

传送门 D. Good Substrings time limit per test 2 seconds memory limit per test 512 megabytes input stand ...

- 清除svn检出导致的所有文件的问号

问题:将svn项目检出到桌面后,桌面的图标都有问号了,怎么消除这一大堆问号? 解决方案:(1)新建一个a.txt文件,把这行代码复制进去for /r . %%a in (.) do @if exist ...

- POSTMAN编写文档

第一步:创建文件夹: 同时创建全局变量: 第二步:创建分组文件夹: 第三步:添加请求: 类似正常调试,然后多了一步保存: 保存: 请求方式发生相应变化,同时颜色也发生变化,说明保存成功: ====== ...

- Codeforces 713C Sonya and Problem Wihtout a Legend(DP)

题目链接 Sonya and Problem Wihtout a Legend 题意 给定一个长度为n的序列,你可以对每个元素进行$+1$或$-1$的操作,每次操作代价为$1$. 求把原序列变成 ...