Hive学习之七《 Sqoop import 从关系数据库抽取到HDFS》

一、什么是sqoop

Sqoop是一款开源的工具,主要用于在Hadoop(Hive)与传统的数据库(mysql、postgresql...)间进行数据的传递,可以将一个关系型数据库(例如 :MySQL ,Oracle ,Postgres等)中的数据导进到Hadoop的HDFS中,也可以将HDFS的数据导进到关系型数据库中。

二、sqoop的特点

Sqoop中一大亮点就是可以通过hadoop的mapreduce把数据从关系型数据库中导入数据到HDFS。

三、Sqoop import 命令

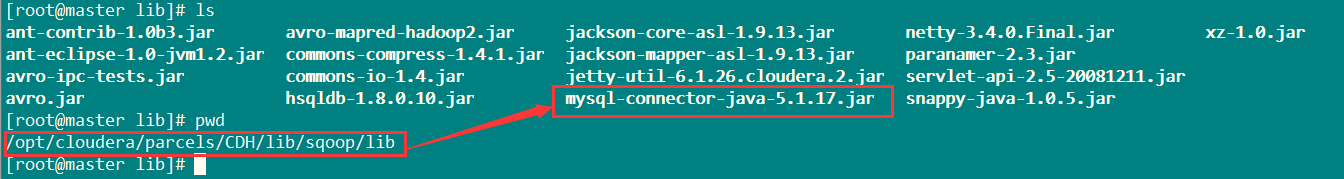

将Mysql的jdbc驱动放在/opt/cloudera/parcels/CDH/lib/sqoop/lib目录下。

如下图:

参考学习网址:

http://archive.cloudera.com/cdh5/cdh/5/sqoop-1.4.4-cdh5.1.0/SqoopUserGuide.html

命令详解:

1、基本语法

$ sqoop import (generic-args) (import-args)$ sqoop-import (generic-args) (import-args)

2、基本命令

查看网址:

http://archive.cloudera.com/cdh5/cdh/5/sqoop-1.4.4-cdh5.1.0/SqoopUserGuide.html

中的sqoop import的 Import control arguments

3、案例

方式一:

将表rpt_sale_daily中数据导入到HDFS上。

目标目录为:sqoop/rpt_sale_daily。

sqoop import --connect jdbc:mysql://master:3306/test \

--username root --password 123456 --table rpt_sale_daily \

--columns "dateid,huodong,pv,uv" \

--where "dateid='2015-08-28'" \

--target-dir sqoop/rpt_sale_daily \

-m 1

如果提示 sqoop/rpt_sale_daily 目录已经存在,执行:

hadoop fs -rmr sqoop/rpt_sale_daily

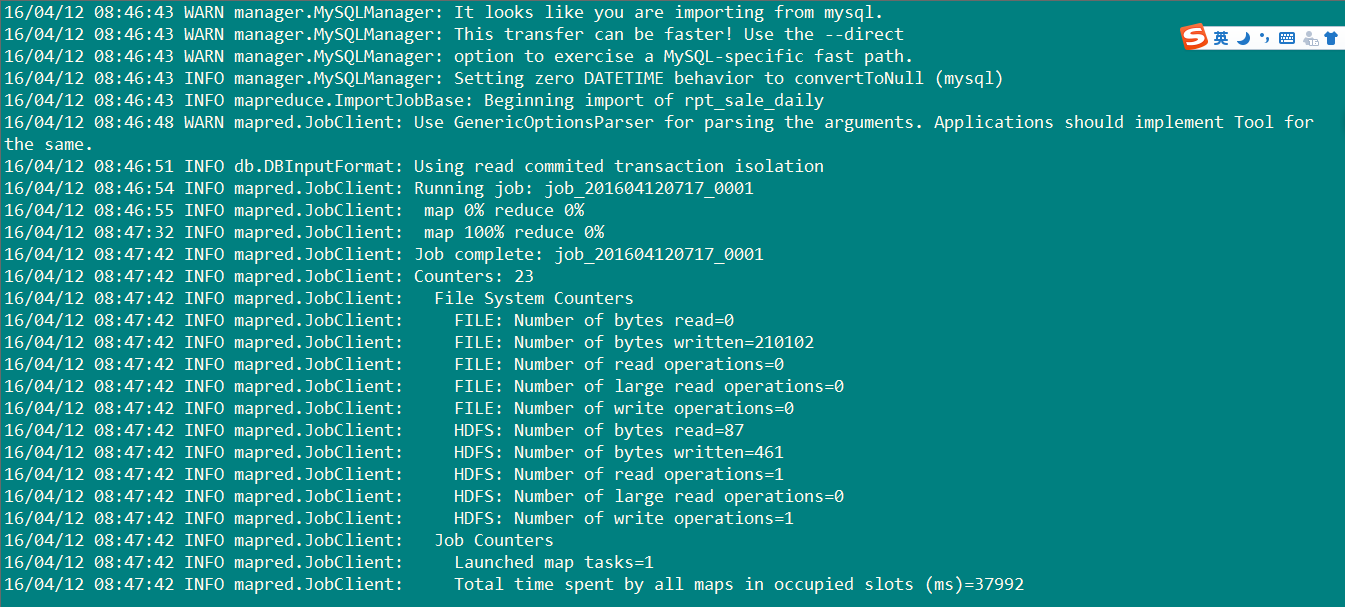

执行结果:如下图

20条数据成功导入,开始检测吧亲。

执行代码:

hadoop fs -cat sqoop/rpt_sale_daily/part-m-00000

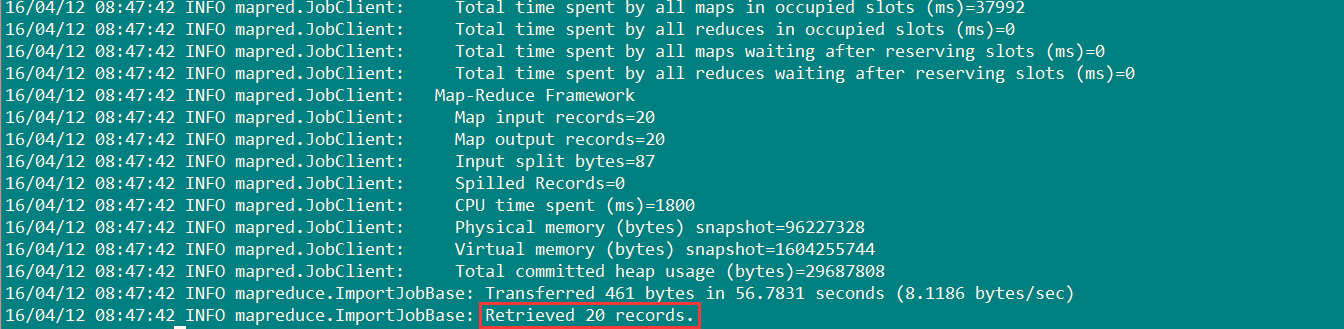

数据如下图:

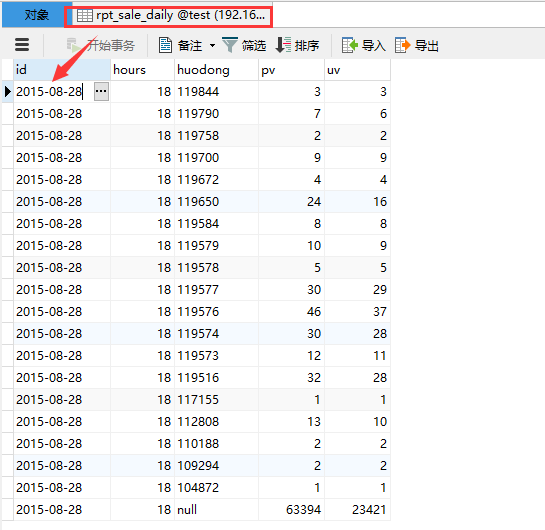

关系数据库表rpt_sale_daily里面的数据如下:

对比,数据相同,成功导入。

方式二:

通过opt文件的方式传送:

新建test.opt文件:

import

--connect

jdbc:mysql://192.168.0.115:3306/test

--username

root

--password --table

rpt_sale_daily

--columns

"id,huodong,pvv,uvv"

--where

"id='2015-08-28'"

--target-dir

sqoop/rpt_sale_daily

-m

执行指令:

sqoop options-file test.opt

执行过程和结果和方式一一样。

Hive学习之七《 Sqoop import 从关系数据库抽取到HDFS》的更多相关文章

- 【Hive学习之七】Hive 运行方式&权限管理

环境 虚拟机:VMware 10 Linux版本:CentOS-6.5-x86_64 客户端:Xshell4 FTP:Xftp4 jdk8 hadoop-3.1.1 apache-hive-3.1.1 ...

- sqoop从oracle数据库抽取数据,导入到hive

环境: hadoop-2.7.5 sqoop-1.4.7 zookeeper-3.4.10 hive-2.3.3 (使用mysql配置元数据库) jdk1.8.0_151 oracle 11.2.0. ...

- (MySQL里的数据)通过Sqoop Import Hive 里 和 通过Sqoop Export Hive 里的数据到(MySQL)

Sqoop 可以与Hive系统结合,实现数据的导入和导出,用户需要在 sqoop-env.sh 中添加HIVE_HOME的环境变量. 具体,见我的如下博客: hadoop2.6.0(单节点)下Sqoo ...

- sqoop import mysql to hive table:GC overhead limit exceeded

1. Scenario description when I use sqoop to import mysql table into hive, I got the following error: ...

- hive学习笔记之七:内置函数

欢迎访问我的GitHub https://github.com/zq2599/blog_demos 内容:所有原创文章分类汇总及配套源码,涉及Java.Docker.Kubernetes.DevOPS ...

- hive学习笔记之八:Sqoop

欢迎访问我的GitHub https://github.com/zq2599/blog_demos 内容:所有原创文章分类汇总及配套源码,涉及Java.Docker.Kubernetes.DevOPS ...

- Hive学习详细版

一.概述 1.Hadoop的开发问题 只能用java语言开发,存在语言门槛 需要对Hadoop底层原理,api比较了解才能做开发 开发调试比较麻烦 2.什么是Hive Hive是基于Hadoop的一个 ...

- sqoop命令,mysql导入到hdfs、hbase、hive

1.测试MySQL连接 bin/sqoop list-databases --connect jdbc:mysql://192.168.1.187:3306/trade_dev --username ...

- sqoop import 和export的问题

sqoop import DB 2 hive(hdfs)是采用JDBC的过程,与传统hive区别在与多走了thrift server接口(稳定性待学习现在还比较模糊没做过大数据量测试),而export ...

随机推荐

- java学习面向对象之封装

在以往几节当中我们讲到了什么是类,类就是对一类事物的描述,比如现在我们有一个人类 class Person { /** *这里我们分别在name和age上加上了元素的访问权限 *这里的private是 ...

- 【模拟】NCPC 2014 K Train passengers

题目链接: http://acm.csu.edu.cn/OnlineJudge/problem.php?id=1797 题目大意: 有N个车站,火车一共可以坐M个人,每个车站下车Ai,上车Bi个人,在 ...

- socket(TCP)发送文件

一:由于在上一个随笔的基础之上拓展的所以直接上代码,客户端: using System; using System.Collections.Generic; using System.Componen ...

- json格式键盘编码对照表

整理了一份JSON格式的键盘编码对照表.欢迎转载,但请注明出处,谢谢! { VK_BACK: 8, //退格键 VK_TAB: 9, //TAB键 VK_RETURN: 13, //回车键 VK_SH ...

- Codeforces Round #333 (Div. 1)--B. Lipshitz Sequence 单调栈

题意:n个点, 坐标已知,其中横坐标为为1~n. 求区间[l, r] 的所有子区间内斜率最大值的和. 首先要知道,[l, r]区间内最大的斜率必然是相邻的两个点构成的. 然后问题就变成了求区间[l, ...

- Java调用R(二)_JRI

推荐使用.相比RServe更灵活,效率更高. 基本步骤 1. R中需要安装rJava包. 2. 系统变量Path加上 C:\Program Files\R\R-3.0.1\bin\i386;C:\ ...

- XPath与Xquery

XPath 和 XQuery 在某些方面很相似.XPath 还是 XQuery 完整不可分割的一部分.这两种语言都能够从 XML 文档或者 XML 文档存储库中选择数据.本文简要介绍了 XPath 和 ...

- SVN安装图解

SVN服务器搭建和使用(一) Subversion是优秀的版本控制工具,其具体的的优点和详细介绍,这里就不再多说. 首先来下载和搭建SVN服务器. 现在Subversion已经迁移到apache网站上 ...

- Excel导入mysql数据库

步骤一:选取要导入的数据快儿,另外要多出一列,如下图: 步骤二: 将选中的数据快儿拷贝到一个新建的表格工作薄,然后“另存为” ->“文本文件(制表符分割)(*.txt)”,假如存到“D: ...

- SAP-MM:发票、贷方凭证、事后借记、后续贷记

发票和事后借记 相同点:增加对供应商的应付款 不同点:针对同一订单收货,发票要先于事后借记(事后借记是对供应商后期发票金额的补充):发票和金额.订单数量有关系,而事后借记只是订单金额调整的凭证,仅仅是 ...