scrapy中XMLFeedSpider

爬取案例:

目标网站:

url = 'http://www.chinanews.com/rss/scroll-news.xml'

页面特点:

先创建爬虫项目:

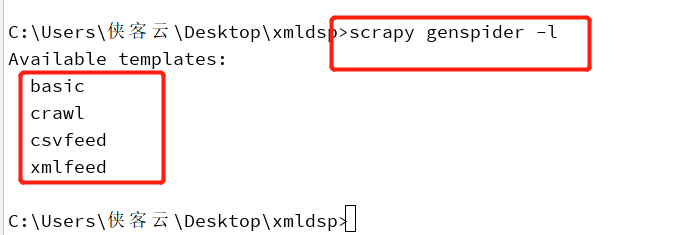

也可以查看爬虫类:

创建xmlFeed 爬虫可以用:

scrapy genspider -t xmlfeed cnew chinanews.com

2. 或可以先创建普通爬虫,再将普通的scrapy爬虫类改为XMLFeedSpider 爬虫类

该爬虫代码:

# -*- coding: utf-8 -*-

import scrapy

from scrapy.spiders import XMLFeedSpider

from ..items import FeedItem

class NewsSpider(XMLFeedSpider):

name = 'news'

#allowed_domains = ['www.chinanews.com']

start_urls = ['http://www.chinanews.com/rss/scroll-news.xml']

#iterator = 'itetnodes'

#itertag = 'item' def parse_node(self, response, node): # item = FeedItem()

item ={}

item['title'] = node.xpath('title/text()').extract_first()

item['link'] = node.xpath('link/text()').extract_first()

item['desc'] =node.xpath('description/text()').extract_first()

item['pub_date'] = node.xpath('pubDate/text()').extract_first() print(item) yield item

3. 将settings中的配置

# Obey robots.txt rules

ROBOTSTXT_OBEY = False

4. 启动爬虫

scrapy crawl news --nolog

5.爬取效果

scrapy中XMLFeedSpider的更多相关文章

- Scrapy中使用Django的Model访问数据库

Scrapy中使用Django的Model进行数据库访问 当已存在Django项目的时候,直接引入Django的Model来使用比较简单 # 使用以下语句添加Django项目的目录到path impo ...

- scrapy中的下载器中间件

scrapy中的下载器中间件 下载中间件 下载器中间件是介于Scrapy的request/response处理的钩子框架. 是用于全局修改Scrapy request和response的一个轻量.底层 ...

- Scrapy中使用cookie免于验证登录和模拟登录

Scrapy中使用cookie免于验证登录和模拟登录 引言 python爬虫我认为最困难的问题一个是ip代理,另外一个就是模拟登录了,更操蛋的就是模拟登录了之后还有验证码,真的是不让人省心,不过既然有 ...

- scrapy 中日志的使用

我在后台调试 在后台调试scrapy spider的时候,总是觉得后台命令窗口 打印的东西太多了不便于观察日志,因此需要一个日志文件记录信息,这样以后会 方便查找问题. 分两种方法吧. 1.简单粗暴. ...

- scrapy中response.body 与 response.text区别

scrapy中response.body 与 response.text区别 body http响应正文, byte类型 text 文本形式的http正文,str类型,它是response.body经 ...

- scrapy中的request

scrapy中的request 初始化参数 class scrapy.http.Request( url [ , callback, method='GET', headers, body, cook ...

- [转]scrapy中的logging

logging模块是Python提供的自己的程序日志记录模块. 在大型软件使用过程中,出现的错误有时候很难进行重现,因此需要通过分析日志来确认错误位置,这也是写程序时要使用日志的最重要的原因. scr ...

- 论Scrapy中的数据持久化

引入 Scrapy的数据持久化,主要包括存储到数据库.文件以及内置数据存储. 那我们今天就来讲讲如何把Scrapy中的数据存储到数据库和文件当中. 终端指令存储 保证爬虫文件的parse方法中有可迭代 ...

- selenium在scrapy中的使用、UA池、IP池的构建

selenium在scrapy中的使用流程 重写爬虫文件的构造方法__init__,在该方法中使用selenium实例化一个浏览器对象(因为浏览器对象只需要被实例化一次). 重写爬虫文件的closed ...

随机推荐

- da5_random模块

import random #标准模块,用来取随机数 print(random.randint(1,100)) #随机取一个整数,顾头顾尾 print(random.uniform(1,900)) # ...

- SparkContext初始化之SparkScheduler初始化

- C++ 在继承中虚函数、纯虚函数、普通函数,三者的区别

1.虚函数(impure virtual) C++的虚函数主要作用是“运行时多态”,父类中提供虚函数的实现,为子类提供默认的函数实现. 子类可以重写父类的虚函数实现子类的特殊化. 如下就是一个父类中的 ...

- Mac 软件

http://xclient.info/?t=e0ec92ebc9ce8ef7b7a48460b06893fa040ff066 Mac破解版软件网址

- Cocos 2dx项目lua调用OC出现卡死但不闪退的坑

最近新上线的一个游戏,发现线上游戏有部分功能在点击的时候出现了没有反应的情况.通过调试源码,发现是原生OC的代码出现了崩溃,但是比较奇怪的是线上的Bugly没有任何记录,这个功能属于高频高能,而且又是 ...

- 69A

#include <stdio.h> int main() { int n; int sum1=0, sum2=0, sum3=0; int x, y, z; scanf("%d ...

- 要学的javaee技术

mybatis.hibernate.spirng MVC.freemarker.zookeeper.dubbo.quartz的技术框架:NoSQL技术ehcache.memcached.redis等: ...

- js 判断浏览器型号

<html><head> <meta http-equiv="Content-Type" content="text/html;charse ...

- redis示例 - 限速器,计时器

INCR INCR key 将 key 中储存的数字值增一. 如果 key 不存在,那么 key 的值会先被初始化为 0 ,然后再执行 INCR 操作. 如果值包含错误的类型,或字符串类型的值不能表示 ...

- js前端使用jOrgChart插件实现组织架构图的展示

项目要做组织架构图,要把它做成自上而下的树形结构. 需要购买阿里云产品的,可以点击此链接购买,有红包优惠哦: https://promotion.aliyun.com/ntms/yunparter/i ...