使用HttpGet协议与正则表达实现桌面版的糗事百科

打开糗事百科笑话的主页,在这里我只取糗事笑话中文字这一板块,点击文字这一菜单栏。如下图。

const string qsbkMainUrl = "http://www.qiushibaike.com";

//获取糗百文字笑话页的url

private static string GetWBJokeUrl(int pageIndex)

{

StringBuilder url = new StringBuilder();

url.Append(qsbkMainUrl);

url.Append ("/textnew/page/");

url.Append(pageIndex.ToString ());

url.Append("/?s=4869039");

return url.ToString();

}

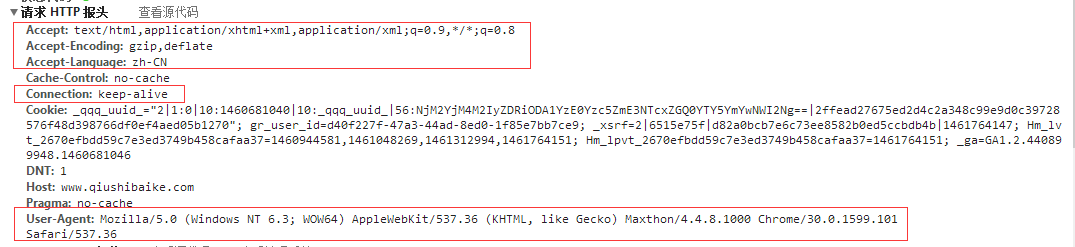

//根据网页的url获取网页的html源码

private static string GetUrlContent(string url)

{

try

{

HttpWebRequest request = (HttpWebRequest)WebRequest.Create(url);

request.UserAgent = "Mozilla/5.0 (Windows NT 6.3; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Maxthon/4.4.8.1000 Chrome/30.0.1599.101 Safari/537.36";

request.Method = "GET";

request.ContentType = "text/html;charset=UTF-8";

HttpWebResponse response = (HttpWebResponse)request.GetResponse();

Stream myResponseStream = response.GetResponseStream();

StreamReader myStreamReader = new StreamReader(myResponseStream, Encoding.GetEncoding("utf-8"));//因为知道糗百网页的编码方式为utf-8

string retString = myStreamReader.ReadToEnd();

myStreamReader.Close();

myResponseStream.Close();

return retString;

}

catch { return null; }

}

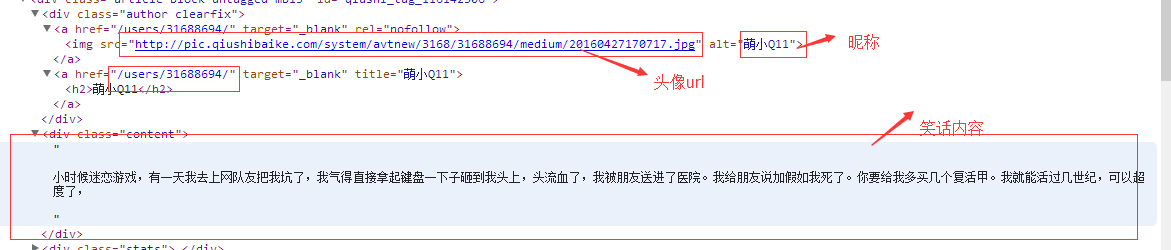

在1中我们已经根据page页索引的不同而获取不同的页面内容,而这一步的任务就是如何从返回的html源代码中获取我们想要的笑话内容。

正则:<img src="([^"]*")\s*alt="([^"]*)"/>\s</a>\s<a href="([^"]*)"[^>]*>\s<h2>[^>]*>\s</a>\s</div>\s*<div class="content">\s*((.*|<br/>)*)

public class JokeItem

{

private string nickName;

/// <summary>

/// 昵称

/// </summary>

public string NickName

{

get { return nickName; }

set { nickName = value; }

}

private Image headImage;

/// <summary>

/// 头像

/// </summary>

public Image HeadImage

{

get { return headImage; }

set { headImage = value; }

}

private string jokeContent;

/// <summary>

/// 笑话内容

/// </summary>

public string JokeContent

{

get { return jokeContent; }

set { jokeContent = value; }

}

private string jokeUrl;

/// <summary>

/// 笑话地址

/// </summary>

public string JokeUrl

{

get { return jokeUrl; }

set { jokeUrl = value; }

}

}

b、利用正则获取笑话内容

/// <summary>

/// 获取笑话列表

/// </summary>

/// <param name="htmlContent"></param>

public static List<JokeItem> GetJokeList(int pageIndex)

{

string htmlContent=GetUrlContent(GetWBJokeUrl(pageIndex));

List<JokeItem> jokeList = new List<JokeItem>();

Regex rg = new Regex(@"<img src=""([^""]*"")\s*alt=""([^""]*)""/>\s</a>\s<a href=""([^""]*)""[^>]*>\s<h2>[^>]*>\s</a>\s</div>\s*<div class=""content"">\s*((.*|<br/>)*)", RegexOptions.IgnoreCase);

JokeItem joke;

MatchCollection matchResults = rg.Matches(htmlContent);

foreach (Match result in matchResults)

{

joke = new JokeItem();

joke.HeadImage = GetWebImage(result.Groups[].Value);

joke.HeadImage = joke.HeadImage != null ? new Bitmap(GetWebImage(result.Groups[].Value), , ) : null;

joke.NickName = result.Groups[].Value;

joke.JokeUrl = qsbkMainUrl + "/" + result.Groups[].Value; ;

joke.JokeContent = result.Groups[].Value.Replace("<br/>", "\r\n").Replace("<br>", "\r\n");

joke.JokeContent = Regex.Replace(joke.JokeContent, @"(\r\n)+", "\r\n");//去掉多余的空行

jokeList.Add(joke);

}

return jokeList;

}

c、根据头像url地址获取头像

private static Image GetWebImage(string webUrl)

{

try

{

Encoding encode = Encoding.GetEncoding("utf-8");//网页编码==Encoding.UTF8

HttpWebRequest req = (HttpWebRequest)WebRequest.Create(new Uri(webUrl));

HttpWebResponse ress = (HttpWebResponse)req.GetResponse();

Stream sstreamRes = ress.GetResponseStream();

return System.Drawing.Image.FromStream(sstreamRes);

}

catch { return null; }

}

3、数据绑定

使用HttpGet协议与正则表达实现桌面版的糗事百科的更多相关文章

- HttpGet协议与正则表达

使用HttpGet协议与正则表达实现桌面版的糗事百科 写在前面 最近在重温asp.net,找了一本相关的书籍.本书在第一章就讲了,在不使用浏览器的情况下生成一个web请求,获取服务器返回的内容.于 ...

- python+正则提取+ip代理爬取糗事百科文字信息

很多网站都有反爬措施,最常见的就是封ip,请求次数过多服务器会拒绝连接,如图: 在程序中设置一个代理ip,可有效的解决这种问题,代码如下: # 需要的库 import requests import ...

- Python+Requests+Re(正则)爬取某糗事百科图片(数据分析一)

1.博客目前在学习爬虫课程,使用正则表达式来爬取网页的图片信息 2.下面我们一起来回归下Python中的正则使用方式/方法 3.糗事百科图片爬取源码如下: import requestsimport ...

- python+正则+多进程爬取糗事百科图片

话不多说,直接上代码: # 需要的库 import requests import re import os from multiprocessing import Pool # 请求头 header ...

- Javascript正则构造函数与正则表达字面量&&常用正则表达式

本文不讨论正则表达式入门,即如何使用正则匹配.讨论的是两种创建正则表达式的优劣和一些细节,最后给出一些常用正则匹配表达式. Javascript中的正则表达式也是对象,我们可以使用两种方法创建正则表达 ...

- js正则表达test、exec和match的区别

test的用法和exec一致,只不过返回值是 true false. 以前用js很少用到js的正则表达式,即使用到了,也是诸如邮件名称之类的判断,网上代码很多,很少有研究,拿来即用. 最近开发遇到一些 ...

- 正则表达示 for Python3

前情提要 从大量的文字内容中找到自己想要的东西,正则似乎是最好的方法.也是写爬虫不可缺少的技能.所以,别墨迹了赶紧好好学吧! 教程来自http://www.runoob.com/python3/pyt ...

- Python之面向对象和正则表达(代数运算和自动更正)

面向对象 一.概念解释 面对对象编程(OOP:object oriented programming):是一种程序设计范型,同时也是一种程序开发的方法,实现OOP的程序希望能够在程序中包含各种独立而又 ...

- JS写法 数值与字符串的相互转换 取字符中的一部分显示 正则表达规则

http://www.imooc.com/article/15885 正则表达规则 <script type="text/javascript"> </scrip ...

随机推荐

- [Virus Analysis]恶意软件分析(二)玩出花的批处理(中)

本文作者:i春秋作家——Sp4ce 0×01上一篇文章部分 首先是文件目录 整理后的目录 整理前的部分文件代码 update.bat %%Q %%Q %%Q %%Q %%Q %%Q %%Q %%Q % ...

- 位域(bit fields)简介

使用位域或位操作移动一个字节中的位 Java中EnumSet代替位域代码详解 关于位域的一些东西 深入理解Java枚举类型(enum) 位域是指信息在存储时,并不需要占用一个完整的字节, 而只需占几个 ...

- Java基础之断言

断言是在Java 1.4中引入的.它能让你验证假设.如果断言失败(即返回false),就会抛出AssertionError(如果启用断言). 什么时候使用断言? 断言不应该用于验证输入数据到一个pub ...

- 实现可搜索仿select下拉选中

由于在优化项目中,发现先前写的一个活化石级的的可搜索下拉功能在高速搜索中会出现卡顿现象 1.起初的解决方法是在搜索事件中加入防抖函数隔一段时间才去触发他,同时搜索的不再是html文档片段,而是直接对数 ...

- XorPay.com 支付平台介绍【免费申请个人微信支付接口】

XorPay 支付平台介绍 XorPay 定位为个人 / 独立开发者 / 个体户 / 小微企业提供安全.简单.稳定.正规的收款服务.目前支持微信 NATIVE / JSAPI / 收银台 / 小程序 ...

- 【learning】微信跳一跳辅助c++详解 轻松上万 【上】

写在前面 17年年底Wechat出了这个跳一跳的小游戏,今年2月份的时候简单地玩了一下,发现被游戏虐了(手太残了只能跳20多). 今天刚好有点空,于是就花了一个下午的时间写了一个跳一跳的c++ ...

- 【NOIP2016提高组】 Day2 T3 愤怒的小鸟

题目传送门:https://www.luogu.org/problemnew/show/P2831 说个题外话:NOIP2014也有一道题叫做愤怒的小鸟. 这题自测时算错了eps,导致被卡了精度,从1 ...

- 归并排序的理解和实现(Java)

归并排序介绍 归并排序(Merge Sort)就是利用归并的思想实现的排序方法.它的原理是假设初始序列含有fn个记录,则可以看成是n个有序的子序列,每个子序列的长度为1,然后两两归并,得到[n2\fr ...

- 关于JSON基础的总结

本文总结自百度百科 JSON 语法规则 JSON 语法是 JavaScript 对象表示语法的子集. 数据在键值对中 数据由逗号分隔 花括号保存对象 方括号保存数组 JSON 名称/值对 JSON 数 ...

- (转)mysql的sql_mode合理设置

mysql的sql_mode合理设置 目录 http://xstarcd.github.io/wiki/MySQL/MySQL-sql-mode.html http://dev.my ...